Des chercheurs suisses ont mis au point un outil permettant de modéliser les mouvements de la mouche drosophile. S’appuyant sur des caméras et des algorithmes d’intelligence artificielle, le logiciel est présenté comme une aide à la conception de meilleurs robots sur pattes.

Elle se déplace sur tout type de terrains : mur, plafond, vitre, plante, humain… La mouche a cette capacité étonnante de se poser sur n’importe quelle surface, grâce à ses pattes dotées de griffes, de pelote adhésive et de ventouses. Pas étonnant que ce petit animal attire l’attention des chercheurs, comme ceux de l’Ecole polytechnique fédérale de Lausanne (EPFL), en Suisse.

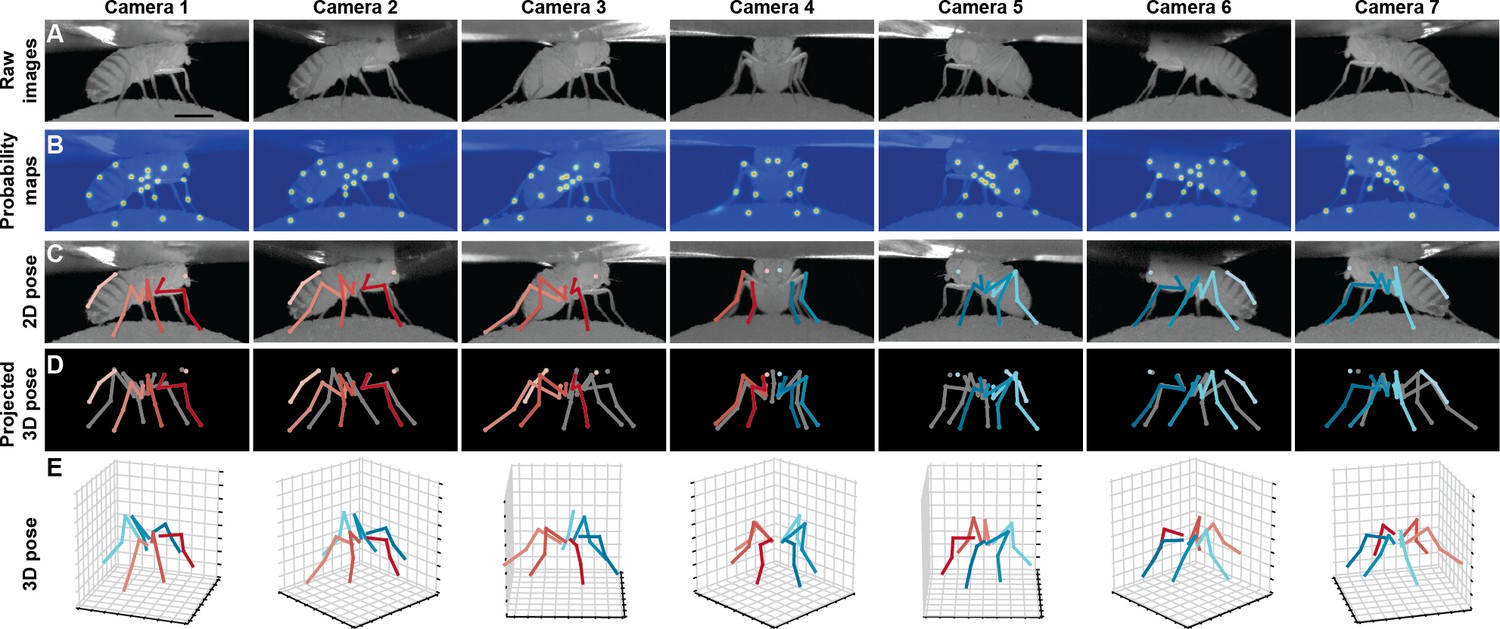

Pour comprendre le comportement de la mouche drosophile “à un niveau de détail sans précédent”, l’équipe a conçu DeepFly3D, un outil de modélisation en 3D des mouvements de ce petit insecte. Basé sur des algorithmes d’apprentissage profond (deep learning) et de multiples caméras, le système permettrait de comprendre précisément les principes de contrôle neuronal de la mouche pour mieux concevoir des robots. Une approche largement utilisée dans la modélisation, notamment pour le tracking des mouvements de l’homme et des grands animaux, mais qui s’avère compliquée lorsque le modèle en question mesure 2,5 cm de long, dispose de nombreuses articulations et doit être éclairée par une lumière infrarouge pour éviter toute stimulation visuelle.

Une triangulation des données 2D

Lors de l’expérimentation, la mouche est “attachée” pour la contraindre à se déplacer sur une sorte de balle. Sept caméras enregistrent simultanément ses mouvements : “en utilisant plusieurs caméras synchronisées et en exploitant la redondance des multiples vues, le logiciel fournit une estimation de pose précise à l’échelle submillimétrique” précise l’étude. DeepFly3D va ainsi détecter la position en 2D de 38 points de repère qui ont été au préalable définis sur un jeu de données. En effet, leur approche s’appuie sur un apprentissage en profondeur supervisé pour former un réseau de neurones détectant l’emplacement des articulations 2D dans des images provenant de caméras individuelles. “Le logiciel utilise ces points de repère annotés par l’homme pour former un réseau de neurones profonds pouvant ensuite identifier les mêmes points de repère sur des données de test”, nous précise Pavan Ramdya qui a dirigé l’étude à l’EPFL.

Parmi ces points de repères, cinq sont positionnés sur chaque membre : les articulations thorax-hanche, hanche-fémur, fémur-tibia et tibia-tarse, ainsi que le pretarsus, la partie terminale du tarse (soit le “pied”). Mais également six sur l’abdomen (trois de chaque côté) et un sur chaque antenne pour mesurer la rotation de la tête. Ces emplacements en 2D vont ensuite être triangulés pour produire des estimations de pose 3D. Les détections 2D erronées sont identifiées et corrigées automatiquement par l’outil lui-même.

Aider la robotique et la médecine

Adapté à la mouche drosophile pour cette étude, l’outil pourra également être utilisé pour d’autres modèles, comme les souris, les primates ou les humains, à condition de changer les dimensions de configuration. Des explications sur ces changements de caractéristiques sont proposées dans la partie “Méthodes” de l’étude.

“En tant qu’organisme modèle, la mouche présente un bon compromis entre docilité et complexité”, partage Pavan Ramdya dans un article de l’EPFL. “Si nous comprenons comment elle accomplit ses actions, nous pourrons apporter une importante contribution à la médecine et à la robotique.”

Réagissez à cet article

Vous avez déjà un compte ? Connectez-vous et retrouvez plus tard tous vos commentaires dans votre espace personnel.

Inscrivez-vous !

Vous n'avez pas encore de compte ?

CRÉER UN COMPTE