Un automobiliste français standard parcourt environ 15.000 kilomètres par an, c’est-à-dire une quarantaine de kilomètres par jour. Une voiture thermique à pétrole permet de parcourir environ 300.000 kilomètres. Grand maximum.

Il reste 94% de la capacité de la batterie de la Tesla Model S après qu’elle ait parcouru 200.000 kilomètres selon la dernière mise à jour (15 Mai 2017) d’une étude néerlandaise menée par une communauté de propriétaires de ce véhicule. La capacité de stockage de la batterie baisse de 1% tous les 45.000 kilomètres. En extrapolant on peut estimer que le seuil des 92% sera atteint au bout de 300.000 kilomètres et celui des 80% au bout de 780.000 kilomètres. Ce qui correspond à un demi-siècle pour un automobiliste standard.

Il y a 4 ans Elon Musk avait révélé que des simulations menées en laboratoire par les ingénieurs Tesla sur une batterie de 85 kWh avaient permis de réaliser 800.000 kilomètres. « Cela pourrait s’avérer erroné mais nous avons une batterie qui a permis de réaliser un demi-million de miles au laboratoire » avait déclaré avec prudence Elon Musk au média USA Today. Cela avait suscité rires et moqueries de la part des sceptiques, y compris des journalistes spécialisés automobiles et des « experts », qui pensaient que l’électrique n’était valable que pour les voiturettes de golf.

Puis dans une note publiée sur le blog de Tesla il y a 2 ans Elon Musk a indiqué que l’objectif de l’entreprise était de produire un groupe motopropulseur (powertrain) capable de résister à 1,6 millions de kilomètres. Cette révélation est passée relativement inaperçue. Mais « pourquoi achèteriez-vous une voiture capable de parcourir 1 million de miles ? » interroge Tony Seba, professeur de l’université Stanford, dans une tribune publiée sur le blog du think-tank RethinkX et intitulée « L’avance de Tesla est-elle encore plus importante qu’on ne le pense ? »

Un million de miles ?

Cela semble relever du non-sens quand on adopte un état d’esprit conservateur. Mais pas dans le cadre d’une approche innovante de la mobilité. Ce n’est pas un hasard si les géants Apple, Google et Uber investissent aussi massivement dans la conduite autonome.

Une start-up californienne, Tesloop, organise des voyages en Tesla S et X, notamment entre Los Angeles et Las Vegas. Il s’agit d’un usage intensif des batteries: une de leurs Model S a parcouru 450.000 kilomètres en 20 mois, soit environ 730 kilomètres par jour en moyenne (l’aller-retour LA/LV fait 860 kilomètres). Ceci avec la voiture la plupart du temps remplie de passagers et de bagages. Et à vitesse élevée, sur autoroute.

Il restait à la batterie de ce véhicule Tesloop 94% de sa capacité de stockage initiale au bout de 320.000 kilomètres. Et non pas au bout de 200.000 kilomètres comme dans l’étude néerlandaise. Comment expliquer la différence ? Deux facteurs dégradent les batteries : l’usage et le temps (le nombre d’années). En roulant beaucoup chaque jour le facteur temps devient marginal. Les batteries Tesla sont actuellement garanties 8 ans mais ceci pour un kilométrage « illimité ».

« Les données provenant des utilisateurs intensifs des batteries suggèrent qu’elles durent bien plus longtemps sur le terrain que ce qui était estimé » soulignent les auteurs de l’étude RethinkX. « Proterra a identifié une tendance historique portant sur un progrès de 5-6% par an de leur performance. Chanje Energy (ex Nohm) s’attend à ce que les batteries puissent durer 800.000 kilomètres dès 2021. Et Tesloop s’attend à ce qu’elles durent encore plus longtemps » affirment-ils sur la base d’interviews avec Proterra, Chanje Energy et Tesloop entre Janvier et Mars 2017.

Les batteries des concurrents, comme par exemple Nissan, « ont 3 fois moins de capacité (de stockage ndlr) que celle d’une Tesla » souligne Pierre Langlois, Docteur en Physique et spécialiste de la mobilité au Québec. « Elles doivent donc être rechargées 3 fois plus souvent. Par ailleurs, elles n’ont pas un bon système de gestion thermique de la batterie comme les véhicules de Tesla. » Au final les batteries des concurrents se dégradent plus vite.

Tesloop, avec son offre City-to-City, démontre que le dogme distillé par le lobby pétrolier selon lequel la voiture électrique est adaptée pour les petites distances urbaines et pas pour les longs trajets est vraiment infondé. « Je ne suis pas sûr que tout le monde pourra s’offrir une Tesla » ironisent parfois certains acteurs. Or, précisément, il ne sera pas nécessaire d’acheter une Tesla pour en jouir. Et elle sera librement accessible à toutes et à tous, quel que soit leur âge, leur état de santé ou leur niveau socio-économique.

RethinkX a fait le calcul. Dans l’hypothèse conservatrice d’un groupe motopropulseur capable de résister à 600.000 miles et d’une batterie à 300.000 miles, soit un seul changement de batterie, alors le coût kilométrique global des A-EV (voitures électriques autonomes), à partir de 2020, sera 10 fois inférieur à celui des voitures thermiques classiques. Ces dernières ne peuvent parcourir qu’une distance deux fois inférieure. Au mieux. S’il s’avérait nécessaire de changer 2 fois la batterie (batterie de 200.000 miles) au lieu d’une seule fois, l’impact serait de l’ordre de trois cents par mile estime RethinkX.

On estime en France que le prix de revient kilométrique (PRK) d’une Renault Twingo thermique est de 56 c€. Avec Tesloop (Tesla S) le coût global est d’environ 13 c€ par kilomètre dès à présent rapporte RethinkX (plus précisément entre 20 et 25 US cents par mile).

Une voiture électrique à batterie n’est constituée que de 20 pièces mobiles, contre 2000 pour une voiture thermique. Il en résulte des frais de maintenance beaucoup plus faibles.

Le géant américain Goodyear a signé un partenariat avec Tesloop dans la perspective de développer des pneus spécifiquement adaptés à un usage de type TaaS (« Transportation as a Service »). Actuellement les pneus coûtent « environ un cent par mile » a déclaré le PDG de Tesloop, Rahul Sonnad, à l’occasion d’une conférence organisée par la banque Morgan Stanley.

Par ailleurs une voiture capable de self-driving génère beaucoup moins d’accidents qu’une voiture qui n’est pas autonome, d’où des frais d’assurance bien plus faibles.

En outre une voiture électrique est trois fois plus efficiente qu’une voiture thermique pétrolière, d’où une facture « carburant » également plus faible. Mais pour Tony Seba c’est la durée de vie élevée des voitures à batterie qui est le facteur le plus important pour l’équation économique.

Il suffira de cliquer sur son smartphone pour qu’un A-EV vienne vous chercher. Et qu’il vous permette de réaliser une économie d’un facteur 10. Plus besoin d’attendre à une station de métro ou de bus aux horaires parfois non adaptés à vos besoins, notamment le dimanche, et parfois éloignée de votre domicile ou de votre lieu de travail. Plus besoin de perdre du temps pour aller faire le plein d’essence ou de diesel, de trouver une place de parking, de payer le garagiste, de payer une assurance, de rembourser un prêt auto, de payer des amendes, de nettoyer la voiture, et aussi de passer le permis de conduire. Et le tout en évitant d’enrichir des pays peu respectueux des droits humains fondamentaux ainsi que d’être co-responsable des marées noires et de la pollution de l’air.

Nul besoin d’être prophète pour percevoir que cette nouvelle forme de mobilité va provoquer un énorme rush estime Tony Seba. Même les personnes propriétaires d’une voiture n’achèteront plus de pétrole : ils la laisseront au garage car cela leur coûtera beaucoup moins cher. Il y a un siècle certains pensaient que l’attachement entre l’homme et le cheval rendra impossible le remplacement de la voiture à cheval par la voiture à moteur. Aujourd’hui certains affirment la même chose à propos de la voiture individuelle privée. Des services que Rethink qualifie de pré-TaaS, comme par exemple Uber ou Lyft, ont démontré qu’il y avait une demande très forte pour ce type de mobilité.

Le plein d’électrons en 5 minutes

A l’occasion du CUBE Tech Fair qui a eu lieu du 10 au 12 Mai 2017 à Berlin, une strart-up israélienne, StoreDot, a démontré qu’il est possible de charger en 5 minutes une batterie permettant de parcourir 300 miles (480 kilomètres). Lors des trajets Los Angeles / Las Vegas sur autoroute avec Tesloop, les Tesla S ne font qu’une seule charge, en milieu de voyage. Cela permet aux voyageurs d’aller aux toilettes, de prendre un café et de se dégourdir les jambes.

Charger une batterie de 100 kWh avec un ultra-chargeur de 350 kW (3,5C), permettant ainsi de faire une bonne partie du plein en une quinzaine de minute, cela aura-t-il un impact sur la durée de vie des batteries ? « Avec du 4C l’impact est vraiment marginal » affirme Marion Perrin, directrice du service stockage et systèmes électriques au sein du CEA, département des technologies solaires. « Avec du 7C cela commence un peu à chauffer ». Les super-chargeurs Tesla d’ancienne génération ont une puissance de 120 kW. Mais Elon Musk a annoncé l’arrivée d’une nouvelle génération bien au-delà de 350 kW.

Y aura-t-il assez de Lithium ?

Une batterie Tesla consomme aujourd’hui 0,8 kg de Lithium par kWh de stockage, et 0,6 kg en 2030 indique RethinkX. Les réserves mondiales sont estimées à 30 millions de tonnes au coût actuel, mais elles sont bien supérieures si l’on accepte un coût supérieur. Et « si c’était cher le lithium, on le recyclerait » a déclaré Marion Perrin. Si le coût devenait élevé, l’extraction du lithium de l’eau des océans deviendrait également rentable, mais cela ne sera pas utile. « Le lithium, est un stock, pas un flux » insiste Tony Seba. Après avoir parcouru 500.000 kilomètres avec une batterie, le lithium est toujours là. Et il est recyclable.

Si les 32 millions de voitures françaises étaient remplacées par 3 millions d’A-EV partagés et équipés d’une batterie de 60 kWh en moyenne, alors le calcul est simple : les besoins seraient de 108.000 tonnes de lithium. La population française pesant 1% de la démographie mondiale, on peut estimer que 10,8 millions des tonnes suffiront.

« Tesla ferait bien de s’intéresser d’un peu plus près à la contrainte à venir sur la disponibilité de cobalt » a conseillé publiquement l’ingénieur Nicolas Meilhan, membre des Econoclastes, sur un réseau social. Il s’agit effectivement du seul élément potentiellement limitant. Mais il existe différentes chimies de batterie au lithium. Si Tesla utilise des batteries contenant du Cobalt, cet élément n’est pas indispensable. En outre les encroûtement cobaltifères, notamment dans les fonds océaniques de la Polynésie française, en contiennent de grandes quantités.

L’approche TaaS, qui permet de diviser par 10 le nombre de voitures, a un intérêt majeur dans la perspective de réduire la demande en matières premières. Elle permet aussi d’envisager la libération d’importantes surfaces dans les villes : celles des parkings. Les espaces libérés en question ont souvent une haute valeur immobilière.

Think again

L’étude publiée par RethinkX a eu un important écho dans la presse anglophone. Mais pas dans la presse française. « Pourquoi des personnes très intelligentes ne parviennent pas à anticiper les vagues disruptives ? ». Tony Seba a fait de cette thématique le cœur de ses travaux de recherche.

En 1911 Ferdinand Foch, commandant suprême des forces alliées durant la première guerre mondiale, avait déclaré que « Les avions sont des jouets intéressants mais n’ont aucune utilité militaire ». En 1928, et jusqu’en 1940, la France lançait la construction de la ligne Maginot pour se protéger rappelle Tony Seba. La ligne Maginot était considérée par les meilleurs experts militaires français comme infranchissable, ils en étaient très fiers. Pendant ce temps-là l’Allemagne nazie a mis en place la Luftwaffe, son armée de l’air. Résultat : il n’a fallu à Adolf Hitler que 6 semaines pour conquérir Paris.

« Les politiques, les insiders et les experts qui pensaient que le futur était linéaire, incrémental, juste une extention du passé, ont sous-évalué l’arrivée d’une disruption technologique (l’aviation) et ont fait des choix pour le futur basés sur des notions mainstream du passé, avec des conséquences massives pour l’Europe et le monde pour les générations à venir » analyse Tony Seba.

Au Royaume-Uni le lobby des voitures à cheval a tenté en 1865 de bloquer l’émergence de la voiture à moteur dite « self-propelled vehicule ». C’est l’origine du mot « auto-mobile » : être capable d’être mobile par soi-même, sans être tiré par un cheval. Le « locomotive act » imposait aux voitures motorisées d’être accompagnées de trois personnes. Deux à bord et une devant la voiture pour agiter un drapeau rouge (« Red flag act »). Attention danger. Et elles n’avaient pas le droit de dépasser 2 miles (3,2 km/h) en ville. Le Royaume-Uni a par conséquent bloqué cette innovation qui cependant n’a pas disparu. Elle a simplement ressuscité aux USA.

L’industrie automobile est en bonne partie à l’origine de la puissance économique et militaire américaine. En 1950 les USA produisaient la moitié des voitures à l’échelle mondiale. « Durant la seconde guerre mondiale Ford a construit, à lui seul, 6790 bombardiers B24, 282.354 jeeps et 42.676 camions » rappelle Tony Seba. Les USA ont libéré l’Europe, y compris la France, du nazisme.

Pour Tony Seba le groupe Volkswagen qui annonce vouloir faire des voitures à batterie tout en continuant en réalité à investir massivement dans la voiture diesel, se comporte comme quand Kodak parlait de la photo numérique tout en continuant à investir massivement dans la photo argentique. Kodak a fait faillite.

Une voiture d’un écosystème TaaS permet de remplacer 10 voitures fumantes privées. Le facteur d’amplification est donc massif. RethinkX ? Repenser (re-think) le facteur X. Car la disruption de la voiture pétrolière par la voiture à batterie va être bien plus rapide qu’estimé jusqu’à présent.

Tony Seba, dans son livre « Solar trillions » publié en 2010, avait prédit une chute rapide du coût du solaire photovoltaïque permettant d’atteindre 3,5 ¢/kWh dès 2020. Ni l’Agence Internationale de l’Energie ni Greenpeace n’avaient été capables de prédire une baisse aussi rapide. Ce chercheur indépendant a mis au point une méthode d’analyse des technologies disruptives basée sur l’analyse de nombreuses ruptures technologiques qui se sont produites dans divers secteurs dans le passé.

Le déclin du pétrole

Pour Tony Seba l’émergence de l’A-EV va avoir des effets « catastrophiques » pour l’industrie pétrolière et de son prolongement, c’est à dire l’industrie de la voiture thermique. La croissance mondiale de la demande en pétrole pourrait être stoppée dès 2021 à 100 millions de barils par jour.

La multinationale pétrolière Total, dans le cadre d’une réflexion basée sur la croissance de la voiture électrique privée et n’intégrant pas du tout l’émergence du TaaS, a estimé lors du dernier sommet BNEF à New-York que ce virage n’arrivera pas avant 2030.

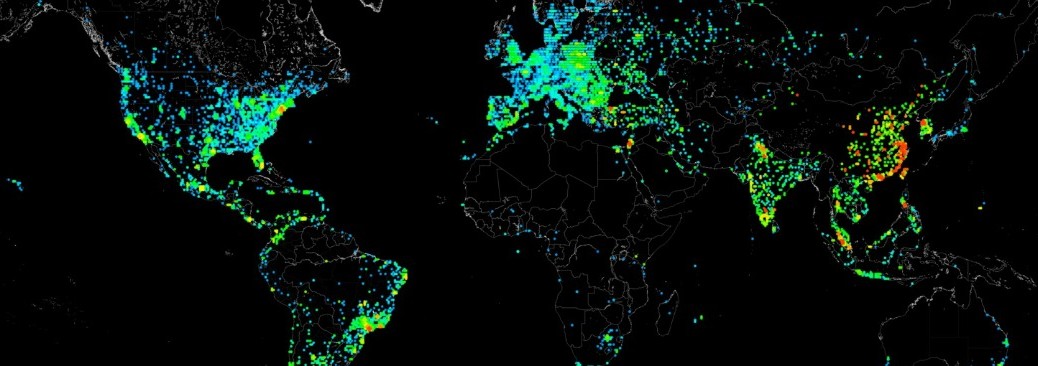

Selon RethinkX, au contraire, la demande en pétrole aura chuté à 70 millions de barils par jour en 2030. Cette asphyxie du marché pétrolier par l’émergence rapide du TaaS aura des effets en jeu de domino. Les pays dont l’économie repose en bonne partie sur une rente pétrolière, comme par exemple la Russie, l’Arabie Saoudite, le Venezuela et le Nigéria, pourraient beaucoup souffrir de cette disruption.

Vers des voitures de 10-12 places

Disposer de véhicules autonomes de niveau 5 (dès 2019 selon Elon Musk) est-il indispensable pour que la disruption commence ? Tesloop a déjà prouvé que non avec des véhicules offrant 3 places pour les passagers. Ceci même en devant payer un chauffeur 15 dollars de l’heure, un coût qui sera réduit à zéro dès l’arrivée des A-EV.

L’entreprise californienne Proterra a mis au point des bus 100% électriques à batterie de 50 places capables de parcourir 560 kilomètres quand ils sont remplis de passagers. Ni les bus thermiques au diesel, au gaz fossile ou au biogaz, ni les bus à hydrogène ne peuvent rivaliser au niveau compétitivité. La croissance du marché des bus à batterie est fulgurante, notamment en Chine.

Mais Elon Musk pense que des voitures de 10 ou 12 places suffiront : « je ne suis pas sûr que le projet de bus ait vraiment du sens » a déclaré le PDG de Tesla le 3 mai 2017. La Tesla X compte 7 places. Avec l’arrivée de la mobilité 100% autonome chercher à diluer le coût du salaire du chauffeur en augmentant le nombre de sièges dans un bus n’a plus aucun sens. Quatre Super-Tesla X d’une douzaine de places chacune sont bien plus flexibles et éviteront de faire rouler des bus parfois à moitié ou aux trois-quarts vides.

Dans ses conférences Tony Seba explique que la conduite 100% autonome permet de réduire d’un facteur 3 la surface consommée par les véhicules sur les routes en synchronisant les freinages et les accélérations des véhicules. Un « train » de 4 super-Tesla X roulant à la queue leu-leu ne prend pas beaucoup plus de place qu’un bus de 50 places.

Tesla développe aussi des semi-remorques pour le transport des marchandises. Peut-être seront-ils commercialisés en reprenant le business-model de BetterPlace reposant sur des robots capables d’échanger les batteries très rapidement. C’est ce croient savoir Ravi Shanker, expert en logistique, et Adam Jonas, analyste de la banque Morgan Stanley.

Sur ce marché aussi, et peut-être encore davantage que sur les autres compte-tenu des volumes kilométriques et énergétiques en question, le stockage batterie a vraiment du sens. Etant donné que les semi-remorques seront 100% autonomes (et donc sans chauffeur à payer) le temps passé pour échanger la batterie ou pour faire le plein avec l’ultra-fast charging n’aura aucune importance. Et ceci même si la batterie ne permet au semi-remorque de ne parcourir que 400 kilomètres.

Pour les opérateurs de flottes de véhicules autonomes « seul le coût et l’efficience ont de l’importance » expliquait en juin 2015 Brad Templeton qui a fait partie de l’équipe travaillant sur la Google Car. « Les Robocars (A-EV) s’en fichent du temps qu’il faut pour recharger ».

Une marée non pas noire mais électrique

Le 16 mai 2017, en direct d’un évènement innovation du groupe Volvo, Colin Mckerracher, analyste spécialisé transport de BNEF, a souligné que la vitesse d’impact de l’électrification sur les camions, les bus et les engins de construction était au centre des débats. « La chute du coût des batteries lithium-ion va se répandre vers d’autres sources de demande en carburant » a estimé l’expert.

Colin Mckerracher a partagé la photo d’une machine excavatrice intégralement électrique et alimentée par une batterie lithium, et une autre photo d’un camion-poubelle Volvo équipé de lidars pour la conduite autonome.

Pour ce spécialiste « la chose la plus intéressante est la mise en place de coalitions d’intérêts entre entreprises qui sont à présent en faveur de la voiture électrique. Les compagnies minières et électriques s’associent contre les compagnies pétrolières ».

Ensemble les géants du lithium, du nickel, du cobalt, du graphite, du phosphate, du fer, du cuivre mais aussi ceux du nucléaire, de l’hydroélectricité, du solaire et de l’éolien et enfin bien sûr ceux de l’informatique, pèsent en effet très lourd. Dans un rapport récent sur la Chevy Bolt (General Motors) la banque UBS considère la voiture électrique à batterie comme « la catégorie de voiture la plus disruptive depuis la Model T de Ford ».

« De nombreux éléments nous ont suggéré la préparation soutenue d’un assaut du marché de la mobilité partagée, autonome et électrique par de grosses entreprises du secteur de la technologie » a déclaré en mai 2017 Adam Jonas, directeur de la recherche sur l’industrie automobile au sein de la banque d’investissement Morgan Stanley qui gère 2 trillions de dollars d’actifs dans le monde entier. Morgan Stanley a publié le 16 avril 2016 le rapport-phare « Global Investment Implications of Auto 2.0 »

Ford, groupe qui est historiquement à l’origine de la révolution automobile américaine, est fortement engagé dans cette bataille de Titans. Papy fait de la résistance. Conscient de la menace Daimler a formé en avril 2017 une alliance avec Bosch pour développer des voitures complètement autonomes, et a annoncé parallèlement que la voiture électrique à batterie était à présent au centre de la stratégie du groupe. Le géant chinois Byd est aussi de la partie. Tout comme Renault qui vient de racheter la branche R&D d’Intel en France (Toulouse et Sophia Antipolis).

« Nous croyons que la concurrence la plus importante pour Tesla viendra en fin de compte des entreprises tech les plus grandes et au capital le plus important à l’échelle mondiale » a affirmé Adam Jonas. « Beaucoup de ces entreprises – telles que Alphabet, Apple et d’autres – sont déjà en train de tester des véhicules pleinement autonomes sur les routes ».

Alphabet, une filiale de Google, a en effet commencé a tester en avril 2017, via son unité Waymo, des voitures 100% autonomes avec des passagers réels. Apple, la plus grande capitalisation boursière du monde avec une valeur qui dépasse à présent 800 milliards de dollars, a reçu en avril 2017 l’autorisation de tester des voitures 100% autonomes sur les routes publiques de Californie.

Olivier Daniélo