« Une demande dont la croissance reste modérée et une offre qui continue de croître à un rythme soutenu ont modifié l’équilibre du marché », insiste Olivier Appert, Président d’IFP Energies Nouvelles. « Sur les 4 trimestres de 2014, la production pétrolière mondiale a systématiquement excédé la demande de 0,5 à 1 million de barils jours et, en 2015, on estime que l’offre sera en excédent de l’ordre de 2 millions de barils jours sur le 1er semestre et de 1 million de barils jours sur le 2e semestre », résume-t-il.

«On peut estimer qu’un prix d’équilibre en 2015 pourrait se situer entre 50 à 70 $ par baril pour écouler les excédents et équilibrer l’offre et la demande », prévient-il. Cette perspective engendre des pertes financières importantes pour les compagnies pétrolières, les pays producteurs et engendre un stockage considérable.

L’OPEP ne veut pas prendre à sa charge la baisse de production

L’excès de l’offre provient essentiellement des pays non membres de l’Organisation des pays exportateurs de pétrole (OPEP). « La production des pays non membres de l’OPEP depuis 2010 s’est accrue deux fois plus vite que celle des pays de l’OPEP, particulièrement tirée par le développement des pétroles de schistes ou Light Tight Oil aux Etats-Unis », nous éclaire Olivier Appert.

Dans ce cadre, l’OPEP a annoncé le 27 novembre 2014 qu’elle refusait de baisser sa production. Les 12 membres de l’Organisation envoient ainsi un message clair : ils ne laisseront pas leurs parts de marché à leurs concurrents (notamment la Russie, les Etats-Unis et le Brésil) quitte à engendrer une baisse de prix significative du baril sur le marché. Pourquoi baisseraient-ils leur production si les autres acteurs ne le font pas ?

Un bras de fer s’ouvre alors entre l’OPEP, menée par l’Arabie Saoudite, et les autres pays pour que tous les acteurs prennent en charge leur part dans la baisse de production. « Ils vont réussir à tuer le LTO aux Etats-Unis et ils savent que Barack Obama va faire pression sur les producteurs américains pour qu’ils diminuent leur production », analyse Olivier Appert. S’ils y arrivent, « le marché rebondira, comme cela a été le cas en 1987, en 99-2000 ou en 2009 », prévoit-il. Sinon, la situation pourrait devenir compliquée pour tous les acteurs.

Le pétrole de schiste, premier menacé ?

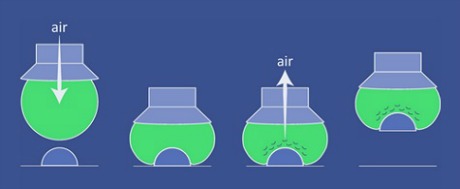

L’institut français des relations internationales rappelle que pour le pétrole de schiste, « la production est caractérisée par un déclin très rapide de la production initiale par puits (entre 60 et 90 % la première année), qui requiert des investissements en continu dans de nouveaux puits pour maintenir/accroître la production ». Et précise que « ce déclin très rapide induit une forte dépendance des projets au prix du brut de la première année de production, contrairement aux pétroles conventionnels, dont l’économie est fondée sur des durées beaucoup plus longues ». Ainsi, la chute des prix du baril entraîne une baisse importantes des investissements et fait craindre une chute de la production.

La baisse des prix a déjà engendré une baisse des demandes de permis de forages aux Etats-Unis, notamment au Texas et dans le Dakota du Nord. On constate ainsi une véritable réduction des investissements qui peut atteint entre – 10 % et – 50 % pour les pétroliers indépendants les plus touchés. « Les effets sur la production des LTO dont le développement de la production nécessite d’investir très régulièrement dans de nouveaux puits pourrait se faire sentir d’ici le mois de Juin », assure Olivier Appert.

La valeur en bourse de nombreuses compagnies et entreprises parapétrolières est d’ores et déjà fortement impactée. « La baisse de la valeur en bourse de nombreuses sociétés crée un climat propice à des achats ou regroupement dont les annonces pourraient bientôt se succéder au cours des prochains mois », prévient Olivier Appert.

Néanmoins, pour le moment, les pétroles de schistes américains ne semblent pas menacés sur le court-terme. « On peut estimer qu’une baisse des investissements de 20 à 40 % en 2015 sur ce type de ressources limiterait la production en 2015 entre 4,2 et 4,9 millions de barils par jour, soit un niveau comparable à 2014, mais inférieure aux prévisions de 5 millions de barils par jour », affirme Olivier Appert.

On s’aperçoit que même si les prix et les investissements baissent, la production se maintient , car les progrès techniques ont conduit à une baisse des coûts de production entre 20 % et 40 % en 5 ans. « Le business model des LTO aux Etats-Unis est une séance expérimentale, personne n’a d’idées sur la résilience du système », reconnait le Président d’IFP Energies Nouvelles.

Les coûts de production varient considérablement selon les puits, en fonction des propriétés géologiques, de 25 $/baril jusqu’à 80 $/baril. « Mais quelle est la part de la production américaine qui reste compétitive, avec un coût de production inférieur à 50 $/baril? Je crois qu’aujourd’hui personne ne le sait réellement », prévient Olivier Appert.

Les pays producteurs en pâtissent, les pays consommateurs jubilent

La baisse du prix du brut engendre également des difficultés budgétaires et économiques pour les pays producteurs. Avec un prix plus faible, les budgets de ces états ne sont plus à l’équilibre. Pour certains, la situation peut même rapidement devenir critique. «Pour un pétrole à 60 $, les pertes de revenus se situent à 2,7 % de PIB pour les pays exportateurs, mais cela peut aller jusqu’à 10 % de PIB pour certains pays du Moyen-Orient», assure Olivier Appert.

En Russie, avec prix à 60 $/baril sur l’ensemble de 2015, les pertes sur les exportations de pétrole et de gaz, atteindraient près de 150 milliards de dollars, soit une baisse équivalente à 7% du PIB national. De plus, le rouble connait actuellement une dépréciation considérable, entraînant une baisse supplémentaire de l’activité économique du pays.

A l’opposé, les pays consommateurs bénéficient de la situation. En moyenne, le gain est estimé à 1 % de PIB pour l’ensemble des pays importateurs et pourrait atteindre jusqu’à 1,6 % pour le Japon. En France, la facture pétrolière et gazière devrait baisser de 15 milliards d’euros en 2015, soit 0,7 % du PIB (si le prix du baril de pétrole tourne autour de 60 $ et le gaz à 7 $/MBtu). « Notre facture énergétique resterait néanmoins déficitaire à hauteur de 48 milliards d’euros », rappelle Olivier Appert. La nécessité d’assurer notre transition énergétique n’est donc heureusement pas remise en cause par cette situation !

Par Matthieu Combe, journaliste scientifique

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)