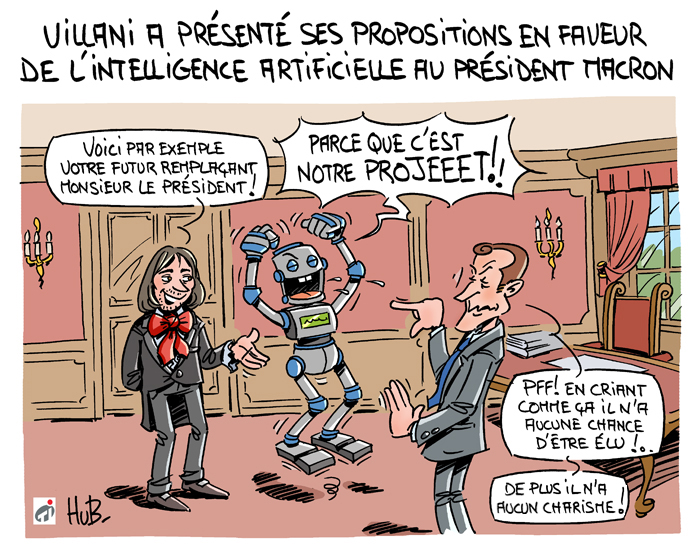

Emmanuel Macron veut faire de la France une nation à la pointe de l’intelligence artificielle (IA), en Europe et dans le monde. La France dispose de nombreux atouts pour ne pas rater cette disruption technologique. « Nous avons des atouts pour réussir », assure le Président de la République, notamment grâce à l’excellence de la formation, des ingénieurs et des chercheurs. Par ailleurs, des centres de recherche de grandes entreprises sont déjà installés sur le territoire.

Pour éviter la fuite des cerveaux et accélérer la croissance l’écosystème, un programme national pour l’IA sera mis en place. « Nous mettrons en place un réseau emblématique de quatre ou cinq instituts dédiés, ancrés dans des pôles universitaires et maillant le territoire français », prévient Emmanuel Macron. Ils seront en interaction permanente et développeront des chaires d’excellence pour attirer les meilleurs talents.

Améliorer la formation et attirer les talents mondiaux

Un effort particulier sera porté à la formation des techniciens, ingénieurs et docteurs. « Nous doublerons le nombre d’étudiants formés à l’intelligence artificielle depuis la licence jusqu’au doctorat, en passant par les formations professionnelles courtes et prévoirons les financements nécessaires à ce doublement », assure Emmanuel Macron.

À cette fin, le Président annonce la mise en place d’une série d’appels à projet mondiaux, à l’instar de ce qui a été fait pour le « Make our planet great again ». Par ailleurs, il entend favoriser les allers-retours des chercheurs entre le public et le privé. Grâce à la loi Pacte, un chercheur public pourra désormais consacrer jusqu’à la moitié de son temps à une entité privée, contre 20% actuellement.

Développer l’expérimentation

Emmanuel Macron a entendu le message : il faut donner plus de place à l’expérimentation en France. D’ici l’été, la Loi Pacte permettra de lancer un appel à expérimentations dans chaque secteur de l’IA.

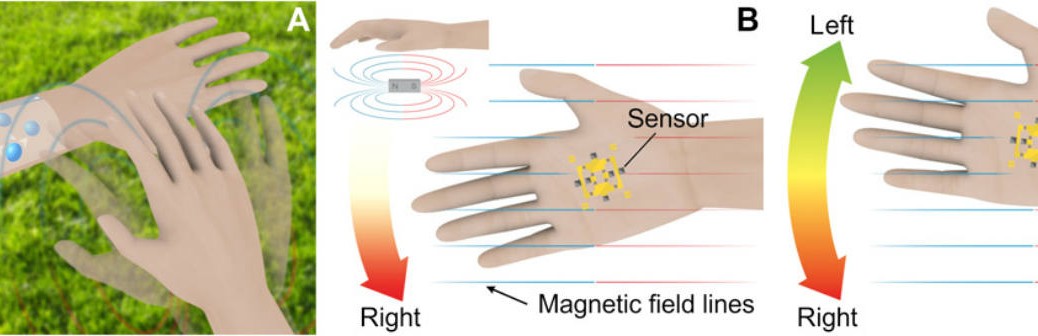

Par exemple, Emmanuel Macron souhaite retrouver le leadership européen en matière de véhicules autonomes, devant l’Allemagne. Très bientôt, la stratégie française pour le véhicule autonome sera dévoilée. Dès début 2019, le cadre législatif autorisera les expérimentations de niveau 4. Le niveau 4 « Eyes off, Hands off » ou « Mind Off » (sans intervention humaine) est la conduite autonome sans surveillance conducteur. D’ici 2022, un cadre permettant la circulation des véhicules autonomes sera mis en place. En bout de chaîne, cela suppose de poser au plus vite le cadre d’homologation des véhicules autonomes.

Ouvrir les données publiques et privées

La France est un pays fortement centralisé et lui confère un avantage certain pour l’IA, grâce à des bases de données centralisées massives. Le Président compte ouvrir les bases de données publiques à des fins de recherche dans les prochains mois. Il ouvrira aussi les données obtenues grâce à des financements de fonds publics et les données issues de projets de recherche financés par l’Etat.

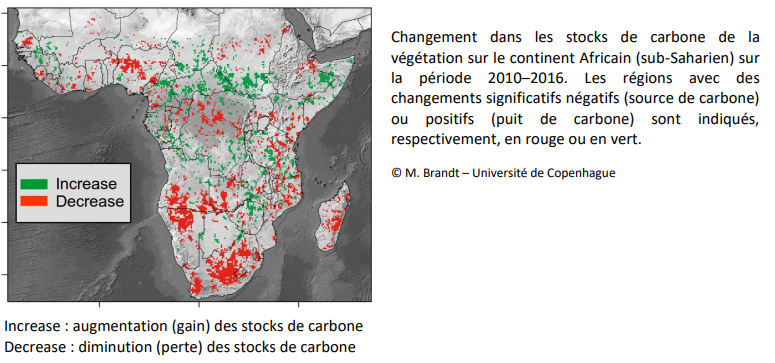

Emmanuel Macron annonce également vouloir faciliter la création de plateformes de partage de données entre acteurs publics et privés, avec une logique sectorielle. « Du secteur bancaire pour les données de transaction, à l’agriculture pour l’efficacité des pesticides, en passant par les données de tests de véhicules autonomes, c’est à une mobilisation générale autour de la donnée que j’appelle », prévient-il. Il désigne notamment quatre secteurs prioritaires dans lesquels l’Etat pourrait « jouer un rôle de structuration » : santé, mobilité, environnement et sécurité. Cela passera en outre par la promotion des logiciels libres partout où ils peuvent se développer.

Le chef de l’Etat lancera par ailleurs une réflexion au sein de l’UE pour avoir accès aux données privées. « Cette politique est inconcevable sans un cadre européen protégeant les données personnelles et permettant la pleine valorisation de ces données dans l’espace européen », précise-t-il. Car l’opinion publique devient sensible à l’utilisation de ses données personnelles. Et il ne faudra pas confondre l’usage des données agrégées et l’intrusion dans les données personnelles. Le nouveau règlement européen répond à ces questions mais doit aller plus loin pour assurer la maîtrise des données, dans un cadre transparent.

Définir un cadre réglementaire et financier français et européen

L’intelligence artificielle sera le premier champ d’application du fonds pour l’innovation et l’industrie de 10 milliards d’euros mis en place en début d’année. Sur le quinquennat, « ce sera un effort dédié d’un milliard et demi d’euros entraînant directement plus de 500 millions d’euros d’investissements privés supplémentaires qui sera mis en oeuvre pour accompagner l’émergence de ce grand pôle mondial de l’intelligence artificielle », annonce Emmanuel Macron. Près de 800 millions d’euros supplémentaires seront investis d’ici 2024 dans la nanoélectronique, ingrédient essentiel au développement de l’IA.

Emmanuel Macron entend définir un cadre financier européen dédié à l’IA. En plus de ses politiques historiques (PAC, fonds structurels), l’Union Européenne doit porter une ambition nouvelle en matière d’innovation, estime le Président Français.

Définir les enjeux éthiques et politiques de l’IA

Il reste enfin à construire les codes éthiques de l’IA. Des engagements de non discrimination sociale, ethnique, sexuelle doivent être pris. Ils devront également respecter les libertés individuelles, l’intimité et la vie privé. Dans cette perspective, « l’Etat rendra par défaut public le code de tous les algorithmes qu’il serait amené à utiliser, au premier rang desquels celui de Parcoursup », prévient le Président.

Une réflexion européenne et nationale sera lancée sur le contrôle et la certification des algorithmes, pour résister à la « privatisation opaque de l’IA ou à son usage potentiellement despotique ». Des discussions seront aussi mises en place au niveau international, notamment avec le Canada. Emmanuel Macron envisage même d’aller jusqu’à la création d' »un GIEC de l’intelligence artificielle » pour créer « une expertise mondiale indépendante qui puisse mesurer, organiser et nourrir le débat démocratique pour que l’IA ne devienne pas une instance de contrôle, mais de liberté ».

Par Matthieu Combe, journaliste scientifique

Une équipe de l’Université technologique de Nanyang a programmé un

Une équipe de l’Université technologique de Nanyang a programmé un  La société de données politiques Cambridge Analytica a discrètement cherché à développer sa propre

La société de données politiques Cambridge Analytica a discrètement cherché à développer sa propre