Début octobre, le ministre de l’économie, Bruno le Maire, a donné le La avec l’annonce de la très prochaine nomination d’un commissaire interministériel à la réindustrialisation qui aura pour rôle de «prévenir les risques de fermetures d’usines» et d’ «accompagner les industries». Deux jours avant, il présentait le nouveau label de la France industrielle, le French Fab, qui espère copier la réussite du label French Tech créé pour soutenir la croissance des start-up. Symbolisé par un coq bleu en origami, cette marque portée par Bpifrance pourra être attribuée aux entreprises innovantes, collectives, qui se digitalisent, qui s’exportent… Elle doit devenir une vitrine pour l’élite de l’industrie française. Le ministre a par ailleurs expliqué que l’objectif est de créer des accélérateurs pour PME et ETI partout sur le territoire afin de les faire devenir des «champions de l’export».

De leur côté, les patrons de l’industrie ont annoncé la création de France industrie, une structure unique commune qui regroupe le Cercle de l’industrie et le Groupement des fédérations industrielles (GFI) afin que PME, ETI et groupes industriels parlent d’une même voix.

Enfin, côté opérationnel, l’Alliance industrie du futur (AIF) a présenté le fruit d’un travail qu’elle mène depuis début 2017 sur les opportunités et le déploiement de l’industrie du futur pour six filières sectorielles majeures en France : l’aéronautique, l’automobile, le ferroviaire, l’agroalimentaire, la construction et le naval. Les résultats font à la fois le bilan de chacune des filières et mettent en exergue comment l’industrie du futur peut les aider à se (re)dynamiser.

Intégrer l’ensemble de la chaîne

Le défi commun à toutes ces filières pour entrer pleinement dans l’industrie du futur, c’est de réussir à intégrer l’ensemble de la chaîne de valeurs et de sous-traitants dans la transformation numérique et de veiller à l’interopérabilité des différents systèmes choisis dans les entreprises. Deux études (*) viennent d’ailleurs d’être publiées s’alarmant du manque d’intérêt et d’actions des PME vers la digitalisation et du risque de voir certaines PME décrocher du marché. Manque de capacité d’investissement, désintérêt dû à une méconnaissance des bénéfices que l’on peut en tirer, peur de l’inconnu et de l’échec sont parmi les principaux freins identifiés. Selon les filières l’intégration sera plus ou moins facile : dans l’aéronautique et l’automobile ou les constructeurs sont extrêmement prescripteurs pour les sous-traitants cela devrait donc se faire plus naturellement que pour l’agroalimentaire ou la construction où la fragmentation du marché constitue un obstacle évident.

Etudes par filière : pour quoi faire ?

Grâce à ces études par filière, l’AIF propose une feuille de route pour le déploiement de la digitalisation et des nouveaux outils industriels à disposition des toutes les parties prenantes : instances représentatives, investisseurs, acteurs de l’innovation et ce sur toute la filière de l’amont à l’aval. L’objectif affirmé est de « créer de la mobilisation et de l’appropriation ». Le diagnostic et donc les remèdes préconisés sont différents selon les filières et les enjeux identifiés. Le document publié par l’AIF propose pour chaque enjeu identifié les solutions que l’industrie du futur peut offrir à court, moyen et long terme et soumet des exemples d’entreprises ayant mis en place ou entamé des initiatives dans ce sens.

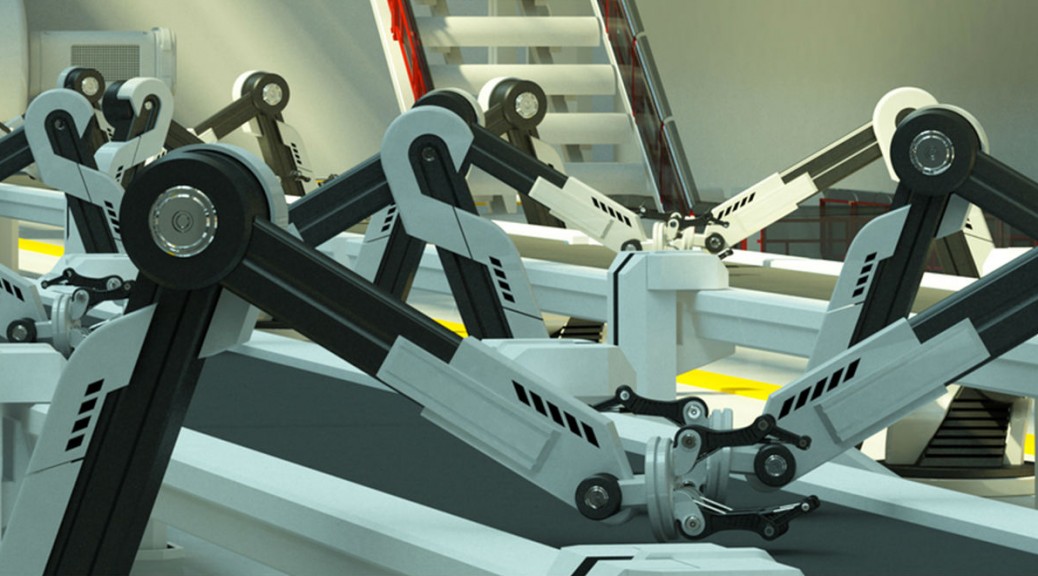

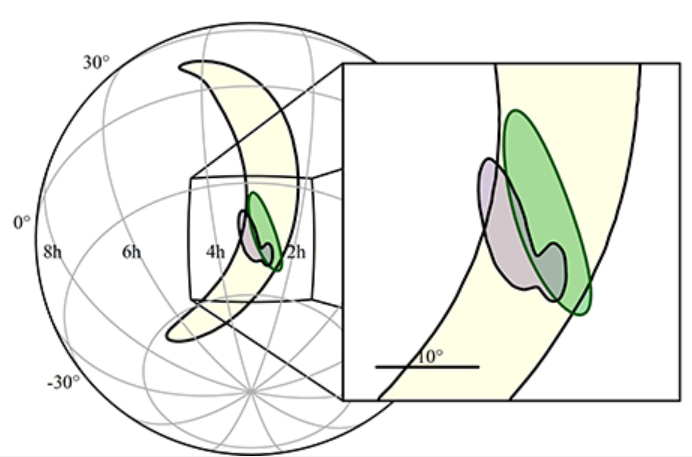

Aéronautique : flexibilité et services

Affichant une valeur ajoutée et une productivité positive et en progrès grâce à des investissements importants, l’industrie aéronautique doit faire face à une demande de livraison importante, une mondialisation toujours accrue des schémas industriels, des évolutions dans l’après-vente et l’apparition de technologies de rupture dans la conception de produits (impression 3D par exemple). Le cabinet de conseil Roland Berger préconise donc de « développer la flexibilité de production, réduire les coûts et poursuivre les améliorations de produits et services ». Parmi les outils proposés, la généralisation de la virtualisation des lignes de production : en élaborant une simulation du processus complet de fabrication, on peut utiliser le « jumeau numérique » pour estimer les impacts d’un changement sur la ligne et ainsi optimiser les moyens et les temps de lancements et de mise en place par exemple. Trois études de cas illustre différentes solutions mises en place chez Airbus, Figeac Aéro ou Thalès.

Construction : maîtriser l’organisation et les défauts

Aujourd’hui, la filière construction doit faire face à des évolutions du marché et à un environnement plus technologique et plus exigeant en matière de qualité, d’organisation des opérations. L’analyse menée par Accenture estime que la filière « devra entre autre adopter les nouvelles méthodologies d’innovation et d’accélération go-to-market, accroître l’efficience de sa chaîne d’approvisionnement, réduire les risques d’accidents, fluidifier le partage d’informations (notamment liées aux projets) entre les différents acteurs / projets, et transformer son business model pour gagner en agilité dans un monde en constante évolution ». Parmi les solutions de l’industrie 4.0 qui peuvent contribuer à relever ces défis : le BIM, les matériaux augmentés (connectés et/ou éco-responsables), les travailleurs et équipements augmentés (mobilité, capteurs, drones, cobotique, réalité augmentée…) et l’analytique couplé au Big Data.

Ferroviaire : assurer l’avenir en se diversifiant

Même si le secteur affiche de bons résultats, l’avenir reste incertain car la mobilité évolue et la concurrence internationale s’est développée. Le rapport souligne la nécessité pour cette filière de repenser sa relation client en se diversifiant et en développant de nouveaux services, de monter en qualité opérationnelle (améliorer sécurité, sûreté, maintenance et aide à l’exploitation), moderniser l’outil industriel en le rendant plus flexible pour faire face à une baisse des activités à court terme. Parmi les solutions identifiées, le développement d’outils de cybersécurité (anti-intrusion pour les infrastructures, billetique, supervision), l’introduction de robotisation et d’ automatisation (pour assemblage des lignes et maintenance), le déploiement de la maintenance prédictive (réseaux de capteurs, automatisation de l’inspection, réalité augmentée), objets connectés et Big Data (autour du client pour développer les services). Le rapport met en exergue l’emploi des drones à la SNCF et la poursuite de l’automatisation de la ligne de 4 du métro à la RATP.

Automobile : retrouver de la valeur ajoutée

Depuis la crise, la valeur ajoutée de l’industrie automobile française s’est fortement réduite. La faible profitabilité a entraîné une réduction des emplois et de l’investissement.

Selon Accenture, pour redynamiser le secteur, il faut « améliorer la compétitivité, préparer le véhicule et les services du futur et se développer à l’international ». La difficulté pour cette filière réside dans le fait que pour accéder aux solutions proposées par les nouveaux outils industriels, il faut un changement des pratiques important et ce pour l’ensemble des acteurs de la filière. Par exemple l’introduction de la virtualisation des lignes de production ou la traçabilité des flux et de la supply chain doit se faire en intégrant les fournisseurs et les constructeurs pour que le bénéfice se fasse ressentir et qu’il y ait une véritable amélioration. Le cabinet Roland Berger a mené une étude prospective sur une usine équipementière et après implémentation des solutions de l’industrie 4.0 prévoit une rentabilité des capitaux investis (ROCE) de 42% au lieu de 15% auparavant.

Naval : moderniser la production

Depuis trois ans le secteur s’est relancé mais pour préserver l’avenir il faut à présent augmenter la compétitivité de la production. L’innovation est au centre de la stratégie des acteurs français et l’industrie 4.0 propose des solutions idéales pour réduire les coûts et assurer ce positionnement.

Comme pour les autres filières, de nombreuses améliorations dans le process de fabrication et dans la communication entre les donneurs d’ordre et les sous-traitants permettraient de réduire les délais et d’améliorer la qualité, la flexibilité et le suivi : maquette numérique partagée, travail collaboratif, réalité virtuelle et simulation tant pour la fabrication que pour la présentation au client, robotisation/automatisation pour la fabrication et la maintenance…

Agroalimentaire : une industrie prise en étau

L’Ania (association nationale des industries agroalimentaires) résume la situation difficile de son secteur par ces mots : « LES INDUSTRIES ALIMENTAIRES éVOLUENT ENTRE UN AMONT DONT LA COMPÉTITIVITÉ S’ÉRODE ET UN AVAL DONT LE POIDS DE NÉGOCIATION AUGMENTE ». Les marges diminuent et pour retrouver une bonne croissance cette filière doit jouer sur plusieurs leviers. A titre d’exemple, concernant l’amont de la filière, l’industrie du futur peut apporter plusieurs améliorations : en accompagnant une agriculture plus productive, rentable et raisonnée via l’utilisation de robots, capteurs, drones, algorithmes prédictifs ; en sécurisant les approvisionnements grâce à des plateformes big data et des analyses prédictives ; en reliant traçabilité et valeur ajoutée et en limitant le gaspillage via la création de blockchain, de plateformes collaboratives, d’outils de gestion du cycle de vie.

(*) Etude BVA pour l’association la Villa Numéris sur les salariés et la transformation digitale

Etude de la Bpifrance intitulée «Histoire d’incompréhension : les dirigeants de PME et ETI face au digital»

Sophie Hoguin