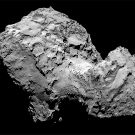

La mission de rendez-vous cométaire Rosetta a offert, grâce à l’atterrissage du module Philae, une opportunité exceptionnelle : celle de l’étude in situ d’un noyau cométaire (de sa surface à sa structure interne), 67P/Tchourioumov-Guérassimenko (aliasTchouri). Elle est susceptible de faire progresser la compréhension de ces petits corps célestes témoins des origines du système solaire. Les mesures réalisées du 12 au 14 novembre 2014 (pendant les 63 heures qui ont suivi sa séparation d’avec Rosetta) par les dix instruments de l’atterrisseur Philae ont complété les observations effectuées par l’orbiteur Rosetta1. Et son arrivée mouvementée sur la comète a même été source d’informations supplémentaires.

Des molécules organiques inédites

Vingt-cinq minutes après le contact initial de Philae avec le noyau de la comète, COSAC (Cometary sampling and composition experiment) a réalisé une première analyse chimique, en mode « renifleur », c’est-à-dire en examinant les particules entrées passivement dans l’appareil. Ces particules proviennent vraisemblablement du nuage de poussière produit par le premier contact de Philae avec le sol. Seize composés ont pu être identifiés, répartis en six classes de molécules organiques (alcools, carbonyles, amines, nitriles, amides et isocyanates). Parmi eux, quatre sont détectés pour la première fois sur une comète (l’isocyanate de méthyle, l’acétone, le propionaldéhyde et l’acétamide).

Ces molécules sont des précurseurs de molécules importantes pour la vie (sucres, acides aminés, bases de l’ADN…). Mais la présence éventuelle de ces composés plus complexes n’a pas pu être identifiée sans ambigüité dans cette première analyse. Par ailleurs, quasiment toutes les molécules détectées sont des précurseurs potentiels, produits, assemblages, ou sous-produits les uns des autres, ce qui donne un aperçu des processus chimiques à l’œuvre dans un noyau cométaire et même dans le nuage protosolaire en effondrement, aux premiers temps du système solaire.

Des amas de matière organique dès l’origine

Les caméras de l’expérience CIVA (Comet infrared and visible analyser) ont révélé que les terrains proches du site d’atterrissage final de Philae sont dominés par des agglomérats sombres qui sont vraisemblablement de gros grains de molécules organiques. Les matériaux des comètes ayant été très peu modifiés depuis leurs origines, cela signifie qu’aux premiers temps du système solaire, les composés organiques étaient déjà agglomérés sous forme de grains, et pas uniquement sous forme de petites molécules piégées dans la glace comme on le pensait jusqu’à présent. Ce sont de tels grains qui, introduits dans des océans planétaires, auraient pu y favoriser l’émergence du vivant.

Des terrains variés cachant un intérieur plutôt homogène

COSAC a identifié un grand nombre de composés azotés, mais aucun composé soufré, contrairement à ce qu’avait observé l’instrument ROSINA, à bord de Rosetta. Cela pourrait indiquer que la composition chimique diffère selon l’endroit échantillonné.

Par ailleurs, les propriétés mécaniques des terrains ont pu être déduites de l’« accométage » à rebondissements de Philae. L’atterrisseur a d’abord touché la surface à un endroit baptisé Agilkia, et a ensuite rebondi plusieurs fois avant d’atteindre le site nommé Abydos. La trajectoire de Philae et les données enregistrées par ses instruments montrent qu’Agilkia est composé de matériaux granuleux sur une vingtaine de centimètres, tandis qu’Abydos a une surface dure.

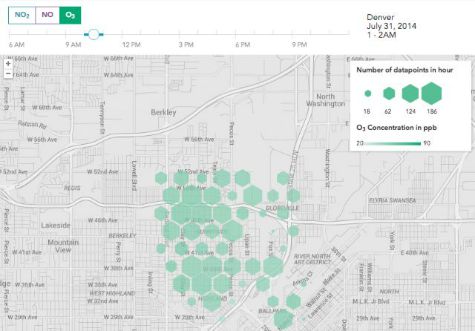

Au contraire, l’intérieur de la comète parait plus homogène que prévu par les modèles. L’expérience radar CONSERT (Comet nucleus sounding experiment by radio transmission) donne, pour la première fois, accès à la structure interne d’un noyau cométaire. Le temps de propagation et l’amplitude des signaux ayant traversé la partie supérieure de la « tête » (le plus petit des deux lobes de Tchouri) montrent que cette portion du noyau est globalement homogène, à l’échelle de dizaines de mètres. Ces données confirment aussi que la porosité est forte (75 à 85%), et indiquent que les propriétés électriques des poussières sont analogues à celles de chondrites carbonées.

Une surface tourmentée

L’expérience CIVA-P (P pour panorama), composée de sept microcaméras, a pris une image panoramique (360°) du site d’atterrissage final de Philae. Elle révèle que les fractures déjà repérées aux grandes échelles par Rosetta se retrouvent aussi jusqu’à l’échelle millimétrique. Ces fractures sont formées par choc thermique, en raison des grands écarts de température que connait la comète lors de sa course autour du soleil.

Des précisions sur la localisation et l’orientation de Philae

Cette image panoramique où apparait par endroits un pied ou une antenne, a aussi révélé la position de Philae. Il repose dans un trou de sa propre taille, couché sur le côté (avec seulement deux pieds sur trois au contact du sol), et entouré de parois qui compliquent son alimentation en énergie solaire et ses communications avec Rosetta.

L’instrument CONSERT a quant à lui déterminé, avec trois périodes d’observations en visibilité directe entre la sonde Rosetta et Philae, la zone (150 mètres par 15 mètres) où se trouve Philae. Cela a facilité la reconstitution de la trajectoire de Philae entre le premier site de contact, Agilkia, et le site d’atterrissage final, Abydos. Puis, en utilisant les signaux qui ont traversé l’intérieur de la comète, CONSERT a réduit l’incertitude sur la localisation de Philae (au bord de la région dénommée Hatmehit) à une bande de 21 mètres par 34 mètres.

Avec les quatre autres articles publiés (portant par exemple sur les propriétés magnétiques et thermiques de Tchouri), ces premières mesures à la surface d’une comète renouvellent l’image que l’on avait de ces petits corps du système solaire.

Références :

- 67P/Churyumov-Gerasimenko surface properties, as derived from the first CIVA-P in situ panoramic images, J-P. Bibring et al., Science, 31 juillet 2015. DOI : 10.1126/science.aab0671

- Properties of the 67P/Churyumov-Gerasimenko interior revealed by CONSERT radar, W. Kofman et al., Science, 31 juillet 2015. DOI : 10.1126/science.aab0639

- Organic compounds on comet 67P/Churyumov-Gerasimenko revealed by COSAC mass spectrometry, F. Goesmann et al., Science, 31 juillet 2015. DOI : 10.1126/science.aab0689

- The landing(s) of Philae and inferences about comet surface mechanical properties, J. Biele et al., Science, 31 juillet 2015. DOI : 10.1126/science.aaa9816

Source : CNRS

Et aussi dans les ressources documentaires :