Cette semaine dans la revue du Web :

- Impressionnant : une plate-forme de Stewart particulièrement habile ;

- Remplir un ballon de baudruche avec du mercure ;

- Folie : résoudre le plus grand Rubik’s Cube du monde (en 7 heures et demi) ;

- Observer la Station Spatiale Internationale passer devant la Lune ;

- Le gadget (inutile?) de la semaine : des explosifs « made in Crimea » ;

- Et en bonus : des boules de neige dans la figure, en slow-motion.

Impressionnant : une plate-forme de Stewart particulièrement habile

Pour débuter notre soixante-quatorzième Revue du Web, laissons-nous bluffer par l’impressionnant sens de l’équilibre de la « plate-forme de Stewart » conçue par Full Motion Dynamics, une équipe universitaire américaine dont les deux têtes pensantes sont deux étudiants en ingénierie de l’université de San Diego, Tyler et Robert. L’équipe bicéphale a travaillé d’arrache-pied sur un projet de simulateur de course à partir d’une plate-forme de Stewart, un positionneur hexapode constitué de six actionneurs lui conférant six degrés de liberté.

Pour fignoler leur projet de fin de semestre et ainsi mieux appréhender les possibilités de cette plate-forme, les deux étudiants touche-à-tout se sont lancés dans la conception d’une plate-forme dont les talents d’équilibriste sont absolument fascinants. Il suffit de lui jeter en pâture une bille d’acier pour comprendre que le dispositif ne plaisante pas, et qu’il peut remettre dans le droit chemin cette sphère métallique si d’aventure elle s’aventurait hors des clous. Le terrain de jeu est constitué d’un écran tactile à technologie résistive monté sur la plate-forme pour repérer les moindres déplacements de la bille, un régulateur proportionnel intégral dérivé (PID) ainsi qu’un module Arduino et six servomoteurs pour imprimer le mouvement. Un vrai travail d’équilibriste !

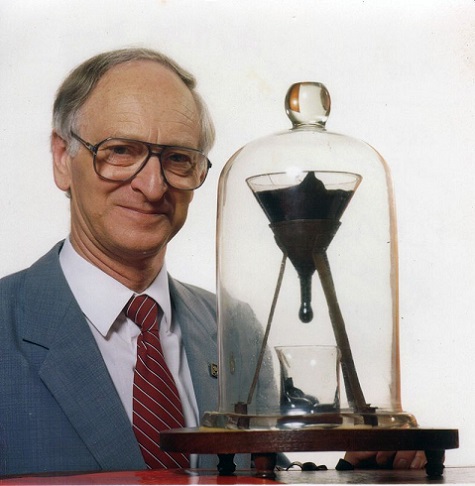

Remplir un ballon de baudruche avec du mercure

Les expériences autour du mercure ont toujours quelque chose d’impressionnant, et le fait que cela soit le seul métal se présentant sous forme liquide dans les conditions normales de température et de pression n’y est probablement pas étranger. Le métal que l’on appelle également « vif argent » fait donc un bon client pour notre Revue du Web, comme le prouve la vidéo qui suit, postée par un internaute dont la passion pour le mercure le rend pour le moins… monomaniaque.

Cette fois-ci, notre scientifique en herbe désire comparer le comportement d’un ballon de baudruche rempli d’eau avec celui d’un ballon rempli de mercure. Première remarque : on ne peut pas remplir un ballon d’eau avec un entonnoir, alors que cela marche très bien avec du mercure, grâce au poids de ce dernier. Autre remarque : la déformation du ballon rempli de mercure et lâché à bonne hauteur est sensiblement plus grande que la déformation d’un ballon plein d’eau.

Si vous vous demandez toujours si on peut absorber du mercure liquide avec une éponge, la réponse se trouve ici. Si vous préférez par contre observer une goutte de mercure danser lorsqu’elle est soumise à différentes fréquences, c’est plutôt par là qu’il faut aller.

Folie : résoudre le plus grand Rubik’s Cube du monde (en 7 heures et demi)

Alors que l’idée d’être confronté à un Rubik’s Cube traditionnel pourrait donner de l’urticaire à un grand nombre d’entre nous, certains amateurs ne semblent jurer que par les modèles les plus larges du célèbre casse-tête d’origine hongroise. Kenneth Brandon, lui, fait définitivement partie des enthousiastes du cube de Rubik. Pour nous le prouver, il va s’attaquer à un monument : le plus grand Rubik’s Cube du monde, un monstre de « 17 par 17 par 17 » (contre « 3 par 3 par 3 » pour le modèle standard) imprimé en 3 D et conçu par le Hollandais Oskar van Deventer.

Mission accomplie pour Kenneth, qui réussit à se dépêtrer du puzzle en… sept heures et demi. Pour les sceptiques – et pour l’Histoire, avec un grand H – notre amateur de puzzles s’est filmé du début jusqu’à la résolution du cube, afin de nous livrer une première vidéo en accéléré, ainsi qu’une seconde vidéo, brute et sans montage, de l’exploit (près de huit trépidantes heures de labeur étalées sur cinq jours). Il faut évidemment s’armer de patience, ne serait-ce que pour mélanger les facettes de ce cube éléphantesque : pas moins de 25 minutes sont nécessaires pour insuffler un joyeux – et nécessaire – désordre coloré à l’ensemble.

La méthode de résolution employée est un classique du genre, baptisée « méthode de réduction », revenant à résoudre les centres avant de passer aux arêtes, afin de se retrouver avec l’équivalent d’un Rubik’s Cube « 3x3x3 » dont les centres seraient très larges, les arêtes allongées et les coins tous petits. Finalement, s’escrimer pendant moins de huit heures, ce n’est pas si mal, mais de l’aveu même du jeune prodige… pas besoin de regarder la vidéo brute en entier. On vous aura prévenu.

La vidéo « brute » :

Observer la Station Spatiale Internationale passer devant la Lune

Le photographe israélien Gadi Eidelheit est parvenu à capturer un joli moment le 28 décembre dernier. Braquant trois appareils en direction de la Lune, notre satellite n’était pourtant pas son unique proie en cette fin d’année… puisque c’était après la Station Spatiale Internationale qu’il en avait. En utilisant les informations fournies par le site Heavens Above – qui permet de déterminer où et quand va passer l’ISS – et en s’armant d’une carte du ciel, il se rendit compte que la Station Spatiale allait virtuellement croiser le chemin de la Lune au dessus de sa tête ce jour-là.

Il va sans dire que les deux corps restent très éloignés l’un de l’autre, les 110 mètres de longueur de l’ISS se baladant aux alentours de 400 kilomètres d’altitude, alors que la distance moyenne nous séparant de notre satellite est de 384 400 kilomètres.

Le gadget (inutile?) de la semaine : des explosifs « made in Crimea » ?

On ne vous apprend rien en vous disant que détruire un bâtiment n’est pas une tâche à prendre à la légère. Ce n’est pas parce que certains le font très bien – comme pour la destruction de la tour de refroidissement de cette centrale polonaise, ou pour une destruction pleine de panache et de couleurs à Albany, dans l’Etat de New-York, dont nous vous parlions ici – qu’il faut penser que cela marche à tous les coups.

La ville de Sébastopol, en Crimée (encore il y a peu ukrainienne, désormais russe) l’a appris à ses dépens, lorsque la municipalité a voulu se débarrasser d’un bâtiment de 16 étages construit illégalement. Le monstre de béton aura chèrement vendu sa peau, puisqu’il aura fallu

- … mais bien trois tentatives pour le mettre à terre. Il nous reste à savoir une chose : faut-il engager le maître d’œuvre qui a réussi à construire un bâtiment aussi résistant, ou se défaire au plus vite de l’équipe de démolition ? A vous de juger !

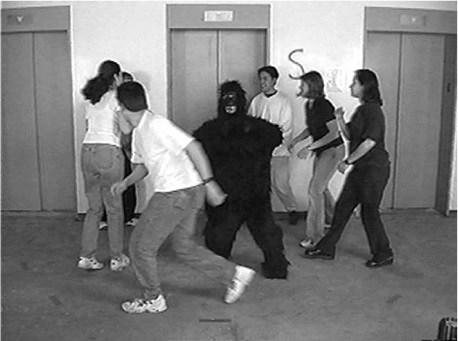

Bonus : des boules de neige dans la figure, en slow-motion

Pour clôturer cette soixante-quatorzième Revue du Web, rien de tel que de se calfeutrer chez soi, de se mettre sous la couette, et de vivre par procuration le bel hiver avec une petite vidéo de saison. Qui dit hiver sous nos latitudes dit Noël, neige… et les incontournables boules de neige !

Pour célébrer la nouvelle année, l’agence de communication Exit10 nous offre la possibilité de nous rincer l’œil devant cette série de visages inconnus, mais réunis par la même et douloureuse attente, à savoir celle d’une boule de neige en pleine poire.

Bien que la vidéo soit en slow-motion, il ne faut pas patienter bien longtemps avant de voir une boule de neige s’inviter, puis les premiers minois se décomposer sous les assauts répétés de ces projectiles glacés. A voir !

Par Rahman Moonzur

.jpg)