Cette semaine dans la revue du Web :

- Chimie du dimanche : « glace chaude » et acétate de sodium ;

- La chevauchée des gouttes d’eau, ode à la gloire de la super-hydrophobie ;

- Hypnotique : faire danser une goutte de mercure à différentes fréquences ;

- Le gadget (inutile?) de la semaine : le tricycle qui ne fait que du sur-place (et facilite la chute) ;

- et en bonus : lutter contre le mal des transports, à la sauce japonaise.

Chimie du dimanche : « glace chaude » et acétate de sodium

Vous ne connaissez pas encore la « glace chaude » ? Pour débuter notre soixante-troisième revue du web, nous n’allons pas vous faire découvrir un nouveau type de crème glacée, sucrerie absurde et réconfortante pour les mois d’hiver un peu longs. L’élément principal de cette « glace chaude » est même plutôt indigeste, puisque c’est le sel de sodium de l’acide acétique, à savoir l’acétate de sodium.

La vidéo qui suit montre sa rapide formation : un grand bocal contenant une solution, une main plongée dans le bocal, et la glace chaude qui se forme presque instantanément autour de la main, cristallisation venant métamorphoser la solution, dans un dégagement de chaleur. Mais alors, comment ça marche ?

Le bocal contient une solution aqueuse basique (CH3COO- Na+ + H2O <–> CH3COOH + HO- Na+) sursaturée en sel de sodium. Cette solution est métastable (la précipitation se fait au moindre changement) et s’obtient facilement, en théorie du moins, en jouant sur la variation de solubilité en fonction de la température. On dissout donc de l’acétate de sodium dans de l’eau chaude, jusqu’à ce que l’eau ne puisse plus en dissoudre. Une fois que la température a baissé, la solution contient plus de sel qu’elle ne peut en contenir à l’équilibre, provoquant la sursaturation. Cette solution sursaturée a besoin d’un élément déclencheur (par exemple, une main enrobée de cristaux d’acétate de sodium) pour initier la cristallisation, cristaux qui donnent la texture si particulière à cette glace. La glace est dite chaude car la réaction est exothermique : l’énergie contenue dans le désordre des particules devient désormais disponible, et se libère alors sous forme de chaleur.

La chevauchée des gouttes d’eau, ode à la gloire de la super-hydrophobie

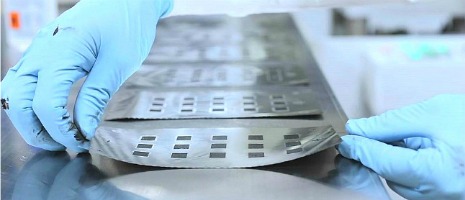

La super-hydrophobie a la côte depuis maintenant de nombreuses années. Pour preuve, la pléthore d’études qui lui sont consacrées, en Europe ou outre-Atlantique, s’appuyant souvent sur l’observation de la nature – biomimétisme, quand tu nous tiens. Les ingénieurs de la National Science Foundation (NSF, « Fondation nationale pour la science », équivalent américain du CNRS) se sont eux aussi penchés sur la question, en observant un petit scarabée de Namibie, le Stenocara, qui présente la faculté pour le moins intéressante de recueillir la condensation de l’eau sur sa carapace, afin de s’abreuver comme il le peut et survivre dans le désert.

Pour amener l’eau jusqu’à son orifice buccal, le scarabée a développé une technique à la fois unique et très astucieuse : en se penchant en avant, les gouttes d’eau glissent en suivant des micro-rainures présentes sur la carapace, dont les propriétés de mouillage sont assez particulières. Les scientifiques du NFS se sont inspirés du Stenocara pour concevoir des surfaces aux propriétés similaires, qu’ils se sont fait une joie de tester dans la vidéo qui suit, sur l’air magique de « La chevauchée des Walkyries » de Richard Wagner.

Petit rappel habituel sur l’hydrophobie : l’angle de contact d’une goutte d’eau, lorsqu’elle est sur une surface plane (localement), doit dépasser les 90 degrés. Au-delà de 150°, la surface est alors considérée comme étant super-hydrophobe. Un angle de contact égal à 180° signifie que la goutte d’eau est complètement sphérique, repoussant la zone de contact jusqu’à un simple point. À titre d’exemple, le Téflon d’une poêle n’est qu’hydrophobe, l’angle de contact moyen étant de 95°.

La super-hydrophobie présente de nombreux intérêts : outre ses évidentes qualités d’imperméabilisation, elle permet de lutter assez efficacement contre le gel, souvent fatal pour les isolants électriques, les lignes à haute-tension, ou le revêtement des ailes d’un avion. Elle est également très efficace pour lutter contre la corrosion, l’accumulation de crasse et le « fouling », la colonisation d’un substrat (souvent immergé) par certains organismes.

Hypnotique : faire danser une goutte de mercure à différentes fréquences

Nick Moore est très curieux. Scientifique à ses heures perdues, il a pris l’habitude de filmer quelques menues expériences de son cru, pour la beauté du geste et ainsi assouvir sa soif de savoir. Ici, notre internaute soumet une goutte de mercure à des fréquences allant de 120 Hz (fréquence d’un son que l’oreille humaine peut percevoir) à 10 Hz (considéré comme un infrason, la fréquence est trop basse pour que le son puisse être perçu), faisant vibrer la goutte métallique qui emprunte certains motifs réguliers. Plus la fréquence est haute, plus les formes et motifs semblent devenir complexes.

Les ondes sonores qui traversent ou contournent la goutte de mercure font osciller cette dernière. La tension superficielle – qui augmente localement la cohésion – ainsi que la vitesse du son dans la goutte de mercure, permettent à certaines ondes sonores d’imprimer certaines vibrations dans la goutte. En d’autres termes, la goutte de mercure entre en résonance avec les ondes sonores à certaines fréquences.

Ce phénomène de résonance n’est pas sans nous rappeler les fameuses « figures de Chladni », motifs créés avec du sable sur une plaque que l’on fait vibrer. La plaque connaît localement des différences d’amplitude, responsables de motifs évolutifs et fascinants dans leur régularité.

En slow-motion :

Piqûre de rappel pour les figures de Chladni :

Le gadget (inutile?) de la semaine : le tricycle qui ne fait que du sur-place (et facilite la chute)

Pour clore en beauté notre soixante-troisième revue du web, rien de tel qu’une vidéo dont le titre colle parfaitement à son contenu et à notre rubrique du gadget (inutile?) de la semaine : « Trois roues, deux pédales, une selle, aucun but pratique ». Le tricycle qui y est présenté est conçu sur la base d’un monocycle, modifié et équipé pour l’occasion de trois roues espacées les unes des autres par un angle de 120°, et orientées selon les trois tangentes du cercle au centre duquel se trouvent la selle, le pédalier et la chaîne.

Pour trouver quelques cobayes, il suffit de poser l’absurde tricycle sur une dalle de pierre circulaire pendant un festival de musique. Un peu de boue, de la motivation, quelques bières, et le tour est joué !

Bonus : lutter contre le mal des transports, à la sauce japonaise

Ce n’est plus un mystère : bien que les causes soient souvent plus complexes, de nombreuses personnes sont sujettes au mal des transports lorsqu’elles ne sont pas assises dans le sens de la marche. Pour remédier à ce problème moderne venant parfois gâcher la vie de l’homo mobilus, certains trains japonais ne font pas dans la demi-mesure, puisqu’ils maximisent le nombre de sièges dans le « bon sens », ne laissant personne souffrir en étant assis dans le sens contraire de la marche.

Une fois arrivé en bout de ligne, pas de chichi. Pas de boucle pour faire demi-tour, pas d’escroquerie d’aiguillages non plus : le terminus devient le théâtre de la rotation de tous les sièges, sans exception, par groupes de deux. De quoi vous assurer d’être assis dans le sens de la marche… pour peu que vous puissiez vous asseoir.

Par Moonzur Rahman