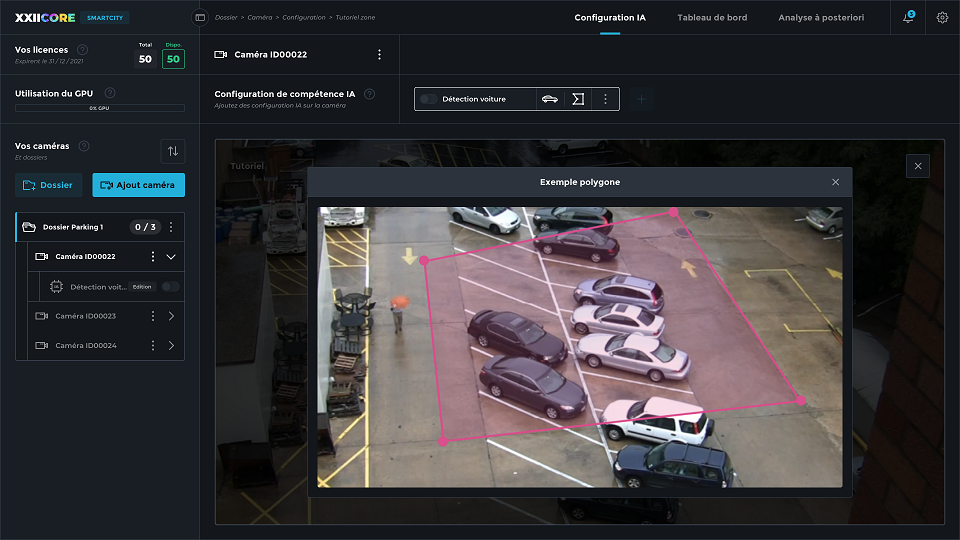

Créée en 2015 par William Eldin et Damien Mulhem, XXII (« Twenty-Two ») a mis au point une série d’algorithmes d’analyse de flux vidéo destinés à de multiples applications : comptage d’humains ou de véhicules, surveillance de périmètres, ou encore détection de chutes et de dépôts sauvages. Regroupés dans une plateforme baptisée XXIICORE, ces algorithmes travaillent en temps réel sur des images issues de parcs de caméras préexistants.

La plateforme XXIICORE a vu le jour en 2021 et s’adresse notamment au secteur des villes et autres collectivités. Permettant de mettre en œuvre toutes les solutions de vision par ordinateur développées par XXII, cette plateforme pourrait également bénéficier aux marchés du commerce, de l’industrie agroalimentaire, ou encore de la logistique. Grâce à l’IA, la plateforme est en outre capable d’orchestrer le fonctionnement des différents algorithmes et d’en mutualiser les calculs. Pouvant fonctionner en local sur des serveurs, ou dans le cloud, XXIICORE est accessible sur abonnement, comme nous l’explique Souheil Hanoune, Directeur R&D et associé de XXII.

Techniques de l’Ingénieur : Quel est l’historique de XXII ?

Souheil Hanoune : XXII est, à l’origine, une start-up, qui a maintenant grandi et compte 70 à 80 personnes. Elle a été créée en 2015, par William Eldin et Damien Mulhem, qui sont des amis d’enfance. William est l’un des cofondateurs de Coyote, l’avertisseur de radars. À l’époque, chez Coyote, il avait déjà commencé à s’intéresser à la vision par ordinateur et, petit à petit, il a décidé de quitter l’entreprise pour fonder XXII.

À ses débuts, XXII était une entreprise sur la vision au sens large, c’est-à-dire qu’elle s’intéressait à la réalité virtuelle, à la réalité augmentée, donc à des expériences de vision avec l’humain au centre de ses usages. L’un des objectifs était aussi de monter une équipe dédiée à l’intelligence artificielle. J’ai pour ma part rejoint l’entreprise quelques mois après sa création, en 2016, et j’ai monté cette équipe IA, puis le laboratoire R&D, puis l’équipe de production… De 2015 jusqu’à l’année passée, nous faisions essentiellement du service. Nous proposions à des clients dans différents secteurs des expériences, des solutions et des projets incluant soit de la vision par ordinateur, soit de la VR et de l’AR : de la réalité virtuelle et de la réalité augmentée.

Petit à petit, la vision par ordinateur a pris plus d’ampleur dans l’entreprise, du fait de son existence dans l’écosystème et dans le marché. En 2019, nous avons ainsi commencé à penser un produit. Nous avons très naturellement construit la vision d’une solution très horizontale, qui aurait la capacité d’attaquer plusieurs secteurs de marché, dans un but d’agilité. Nos années passées à faire du service nous ont permis de construire un état de l’art, une étude de marché. En 2021, nous avons donc créé XXIICORE, une plateforme qui permet de déployer, d’optimiser les calculs et de proposer aux clients n’importe quelle solution en vision par ordinateur développée chez XXII. Tout cela de manière extrêmement facile et extrêmement peu coûteuse. Nous nous sommes très naturellement orientés vers les villes, vers la smart city, et en début d’année, nous avons complété notre solution autour des smart infrastructures, des infrastructures privées qui peuvent être liées à la ville. XXIICORE a aussi pour ambition d’être déclinable sur différents autres secteurs de marché : commerce, alimentaire, industrie, logistique… car nous avons déjà mené des projets dans ces secteurs et nous avons déjà identifié des cas d’usages à fort retour sur investissement.

Pourquoi ce nom, XXII (« Twenty-two ») ?

Ce nom a plusieurs sens. Il est tout d’abord en lien avec le vingt-deuxième siècle, une vision chère à William et Damien. C’est aussi et surtout le nom de leur groupe de musique ! Ils avaient ainsi la marque depuis leur adolescence. Après avoir fait quelques années dans la musique, chacun a poursuivi son chemin. Ils se sont finalement rejoints en 2014 et se sont posé la question de relancer la marque. C’est comme cela que le nom de l’entreprise a été choisi.

Vous évoquiez la plateforme XXIICORE. Sur quelles technologies est-elle basée ?

L’IA est centrale. C’est-à-dire que les algorithmes de vision par ordinateur sont centraux dans la plateforme. L’idée de base était de se dire : aujourd’hui, à l’époque, en 2019, comment peut-on répondre aux besoins de marchés avec de la vision par ordinateur ? Au lieu de faire comme nos concurrents et de nous orienter vers des marchés où l’on installe des caméras dédiées, nous avons décidé de nous baser sur les parcs de caméras existants. Nous nous sommes alors demandé comment répondre à un client qui a plusieurs dizaines, voire centaines de caméras. Une notion fondamentale est alors ressortie : quand on a un logiciel d’IA, le modèle lui-même représente la moitié de la valeur, et l’autre moitié de la valeur est constituée par la façon dont on met ce modèle à disposition du client, comment on fait en sorte qu’il soit utilisable de manière simple et accessible. C’est ainsi que la plateforme XXIICORE est née. Nous avons travaillé sur toute la chaîne de valeur : de la R&D en deep learning[1] avec des réseaux de neurones et de l’IA décisionnelle, jusqu’aux algorithmes, que nous avons portés dans XXIICORE.

Cette plateforme a plusieurs objectifs. Le premier est qu’elle puisse porter n’importe quel algorithme qui traite en temps réel des images issues d’un parc de caméras. Le deuxième objectif était d’avoir une plateforme qui puisse être déployable en local, mais aussi sur cloud. La plateforme est donc basée sur des technologies telles que Kubernetes, Docker[2] … Un autre objectif était aussi de pouvoir optimiser la puissance de calcul. Nous avons donc cherché à optimiser chacun des algorithmes, mais au-delà de ça, nous avons aussi développé ce que l’on appelle un scheduler, un « orchestrateur ». Il s’agit d’une technologie que nous avons brevetée et qui permet de mutualiser les calculs : plutôt que de déployer plusieurs fois un même algorithme pour chaque flux d’images, dans notre plateforme, une IA supervise tout cela et compte combien de flux on peut faire passer par un même algorithme. Nous sommes, à ma connaissance, les seuls à faire ça. Cela permet d’économiser encore plus de puissance de calcul nécessaire pour traiter un nombre donné de caméras. Cette quantité dépend notamment du nombre d’images par seconde à traiter : pour compter des humains, deux images par seconde peuvent suffire, là où il en faut 12, 15 ou 25 pour détecter des mouvements ou des chutes.

Votre solution s’adresse à des parcs de caméras existants. Y a-t-il malgré tout des caractéristiques techniques minimales à respecter pour que le système fonctionne ?

Il y a effectivement des résolutions minimales nécessaires. Mais rien d’extraordinaire, une résolution de 720p est largement suffisante et un nombre important d’algorithmes peut fonctionner en 480p : tout ce qui est comptage, détection de périmètre… C’est uniquement quand on s’intéresse à des comportements un peu plus complexes que la résolution prend de l’importance : stationnement, maraudage ou encore détection de dépôts sauvages.

D’autres paramètres sont également importants, notamment l’angle d’attaque de la caméra. Si la caméra est trop plongeante, les algorithmes à utiliser sont très différents de ceux utilisés traditionnellement pour une vue à 45 ou 60° et sur lesquels nous avons entraîné et affiné nos algorithmes. Nous avons d’ailleurs, pour cela, une équipe dédiée à la data, chargée de réaliser des captations dans les villes. Nous allons dans les villes avec nos propres caméras, nous demandons les autorisations de captation et nous identifions des zones propices à l’entraînement de nos algorithmes.

Vos algorithmes sont donc « prêts à l’emploi » et ne nécessitent pas, pour vos clients, de phase d’apprentissage ?

Tout à fait. Et c’est le cas de tous nos algorithmes. Nous ne présentons pas, d’ailleurs, des algorithmes à nos clients, mais des solutions équivalentes à ce que ferait un humain. Chaque cas d’usage fait appel à une combinaison spécifique d’algorithmes qui ont déjà appris, qui sont déjà fine-tuned[3]. Il reste parfois simplement quelques seuils, quelques éléments de réglage à adapter, en fonction de l’angle de la caméra, de son ouverture, de la surface qu’elle couvre etc. Ces seuils peuvent être réglables une seule fois, au départ, et après nous n’y touchons plus. Il peut aussi s’agir de réglages extrêmement simples et facilement compréhensibles qui peuvent être ajustés au fur et à mesure par un opérateur. Il y en a moins de dix dans toute la plateforme.

Sur quels types de machines la plateforme peut-elle tourner ?

Nous privilégions aujourd’hui plutôt les technologies serveurs, pour plusieurs raisons. La première est qu’il faut la puissance de calcul nécessaire pour gérer plusieurs dizaines de caméras. La deuxième raison est que nos clients sont essentiellement des villes, auxquelles nous ne pouvons mettre à disposition de simples stations de travail : il leur faut des technologies serveurs qui peuvent être redondantes, pour lesquelles des pièces de rechange peuvent être fournies pendant cinq à sept ans, et dont les capacités peuvent être augmentées. Si le client veut gérer trente ou quarante caméras, nous venons simplement ajouter des GPU[4]. Toutefois, la puissance de calcul nécessaire dépend exclusivement du nombre de caméras : nous avons, en interne, de simples PC sur lesquels nous faisons des démonstrations et qui peuvent gérer quatre ou cinq flux.

À quels types d’applications votre solution permet-elle de répondre ? Avez-vous quelques exemples à nous donner… ?

Nous avons deux « cœurs ». Un premier lié à l’alerting, c’est-à-dire de la remontée d’alerte en temps réel. C’est l’idée initiale avec XXIICORE. S’ajoute à cela le comptage. Cela n’est pas forcément destiné aux opérateurs employés dans les centres de supervision urbains, mais plutôt aux maires, aux responsables d’agglomération, aux responsables de la voirie… pour leur donner des informations sur les dynamiques de la ville. Tous nos algorithmes tournent autour de l’humain et des véhicules, et de toute la dynamique qui peut exister entre ces deux aspects. Les applications peuvent donc être du comptage d’humains, du comptage de véhicules – avec d’ailleurs différentes typologies de véhicules : camions, vélos, motos, trottinettes –, ou de la périmétrie, c’est-à-dire la détection de pénétration d’une zone. Nous avons aussi des détections plus intelligentes : personnes sur des voies ferrées, dépôts sauvages, détériorations, détections de chutes de personnes. En parallèle, nous avons tout un ensemble de comptages qui permettent de récupérer des informations statistiques : passage dans un sens, violation de sens interdit… Nous avons aussi des applications d’alerting liées à la sécurité, comme l’alerte de feu rouge brûlé.

Face à toutes les possibilités offertes par vos algorithmes, quelle importance accordez-vous à l’éthique de votre solution ?

Les questions éthiques sont centrales pour nous. Tout ce qui est lié à la protection des données personnelles et les questions éthiques sont des aspects historiquement centraux chez XXII. Nous avons travaillé avec la CNIL[5] dès 2018, au moment du lancement du RGPD. En ce qui concerne l’éthique, nous avons plusieurs axes. Nous avons notamment une charte éthique, qui est le fruit d’un travail de quatre ans, mené par un comité éthique composé d’intervenants externes tels que des journalistes, des philosophes… – qu’ils soient plutôt pour ou contre l’usage de ces technologies – ainsi que des représentants du personnel. Le comité se penche régulièrement sur des cas d’usage et différents sujets précis. Nous avons particulièrement en tête la protection des données et l’usage des technologies dans un objectif de bien-être et de développement positif de la société. Au-delà de ça, pour des questions juridiques et liées aux données personnelles, nous travaillons systématiquement avec la CNIL et nous réalisons systématiquement pour tous nos algorithmes des AIPD : des analyses d’impact relatives à la protection des données. XXII n’utilise par exemple jamais de données biométriques.

La reconnaissance faciale ne fait donc pas partie des pistes que vous explorez…

Pas du tout, la plateforme n’offre aucune fonctionnalité de ce type. Nous avons en fait des fonctionnalités avancées qui permettent de suivre une personne sur une vue caméra ou entre des caméras, mais on ne se base absolument pas sur son visage : on se base sur la forme globale, sur les vêtements etc. Nous ne stockons jamais ces informations plus que quelques minutes. On peut par exemple utiliser cette approche pour aider une personne qui a perdu son bagage dans une gare. Suivre une personne dans une ville, en revanche n’a pas beaucoup d’intérêt et a très peu de chance de fonctionner. Nous ne voulons donc pas nous positionner sur ce type d’usage. Nous nous positionnons au contraire à rebours de nos potentiels concurrents internationaux, qui, eux, n’ont aucun problème à utiliser de la reconnaissance faciale de manière massive. Notre objectif est de fournir des solutions qui n’utilisent pas ce type d’algorithmes. Si les villes et d’autres structures n’ont pas le choix, elles seront en effet contraintes d’utiliser les technologies problématiques de reconnaissance faciale.

Qui sont aujourd’hui vos clients ?

Nous avons actuellement, parmi nos clients, à la fois des villes, une trentaine, et des infrastructures privées comme des musées ou des sites touristiques, une vingtaine environ. Nous visons de fortes croissances. Les villes vont en effet petit à petit constater le déploiement de la solution dans d’autres municipalités, ce qui va donc permettre de les rassurer sur le bien-fondé de la technologie et de son utilisation. Nous misons aussi sur la vente indirecte avec nos intégrateurs et nos distributeurs qui répondent notamment aux appels d’offres de vidéosurveillance lancés sur les marchés publics.

Quel modèle économique avez-vous adopté ?

Nous avons mis en place un abonnement sous forme de licence annuelle. Le client paie un accès par caméra et peut appliquer autant d’algorithmes qu’il le souhaite sur cette même caméra. Nous sommes en train de réfléchir pour faire évoluer l’offre actuelle vers un système de packs, qui permettraient de rendre la solution plus abordable en n’obligeant pas les clients à acheter tous les traitements, mais uniquement les packs qui les intéressent. Nous proposons, de plus, des licences flottantes : une licence n’est pas attachée à une caméra physique. Un client qui a cent caméras peut donc n’acheter qu’une quarantaine de licences, et en fonction du moment de la journée, mettre un traitement sur une caméra, puis sur une autre. Il ne se passe en effet jamais des choses intéressantes sur toutes les caméras en même temps.

Quelles sont les évolutions à venir de la technologie et de la plateforme sur lesquels vous travaillez ? Avez-vous des projets particuliers en tête pour les mois prochains ?

Aujourd’hui, l’entreprise est en train de changer d’échelle. Nous avons observé une appétence du marché pour notre produit, que nous commençons à vendre et à déployer. Nous commençons aussi à nous attaquer à d’autres pays d’Europe qui ont les mêmes principes que la France et les mêmes problématiques à traiter. Nous prévoyons en outre de grosses évolutions. Les premières consisteront à proposer des produits à d’autres secteurs que j’évoquais en début d’entretien : le commerce de détail, la logistique… Cela avec la même base d’IA, mais avec des adaptations pour répondre de la manière la plus efficace aux besoins spécifiques de ces secteurs. Nous avons également des projets de R&D plus fondamentaux, notamment des algorithmes d’IA très poussés développés pour des cas d’usage où l’apprentissage sur de grosses bases de données n’est pas possible. Si l’on veut traiter la problématique des risques, on ne va pas créer des accidents spécialement pour entraîner l’algorithme… Nous travaillons donc sur des familles d’algorithmes qui ont la capacité d’apprendre directement chez le client, et de se nourrir de comportements et de situations complexes. Nous avons aussi des CIFRE[6], avec des doctorants travaillant en collaboration entre XXII et des laboratoires publics. Ils s’intéressent à des problématiques d’IA assez complexes, afin de développer des algorithmes pouvant être déployés dans plusieurs secteurs en répondant à chaque fois à un besoin spécifique.

Côté financement, nous préparons une levée de fonds à la fin du premier semestre et nous voulons doubler les effectifs de l’entreprise entre juin 2022 et juin 2023. Nous prévoyons donc un effort important de recrutement. Nous nous intéressons en effet à des marchés tels que l’Espagne, l’Allemagne ou encore le Benelux.

[1] Apprentissage profond

[2] Kubernetes et Docker sont complémentaires. Solution Open Source, Kubernetes, est une plateforme d’orchestration de containers. Docker gère le cycle de vie des containeurs.

[3] Ajustés avec précision

[4] Graphics Processing Unit : processeur graphique

[5] Commission nationale de l’informatique et des libertés

[6] Conventions industrielles de formation par la recherche

Réagissez à cet article

Vous avez déjà un compte ? Connectez-vous et retrouvez plus tard tous vos commentaires dans votre espace personnel.

Inscrivez-vous !

Vous n'avez pas encore de compte ?

CRÉER UN COMPTE