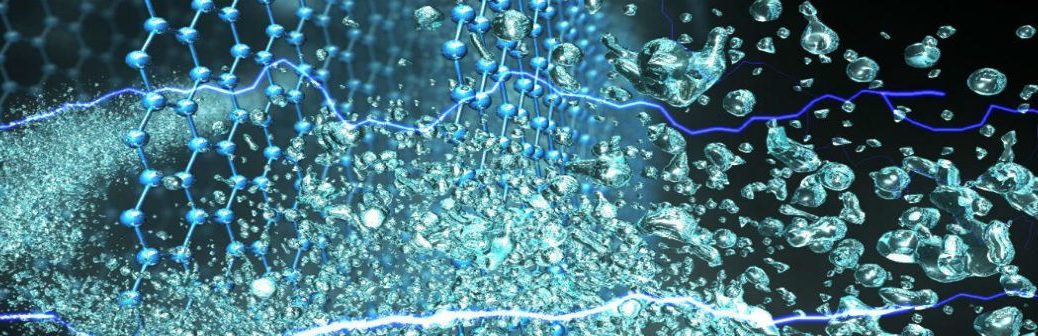

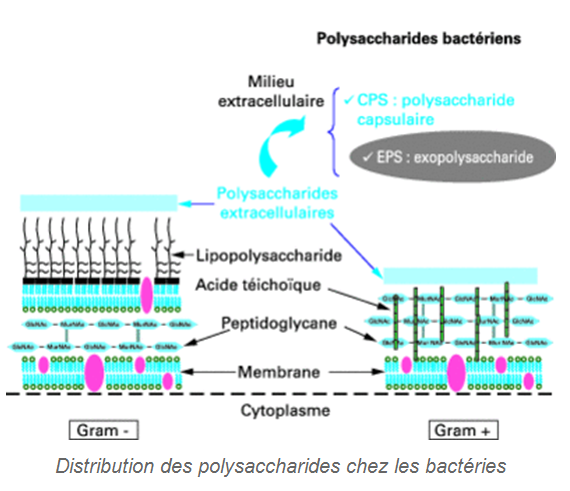

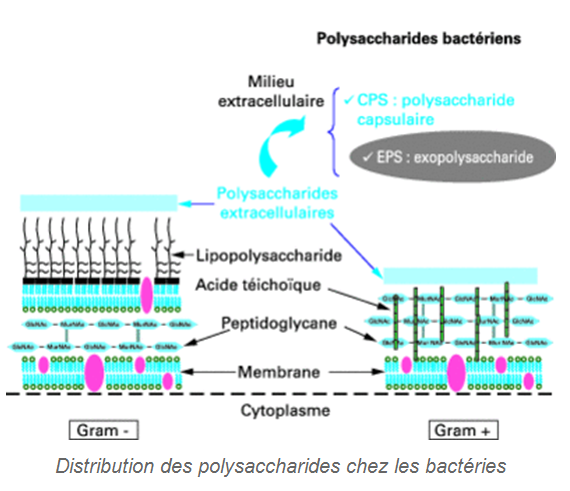

Les polysaccharides peuvent être définis comme des macromolécules formées de l’enchaînement de motifs similaires, en l’occurrence de glucides appelés couramment « sucres » ou « oses ». Initialement dominé par les gommes d’origine végétale et algale, leur marché s’ouvre également aux polysaccharides bactériens. En milieu marin, cette production semble être majoritairement le fait de souches appartenant aux genres Alteromonas, Pseudoalteromonas, Pseudomonas, Shewanella et Vibrio. Chez les bactéries, ces polysaccharides sont présents au niveau de la paroi cellulaire, à l’extérieur de la cellule mais liés à celle-ci (polysaccharide capsulaire) ou relargués dans le milieu de culture sous forme d’exopolysaccharides (EPS).

Des molécules biosourcées pour la cosmétique

De par leurs propriétés biologiques, chimiques et physico-chimiques, les EPS peuvent trouver des applications dans différents secteurs d’activités tels que la santé, la chimie, le phytosanitaire, la nutraceutique, l’environnement, la récupération assistée des huiles et la cosmétique. Si des exopolysaccharides bactériens ont trouvé des applications (xanthane, gellane, hylauronane, succinoglycanne, curdlane, pullulane, dextranes…), force est de constater que rares sont ceux d’origine marine ayant connu à ce jour un réel développement.

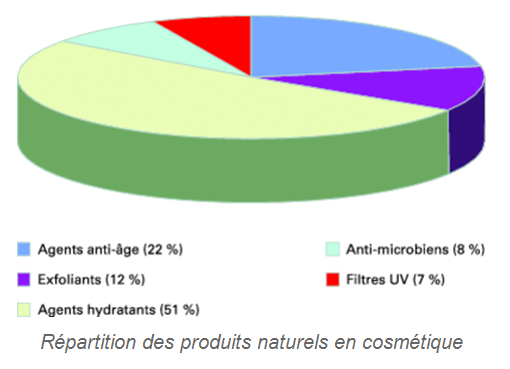

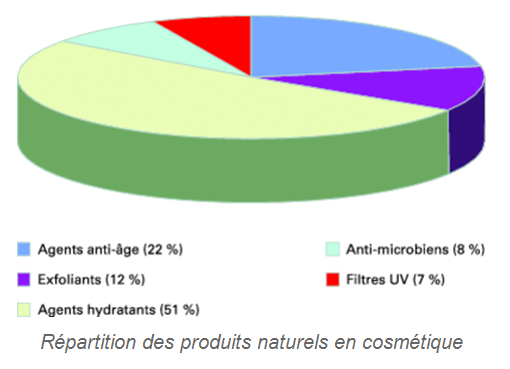

Parmi les secteurs en demande de polysaccharides, il y a la cosmétique et la cosméceutique. En effet, la limite entre pharmaceutique et cosmétique devient de plus en plus tenue au regard de l’évolution des législations et d’une prise de conscience des utilisateurs, d’où cette terminologie de « cosméceutique » venant compléter celle de « cosmétique ». Il s’agit là d’un secteur économique en forte croissance et correspondant à une demande sociétale en expansion. La cosmétologie/dermo-cosmétologie est un domaine en quête de nouvelles molécules innovantes, tant pour leur « histoire » et origine, que pour leurs propriétés physico-chimiques et leur efficacité. Dans ce secteur, l’utilisation d’ingrédients biosourcés, la préservation de l’environnement naturel, la diminution de l’utilisation de solvants dans les procédés de fabrication, le contrôle des rejets de CO2… sont des arguments que les plus grandes enseignes mettent en valeur afin de répondre à une demande de marché de plus en plus croissante. Le milieu marin se présente alors comme un domaine de recherche tout à fait en adéquation avec l’ensemble de ces critères.

Des produits « anti-âge » aux traitements dermiques

Parmi les produits les plus recherchés, il y a naturellement les molécules « anti-âge » (agents hydratants, raffermissement de la peau, lissage, antirides, réparation cellulaire, régénération des cellules dermiques, protection contre les UV, etc.). D’une manière plus générale, il s’agit de molécules en adéquation avec une volonté affichée des consommateurs d’un meilleur bien-être passant, en premier lieu, par l’apparence physique et l’entretien du corps. Dans les pays industrialisés, cette tendance a débuté auprès des « baby-boomers » de l’après-guerre mais se poursuit maintenant, et de plus en plus, avec les nouvelles générations. Ces produits « anti-âges » comprennent les vitamines (pour plus de 50 % de ce marché : vitamines A, B5, C et E), mais aussi les polysaccharides (acide hyaluronique, chitosane et β-glucanes) pour plus de 20 %. À ces produits majoritaires, il convient d’y ajouter les peptides et protéines, les enzymes et co-enzymes, les extraits naturels et d’autres produits comme les hydroquinones, amino-acides, etc. Et à cet énorme marché vient également s’ajouter celui des systèmes de délivrance et libération contrôlée des actifs cosmétiques sous forme de nanoparticules, nanoémulsions, microcapsules et millicapsules, ainsi que les patches. D’autres pistes de développement sont envisageables, qui utiliseraient la propriété de polysaccharides à fixer certains ions spécifiques (argent, cuivre, zinc et titane) intervenant par exemple dans le traitement de l’acné ou autres affections dermiques.

Des EPS d’origine bactérienne

Bien que la classe des polysaccharides soit déjà bien représentée en cosmétique et dermo-cosmétique notamment via les algues, la demande persiste pour de nouvelles molécules caractérisées par la diversité de leurs origines, l’originalité des unités saccharidiques et de leurs propriétés physico-chimiques, biologiques et rhéologiques, permettant d’envisager des applications sous des formes galéniques variées. Au titre de ces nouvelles opportunités, on retrouve tout naturellement les micro-organismes comme sources d’exopolysaccharides bactériens originaux. Ces exopolysaccharides bactériens présentent quelques atouts comme l’absence de dépendance vis-à-vis d’aléas climatiques, écologiques et politiques pouvant affecter la qualité, le coût et l’approvisionnement de leurs homologues extraits d’algues ou de plantes. De plus, les possibilités d’agir sur les conditions de fermentation (sources de carbone, température, aération, pH, etc.) – en vue d’optimiser la production, d’assurer la traçabilité, mais aussi de modifier le polymère produit – jouent en faveur de la fermentation bactérienne. Ces polymères présentent souvent un degré de régularité de structure plus important et peuvent être extraits et purifiés sans l’utilisation de conditions drastiques. Les inconvénients de ces polymères bactériens restent liés aux micro-organismes eux-mêmes, à leur manipulation et conservation ainsi qu’à la production de métabolites secondaires et coproduits associés à la fermentation.

Perspectives

Les exopolysaccharides bactériens d’origine marine font partie de ces molécules à fort potentiel biotechnologique, soit à l’état natif soit après modifications chimiques et surtout enzymatiques. Le fait de pouvoir également contrôler en amont cette production, via le génie génétique ou plus simplement par une connaissance des mécanismes de biosynthèse, constitue une voie d’avenir. Dans cette attente, le développement industriel de ces exopolysaccharides marins reste à ce jour relativement limité car il se heurte, comme d’autres EPS, à un problème majeur, leur coût de production, un coût qui doit être compatible selon les applications, avec les réalités économiques. À titre d’exemple le coût de production des principaux EPS marins commercialisés à ce jour peut dépasser les 500 à 1 000 euros/kg alors que celui du xanthane se situe, selon la qualité recherchée, aux alentours de 5 à 10 euros/kg. Les solutions à cette réduction des coûts de production passent par l’utilisation de substrats carbonés peu onéreux, comme les coproduits de l’industrie (alimentaire, énergie) et une simplification des procédés d’extraction et de purification en évitant, autant que faire se peut, l’utilisation de solvants organiques. Dans cette attente seuls les marchés de niche ou ceux de la santé, mais sous réserve d’une pureté et reproductibilité de polysaccharides natifs ou modifiés, semblent alors accessibles.