En France, le CDI reste la norme : 87 % des salariés du secteur concurrentiel occupent un contrat à durée indéterminée, une part relativement stable depuis les années 2000.

Après une forte régression au cours des années 1980-90, la part de l’emploi non salarié est en progression depuis 2008. Aussi, de nombreux articles de presse annoncent la fi n prochaine du salariat classique au profit des nouvelles formes d’emploi.

La création du régime d’autoentrepreneur (indépendant sans salarié) en 2008 a en effet entraîné une appétence nouvelle pour l’entrepreneuriat. La part dans l’emploi du travail indépendant était estimée à 12 % en 2016. Depuis 10 ans, l’emploi non salarié progresse plus vite que l’emploi total, en particulier dans le secteur tertiaire. Par ailleurs, les modalités d’exercice de l’emploi salarié sont bousculées avec une progression du temps partiel, des horaires décalés ou variables. Le développement de la pluriactivité, estimée à plus de 2 millions d’actifs, bouleverse également les relations à

l’emploi tout comme l’apparition des groupements d’employeurs et des entreprises de travail à temps partagé qui visent à faciliter le partage de main d’œuvre et la sécurisation des actifs.

Les formes d’emploi atypiques se révèlent nombreuses en nature mais relativement marginales en volume. Ainsi, 30 000 personnes seraient concernées par le portage salarial, 30 000 par les groupements d’employeurs et quelques centaines par le temps partagé. Toutefois, selon le CNIS, malgré la dynamique actuelle de ces formes d’emploi, le seuil des 100 000 emplois ne serait pas dépassé.

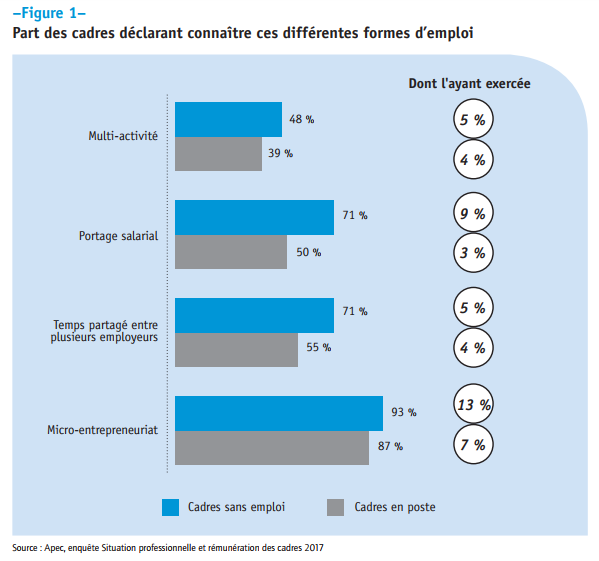

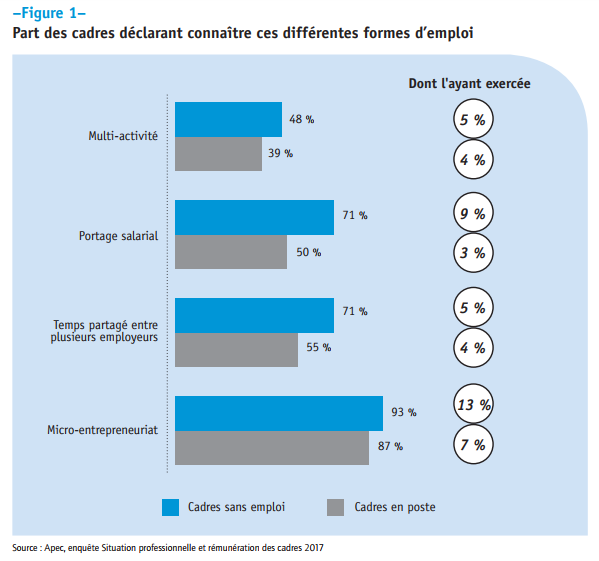

Selon l’enquête quantitative « Situation professionnelle et rémunération des cadres », les cadres connaissent plus ou moins bien ces nouvelles modalités d’exercice du travail. Pour autant, très peu les ont expérimentées. Le microentrepreneuriat est de loin le mode qui bénéficie de la plus forte notoriété chez les cadres en poste (87 % d’entre eux le connaissent) mais seulement 7 % déclarent avoir exercé une activité sous ce régime.

Globalement, ces nouvelles formes d’emploi suscitent un intérêt certain chez 7 cadres en poste sur 10. L’appréhension de ces nouvelles formes d’emploi évolue cependant au gré des caractéristiques des cadres, de leur poste ou encore de leur entreprise. Ainsi, le portage salarial est plus souvent connu par les cadres de 50 ans et plus, ceux ayant récemment changé d’employeurs ou encore ceux occupant un poste dans la fonction informatique.

Ces nouvelles formes d’emploi trouvent, en toute logique, un écho particulier chez les cadres sans emploi. Ces derniers sont plus nombreux, en proportion, à les connaître et à les avoir expérimentées.

En complément de ces éléments quantitatifs, les enseignements présentés ci-après s’appuient sur une étude qualitative conduite par l’Apec afin d’appréhender les motifs d’accès et de recours aux nouvelles formes d’emploi des cadres et leur vécu.

UNE MISE À DISTANCE DU SALARIAT OU UNE APPÉTENCE PARTICULIÈRE ?

L’accès aux nouvelles formes d’emploi relève avant tout d’une conjonction de facteurs de différents ordres. C’est en effet généralement un contexte particulier qui favorise la bascule vers une nouvelle forme d’emploi.

La volonté de (re)devenir acteur de ses temps professionnels et personnels

La majorité de l’échantillon interrogé s’est tournée vers une nouvelle forme d’emploi, notamment sous une forme entrepreneuriale, à la recherche d’un mode de production alternatif au salariat. Le premier motif d’accès ou de motivation était le souhait de recouvrer une certaine autonomie dans ses arbitrages professionnels ainsi qu’une meilleure conciliation avec la vie privée. Il s’agit dans la plupart des cas de restaurer de la flexibilité, d’avoir la possibilité de s’organiser différemment, même si, par ailleurs, la charge de travail peut être plus importante et plus chronophage dans le nouvel emploi que dans un emploi salarié classique. Ces aspirations sont partagées par l’ensemble des cadres interrogés : toutes classes d’âges confondues, des cadres les plus contraints (avec une charge de famille) aux cadres en fin d’activité professionnelle et largement par les plus jeunes. Toutefois, cette aspiration à un mode productif alternatif, plus souple mais également plus responsabilisant, n’est pas suffisante pour envisager de basculer sur une nouvelle forme d’emploi.

La maturité professionnelle et un désir d’autonomie

Dans un contexte professionnel estimé insatisfaisant, la maturité des compétences professionnelles et la confiance dans leur expertise métier sont, pour les cadres, des facteurs qui vont les encourager à poursuivre leur carrière sous une nouvelle forme d’emploi. Le sentiment de ne plus progresser dans leurs fonctions ou attributions, de ne pas avoir de perspectives d’évolution métiers au sein de l’entreprise (acquisition de nouvelles compétences ou de savoir-faire) et ne plus partager la vision ou l’orientation stratégique de l’entreprise portée par la hiérarchie ou l’encadrement constituent des motifs de bascule vers une nouvelle forme d’emploi. L’entrepreneuriat peut, en effet, permettre de valoriser des compétences, de les faire évoluer dans un rapport au travail renouvelé, notamment par une relation client plus engagée en offrant une offre de service plus personnalisée. Pour les cadres à l’expertise sectorielle plus limitée ou au parcours professionnel plus erratique, la recherche d’un environnement davantage centré sur des valeurs ou des conditions de travail plus en phase avec leurs aspirations les conduit à s’orienter vers une nouvelle forme d’emploi.

Un environnement sécurisé prégnant

Pour les cadres, bénéficier d’un environnement sécurisé, permettant le développement de leur projet, constitue également un facteur déterminant. En effet, l’ensemble des cadres interrogés ont pu concrétiser leur projet parce qu’ils se trouvaient dans un environnement favorable, susceptible d’amortir la prise de risque inhérente au choix d’une nouvelle forme d’emploi… Le soutien parental, en nature (hébergement, aide administrative…) ou financier pour les plus jeunes, est essentiel. La présence d’un conjoint actif, salarié est aussi l’assurance de bénéficier de protection en matière de risque maladie (accès à la mutuelle) et de revenus (sécurité d’un salaire). Le fait de ne pas avoir de charge familiale peut également être appréhendé comme un facteur de sécurisation voire de bascule vers une nouvelle forme d’emploi. Pris indépendamment, ces facteurs vont inciter et participer au fait que les cadres choisissent de s’engager dans une nouvelle forme d’emploi. Toutefois, c’est très souvent la conjonction de plusieurs de ces facteurs qui va favoriser le passage à l’acte.

UN DÉTACHEMENT CONTRAINT DU SALARIAT

Pour un tiers des cadres interrogés, l’accès à ces nouvelles formes d’emploi et plus précisément l’entrée en entrepreneuriat, même sous statut salarié, n’est pas un choix de première intention. Plusieurs situations peuvent conduire les cadres à envisager une nouvelle forme d’emploi.

Une rupture professionnelle subie

Pour certaines des personnes interrogées, l’orientation vers une nouvelle forme d’emploi intervient après un licenciement. Face aux difficultés rencontrées dans leur recherche d’un poste salarié, la plupart envisage assez rapidement une autre forme d’emploi orientée vers l’indépendance. Pour autant, ces cadres ne songeaient pas particulièrement à développer une activité en indépendance. Ils ne se projetaient pas dans la création d’activité et dans la posture d’entrepreneur nécessitant certaines compétences : vision stratégique, capacité commerciale, connaissances administratives et financières… L’activité en indépendance, au-delà du bouleversement de posture, suscite en outre des inquiétudes quant à la nature et au niveau de protection associée (santé, indemnisation chômage, retraite).

Une insertion professionnelle difficile pour les jeunes actifs

Dans un contexte d’insertion difficile pour les jeunes actifs sur le marché de l’emploi, l’accès aux nouvelles formes d’emploi, ou le passage par une de ces formes, s’inscrit pour eux (tout particulièrement pour ceux disposant d’une faible expérience professionnelle et / ou ceux souhaitant travailler dans des secteurs peu recruteurs) dans une logique d’adaptabilité. Les nouvelles formes d’emploi sont alors davantage perçues comme la matérialisation d’une précarisation générale des statuts et formes d’emploi qui fait écho aux difficultés d’insertion sur le marché de l’emploi.

UN IMPORTANT BESOIN D’INFORMATIONS ET DE CONSEILS PERSONNALISÉS

Par réflexe mais aussi par défaut, Internet constitue une première source d’information nécessaire mais non suffisante. Parmi les cadres interrogés, les plus experts dans leur recherche ont exploité l’ensemble des sites gouvernementaux, institutionnels et « communautaires » (forum d’autoentrepreneurs ou propres au secteur numérique) et tentent en complément de prendre contact, le plus souvent par téléphone, avec le RSI ou les services fiscaux. La plupart ont recours à leur cercle de proches, familles et amis, voire leurs connaissances, pour obtenir des précisions en matière comptable essentiellement (déclaration du chiffre d’activité, suivi de la comptabilité). Le caractère complémentaire de l’activité entrepreneuriale joue sans aucun doute sur le temps consacré à cette recherche et la nature des informations mobilisées. Hors autoentrepreneuriat, les autres formes d’emploi (portage, CAE, groupement d’employeurs) sont peu connues et ne font pas véritablement l’objet d’une recherche approfondie d’information. Les cadres en portage ont le plus souvent opté pour la société de portage suite à la recommandation d’un collègue ou d’un ami. Les cadres en coopérative d’activité, quant à eux, ont été le plus souvent orientés par les services de l’emploi dans le cadre d’un accompagnement au retour à l’emploi. Le manque d’opérationnalité et de personnalisation de l’information est souligné par les personnes interrogées. Plus qu’une recherche d’information au sens strict, les cadres sont en attente d’une information « orientée », « d’un accompagnement de l’information » et très rapidement d’un accompagnement personnalisé qui puissent faire cheminer leur projet.

Source : Apec