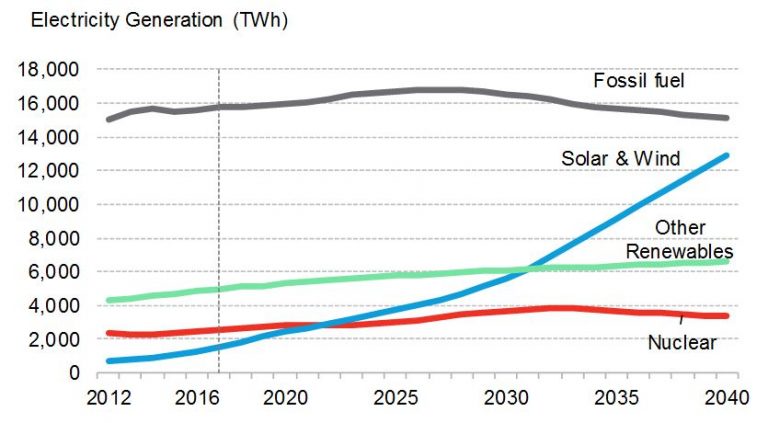

L’étude montre que le stockage batterie n’est nécessaire que quand le niveau d’EnR variables dépasse 40-50% explique le média spécialisé RenewEconomy, et qu’il est possible d’atteindre 90% de solaire + éolien quand on fait appel au stockage batterie.

En France le service presse de RTE parvient à des conclusions similaires : « des solutions ont été identifiées pour intégrer jusqu’à 40% d’énergie renouvelable à un coût raisonnable, sans nécessairement avoir besoin de stockage. RTE étudie avec ses partenaires européens des solutions pour aller au-delà de ce seuil. » C’est ce que rapporte le journaliste spécialisé Vincent Boulanger dans un article intitulé « Variabilité: le réseau sait gérer » et publié dans le numéro d’avril-mai 2017 du Journal des Energies Renouvelables.

Selon Boris Shucht, PDG de l’opérateur allemand 50 Hertz (équivalent de RTE) « il y a quelques mythes qui courent dans le monde de l’énergie. On peut prendre l’exemple de la considération voulant que l’intégration des énergies renouvelables exige tout de suite plus de flexibilité du système. C’est à dire du stockage, des capacités d’effacement ou davantage de centrales en back-up. C’est un mythe, nous avons plus de flexibilité dans le système que nécessaire ».

0,75 pour 1

Au niveau de l’architecture énergétique il faut pour chaque GW solaro-éolien une batterie (ou une STEP, qui est une « batterie gravitaire ») d’une puissance de 0,75 GW et d’un volume de 2,6 GWh. Ce qui correspond à 10 heures avec une puissance moyenne de 0,26 GW, soit le quart de la puissance solaro-éolienne installée.

Sur l’île de Kauai (Hawaï) 28 MW de solaire PV sont accompagnés d’une batterie Tesla de 20 MW / 100 MWh. Le prix du solaire + batterie est alors de seulement 11 US cents / kWh (environ 10 c€/kWh). Le rapport puissance solaire / puissance batterie est de 0,71 pour 1, ce qui est très proche du dimensionnement de l’étude australienne (0,75 pour 1). Les 100 MWh correspondent à environ 20 heures de stockage à la puissance moyenne. Plus on augmente le volume d’heures et plus le taux de pénétration EnR augmente. Il est probable que plus de 95% de l’électricité de cette île tropicale sera d’origine solaire à l’échelle annuelle. Les moins de 5% restants seront comblés par du back-up thermique classique.

Sur l’île de Tau 6 MW de solaire PV accompagnés de 6 MWh de batteries ont été installés par l’entreprise SolarCity (Tesla) pour rendre l’île autonome. Ce territoire des Samoas américaines est à présent appelé « l’île de Tesla ».

Sur l’île portugaise de Graciosa l’architecture énergétique proposée par Younicos est de 4 MW / 3,5 MWh de batterie Lithium pour un total de 5,5 MW de solaro-éolien. Le ratio puissance est ainsi de 0,72 pour 1. La durée de stockage est en revanche assez limitée, d’environ 4 heures à la puissance moyenne, ce qui permet nénamoins d’envisager d’atteindre un taux d’EnR moyen annuel de 75% selon Younicos. Les 25% restants sont assurés par un back-up thermique classique qui coûte 10 fois moins cher qu’une solution à base d’hydrogène selon Toshiba Corp.

Le faux débat sur « l’inertie réelle »

Ce qui est possible sur l’île portugaise de Graciosa est-il possible en France si l’on considère le pays du « roi soleil » comme une île isolée ? Contacté par Techniques-ingénieur.fr, Philip Hiersemenzel, le porte-parole Europe de l’entreprise berlinoise Younicos est catégorique: « c’est bien entendu possible en France mais aussi en Grande-Bretagne, qui est réellement une île ». L’expert a confirmé ce qu’il a expliqué via le média RenewEconomy : « Nous avons eu écho de la discussion sur l’« inertie réelle » et cela résonne de façon étrange pour nous. Il n’y a, bien entendu, absolument pas besoin d’« inertie réelle » plutôt que d’ « inertie synthétique » pour que le réseau électrique soit stable. En réalité si vous partez du postulat que de plus en plus d’électricité pourrait et va être délivrée à partir d’énergies renouvelables bon marché, propres mais intermittentes, alors l’« inertie synthétique » offre de nombreux avantages manifestes ».

Plus de 80% de solaire PV au sol en France grâce au stockage saisonnier hydrogène, ce projet est-il pertinent ? Pour Philippe Hiersemenzel « nous n’avons pas besoin de stockage saisonnier maintenant. Il faut d’abord atteindre 40%, puis 60% de renouvelables avec du solaire, de l’éolien et des batteries, et après on verra. »

«Nous pouvons atteindre plus de 70-80% de solaire et d’éolien avec le stockage par les STEP (Stations de Transfert d’Energie par Pompage) et/ou les batteries » souligne François Lempérière, président de l’association Hydrocoop et qui a été primé par l’Académie des Sciences, contacté par Techniques-ingénieur.fr.

François Lempérière a proposé plusieurs solutions de STEP innovantes, y compris des STEP marines, tout en soulignant que le potentiel continental en Europe reste très élevé. « Il n’y a pas de lobby des STEP en France » soupire l’ingénieur.

L’ingénieur Samuel Portebos, analyste senior de Clean Horizons Consulting, cabinet spécialisé en stockage, ne tarit pas d’éloges à propos du stockage batterie : « les batteries offrent au réseau des services comparables aux systèmes traditionnels sur le plan de la gestion de la tension et de la fréquence » a-t-il déclaré à Techniques-ingénieur.fr. « En réalité il s’agit même d’un service de qualité supérieure : le temps de réponse passe de quelques secondes à quelques millisecondes. »

François Lempérière souligne de son côté que « les STEP ont non seulement une haute efficacité mais en plus une durée de vie qui peut dépasser le siècle. Les pompes et les turbines peuvent durer 50 ans ».

En Australie cette solution de stockage est considérée avec un grand intérêt. Et ceci même si Elon Musk a proposé d’y construire une centrale de stockage batterie de 100 MW en moins de trois mois.

Par Olivier Daniélo