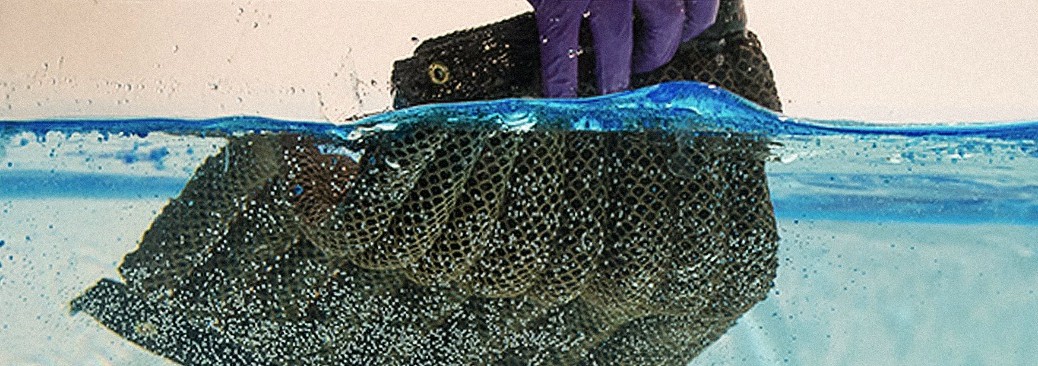

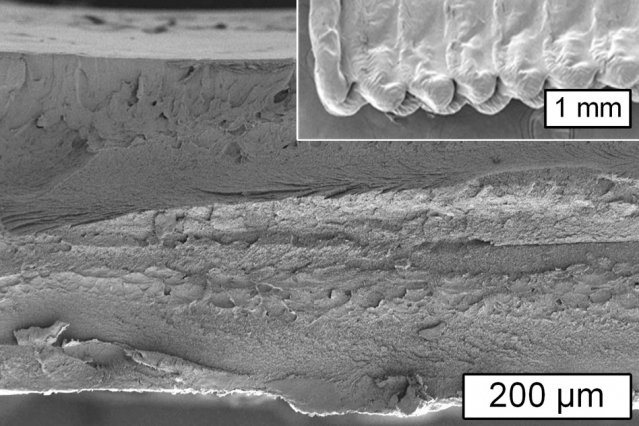

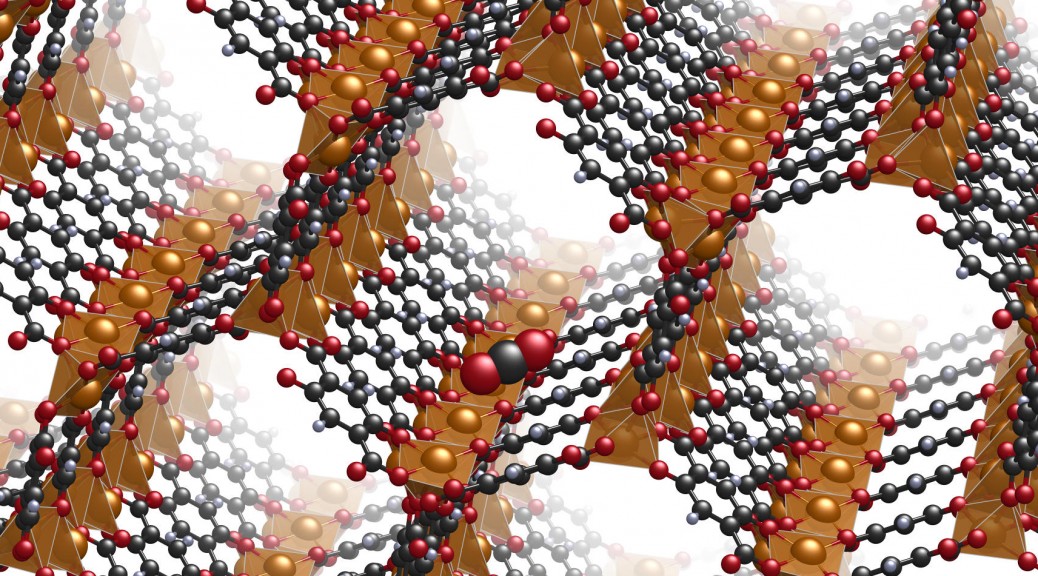

De l’Amoco Cadiz à Deepwater Horizon, les marées noires reviennent régulièrement polluer les côtes et les mers du monde entier. Des chercheurs chinois d’un côté et des chercheurs américains de l’autre ont développé des éponges à hydrocarbures en s’appuyant sur les composés chimiques super-oléophiles et super-hydrophobes. Les éponges à hydrocarbures actuellement sur le marché donnent des déchets solides qu’il faut traiter alors que le nouveau type d’éponges mises au point au laboratoire d’Argonne à Chicago par des Américains présente l’avantage de pouvoir relarguer les hydrocarbures sous une forme utilisable. L’Oleo-Sponge, comme elle a été baptisée, se présente plutôt comme une bande de tissu peut donc être utilisée plusieurs fois. Elle est composée d’un polymère auquel a été ajouté une couche d’oxydes métalliques qui retient les hydrocarbures. Les chercheurs expliquent s’être inspirés des méthodes de synthèse d’infiltration séquentielle (SIS) utilisées à l’échelle nanométrique pour créer leur éponge en polymère. Testée en laboratoire et dans un bassin d’eau de mer, l’éponge a démontré sa capacité à absorber les hydrocarbures à la surface et en profondeur avec un taux de 30 fois son poids d’origine pour le polyuréthane à 90 fois pour le polyimide (voir cette vidéo). Ces recherches ont fait l’objet d’un article dans le Journal of material chemistry A.

Dans ce même journal, un an plus tôt, une équipe chinoise de la Northwest Normal University de Gansu proposait une éponge à hydrocarbure basée sur un polyuréthane dont la surface était couverte d’attapulgite super-hydrophobe. Pour rendre leur éponge pleinement opérationnelle en condition maritime, les chercheurs proposait de la coupler à un système d’aspiration par vide d’air permettant ainsi de récolter 3200 fois le poids de l’éponge en 20s. L’étude note aussi que cette éponge peut permettre de séparer à plus de 99% les gouttes d’huile d’une émulsion huile-eau obtenue après la dispersion d’un tensioactif.

Capter les odeurs et les micro-polluants

Le système de l’”éponge” inspire d’autres secteurs et sous d’autres formes. Ainsi, un article de Science et Avenir de mars 2017 sur la biométrie olfactive en criminologie, se faisait l’écho d’un organogel microporeux mis au point par une équipe de chercheurs toulousains. A base d’huiles végétales et de gélifiants auxquels sont ajoutés des cristaux de sucre, le dispositif piège les odeurs résiduelles, celles que l’on laisse sans s’en apercevoir et ce de manière extrêmement concentré. Alexandra ter Halle, l’une des chercheuses, précise ainsi que “dans une pastille d’organogel de la taille d’une pièce de monnaie la surface de contact avoisine 200m2”. Mais il reste encore à analyser le contenu avec un spectromètre de masse et à le caractériser avec certitude.

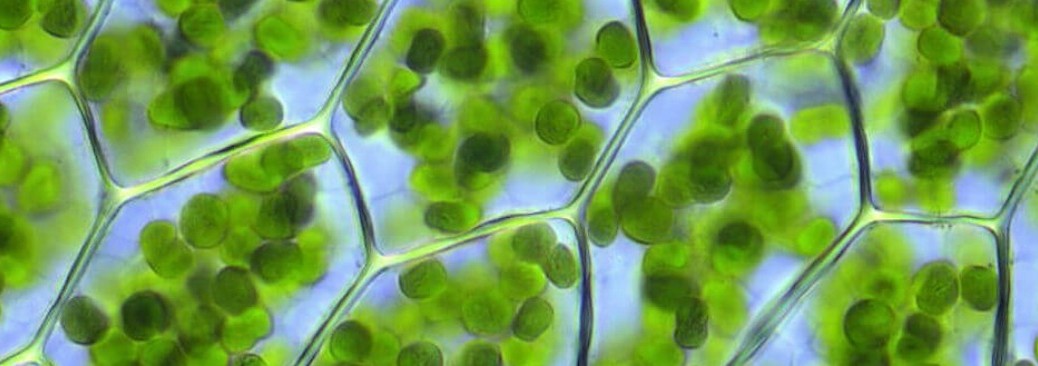

Dans la catégorie piège à molécules, l’innovation se tourne aussi vers le “bio”. Biostart, jeune pousse, récemment primée au concours de l’innovation du Génopole, Genopole Young Biotech Award en décembre 2016, propose ainsi, un polymère à base de cyclodextrine pour piéger les micro-polluants des eaux usées, notamment les 40 visés par la directive européenne sur la protection de l’eau. La cyclodextrine est un polymère que l’on peut par exemple facilement fabriquer à partir de l’amidon de la pomme de terre et qui est couramment utilisé pour l’encapsulation dans l’industrie pharmaceutique. Le brevet déposé, le polymère doit maintenant être testé en conditions réelles dans une station d’épuration.

Sophie Hoguin