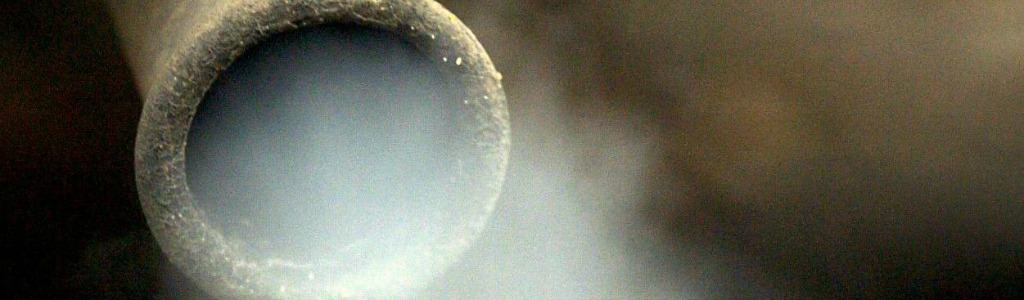

L’eau est pompée quand la ressource solaro-éolienne est abondante, et à l’inverser turbinée quand elle devient rare. Le rendement d’un cycle complet est généralement de 70 à 80%. L’originalité de Nature & People First est de réaliser ce stockage avec des STEP de dimensions réduites que l’on peut déployer en milieu urbain.

Denis Payre a dans la passé fondé deux sociétés devenues des leaders mondiaux dans leurs domaines respectifs dans des secteurs fortement technologiques et très concurrentiels: Business Objects désormais centre de compétence mondial du géant SAP et Kiala désormais centre de compétence mondial du géant UPS.

Denis Payre est également à l’origine de Croissance Plus, un réseau français de dirigeants de petites et moyennes entreprises et entreprises de taille intermédiaire françaises. Ainsi que du mouvement politique Nous Citoyens en 2013 qui a notamment été présidé en 2014 et 2015 par le député européen Jean-Marie Cavada auquel a succédé l’entrepreneur Nicolas Doucerain, directeur général d’U-MEN, un cabinet de conseil spécialisé dans « la gestion de crise et la transformation de nos entreprises ». Nous citoyens compte 5000 adhérents et plus de 30.000 sympathisants.

Denis Payre est également à l’origine de Croissance Plus, un réseau français de dirigeants de petites et moyennes entreprises et entreprises de taille intermédiaire françaises. Ainsi que du mouvement politique Nous Citoyens en 2013 qui a notamment été présidé en 2014 et 2015 par le député européen Jean-Marie Cavada auquel a succédé l’entrepreneur Nicolas Doucerain, directeur général d’U-MEN, un cabinet de conseil spécialisé dans « la gestion de crise et la transformation de nos entreprises ». Nous citoyens compte 5000 adhérents et plus de 30.000 sympathisants.

Techniques de l’ingénieur (TI): Quels sont les atouts de la technologie choisie par Nature & People First dans le domaine des technologies du stockage ?

Denis Payre (DP): Notre initiative à l’avantage de capitaliser sur des savoir faire français majeurs: l’hydroélectricité avec des fabricants de turbine encore capable de produire en France et ayant une réputation mondiale (rappelons le rachat de Alstom Power par l’américain General Electric), le génie civil avec des groupes mondiaux dont la réputation de savoir faire et de capacité à innover n’est plus à faire.

De plus, outre le fait de faire travailler en priorité des entreprises françaises et des employés français sur toute la chaîne ou presque, au moins dans les zones françaises, chose rare en matière de transition énergétique, nous allons aussi donner du travail à du personnel peu qualifié ce qui dans un contexte de chômage de masse pour ces profils, est aussi une bonne chose.

Notre projet a une ambition mondiale comme tous mes projets précédents. Nous avons déposé des brevets dans plus de 60 pays sur notre approche et sommes détenteurs de brevets en Europe et USA à ce stade. Nous serons amenés à faire des annonces complémentaires prochainement sur notre stratégie de déploiement.

TI : Selon François Lempérière, ex-Président du Comité Français des Grand Barrages et fondateur d’Hydrocoop, plus une STEP est de dimension importante, plus elle est rentable. Certes les grandes STEP inondant des vallées posent des problèmes d’acceptabilité environnementale et sociale mais l’équation économique des micro-STEPs urbaines est-elle solide ?

DP : Nous avons effectué un certain nombre de simulations technico-économiques très poussées appuyées sur des études et devis des meilleures sociétés de production hydroélectrique et de génie civil françaises et basés des sites précis qui montrent que le coût des micro STEPs est probablement très inférieur au coût de meilleures batteries actuelles et le restera avec l’évolution des coûts prévisibles des batteries sur les années à venir, pour au moins deux raisons:

- La durée de vie de nos équipements est de 50 à 60 ans, voire plus, or la durée de vie de batteries Lithium Ion, les moins chères actuellement et les plus performantes, est de 7 à 12 ans au grand maximum. Après cette échéance, il faut renouveler les matières premières à un coût inconnu à ce jour et sur lequel on ne peut que spéculer.

- Nous sommes capables de rendre des services que les batteries ne savent pas rendre à un opérateur électrique comme la fourniture d’inertie pour maintenir la fréquence du réseau. L’inertie chute avec le déploiement des panneaux solaires par définition non générateurs d’inertie et accessoirement le déploiement de turbines à gaz ou diesel plus légères car issues de l’aéronautique. L’inertie est fortement valorisée par les opérateurs. Les fabricants de batteries tentent de fournir de « l’inertie synthétique » mais n’y parviennent pas aux dire des grands opérateurs qui testent ces solutions.

TI: Les batteries ne constituent-elles pas néanmoins des solutions de stockage plus simples à mettre en œuvre, et ceci partout sur Terre ?

DP: Les batteries posent des problèmes majeurs d’acceptabilité, particulièrement dans les îles qui sont des destinations touristiques qui se veulent à juste titre éco-responsables. Elles sont de plus très volatiles et peuvent prendre feu très facilement ce qui pose aussi bien sûr des problèmes de sécurité dans des zones touristiques souvent arides.

Leur capacité à fournir des solutions de stockage de masse, plus de deux heures sur plusieurs MW, ne sont pas prouvées actuellement. Cela reste de la R&D. Enfin, elles utilisent des matériaux non renouvelables comme le Lithium qui n’est produit actuellement que par un petit nombre de pays. La Banque Goldman Sachs ne s’y est pas trompée. Elle a dit récemment que les batteries étaient « le nouveau pétrole du 21° siècle » du fait des cartels qui commencent à se mettre en place…

Notre approche à l’inverse repose sur l’utilisation de l’eau, un composant renouvelable qui de plus n’est pas consommé dans notre cas. Notre technologie est propre, totalement fiable, ce n’est pas de la R&D, et 100% renouvelable. Nous avons travaillé sur l’acceptation de nos micro STEPs en les intégrant dans le paysage urbain et en prévoyant de placer sur les réservoirs des infrastructures peu couteuses mais très utiles aux collectivités comme des parkings ou des terrains de sport.

Nos échanges avec des élus montrent un soutien très fort à cette approche. Nous prévoyons de mutualiser donc l’utilisation du foncier ce qui en fait des infrastructures qui ne sont pas perçues comme une gêne pour la collectivité mais au contraire comme un élément bénéfique d’autant qu’à l’infrastructure utile à la collectivité viendra s’ajouter une source de revenus pour l’utilisation du foncier sur une période très longue.

Les batteries rejettent régulièrement des déchets hautement toxiques qui vont le rester pendant près de 1.000 ans, cela ressemble au nucléaire.

TI: Elon Musk explique que le lithium est recyclable et que de plus il constitue un composant mineur des batteries dites « lithium ». La giga-usine en construction dans le Nevada dont la première tranche a été inaugurée en juillet 2016 intègre un volet recyclage. Plusieurs rapports (dont celui du MIT, « The future of Solar », 2015) montrent qu’il n’y a pas de pénurie de Lithium en perspective, même dans l’hypothèse d’un monde devenu 100% solaire photovoltaïque. Enfin il existe des batteries qui ne contiennent pas un seul gramme de lithium…

DP: Le lithium est recyclable, c’est exact. Cependant le coût du recyclage est actuellement environ 5 fois supérieur au coût du lithium lui même ce qui le rend prohibitif sur la base du coût actuel du lithium. Il n’est pas certain que ce coût complet soit actuellement modélisé à son juste prix par les promoteurs de batteries. Si le lithium n’est pas recyclé, alors on se retrouve avec des déchets hautement toxiques pour une longue durée.

Il est probable que les batteries au lithium se développent pour les applications où elles sont très compétitives techniquement: pour les applications embarquées comme des objets électroniques ou des véhicules électriques mais sur des bases de coûts fortement supérieurs aux coûts actuels compte tenu du coût du recyclage élevé et compte tenu de la demande croissante et du caractère limité des ressources de lithium au plan mondial, un parallèle avec le pétrole.

Le prix du lithium a déjà été multiplié par 3 en 10 ans pour cette raison et les constructeurs automobiles de véhicules électriques s’attendent à ce que la demande de lithium dépasse l’offre à partir de 2020. Il est probable que pour les applications de stockage d’énergie, le lithium soit la dernière solution envisagée après des solutions moins coûteuses comme les micro STEPs urbaines intégrées.

Il est certain que les micro STEPs ne pourront pas être mise en œuvre partout car il faut du dénivelé, néanmoins au même titre que la Suisse grâce à son relief a longtemps été la batterie de l’Europe, on peut imaginer que les zones collinaires et montagneuses d’une région jouent ce rôle pour les zones ayant moins de relief.

Les batteries au lithium seront donc probablement les solutions de dernier recours lorsque les autres options auront été épuisées. Or il se trouve que les zones à fort potentiel de stockage actuellement et donc à court terme, sont des zones ayant aussi un relief important : îles françaises des Caraïbes, Réunion, Corse, Californie et Hawaï.

TI : Les pays qui jouissent de gisements en lithium, cobalt et graphite n’ont-ils pas tout à gagner du déploiement de cette technologie ?

DP: Le lithium a un autre inconvénient non négligeable qui est la complexité et le caractère polluant de son exploitation. Le lithium est logé principalement dans la saumure de marais salant de quelques plateaux arides de pays andins. Son extraction nécessite le pompage d’eau salée émetteur de CO2. Le lithium est obtenu ensuite par évaporation et ajout de carbonate de sodium et de chaux. Cela provoque une pollution des sols, une raréfaction de l’eau et une pollution de l’air et de l’eau par les produits utilisés. La rare nourriture des populations pauvres de ces zones est aussi impactée.

Les populations locales commencent à s’organiser pour contrer cette exploitation peu renouvelable de leurs terres faisant peser un risque fort sur la pérennité de ces exploitations, en tout cas à minima aux conditions économiques actuelles. La nature de l’exploitation du lithium est aussi un facteur de hausse de prix et même peut être de pénurie si les populations de certaines zones s’y opposent catégoriquement.

Enfin, le lithium comme le pétrole est confronté à un problème de concentration géographique des ressources dans des pays qui peuvent subir une instabilité politique et provoquer des difficultés d’approvisionnement. 70% des ressources mondiales de Lithium seraient concentrées en Argentine, Bolivie et Chili, des pays dont l’histoire récente n’a pas été marqué par la stabilité.

L’apport de ressources liées à une ressources naturelle rare ne favorise pas pour autant la stabilité politique comme le montre actuellement dans cette région le Venezuela avec le pétrole, c’est même parfois l’effet inverse qui se produit, en retirant les incitations à organiser une économie productive, diversifiée et à valeur ajoutée.

TI: Devrait-on selon-vous abandonner la voie du stockage batteries ?

DP: Chez Nature & People First nous ne sommes pas opposés aux batteries, l’avenir sera constitué d’une multitude de solutions en fonction des besoins spécifiques de chaque site. Nos interlocuteurs au sein des opérateurs avec lesquels nous discutons partagent notre vision et nous disent que les batteries seront probablement les dernières options quand tout le reste aura été écarté compte tenu des problèmes évoqués plus haut qui rappellent l’ère Nucléaire/ Pétrole.

Je suis un admirateur d’Elon Musk. Il a réalisé de belles choses mais certains de ses paris ne sont pas encore validés. Le choix par exemple de la batterie comme mode de locomotion des voitures de demain n’est pas partagé par tous les constructeurs automobiles de la planète. Les constructeurs japonais, très puissants et très innovants, les premiers à se lancer dans les véhicules motorisés par batteries via les véhicules hybrides, misent plutôt maintenant sur les piles à combustible à hydrogène, beaucoup plus propres et ayant semble-t-il un rapport poids/ puissance plus favorable et délivrant probablement un couple supérieur à celui des batteries.

Là encore, je ne prends pas partie, je dis juste que l’avenir est en train de s’écrire et que rien n’est joué, que la batterie n’est pas nécessairement promise à un avenir aussi large, en dehors des applications légères que nous connaissons déjà (objets connectés..) pour lesquels elle est probablement adaptée.

TI: Quel regard portent les géants français de l’énergie sur votre innovation ?

DP: EDF SEI est séduit par notre approche, notamment pour l’Outre-Mer. Nous sommes aussi en contact avec ENGIE dont la nouvelle stratégie repose fortement sur le solaire photovoltaïque.

Un entretien entre Thierry Lepercq (devenu Vice-président d’ENGIE en charge de l’innovation et fondateur de Solaire Direct) et Denis Payre est disponible depuis le site de Challenges.fr, ceci dans le cadre du Sommet des start-ups.

Olivier Daniélo