Ce n’est plus un secret pour personne : les données permettent de prédire nos comportements. Réellement.

Les services de renseignement et les forces de police développent des systèmes permettant de détecter les comportements suspects sur Internet, ou de brasser une grande quantité de données, afin de prédire (ou presque) les crimes. C’est par exemple le cas de PredPol, utilisé par la police américaine.

Prédire le crime et détecter les suspects

Basé sur des algorithmes, ce logiciel permet de prédire les lieux où surviendront des crimes, en temps réel. Et les résultats sont là : en 2014, en moins d’un an, la criminalité de la ville de Santa Cruz avait déjà baissé de 27%.

Développé par un mathématicien, un criminologue et un anthropologue américain, PredPol est aussi utilisé en Europe, par la police du Kent, en Grande-Bretagne, qui le teste depuis un an. Se présentant sous la forme d’une carte, actualisée en permanence, PredPol existe aussi en version « mobile », pour smartphone ou tablette, et permet aux policiers de se rendre sur les lieux d’un crime… avant qu’il ne soit commis.

PredPol est inspiré des programmes de prévention des séismes. Il utilise des algorithmes, mais aussi une base de données qui recense toutes les infractions passées dans un lieu donné. PredPol a déjà conquis plusieurs villes américaines : Los Angeles, Memphis (Tennessee), Charleston (Caroline du Sud) et New York.

Autre exemple d’analyse prédictive grâce aux données : Indect. Impossible de savoir ce que les scientifiques de l’Union européenne ont fait des recherches effectuées dans le cadre de ce projet, entre 2009 et 2013, mais il y a fort à parier que l’on retrouve quelques uns de ses algorithmes dans le système utilisé par les services de renseignement, une fois la loi de surveillance définitivement actée.

Grâce à une compilation de comportements suspects et d’algorithmes, les caméras de surveillance deviennent “intelligentes” et permettent de détecter un comportement “anormal”. Sur Internet, des outils de reconnaissance optique de caractères, de reconnaissance faciale et de reconnaissance audio permettent de détecter des suspects virtuels.

Les RH prédictives

Mais au delà de cette utilisation par les forces de l’ordre, le big data peut aussi permettre de prédire nos comportements dans un tout autre domaine, celui de l’entreprise.

Comme le note Jean-Baptiste Audrerie, spécialiste du marketing canadien, sur son blog, l’analyse d’une masse gigantesque de données permettra à terme aux “DRH” (directeurs des ressources humaines) d’en savoir beaucoup sur les candidats à un poste, sans même consulter de CV ou sans avoir besoin de les rencontrer.

Il existe déjà des tests, comme le célèbre questionnaire de personnalité PAPI, qui consiste à vous faire répondre à une longue série de questions, qui croisées, créent une sorte d’organigramme reflétant votre comportement en entreprise.

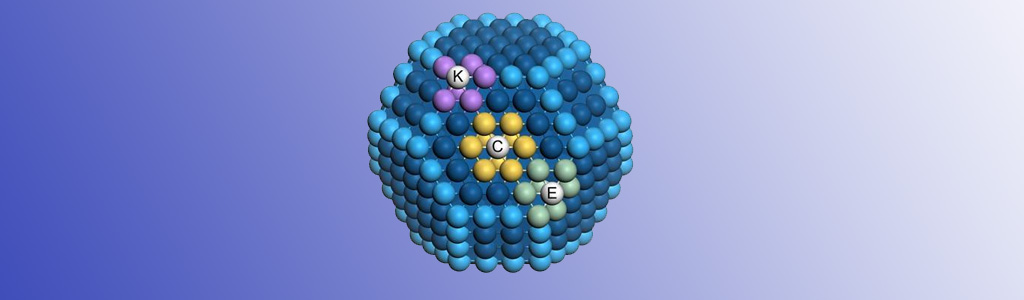

Mais le big data et le machine learning (en français, “apprentissage automatique”, un champ de l’intelligence artificielle) permettent d’aller plus loin. Ainsi, le service Watson Developer Cloud BlueMix d’IBM permet d’analyser votre personnalité, et d’en dresser là aussi une carte, mais d’une façon bien plus fine que PAPI.

Comme le note Jean-Baptiste Audrerie, en Chine, L’Oréal recrute déjà de jeunes diplômés grâce à la reconnaissance du langage : “le géant des cosmétiques a développé une technologie mobile (application sur smartphone) qui permet d’enregistrer et d’analyser les réponses verbales de candidats à trois questions”.

Ainsi, cette application développée par l’entreprise Seedlink Tech, permet de “prédire sur la base d’un modèle scientifique la corrélation du langage avec les aptitudes de ventes. La pré-sélection indique quel candidat a les meilleurs aptitudes et le meilleur pronostic de performance dans l’emploi”, explique Jean-Baptiste Audrerie.

En outre, les algorithmes peuvent même permettre de prédire le départ d’un salarié. Ainsi, comme l’explique le Wall Street Journal, WallMart et Crédit Suisse utilisent de gros paquets de données pour prédire quel employé est susceptible de quitter l’entreprise, en fonction de ses performances, de son lieu de vie, de ses traits de personnalité, ou encore de ses interactions sociales. Objectif : détecter les “talents” qui risquent de partir, afin de les garder au moyen de primes et d’augmentations de salaires. Bref, l’avenir semble définitivement radieux.

Par Fabien Soyez