Censés privilégier l’électricité, les premiers financements issus du mécanisme pour l’interconnexion en Europe (MIE) ont été affecté… au gaz. Ce mécanisme de financement mis en place par l’UE afin de soutenir des projets d’intérêt commun en matière de transport, d’énergie et de télécommunication a lancé cette semaine une première série de financements pour 1,37 milliard d’euros.

647 millions d’euros ont d’ores et déjà été alloués, dont une majorité aux projet liés au gaz (392 millions d’euros), tandis que les projets liés à l’électricité se sont vus allouer seulement 255 millions.

Problème, le règlement du MIE stipule que la « majeure partie de l’aide financière » disponible doit être allouée aux projets liés à l’électricité pour 2014 – 2020. Cet objectif est toutefois « sans préjudice de toute éventuelle réaffectation des financements disponibles pour les projets dans le domaine de l’énergie », précise le règlement.

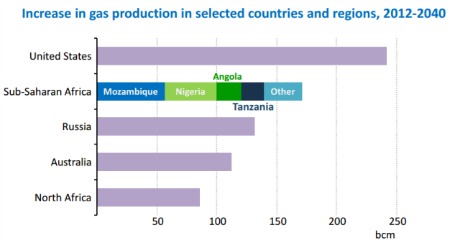

La décision de financer des infrastructures gazières, soutenue par les pays européens, souligne l’inquiétude croissante des États en ce qui concerne la dépendance de l’UE au gaz russe depuis le début de la crise ukrainienne.

Malgré le règlement qui précise que « l’aide […] dans le domaine de l’électricité représentera la majeure partie de l’enveloppe financière allouée à l’énergie », la Commission a annoncé ce mercredi 29 octobre que l’essentiel des 647 millions d’euros investis ira aux infrastructures gazières dans les pays baltes et dans le sud et le centre de l’Europe de l’Est. C’est la première fois que l’UE transfère spécifiquement des fonds à des infrastructures énergétiques.

Les projets financés sont conçus pour relier les « îlots énergétiques » isolés aux réseaux européens et minimiser leur dépendance vis-à-vis du gaz russe. Cela concerne notamment des ports permettant le transport de gaz naturel liquéfié et des gazoducs.

« [Cela] nous aidera à construire rapidement les infrastructures dont l’Europe a besoin pour assurer sa sécurité énergétique, a expliqué Günther Oettinger, le commissaire européen à l’Energie. La crise géopolitique en Ukraine a mis en évidence notre besoin de mettre en place des réseaux énergétiques mieux connectés. »

Le poids du gaz

Sur les 34 projets financés, 16 sont liés au gaz naturel et 18 à l’électricité. Tous ces projets n’ont toutefois pas le même poids financier. Ainsi, les six projets de constructions recevront à eux seuls 555,9 millions d’euros. Le reste des investissements ira aux 28 autres projets, qui concernent des études d’impact et de la recherche.

Le groupe de réflexion E3G a prévenu que l’écart d’investissement, c’est-à-dire la différence entre le montant rééls des financements et les véritables besoins des secteurs, est trois fois plus élevé pour les infrastructures électriques que pour les installations gazières.

« Cela montre que les investissements sont centrés sur les importations de gaz. Les infrastructures électriques critiques et les projets liés à l’efficacité énergétique constitueraient des investissements plus avantageux en termes de sécurité et de résistance énergétiques pour l’Europe », explique à EurActiv Jonathan Gaventa, directeur adjoint d’E3G.

E2G a déjà prévenu que l’UE risque de gaspiller des milliards d’euros dans des infrastructures gazières inutiles à cause des pressions actuelles liées à la crise ukrainienne. Les recherches du groupe de réflexion révèlent que les gazoducs financés par le MIE finiront « abandonnés », parce que la demande en gaz sera fortement réduite.

Interconnexion électrique

La première série de financements du MIE prévoit d’allouer 0,5 % de ses fonds à l’interconnexion franco-espagnole, moins d’une semaine après que les dirigeants européens s’accordent sur le statut de « priorité urgente » de cette connexion.

Un maximum de 3,25 millions d’euros sera réservé aux études de faisabilité concernant l’interconnexion franco-espagnole. En comparaison, le gazoduc lituano-polonais, qui n’est donc pas une priorité, bénéficie tout de même d’un maximum de 295,37 millions d’euros.

« Il est décevant de voir que moins de 1 % du financement du MIE sera dédié à résoudre le problème d’un des pires goulots d’étranglement énergétique européen », regrette Jonathan Gaventa.

Lors du sommet européen consacré à l’objectif climat-énergie pour 2030 les 23 et 24 octobre, le Portugal et l’Espagne ont fait pression pour que les États membres soient contraints de mettre 15 % de leurs capacités de génération d’énergie à disposition des autres pays européens.

Depuis longtemps, les deux pays ont été incapables de vendre leurs surplus d’énergies renouvelables à la France, qu’ils accusent de protéger jalousement son industrie nucléaire.

Les dirigeants européens n’ont toutefois pas été aussi loin, se limitant renouveler leur engagement de 2002 d’une augmentation de 10 % des échanges d’énergie via les interconnexions électriques d’ici à 2020. Cet engagement sous-entend néanmoins une élévation de ce chiffre à 15 % une fois l’objectif initial atteint.

Il n’y a aucun lien entre les conclusions du sommet et les décisions concernant les allocations de fonds actuelles du MIE, soulignent certaines sources espagnoles, puisque certains des projets financés avaient déjà été choisis en 2013.

Les financements concernant l’interconnexion franco-espagnole n’ont pas leur place à ce stade, mais apparaîtront plus tard au programme du MIE, selon ces sources. Quelque 5,85 milliards d’euros ont d’ores et déjà été alloués par le MIE aux infrastructures énergétiques pour la période 2014-2020. Les fonds du mécanisme peuvent être utilisés pour financer des projets couteux qui sont clairement dans l’intérêt commun des pays européens. Le financement peut couvrir jusqu’à la moitié du coût total du projet. En cas de circonstances exceptionnelles, il peut monter jusqu’à 75 %.

Une stratégie déconnectée

Le groupe de réflexion E3G appelle à un changement de la stratégie des États membres et de la Commission à partir de la prochaine série de financements et du prochain appel de demande de financement qui aura lieu en 2015.

Il souhaite que le financement des infrastructures soit guidé par les programmes d’efficacité énergétique européens, que le MIE s’engage en faveur de l’électricité et qu’une partie du financement alloué au transport (secteur qui reçoit le plus de financements) soit transférée au secteur de l’énergie. Le groupe de réflexion estime également que les objectifs européens en matière de climat et d’énergie devraient servir de lignes directrices lors de la sélection des projets.

Source : Euractiv