De nombreuses théories basées sur les équations d’épuisement de certains champs de pétrole sur le modèle californien ont fait florès ces dernières années en annonçant la fin imminente de la ressource pétrolière mondiale.

Or il apparaît, à ce jour, que grâce aux investissements massifs de l’industrie pétrolière, motivée par les prix rémunérateurs, et grâce aux succès d’exploitants américains dans l’extraction de gaz non conventionnels, que les ressources mondiales en hydrocarbures sont de nature à pouvoir satisfaire une demande mondiale de produits pétroliers en progression, tirée vers le haut par les consommations asiatiques. En effet, l’extraction des gaz dont on récupère les condensats (« gaz humides ») contiennent une part importante d’hydrocarbures assimilables à du pétrole léger.

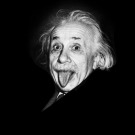

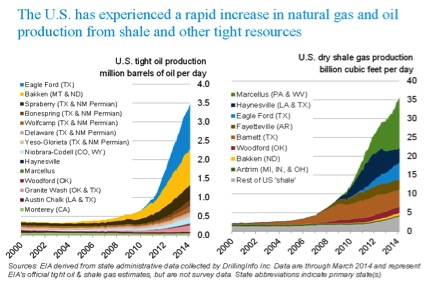

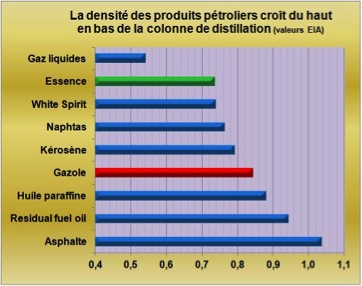

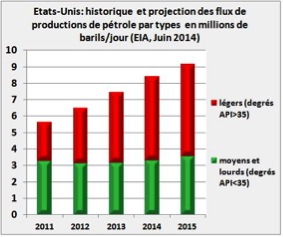

Cet apport de « liquides » sous-produits de l’extraction des gaz, explique pour une large part les progrès rapides réalisés dans l’extraction de pétroles légers aux Etats-Unis (Fig.1) qui implique la poursuite des importations de pétroles lourds ou de bitumes canadiens nécessaires aux raffineries américaines qui produisent et exportent de larges quantités de gazole. Les Etats-Unis vont devenir le premier producteur mondial de pétrole mais ils devront toujours importer du pétrole lourd pour alimenter leurs raffineries.

- Figure 1 : Historique et projection des productions américaines de pétrole par types de densité API (« American Petroleum Institute ») selon l’EIA

L’annonce réaliste d’un pic de production de pétrole (« peak oil ») aurait dû reposer sur l’évaluation la plus rigoureuse et exhaustive possible des « réserves ultimes » qui devraient être connues dans quelques siècles, si l’humanité exploite encore la ressource, quand seront extraits du sous-sol les derniers barils de pétrole et de condensats de gaz.

Cette annonce, largement vulgarisée et commentée durant la dernière décennie, était d’évidence prématurée. Cette incohérence provient essentiellement du fait que les promoteurs de ce « stress écologique » ne prenaient en compte que les seules réserves « classiques » de pétrole et oubliaient de comptabiliser toutes les autres formes d’énergies fossiles et de biomasse qui par le progrès technologique peuvent conduire à l’élaboration de carburants ou d’intermédiaires de synthèse.

Pourtant cet inventaire beaucoup plus exhaustif, tenant compte du coût de la ressource, avait été réalisé par certains comme en atteste la très importante figure 3.

- Figure 2 : Ressources ultimes estimées (Source IEA. dans EIA Meeting “the world’s demand for liquid fuels” April 2009-Slide N° 11) Consulter la publication

.jpg)

Les divers rectangles de la figure 2 représentent, sur l’axe horizontal, les réserves ultimes estimées en milliards de barils en fonction les coûts de productions mini et maxi, en dollars 2008, sur l’axe vertical. Sont représentés respectivement de la gauche vers la droite du graphique :

- Jaune : les quantités de pétrole cumulées extraites et consommées au jour de la publication depuis le XIXème siècle, de l’ordre de 1100 milliards de barils, (sur la base de 75 millions de barils/jour la consommation annuelle de pétrole brut se situe autour des 27 milliards de barils par an). Il faudrait actualiser ces consommations cumulées autour des 1200 milliards de barils aujourd’hui.

- Rose : les réserves à bas coûts encore exploitables au Moyen-Orient et en Afrique du Nord (MENA)

- Rouge : les autres réserves exploitables de pétrole conventionnel dans le monde,

- Bleu pâle : les progrès d’extraction par injection de CO2 qui fluidifie le pétrole (EOR : « enhanced oil reserve »). Une des voies d’avenir, économiquement acceptable, du piégeage du gaz carbonique, rentabilisée par l’accroissement du taux d’extraction du pétrole.

- Bleu : les réserves en eaux profondes et ultra-profondes.

- Jaune : les EOR classiques, récupérables par injection d’eau.

- Rose : les réserves estimées de l’Arctique.

- Rouge Orangé : les huiles lourdes et sables bitumineux

- Orange : les huiles de schistes (shales) dont une part des condensats de gaz de schistes exploités aujourd’hui.

- Parme : la conversion d’une partie des réserves de gaz naturel en liquides par le procédé Fisher Tropsch (GTL) ou autre variante (MTG) par la voie méthanol.

- Marron bistre: la conversion d’une partie de charbon en liquides (CTL) soit par le procédé Fischer Tropsch dont le leader historique, depuis le milieu du XXéme siècle, est le sud-africain Sasol, soit par une variante, mise au point par Mobil, et qui utilise l’intermédiaire méthanol (MTG ou « methanol to gasoline).

Il manque dans ce superbe graphique des ressources ultimes la part des biocarburants classiques qui devraient majorer de quelques pourcents toutes les réserves en proportion des biocarburants ajoutés à l’essence et au gazole rapportées aux productions totales de produits pétroliers. A ce jour les 2,5 millions de barils de biocarburants utilisés annuellement représentent, en volumes, 2,5/91= 2,7% de l’ensemble des produits pétroliers consommés dans le monde.

Il manque aussi la conversion possible de la biomasse en liquides par procédé Fischer Tropsch (BTL) ou sa variante au méthanol qu’on peut imaginer couplée avec la conversion du charbon et qui majorerait de 5 à 10% le pavé CTL. Enfin l’auteur ne mentionne pas les hydrates de méthane dont certains essais d’exploitation sont actuellement en cours à l’Est du Japon dans la fosse de Nankai et aux Etats-Unis (dans le Golfe du Mexique et en Alaska. Les ressources d’hydrate de méthane sont estimées à ce jour aux environs de 1700 Tcf (48 000 milliards de m3).

Ce précieux graphique des ressources ultimes estimées en fonction des prix méritera d’être régulièrement actualisé et conduira probablement à des ressources ultimes accrues, ne serait-ce qu’en raison de l’accroissement général des prix de la ressource qui rend de nouveaux procédés rentables. Je pense, en particulier, au recyclage du CO2 mélangé au méthane qui sera abordé plus loin.

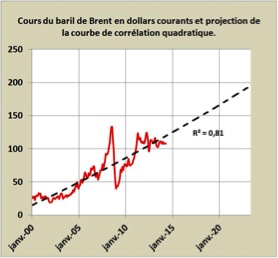

Ces réserves ultimes dépendent des prix du baril qui déterminent la rentabilité des opérations et donc leur mise effective en exploitation de tel ou tel procédé. Aujourd’hui, par exemple, la disponibilité de larges ressources de gaz (du North Field au Qatar ou extraites des schistes aux USA) ainsi que les prix des produits pétroliers comme le gazole rendent la conversion des gaz en liquides (GTL) rentable et donc industriellement exploitable.

Pour mémoire les cours du gazole (« diesel ») pilotés par les consommations européennes sont internationaux et se négocient autour des 3 dollars le gallon ou 3×42=126 dollars le baril.

Ces réserves ultimes furent annoncées par certains, pour le seul pétrole conventionnel, autour des 2000 milliards de barils qui représentaient le double des extractions passées qui ont franchi les 1000 milliards de barils (Fig.2, petit rectangle jaune à l’extrême gauche du graphique).

Cette valeur de 2000 milliards, à l’exclusion volontaire et politique de toute autre ressource, était parfaite pour expliquer que les extractions cumulées arrivaient au point d’inflexion de la sigmoïde qui les représente en fonction du temps, point d’inflexion où la vitesse d’extraction de la ressource, dérivée de la courbe, passe par un maximum : le peak-oil. Mais voila, aujourd’hui les géologues les plus avertis estiment ces ressources ultimes, hors divers procédés de synthèse mais en incluant les condensats de gaz, autour des 4000 à 6000 milliards de barils.

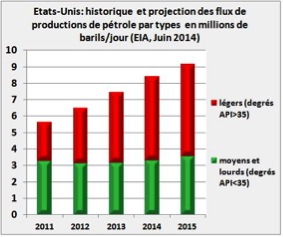

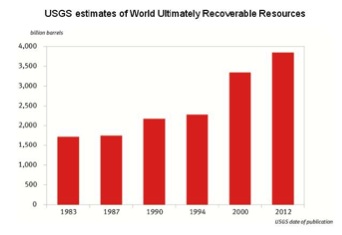

Les ressources pétrolières mondiales sont régulièrement estimées par l’USGS américaine. Constituées des ressources des champs en exploitation, d’une estimation de croissance de ces réserves récupérables et d’une estimation statistique, bassin par bassin, des ressources restant encore à découvrir, elles demandent à être pondérées en fonction de la probabilité de réalisation de ces estimations. L’USGS publie des valeurs estimées proches d’une probabilité de 50% d’occurrence. Ces réserves, malgré les productions, croissent au cours du temps en raison des progrès techniques constants dans l’exploration et la production. (Figure 3) du pétrole et du gaz naturel.

- Figure 3 : Résumé des ressources ultimes de produits pétroliers estimées (hors procédés de synthèse) par l’USGS au cours des trente dernières années (publication OPEP). La progression des quantités estimées traduit l’approfondissement des connaissances géologiques et les progrès technologiques d’exploration et de production dans un cadre d’accroissement continu des prix du baril.

A l’échelle des temps géologiques cette différence entre 2000 milliards et 4000 ou 5000 milliards de barils est bien sûr négligeable. Mais cela repoussera le plateau de production inexorable de quelques décennies (2000 milliards de barils de plus mobilisables au rythme actuel des extractions de 100 milliards de barils tous les quatre ans représentent dans les 40 ans de répit supplémentaire avant de voir les extractions cumulées atteindre la moitié des réserves ultimes estimées), ce qui donnera le temps nécessaire à l’économie mondiale pour s’adapter sérieusement aux nouvelles contraintes énergétiques qui seront essentiellement financières, en permettant de mettre en place progressivement et à grande échelle la production de biocarburants à partir de biomasse et la synthèse de produits raffinés à partir de gaz naturel, de charbon enrichi de biomasse et autres lignites ou de CO2.

Les productions d’hydrocarbures deviennent de plus en plus complexes. Outre les champs de pétrole traditionnels dont l’Arabie Saoudite, leader de l’OPEP, est la porte parole mondialement reconnue, de nombreuses autres ressources accompagnées par des progrès techniques déterminants sont apparues ou sont devenues exploitables durant ces dernières décennies. Citons pour mémoire les ressources offshores ultra-profondes de l’Ouest de l’Afrique, du Golfe du Mexique ou au large du Brésil. Citons les huiles lourdes de l’Orénoque et les sables bitumineux canadiens.

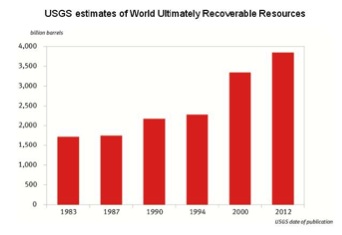

Sans oublier l’Est de l’Afrique nouvelle région de l’exploitation pétrolière. De même l’exploitation des gaz de schistes américains illustre qu’après quelques décennies de prospection systématique et de compréhension structurelle fine du sous-sol les mêmes types de ressources pourront être exploités en Amérique du Sud, en Chine, en Russie ou en Afrique. Certains de ces gaz sont peu chargés en hydrocarbures liquides (gaz secs) ; c’est le cas par exemple des gisements d’Haynesville au Texas et en Louisiane, d’autres champs produisent de larges quantités de condensats comme le gisement de Bakken dans le Nord-Dakota ou plus récemment celui d’Eagle Ford dans le Texas.

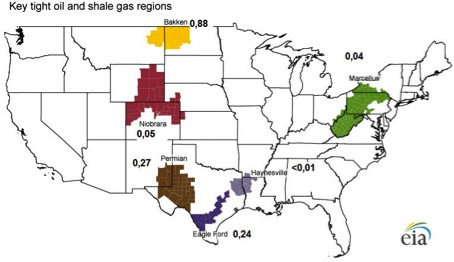

Il est possible de quantifier cette propriété de produire des condensats par le rapport entre les productions de pétrole exprimées en barils par jour et celles de gaz exprimées en milliers de pied-cube. Ce rapport, aux Etats-Unis varie de quasiment zéro pour Haynesville à 0,88 baril par millier de pied-cube pour Bakken (Fig 4) ce qui représente dans les 4 litres de condensats par mètre cube de gaz extrait. Cette caractéristique peut expliquer, pour des raisons économiques évidentes, la décroissance observée des productions de Haynesville et la croissance de celles de Bakken dont une partie des gaz est brûlée par torchage (« flaring »).

- Figure 4 : Principaux gisements de gaz de schistes aux Etats-Unis et leurs ratios (2013) d’extractions de condensats par rapports à celles de gaz en baril par millier de pied-cube

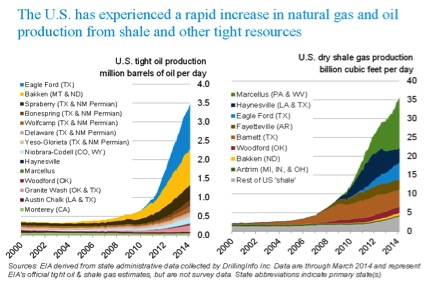

Les croissances américaines des productions de gaz naturel et de condensats dont une part est assimilable au pétrole étaient imprévisibles quelques années auparavant (Figure 5).

- Figure 5 : Etats-Unis, productions de gaz et de pétrole à partir de divers gisements non conventionnels (EIA, MARS 2014)

Quand à La France précautionneuse et incompétente, elle s’est fixée, de par la loi, une interdiction, de fait, de prospecter ces ressources. Et pourtant, ses importations nettes de gaz naturel représentaient, d’après les Douanes Françaises, sur 12 mois à fin Avril 2014, la rondelette somme de 14 milliards d’euros. L’intégration de cette dépense extérieure au sein de l’économie de notre pays en accroitrait à coup sûr la richesse, même si des précautions de Sioux et certaines restrictions locales devraient impérativement être mises en œuvre pour protéger notre environnement.

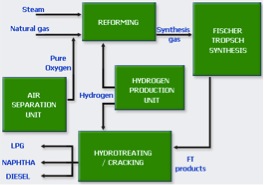

- Une voie d’avenir : les procédés GTL

Dans le champ de la synthèse des produits pétroliers liquides, il est indispensable de noter l’importance de la conversion des ressources de gaz en gazole et autres dérivés du pétrole. La formidable avancée du Qatar dans la synthèse de produits raffinés à partir de ses énormes réserves de gaz dans sa nouvelle unité d’Oryx développée avec Shell et Sasol qui apporte sa technologie et ses catalyseurs à base de Cobalt est exemplaire. Cette réalisation qui produit plus de 32000 barils par jour de produits pétroliers conduit à assimiler une partie des réserves de gaz dans le monde à de futures ressources pétrolières.

Outre la présence de Sasol en Louisiane, dans la région du Lac Charles, avec de vastes projets de conversion de gaz en liquides qui pourraient atteindre les 96 000 barils/jour en deux tranches d’investissements, doivent être notés divers projets aux USA (exemple de Pinto Energy dans l’Ohio) ou en Afrique (projet Escravos au Nigeria future copie de l’unité Oryx au Qatar).

De quoi chambouler le bilan des ressources ultimes de pétrole (Figure 1).

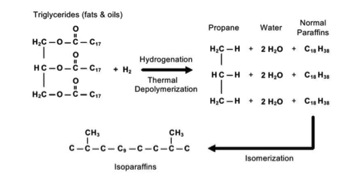

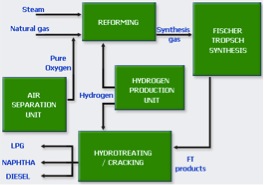

Le procédé GTL (Figure 3) repose sur la production par reforming du gaz et production d’hydrogène d’un mélange CO et H2 ad hoc. Ce mélange est transformé par le procédé Fischer Tropsch en paraffines qui sont ensuite isomérisées par hydrocracking pour produire en final du gazole, du naphta et divers gaz comprimés liquides.

- Figure 6 : GTL-Procédé ORYX au Qatar

D’après Sasol 10 mille pied-cube de gaz conduisent par le procédé GTL à un baril de produits raffinés comprenant 75% de gazole, 20% de naphta et 5% de gaz comprimés liquides. En d’autres termes il faut autour des 280 m3 de gaz naturel pour obtenir un baril de produits finis par un procédé GTL (283 m3 par calcul).

Ces quelques exemples montrent que l’exploitation des ressources pétrolières de demain traitera une multiplicité de matières premières (pétroles traditionnels, sables bitumineux, huiles lourdes, gaz humides ou secs) selon divers procédés allant du raffinage traditionnel aux procédés Fischer Tropsch de synthèse de paraffines à partir de mélanges CO et H2 d’origines diverses (gaz, charbon, biomasse, résidus divers).

Ces procédés seront également de nature à valoriser des gisements de gaz naturel riches en CO2 comme le montrent des essais sur équipements pilotes au Japon. Le CO2 combiné au méthane, pourra devenir un part des ressources de procédés Fischer-Tropsch évolués selon le schéma :

.jpg)

Il y a là, de toute évidence, une nouvelle voie pour valoriser les ressources de gaz naturel riches en CO2 ou pour recycler le CO2 lui même.

Les biocarburants en parallèle, sous l’effet des prix des produits pétroliers, verront leur pertinence économique s’accroitre et leurs volumes de production progresser avec la biosynthèse d’isobutanol, moins polaire que l’éthanol, plus soluble dans l’essence et source d’isobutylène puis de plastiques « bio », en lieu et place d’éthanol. L’américain GEVO est une des industries pionnières dans ce domaine.

.jpg)

La teneur en butanol pourra atteindre 16% en volume dans l’essence.

Une telle teneur en alcool remplacera en énergie 13,6% d’essence, alors qu’aujourd’hui les 10% d’éthanol mélangés à l’essence ne remplacent énergétiquement que 6,8% d’essence. La composante énergétique du biocarburant dans le mélange carburant pourrait donc doubler en passant du mélange à l’éthanol E10 à celui au butanol B16.

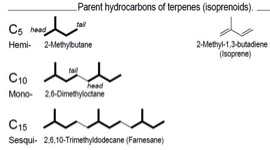

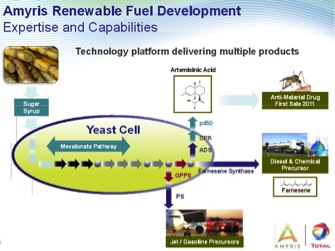

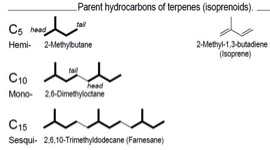

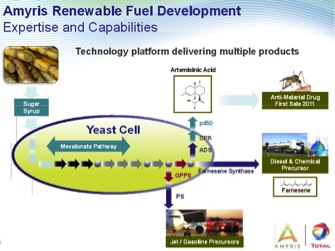

Il faut également citer la remarquable biosynthèse de terpènes (tel que le farnésène, terpène insaturé en C15) et, après hydrogénation, de kérosène ou de gazole à partir de sucres par le procédé Amyris conduisant à des produits de fortes valeurs ajoutées. Dans son usine Brésilienne, John Melo dirigeant d’Amyris revendiquait en Octobre 2013 avoir su produire un million de litres de farnésène en 45 jours, preuve récente de la maîtrise industrielle du procédé.

Un des objectifs d’Amyris, avec la collaboration du pétrolier Total, est de savoir par la voie directe « sugar to hydrocarbon » (DSHC) produire un kérosène bio, satisfaisant les normes ASTM, et qui devrait alimenter en carburant dès 2014, les vols d’une compagnie d’Amérique Latine.

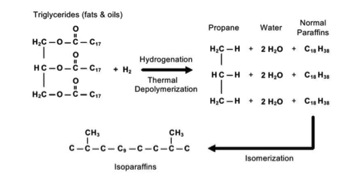

Parmi les grands acteurs de la valorisation des biocarburants il est indispensable de citer également le pétrolier finlandais Neste Oil qui a commercialisé 411 mille tonnes de biodiesel durant le deuxième trimestre 2013. Ce pétrolier estime une demande mondiale autour des 21 millions de tonnes en 2012 et projette cette demande à 35 millions de tonnes de biodiesel en 2020. Son procédé repose sur l’hydrogénation catalytique de graisses animales ou d’huiles végétales diverses (palme, soja, colza, maïs, etc.) et de résidus oléagineux de production de ces huiles. Ce procédé conduit à du propane et des chaînes aliphatiques par la suite isomérisées par hydrocracking pour produire des mélanges carburants tels que du gazole (figure 7).

- Figure 7 : Schéma du procédé Neste Oil d’hydrogénation catalytique des corps gras (huiles et graisses) en propane et paraffines

Neste oil s’est associé à Dong Energy pour essayer de diversifier ses ressources de matières premières par une intégration dans les voies de biologie synthétique conduisant des sucres cellulosiques à des huiles.

Par Raymond Bonnaterre

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)