Si le Mondial de l’Auto – pardon, le Mondial Paris Motor Show – se déroule toujours jusqu’au 14 octobre, le Mondial.Tech s’est quant à lui achevé samedi dernier. C’était une première : un salon dans le salon, occupant l’étage d’un hall de la Porte de Versailles à lui tout seul, concentré sur l’innovation technologique, les start-ups et les thématiques les plus en vue dans l’automobile de demain : mobilité, bien-être et confort, électrification, connectivité, cybersécurité, etc. Si l’organisation de l’espace était parfois curieuse – qui a compris le sens caché du labyrinthe planté en plein milieu ? – l’évènement donnait à voir plusieurs inventions, prochainement susceptibles de bonifier l’expérience du conducteur ou de valoriser la filière industrielle. En voici un aperçu.

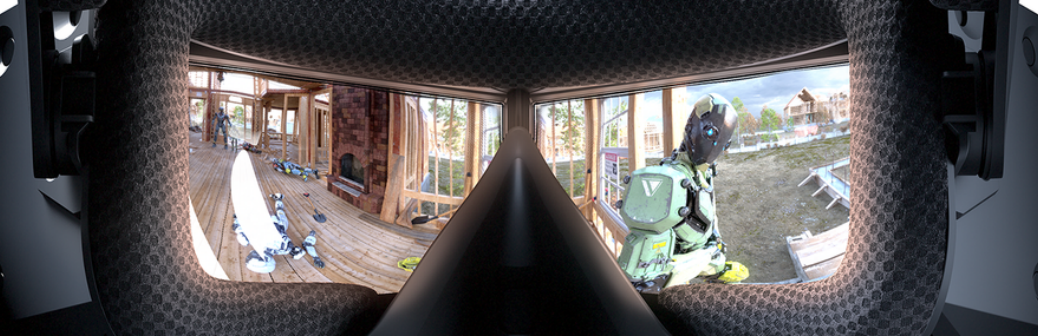

Ce simulateur analyse le stress du conducteur

Les simulateurs de conduite automobile impliquant la réalité virtuelle ne sont pas rares sur un salon comme le Mondial de l’Auto. Celui-ci ne vise pas à divertir toutefois, mais à mesurer le stress du conducteur et son état cognitif. C’est le fruit d’un partenariat entre l’Institut de recherche technologique b<>com et Human Design Group, dont l’expertise se focalise sur l’ergonomie et les interfaces homme-machine. Volant, siège, pédales d’accélération et de freinage : le poste de conduite est comparable à celui du cockpit d’une voiture. Mais dans le cas présent, le conducteur-cobaye s’équipe d’un casque RV et de capteurs mesurant son rythme cardiaque, sa transpiration (par réponse galvanique de la peau) et les mouvements de tête. Evoluant sur une artère urbaine en 3D, il est soumis à divers incidents – GPS qui perd la boule, insecte perturbateur, impact sur le pare-brise -et réagit en conséquence. Ses signaux biométriques et ses actions peuvent être corrélées puis analysées, afin de mettre en lumière des subtilités que les méthodes traditionnelles occultent. Ce projet, au stade de preuve de concept, se destine aux constructeurs automobiles et aux fournisseurs de technologie.

L’éthylomètre Ocigo combine fiabilité et connectivité

Réalisation de la société Olythe, née en 2013, Ocigo est un éthylomètre connecté qui sera commercialisé début 2019, au prix de 250 €. Il n’a rien d’un gadget. «Sa technologie est identique à celle des éthylomètres officiels employés par les forces de l’ordre, explique Guillaume Nesa, PDG et cofondateur d’Olythe. C’est de la spectrométrie infrarouge, aussi fiable qu’une prise de sang pour mesurer le taux d’alcoolémie.» Mais il a fallu relever plusieurs défis pour qu’Ocigo soit à la fois compact et abordable. «D’ordinaire, la miniaturisation et la précision de la mesure spectrométrique sont deux notions contradictoires, explique Guillaume Nesa. A l’aide de simulations numériques, nous avons rusé en mettant au point un système multi-réflectif, qui remplace le système rectiligne habituel des spectromètres. L’autonomie est un autre enjeu, car le préchauffage, nécessaire pour dépasser la température du point de rosée, est énergivore. Ocigo, prêt en 30 secondes, ne consomme que 300 mW durant cette phase.» Enfin, et même s’il fonctionne de manière indépendante, Ocigo communique via Bluetooth : l’application mobile avise du taux d’alcoolémie et de la courbe d’absorption, indiquant le délai au bout duquel la conduite est autorisée. «Ces données peuvent être transmises à un serveur, si le client en exprime la demande» poursuit Guillaume Nesa. Car Ocigo intéresse aussi les entreprises qui gèrent des flottes de véhicules.

Selfplug se charge de la recharge de la voiture électrique

Et si la recharge du véhicule électrique s’effectuait automatiquement ? C’est le principe du Selfplug, une réalisation de la start-up grenobloise Gulplug, née en 2014 au sein de Schneider Electric. Le geste qui consiste à brancher à chaque fois la prise électrique du véhicule peut en effet être vécu comme une corvée. «40 % des personnes qui possèdent une voiture hybride finissent par ne plus le brancher» constate Benoît Thevenot, ingénieur chez Gulplug. Si cette jeune pousse va au bout de son projet, elles n’auront peut-être plus à s’en soucier. Selfplug est formé de deux parties : d’un côté, un disque de 50 centimètres, posé sur le sol et branché sur le secteur, de l’autre un câble et son embout magnétique attachés sous le véhicule. Quand le véhicule est garé et que les deux parties sont suffisamment proches (une communication Bluetooth signale cette proximité), le câble se déroule et rejoint le centre du disque, où le contact électrique s’établit. «C’est comme un électro-aimant, détaille Benoît Thevenot. On active des bobines successivement pour guider l’embout jusqu’au centre de l’accessoire, puis le contact final est assuré par un aimant.» Quand le véhicule redémarre, le câble s’enroule aussi de lui-même. Selfplug prendra en charge des puissances de 3 W et de 22 kW en triphasé. En phase d’optimisation, il devrait être commercialisé en 2020.

Boarding Light remédie au mal des transports

Créée en 2015, la société Boarding Ring s’est donnée pour mission de lutter contre le mal des transports, «qui a affecté au moins une fois 40% des personnes ayant pris place dans une voiture», indique Antoine Jeannin, le PDG. Leur première réalisation est une étrange paire de lunettes comportant un liquide coloré, déjà disponible auprès des pharmaciens notamment. «Le mal des transports résulte d’un conflit sensoriel entre l’oreille interne et la vue, le cerveau ne parvenant pas à traiter deux informations contradictoires, explique Antoine Jeannin. Notre paire de lunettes resynchronise la vue avec le sens de l’équilibre. Il suffit de les porter 10 minutes à l’apparition des symptômes, puis on est tranquille.» Le deuxième produit en préparation, Boarding Light, reprend le même principe mais le modernise : ce sont des barrettes LED qui, placées dans le champ de vision des passagers, créent un plan d’horizon artificiel. Elles pourraient être incorporées dans les montants. «Nous travaillons avec l’équipementier automobile Novares, poursuit Antoine Jeannin, et devrions présenter le projet aux clients courant 2019.»

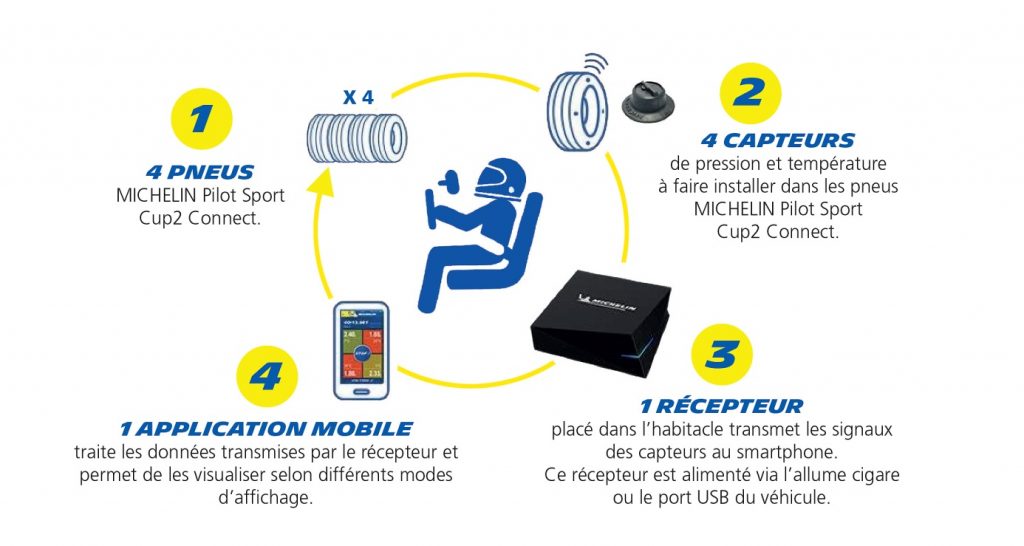

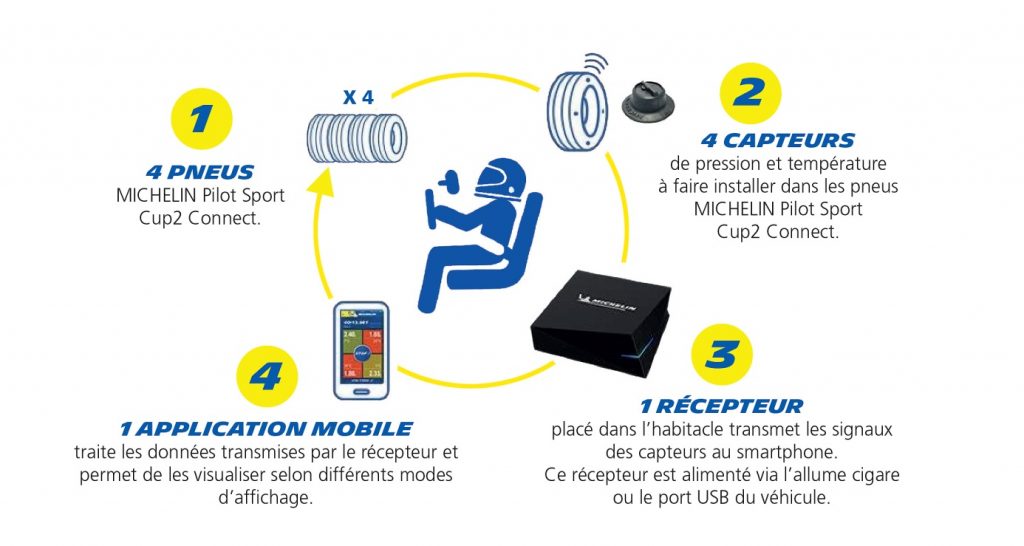

Les pilotes remettent la gomme avec Track Connect

Un pneu connecté ? C’est plutôt gonflé, et c’est de la part de Michelin. Le spécialiste du pneumatique avait présenté cette innovation au printemps dernier et a récidivé au Mondial de l’Auto. Track Connect n’est pas fait pour tout le monde : il s’adresse aux pilotes amateurs qui cherchent à grignoter la moindre seconde au terme de leurs passages sur circuit. Concrètement, il s’agit de quatre capteurs fixés à l’intérieur de chaque pneumatique. Les données de température et de pression sont transmises à un relais radio qui les communique ensuite au smartphone du pilote. L’application mobile recommande d’abord les pressions adaptées au véhicule et aux conditions de roulage (circuit sec, humide ou mouillé), puis enregistre les informations pendant la conduite. Un moyen pour le pilote d’analyser l’évolution de ces paramètres et d’optimiser le gonflage, en vue d’obtenir de meilleures performances. Ce système pourrait s’inviter à des compétitions de rallye l’an prochain.

Les capteurs de Nanomade enrichissent l’interactivité et l’analytique

Existant depuis 2009, Nanomade conçoit des capteurs souples, brevetés, qui rendent sensibles au toucher et à la pression des matières telles que le plastique ou le cuir. L’entreprise investit depuis deux ans le secteur automobile pour mettre «l’interactivité à portée de main», confie Faouzy Soilihi, le PDG. Mais ces capteurs peuvent aussi être placés sous la surface du siège : un prototype avait été présenté avec l’équipementier Valeo au salon CES 2018 à Las Vegas. «On peut alors mesurer de manière non intrusive les micro-mouvements du corps et en extraire, à l’aide d’algorithmes, des informations telles que les rythmes cardiaques et respiratoires» explique-t-il. L’amélioration du confort (analyse de la posture, etc) et de la sécurité sont des applications possibles.

Carfit Puls surveille l’état de santé de la voiture

Conçu par l’entreprise californienne Carfit, ce mini-capteur Bluetooth se colle au-dessus du volant et détecte les vibrations du véhicule, provenant de la direction, des amortisseurs, des freins, des pneus… Tout écart par rapport à la signature vibratoire initiale traduit une usure ou une anomalie, dont le conducteur prend connaissance en utilisant l’application mobile développée par Carfit. Cette analyse comparative, réalisée dans le cloud, s’appuie sur du traitement de signal, une base de données construite à partir de voitures neuves et un moteur d’intelligence artificielle dont les algorithmes s’affinent progressivement. Ces informations intéressent aussi les concessionnaires et les réparateurs, dans un objectif de maintenance prédictive, ou encore les assurances.

Par Frédéric Monflier