«L’État crée les conditions pour que la part de l’énergie produite à partir de sources renouvelables utilisée dans tous les modes de transport en 2020 soit égale à 10 % au moins de la consommation finale d’énergie dans le secteur des transports et à au moins 15 % en 2030 », fixe le texte de loi.

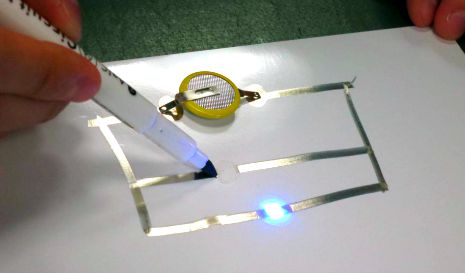

D’ici 2030, au moins 7 millions de bornes seront installées sur le territoire pour recharger les véhicules électriques et les hybrides rechargeables. Un crédit d’import « transition énergétique » de 30 % s’appliquera pour l’acquisition d’un système de recharge pour les véhicules électriques à domicile.

Des transports publics qui passent au vert

La loi prévoit d’imposer, d’ici 2025, pour les parcs de véhicules de moins de 3,5 tonnes gérés par l’Etat et ses établissements publics, 50 % de « véhicules à faibles émissions » dans leurs renouvellements, dès lors que le parc excède 20 véhicules. Ces véhicules seront électriques ou « de toutes motorisations et de toutes sources d’énergie produisant de faibles niveaux d’émissions de gaz à effet de serre et de polluants atmosphériques », précise le texte de loi. Un décret fixera ces références. La proportion est portée à 20 % du renouvellement pour les collectivités territoriales. Pour les véhicules de plus de 3,5 tonnes, la proportion dans le renouvellement est fixée à 50%.

A partir de 2020, les transporteurs publics exploitant plus de 20 autobus et autocars, devront acquérir 50 % de « véhicules à faibles émissions définis en référence à des critères fixés par décret » dans leurs renouvellements. La totalité du renouvellement devra se faire avec ces véhicules à partir de 2025. Pour la RATP, la proportion minimale de 50 % s’applique dès 2018.

Avant 2020, pour les loueurs de voitures, les taxis et les exploitants de voitures de transport avec chauffeur, chaque renouvellement doit contenir au moins 10 % de véhicules à faibles émissions (lorsque le parc dépasse 10 véhicules).

Le covoiturage et l’autopartage favorisés

La loi définit le covoiturage comme « l’utilisation en commun d’un véhicule terrestre à moteur par un conducteur et un ou plusieurs passagers, effectuée à titre non onéreux, excepté le partage des frais, dans le cadre d’un déplacement que le conducteur effectue pour son propre compte ».

Les véhicules autorisés en covoiturage pourront bénéficier de conditions de circulation privilégiées et de prix privilégiés sur autoroute. Notamment, les sociétés concessionnaires d’autoroutes devront créer ou développer des places de covoiturage. D’ici un an, le Gouvernement remettra au Parlement un rapport évaluant l’opportunité de réserver, sur les autoroutes et les routes nationales, une voie aux transports en commun, aux taxis, à l’auto-partage, aux véhicules à très faibles émissions et au covoiturage.

A partir de 2018, toute entreprise d’au moins 100 travailleurs située dans un territoire couvert par un plan de déplacements urbains devra établir « un plan de mobilité pour améliorer la mobilité de son personnel et encourager l’utilisation des transports en commun et le recours au covoiturage ». Les entreprises de plus de 250 salariés doivent quant à elles faciliter le covoiturage pour les déplacements entre le domicile et le travail.

Le Syndicat des transports d’Ile-de-France pourra délivrer un label « auto-partage », organiser des services publics de transport de marchandises et de logistique urbaine, d’auto-partage et location de bicyclettes dans les communnes qui n’en présentent pas. Il pourra aussi développer des plateformes de covoiturage et créer un « signe distinctif » des véhicules utilisés dans le cadre d’un covoiturage.

Des places et conditions de circulation privilégiées

Le code la route est modifié : «les véhicules à très faibles émissions, en référence à des critères déterminés par décret, peuvent notamment bénéficier de conditions de circulation et de stationnement privilégiées ».

Des zones de circulation restreintes autorisées aux seuls véhicules les moins polluants, pourront également être créées dans les villes et les zones couvertes par un plan de protection de l’atmosphère. De même, entre juillet 2015 et jusqu’au 1er janvier 2017, une commune couverte par un plan de protection de l’atmosphère peut interdire à certaines heures l’accès aux véhicules les plus polluants.

Le vélo fortement favorisé

Le vélo fait son entrée dans la transition. Soit par la mise à disposition gratuite de flottes de vélos pour les salariés pour les trajets domicile-travail, disposition qui offre droit à l’entreprise à une réduction d’impôt égale à 25 % du prix d’achat de ladite flotte. Soit par la mise en place d’une « indemnité kilométrique vélo » pour les salariés pour ces mêmes trajets. Le montant de l’indemnité sera fixé par décret et exonéré de cotisations sociales, dans la limite d’un montant défini par décret.

La France pévoit également un « déploiement massif, avant 2030, de voies de circulation et de places de stationnement réservées aux mobilités non motorisées, en particulier de stationnement sécurisés pour les vélos ». Ainsi, toute nouvelle construction comprenant un parking devra inclure des places de stationnement sécurisé pour vélos et de prises de recharge pour véhicule électrique ou hybride rechargeable. Cette obligation s’imposera aussi lors de travaux sur des parking à proximité d’habitations, bâtiment tertiaire ou industriel, etc. Un décret précisera les modalités en fonction de la taille et la catégorie des bâtiments concernés.

La grande distribution et les aérodromes mettent la main à la patte

D’ici le 31 décembre 2016, la grande distribution va devoir établir un programme d’actions pour réduire les émissions de gaz à effet de serre et de polluants atmosphériques dues au transport de ses marchandises. L’objectif est de réduire l’intensité de ces polluants – le rapport entre volume des émissions de polluants et les quantités de marchadises commercialisées – de 10 % en 2020 et de 20 % en 2025, par rapport à 2010.

Les aérodromes devront également prévoir un plan d’action similaire, répondant aux mêmes objectifs pour 2020 et 2025, pour réduire la pollution des activités directes et au sol. Ces plans d’actions seront évalués par l’ADEME qui en dressera un bilan national pour le 31 décembre 2017.

Deux dispositions insolites

Les amateurs de « tuning » vont déchanter. « Est puni d’une amende de 7 500 € le fait de réaliser sur un véhicule des transformations ayant pour effet de supprimer un dispositif de maîtrise de la pollution, d’en dégrader la performance ou de masquer son éventuel dysfonctionnement, ou de se livrer à la propagande ou à la publicité, quel qu’en soit le mode, en faveur de ces transformations », prévoit le texte. De plus, le contrôle des émissions de polluants atmosphériques et de particules fines sera renforcé lors du contrôle technique, par décret avant 2017.

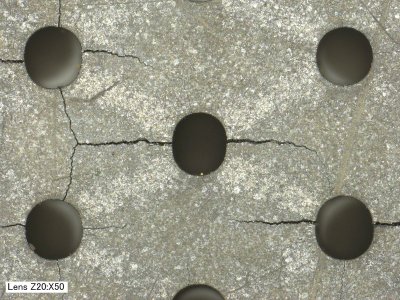

La loi prévoit de réduire l’exposition des populations aux pollutions atmosphériques. Des objectifs nationaux de réduction des émissions de polluants atmosphériques seront définis par décret pour 2020, 2025 et 2030. Un plan national de réduction de ces émissions devra être arrêté au plus tard le 30 juin 2016. Mais ce plan exclut les « émissions de méthane entérique naturellement produites par l’élevage de ruminants». Les éleveurs seront certainement satisfaits, pour une fois.

Par Matthieu Combe, journaliste scientifique

Et aussi dans les

ressources documentaires :

.jpg)