Selon PlasticsEurope, le représentant des producteurs européens de matières plastiques, près de 299 millions de tonnes de plastique ont été produites dans le monde et 57 millions en Europe en 2013. En 2012, l’Europe a généré 25,2 millions de tonnes de déchets plastiques, issues pour 40 % de produits à courte durée de vie (emballages) et pour 60 % de produits à longue durée de vie (automobile, construction et bâtiment, équipements électriques et électroniques, agriculture…). En France, 3,3 millions de tonnes de déchets plastique ont été collectées en 2012.

L’enfouissement des déchets de matières plastiques demeure l’option privilégiée dans la majorité des pays européens. En 2012, 38 % de ces déchets produits en Europe ont été enfouis, 36 % ont été incinérés et seulement 26 % ont été recyclés.

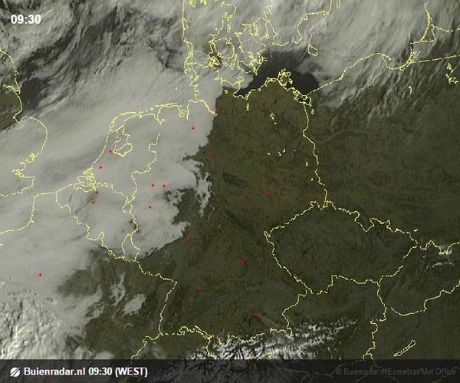

Douze pays européens enfouissent encore plus de 50 % de leurs déchets de matières plastiques. Mais 9 pays ont introduit des restrictions sévères à cette mise en décharge et ont développé conjointement le recyclage et la valorisation énergétique par incinération. Ces 9 pays parviennent ainsi à enfouir moins de 10 % de leurs déchets de matières plastiques. Il s’agit de la Suisse, l’Allemagne, l’Autriche, le Luxembourg, la Belgique, le Danemark, la Suède, les Pays-Bas et la Norvège. La Suisse est championne avec moins de 0,2 % de plastiquesenfouis. La France est dans une situation intermédiaire, avec encore 38 % d’enfouissement.

Diminuer la mise en décharge au profit de la valorisation et du recyclage

Entre 2005 et 2012, les volumes de déchets de matières plastiques mis en décharge en Europe ont largement diminué. De 13 millions de tonnes enfouies chaque année en 2005, ils sont passés à 9,6 millions de tonnes en 2012. Toutefois, la dynamique doit s’amplifier pour atteindre « zéro plastique » en décharge en 2025.

La directive européenne sur l’économie circulaire préparée par la DG Environnement visait à interdire la mise en décharge des plastiques d’ici 2025. Mais la commission a estimé qu’il n’était pas raisonnable d’imposer des objectifs que l’ensemble des États membres ne pourraient pas atteindre. La DG Environnement va travailler avec la DG Entreprise pour une directive industriellement et financièrement faisable. Elle devrait donc plutôt prévoir des objectifs de recyclage ambitieux. « Nous pensons que si l’Europe se donne pour objectif d’amener l’ensemble de ses membres au niveau de performance du plus vertueux d’entre eux, à savoir l’Allemagne (42 % de taux de recyclage), nous aurons beaucoup progressé», évalue Véronique Fraigneau, responsable de la communication de Plastics Europe. « Si seulement les 10 pays qui enfouissent le plus de déchets se dotent d’un objectif ambitieux de réduction de la mise en décharge des plastiques, alors cela sera gagné. On ne peut pas, par exemple, imposer à la Roumanie, les mêmes objectifs qu’au Royaume-Uni ou à la France qui enterrent encore beaucoup trop de plastique », précise Michel Loubry, directeur général de PlasticsEurope pour l’Europe de l’Ouest.

Pour parvenir à baisser la mise en décharge des plastiques en France, le projet de loi relatif à la transition énergétique en cours de discussions prévoit de « réduire de 30 % les quantités de déchets non dangereux non inertes admis en installation de stockage en 2020 par rapport à 2010, et de 50 % en 2025 ». « Les déchets plastiques font de fait partie des déchets qui devraient être parmi les premiers à être déviés de la décharge, puisque non dangereux pour leur très grande majorité et non inertes », relève Véronique Fraigneau.Cette disposition est notamment accompagnée de l’extension des consignes de tri à l’ensemble des plastiques d’ici 2022, mais aussi de la généralisation du tri à la source des déchets organiques pour tous les producteurs de déchets d’ici à 2025, afin de diminuer leur mise en décharge.

Incinérer ou recycler les plastiques ?

Si les plastiques ne sont plus mis en décharge, il faut soit les recycler, soit les incinérer. La France, avec un taux moyen de recyclage des plastiques de 20 % et de valorisation énergétique de 42 % recycle moins que la moyenne européenne. Lorsqu’on ne considère que les emballages en plastique, les taux de recyclage sont plus élevés et la moyenne européenne s’élève à 34,7 %. La France est, encore là, bien en dessous de ce résultat, avec un taux de recyclage de ces emballages de 23,9 %.

L’éco-organisme Eco-Emballages mène une expérimentation sur l’extension des consignes de tri auprès de 3,7 millions d’habitants depuis 2011. L’extension des consignes de tri à l’ensemble de la population se poursuivra de 2016 à 2022.

Les résultats des expérimentations menées sont encourageants. Ils laissent envisager un doublement du gisement potententiel d’emballages à recycler. Alors qu’à ce jour,pour les plastiques, seulement 40 % des emballages (bouteilles et flacons) font l’objet d’une consigne de tri, environ 40 % supplémentaires de films en polyéthylène et de pots et barquettes pourraient entrer dans les consignes de tri.

PlasticsEurope estime que l’extension des consignes de tri à l’ensemble des emballages en plastique permettra d’augmenter de façon indirecte l’ensemble des emballages triés par les ménages. Ainsi, Plastics Europe évalue que cette disposition permettra de recycler 5 kg supplémentaires d’emballages par habitant et par an : 2 à 3 kg/hab/an de pots, barquettes et films, 0,5 kg/hab/an de bouteilles et flacons (pour atteindre 4,5 kg/hab/an) et 1,5 kg/hab/an d’autres emballages (carton, briques alimentaires, acier, aluminium). Cela permettrait d’atteindre un taux de recyclage des emballages en plastique d’environ 40 %.

Pour les emballages en plastique restants (plastiques complexes, films trop petits…) dont le recyclage des résines n’est pas économiquement viable, et pour les emballages non recyclés, il faut développer la valorisation énergétique par incinération. Cela se fera dans des incinérateurs municipaux avec récupération d’énergie, ou sous forme de combustibles solides de récupération. « Les emballages qui ne pourront pas être recyclés devront tous être valorisés énergétiquement. Le zéro plastique en décharge passe par un pourcentage de recyclage, complété par un pourcentage de valorisation énergétique qui ramène le taux de mise en décharge à presque zéro », prévient Véronique Fraigneau. La réussite de cette extension passe par la nécessaire adaptation des centres de tri. Selon l’ADEME, l’investissement nécessaire s’élève entre 1,2 et 1,8 milliards d’euros.

Par Matthieu Combe, journaliste scientifique

Et aussi dans les

ressources documentaires :