Qui ne s’est jamais senti découragé et épuisé à la seule idée d’ouvrir sa boîte courriel ?

Qui n’a jamais été pris de court, dans l’impossibilité de réagir correctement face à un partenaire, un confrère, un concurrent, par absence d’une information critique ?

Qui – au contraire – ne s’est jamais perdu dans la quantité d’information, non triée, non vérifiée, à disposition dans son organisation ?

Voici quelques-unes des questions qui résument l’un des plus grands défis actuels pour les entreprises et leurs salariés. Dans un monde plus ouvert que jamais, où l’information circule instantanément et où il est vital de prendre en compte la globalité de son écosystème, nous sommes en fait trop facilement débordés.

Les conséquences sont faciles à identifier. D’après le « Fifth European Working Conditions Survey » de la Fondation Européenne de Dublin (Commission Européenne), la France est dans le top 3 des pays « stressés » de l’UE. Le gâchis que cela représente au quotidien est difficile à chiffrer, mais indéniable.

A l’heure où maîtriser, économiser même, les ressources, l’énergie… donnent lieu à des paroles et à des actes, qu’en est-il de la sauvegarde de l’énergie humaine ? Moins de fatigue, moins de stress, moins de tensions interpersonnelles, favorisent une meilleure productivité, une utilisation optimale de l’intelligence collective et une plus grande créativité. Un avantage majeur à la fois pour l’entreprise et le salarié.

Les recettes traditionnelles ne suffisent plus

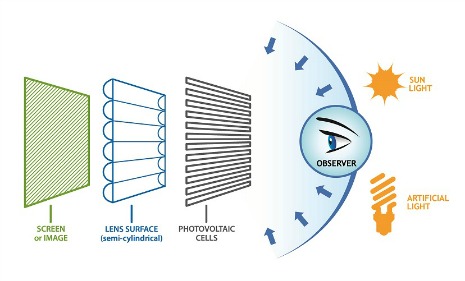

Il existe déjà des recettes concrètes pour permettre à l’entreprise d’économiser l’énergie de ses salariés, pour qu’ils conjuguent efficience et sérénité. Bien sûr, il y a l’environnement de travail (une bonne luminosité, de l’espace, un volume sonore confortable…) ou les services mis à disposition du personnel, en interne ou dans les environs immédiats, pour lui faciliter la vie.

Mais dans cet univers numérique, mobile et instantané dans lequel nous vivons, cela ne suffit plus. Ce qui aide le plus un collaborateur, lui permet de vraiment se concentrer sur l’essentiel, c’est l’accès immédiat à la « juste » information. C’est-à-dire celle dont il a besoin pour décider, pour agir, pour être devant ses concurrents ; celle qui enrichit les réflexions et élargit le périmètre de connaissance. Celle, enfin, qui facilite l’innovation, clé de voûte des entreprises qui se développent et se réinventent sans cesse. C’est une information précise, vérifiée, non redondante, accessible, en mode « zéro clic ».

Les technologies qui répondent à ces aspects existent déjà et ont toutes en commun le collaboratif et le social. Mieux : en plus de faciliter l’accès à l’information, elles sont également évolutives ; elles apprennent des choix et des préférences de l’individu, pour lui fournir une information filtrée, prête à consommer, sans qu’il ait chaque jour à expliciter de nouveaux ses besoins réels. Cette capacité d’évolution est centrale dans un contexte où une entreprise est tout sauf une structure figée. Elle évolue de jours en jours et les attentes de ses collaborateurs changent progressivement elles aussi. Les outils doivent donc en tenir compte.

Collaboratif et RSX pour mieux utiliser son énergie

Parmi ces derniers, les réseaux collaboratifs d’entreprises sont ceux qui offrent les plus grands bénéfices. Ils sont au cœur des enjeux business et de relations interpersonnelles. Leur objectif est en effet de faire naitre des synergies métier et d’augmenter la puissance des communautés professionnelles qui les utilisent.

En alliant ces réseaux avec un accès intuitif à l’information pertinente, les idées se partagent mieux, les capacités d’innovation et de découvertes stratégiques se multiplient car la justesse des informations, leur non-redondance sont vérifiées – sans perte de temps. Les salariés disposent ainsi d’un plus grand confort pour partager leurs réflexions et les enrichir avec ceux, parmi leurs pairs, qui seront les plus concernés et capables d’apporter de la valeur. De facto, l’énergie de ces collaborateurs est préservée, voire augmentée.

La bonne nouvelle, c’est que les entreprises prennent conscience des enjeux d’efficience, de développement, de climat social et d’innovation, que cet impératif de sauvegarde de l’énergie humaine recouvre. L’édition 2013 de l’Index International des valeurs, réalisé par l’agence Wellcom, souligne ainsi la très forte progression de la valeur « Innovation » dans les entreprises, pour se différencier de la concurrence et l’apparition, pour la première fois, de la valeur « Communauté » dans le classement. Cette dernière concerne d’ailleurs autant une dynamique interne (salariés) qu’externe (clients).

En effet, si les professionnels comprennent que l’optimisation de l’énergie humaine par une utilisation plus fine des outils collaboratifs est une force, l’idée qu’il s’agit également d’un atout à l’extérieur de l’entreprise fait son chemin. La stratégie de la pertinence et du « zéro clic », appliquée sur les réseaux sociaux externes (RSX)* offre une forte optimisation de leurs processus de vente : un utilisateur, client, revient sur une plateforme lorsqu’il sait que l’information qui lui est présentée est de qualité. Un des critères fondamentaux de cette qualité est la pertinence vis-à-vis de ses centres d’intérêt. Thématique par thématique, il est donc possible de capitaliser d’un point de vue business sur les mêmes approches qui ont rendu ses salariés plus efficients et zen dans son organisation. En approfondissant l’analyse, il apparait même que les clients deviennent sources d’innovation, facilitant l’adaptation permanente de l’entreprise.

À une époque où toute organisation cherche à rationaliser ses investissements, les dispositifs qui favorisent l’économie de l’énergie humaine sont plus qu’une ligne dans la politique RSE des entreprises ou qu’une simple opportunité commerciale. Veiller, agir pour maîtriser la dépense d’énergie humaine de son écosystème est une véritable nécessité. Agir pour favoriser le partage au sein de l’entreprise et avec ses clients est un formidable levier de synergie.

* Les RSX sont des réseaux sociaux sur-mesure, conçus par les entreprises pour fédérer une communauté autour de leur activité, sur une plateforme externe thématique qu’elles maitrisent et sur laquelle elles peuvent s’appuyer systématiquement pour se développer.