L’équipe de la route solaire française espère pouvoir atteindre un coût de 6 €/W (6,5 $/W) dans le futur, ce qui nécessitera une division d’environ un facteur 3 du coût actuel. Mais même un facteur 1,3, comme c’est le cas pour le prix de lancement du toit solaire de Tesla qui sort tout juste du laboratoire, n’a rien de négligeable et est problématique selon certains experts du solaire sensibles aux problématiques écologiques. Tesla a publié un billet de blog pour présenter son nouveau bébé.

« Et maintenant voici le test acide pour les toits solaires de Tesla. Jenny Chase est-elle impressionnée, bien qu’à contrecœur ? » a interrogé publiquement Michael Liebreich, fondateur de l’agence Bloomberg New Energy Finance. Jenny Chase, directrice des analyses solaires au sein de BNEF, a fait le calcul : « $42 par pied-carré correspondent à $452 par mètre-carré. Ou, avec une efficience de 18%, à $2,52 le Watt. Les systèmes résidentiels allemands sont aujourd’hui à un coût bien inférieur à $1,9 le Watt (1,7 €/W NDLR), frais d’installation compris. »

On objectera que le toit solaire de Tesla permet de faire des économies en tuiles et en ardoises mais pour Jenny Chase « le coût des bardeaux d’asphalte (très utilisés en Amérique du nord NDLR) est négligeable. Donc oui, construire le système photovoltaïque en même temps que le toit permet de réaliser des économies, mais on peut faire cela avec des modules solaires classiques aussi ».

En fait « si les toits solaires de Tesla semblent bon marché, c’est parce qu’aux USA le solaire classique est cher » comparativement à l’Allemagne a ajouté cette experte suisse.

Pour Joju Solar, l’un des leaders de l’installation de solaire en toiture au Royaume-Uni, de nombreuses tentatives d’installation de tuiles et ardoises solaires ont été effectuées dans le passé. Mais aucune n’a été concluante « à cause de coûts plus élevés et d’une efficience plus faible » expliquent ces spécialistes dans une note d’analyse. Les cellules solaires sont en effet sensibles à la température et les intégrer directement dans le toit limite la possibilité de ventilation.

« Quelque chose qui devient joli n’est pas un game-changer » tranche Jenny Chase, dans un tweet qu’elle a adressé à Elon Musk. « Des modules c-Si normaux permettent d’atteindre une meilleure NPV » a ajouté la scientifique. La valeur actuelle nette (Net Present Value, NPV) est une mesure de la rentabilité d’un investissement.

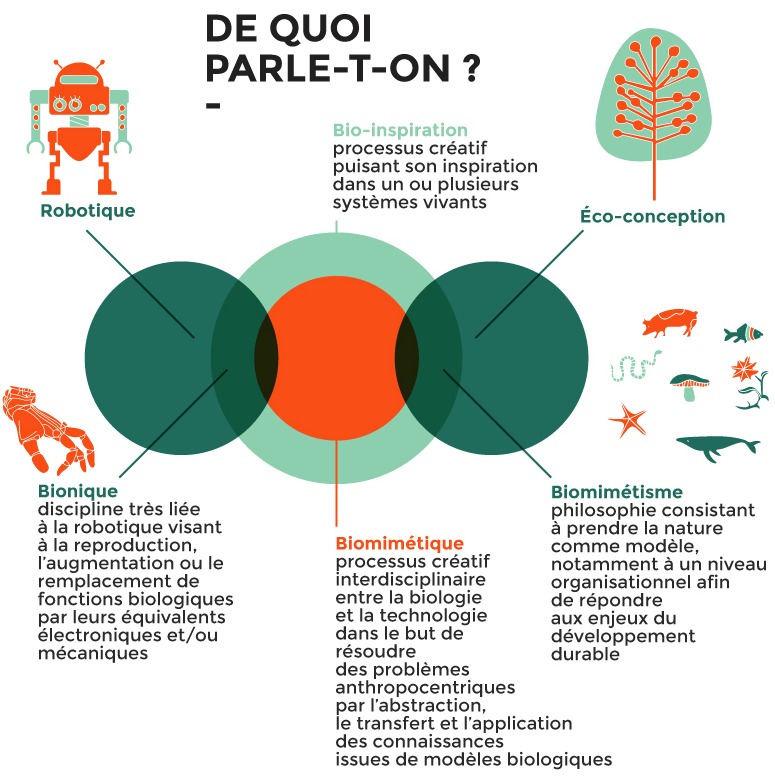

Cohérence éco-logique

« Quand le solaire devient sexy » titrait Techniques-ingénieur.fr le 21 novembre 2016 dans l’article le plus lu de l’histoire de ce média, toutes rubriques confondues. Mais l’approche esthétisante, parfois nuisible à la performance énergétique et économique et qui tel un miroir attire les alouettes, est-elle vraiment souhaitable ?

« Aucune grâce extérieure n’est complète si la beauté intérieure ne la vivifie » écrivait Victor Hugo. Dans un contexte de crise écologique planétaire (Eaux, sols, atmosphère, biodiversité) et d’urgence de sortir des combustibles fossiles, focaliser sur l’esthétique est-il vraiment prioritaire ? Et les panneaux classiques sont-ils vraiment laids ? Ce sont peut-être les paysages mentaux intérieurs qu’il conviendrait de changer.

Le toit solaire a été annoncé par Elon Musk dans un contexte où il tentait de sauver SolarCity en fusionnant cette entreprise avec Tesla. Ces toits permettent notamment d’alimenter les voitures électriques. Jouissant d’une aura quasi-divine, l’entrepreneur aux multi-succès est parvenu à ses fins. Mais cela ne signifie pas que tout ce que propose Elon Musk est forcément génial.

Creuser (et donc dépenser beaucoup d’énergie) des tunnels sous Los Angeles pour propulser à 200 km/h des voitures montées sur des wagons et traverser toute la ville en 5 minutes, est-ce s’inscrire dans une trajectoire de développement vraiment durable et donc d’efficience énergétique ? C’est le projet de The Boring Company, une nouvelle entreprise fondée par Elon Musk. Ivan Illich se retourne dans sa tombe.

Envoyer des touristes prendre des photos autour de la Lune grâce aux fusées de SpaceX, qui brûlent de grandes quantités d’hydrogène dont la production via l’énergie photovoltaïque et éolienne est très inefficiente, conduit à poser la même question. « Même si les ressources renouvelables sont gigantesques, les dépenses en matières premières nécessaires pour fabriquer tous les convertisseurs pourraient contribuer à accroître significativement les dégâts environnementaux associés » souligne Bernard Multon, Professeur à l’Ecole Normale Supérieure de Rennes. L’ingénieur centralien Philippe Bihouix, auteur du livre « L’âge des Low-Techs » (Edition Seuil, 2014) et spécialiste des métaux, n’a cessé d’alerter à ce sujet.

Pourquoi vouloir construire des villes sur Mars, ceci après y avoir lancé des bombes nucléaires dans l’espoir de faire fondre l’eau des calottes polaires de la planète rouge ? Au cas où la situation tournerait mal sur Terre a expliqué Elon Musk. Ne vaudrait-il pas mieux faire le pari que tout ira bien si chacun parvient à intégrer le minimum vital d’éco-conscience ? L’idéologie « no limit » peut conduire au pire. L’électricité solaire, si elle tombe entre de mauvaises mains, peut alimenter des chars ou des avions de guerre électriques.

« Dans l’axe est son moteur, il décolle. Son accélérateur le console » chantent dans « Il roule (Les fleurs du bal) » Alain Souchon et Laurent Voulzy. « Les guitares qui jouent fort dans son cockpit lui sont d’un réconfort Amniotique. Il roule, il roule comme les larmes qui coulent laissant là, dans la salle sur le sol éparpillées les fleurs du bal ».

Charles Baudelaire, à l’occasion de l’exposition universelle de 1855, s’interrogeait déjà : « Je laisse de côté la question de savoir si, délicatisant l’humanité en proportion des jouissances nouvelles qu’il lui apporte, le progrès indéfini ne serait pas sa plus ingénieuse et sa plus cruelle torture ; si, procédant par une opiniâtre négation de lui-même, il ne serait pas un mode de suicide incessamment renouvelé, et si, enfermé dans le cercle de feu de la logique divine, il ne ressemblerait pas au scorpion qui se perce lui-même avec sa terrible queue, cet éternel desideratum qui fait son éternel désespoir ? ». Quelle est l’origine de la boulimie technologique d’Elon Musk ?

Un débat organisé par Le Mouton Numérique aura lieu le 9 juin 2017 à Paris dans le cadre de « Futur en Seine » avec Sophie Lacour, Docteur en Sciences de l’Information & Communication spécialisée en prospective touristique et Eric Vidalenc, expert au sein de l’ADEME et prospectiviste du think-tank Futuribles.

Son thème : « La mobilité du futur doit-elle refléter nos désirs ? ».

Olivier Daniélo