Le socle de la transition énergétique allemande est basé sur la sortie totale du nucléaire d’ici 2022. La loi vise donc à faire de cette sortie un succès et définit la marche pour y parvenir. Elle prévoit notamment une baisse de la consommation électrique de 10 % en 2020 et 25 % d’ici 2050, par rapport à 2008 et une part d’énergies renouvelables de 80 % en 2050. La consommation électrique devra donc atteindre 556 térawattheures (TWh) en 2020. Elle est de 578,5 TWh fin 2014, soit une baisse déjà observée de 9,7 % depuis 2008.

Idée reçue n°1

- La sortie du nucléaire et le développement de l’énergie solaire en Allemagne entraînent une augmentation du recours au charbon

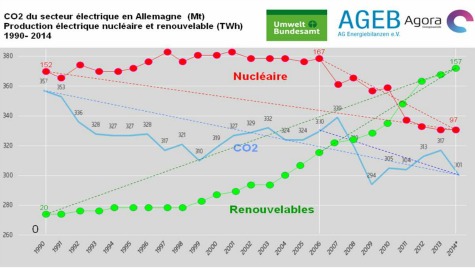

2008 marque le début des « années solaires » en Allemagne, avec un développement important des panneaux solaires. Entre 2008 et 2014, la production photovoltaïque est passée de 4,4 TWh à 34,9 TWh. Mais ce n’est pas tout. Dans ce même laps de temps, la production éolienne est passée de 40,6 TWh à 56 TWh et la production à base de biomasse de 23,1 TWh à 43 TWh. Entre 2008 et 2014, à eux seuls, l’éolien, le photovoltaïque et la biomasse ont donc permis de gagner 65,8 TWh.

La production nucléaire allemande baisse régulièrement depuis 2006. Le nucléaire produisait 148,8 TWh en 2008, 140,6 TWh en 2010, 108 TWh en 2011 et 97,1 TWh en 2014. Cette baisse est notamment marquée depuis 2011, avec la fermeture des 8 réacteurs les plus anciens. La fermeture des réacteurs et la baisse de la production nucléaire a entraîné un recul de production d’origine nucléaire de 51,7 TWh entre 2008 et 2014.

En parallèle, entre 2008 et 2014, la production à base de charbon a perdu 15,6 TWh, celle à base de gaz a perdu 30,8 TWh, celle à base de fioul a perdu 3,7 TWh, lorsque la production à base de lignite a augmenté de 5,2 TWh. A y regarder de plus près, la diminution de la production de gaz a réellement commencé en 2011. Depuis, le gaz recule d’environ 9 TWh par an. La lignite a connu un regain d’intérêt entre 2011 et 2013, mais sa part a recommencé à diminuer en 2014. Même constat du côté du charbon.

Examinons cela plus en détail. Entre 2011 et 2012, le gaz a baissé de 9,7 TWh au profit d’une augmentation de 10,7 TWh de lignite et de 4 TWh de charbon. Entre 2012 et 2013, bien que le gaz ait baissé de 9 TWh, le charbon n’a augmenté que de 5,3 TWh. En 2014, les trois sources de production ont baissé, alors que les énergies renouvelables continuaient leur développement. Dire que le recours au charbon augmente en Allemagne est donc faux. Dire que cette hausse est due aux énergies renouvelables l’est encore plus !

Ci-dessus : Evolution interannuelle de la production de charbon, de lignite et de gaz en Allemagne (en TWh) et bilan net (en TWh) de l’évolution de la production de ces 3 énergies fossiles

Bilan : entre 2008 et 2014, le nucléaire recule de 51,7 TWh, le charbon de 15,6 TWh, le gaz de 30,8 TWh, le fioul de 3,7 TWh, mais la lignite augmente de 5,2 TWh. Soit une diminution nette de production non renouvelable de 96,6 TWh. L’ensemble des énergies renouvelables ont permis de gagner 67,3 TWh et la baisse de production électrique nationale a été de 26,7 TWh. Le compte y est : la production à base d’énergie renouvelable et la hausse de l’efficacité énergétique (94 TWh) ont pleinement permis de contrebalancer la diminution de la production nucléaire et la baisse des énergies fossiles (93,6 TWh).

Entre 2008 et 2014, le solde d’exportation net est passé de 22,5 TWh à 35,5 TWh. Pour la première fois en 2014, la baisse de la consommation électrique en Allemagne s’est accompagnée d’une augmentation du PIB. L’Allemagne est donc parvenue, l’année dernière, à découpler croissance économique et consommation d’énergie. Cela reste néanmoins à confirmer.

Idée reçue n°2

- le recours au charbon pour gérer l’intermittence des ENR est inévitable

En 2014, le couple charbon-lignite a produit 43,1% de l’électricité allemande. Malgré le fort développement des énergies renouvelables, les émissions de CO2 du secteur de la production d’électricité en Allemagne ne sont passées que de 319 millions de tonnes équivalent CO2 (MtCO2) en 2008 à 301 MtCO2 en 2014 selon les statistiques officielles du Ministère fédéral de l’Environnement. Cette faible baisse en cache une autre. En 2009, les émissions du secteur représentaient 292 MtCO2, puis 305 MtCO2 en 2010 et 2011. Mais le recours accru au charbon, au détriment du gaz, les a fait rebondir à 317 MtCO2 en 2012 et 2013. Entre 2013 et 2014, la baisse de production de 28 TWh due aux énergies fossiles a entraîné une diminution des émissions de CO2 de 26 MtCO2. A l’avenir, ces émissions devraient continuer à baisser fortement grâce à la baisse de la production à base de charbon-lignite.

Le recours accru au charbon en Allemagne a été provisoire, dû à une conjoncture favorable au charbon, au détriment du gaz. Le Gouvernement prévoit un mix composé de 80% d’ENR et 20% de gaz en 2050. Il faudra donc réussir à « décharboner » la production électrique. Pour y parvenir, l’Allemagne planche avec la France sur une réforme du marché ETS. Le Ministère de l’économie et de l’énergie allemand étudie également actuellement un projet de loi visant à faire payer une taxe comprise entre 18 et 20 euros par tonne de CO2 aux centrales à charbon de plus de 20 ans, si elles émettent plus de 7 millions de tonnes de CO2 par gigawattheure. « Le marché est aujourd’hui en surcapacités, si bien qu’il est souhaitable qu’un certain nombre de capacités thermiques soient fermées », précise Dimitri Pescia, du think-thank Agora Energiewende. « Sauf qu’il faudrait que ce soit des capacités à charbon et non à gaz qui ferment, d’où d’ailleurs le projet récent du gouvernement de contraindre les producteurs à acheter davantage de certificats sur le marché, dans le cas où leurs centrales seraient particulièrement polluantes ».

Les objectifs allemands visent une réduction nationale des émissions de gaz à effet de serre de 40 % d’ici 2020 et de 80% à 95 % d’ici 2050, par rapport à 1990. En 2014, les émissions globales de CO2 du pays ont baissé de 27 % par rapport à 1990. Le secteur électrique demeurant le principal émetteur de gaz à effet de serre, la décharbonisation devient donc l’une des priorités du Gouvernement fédéral.

Idée reçue n°3

- la facture électrique des particuliers va continuer à exploser

La redevance due à la loi sur les énergies renouvelables, dite « EEG » (Erneuerbare Energien Gesetz) étant plafonnée pour les industries électro-intensives, une part importante de la taxe sur les énergies renouvelables est supportée par les ménages. Ainsi, le prix du kWh électrique est passé de 19,1 centime d’euros (ct€) en 2006 à 29,4 ct€ en 2013 pour les particuliers allemands. Depuis, le prix s’est stabilisé, à hauteur de 29,6 ct€ en 2014 et devrait se situer autour de 29,4 ct€ en 2015. Ce prix est deux fois plus élevé qu’en France (14,3 ct en base chez EDF). Malgré cela, la facture des ménages n’est que 30% supérieure grâce à une efficacité énergétique supérieure.

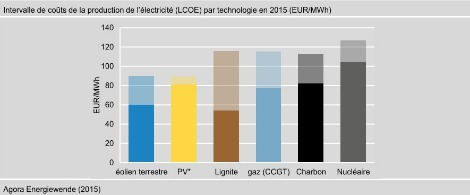

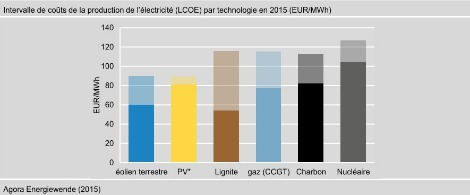

Le prix de l’électricité a fortement augmenté à cause du développement de l’énergie solaire entre 2008 et 2012, lorsque les tarifs d’achats étaient encore élevés. « Les consommateurs allemands ont contribué à accélérer la baisse des coûts du photovoltaïque », éclaire Dimitri Pescia. « Les consommateurs allemands paieront 180 milliards d’euros pour les capacités photovoltaïques installées entre 2000 et 2013. Aux tarifs d’achat d’aujourd’hui, ce montant se situerait seulement entre 60 et 80 milliards d’euros ». Car depuis 2006, les coûts du photovoltaïque ont baissé de 70%.

Les installations éoliennes sur terre et photovoltaïques sont désormais compétitives pour les nouveaux investissements. Les prix devraient donc se stabiliser à l’avenir.

Idée reçue n°4

- La perte historique des électriciens allemands montre l’échec de l’Energiewende

Il n’y a pas qu’Areva qui va mal. En mars 2015, l’énergéticien allemand EON a annoncé une perte de 3,16 milliards d’euros. Ses deux concurrents RWE et EnBW s’en tirent un peu mieux, mais leur avenir est également menacé. Le parc allemand étant en surcapacité et les énergies renouvelables bénéficiant d’une priorité d’injection sur le réseau, la rentabilité des centrales à charbon est mise à mal.

« La perte de CA d’EON ne menace pas en soi la transition énergétique, mais montre à quel point le business model traditionnel des énergéticiens est en pleine mutation », assure Dimitri Pescia. La perte de chiffre d’affaires d’EON est liée essentiellement à une dépression de certains de ces actifs en Allemagne et à l’étranger et à des pertes sur les volumes vendus d’électricité et de gaz. En cause : les prix très bas sur le marché de l’électricité. « Le groupe a tiré les conséquences de cette situation en annonçant une restructuration stratégique majeure, visant à se repositionner uniquement sur les activités liées à la transition énergétique : ENR, réseaux, commercialisation… », résume Dimitri Pescia. Les autres activités traditionnelles (gaz, charbon, nucléaire, négoce, exploration) seront cédées à une autre entité en 2016. Il s’agit là d’un revirement stratégique inévitable pour tout géant de l’énergie souhaitant continuer à vivre.

Par Matthieu Combe

Et aussi dans les

ressources documentaires :

.jpg)

.jpg)