Envie de voir l’une des sublimes sculptures cinétiques de Theo Jansen, l’un des merveilleux pièges à brume de Carlos Espinosa, ou l’un des effrayants clones « géminoïdes » d’Hiroshi Ishiguro ? Le Palais de Tokyo réunit du 18 février au 17 mai 2015 une flopée d’artistes, scientifiques et créateurs de tous horizons dans une exposition collective venant bousculer nos certitudes sur les frontières établies entre territoires artistiques balisés, inventions pures et loufoqueries créatives. Les interrogations de Marcel Duchamp sur l’essence-même d’une œuvre artistique viennent rythmer dans l’ombre « Le bord des mondes », exposition unique qui nous jette en pâture l’un des monstres tubulaires de Theo Jansen, les « chindōgu » inutilisables de Kenji Kawakami, la « topographie des larmes » de Rose-Lynn Fisher, les « attrape-nuages » de Carlos Espinosa et les clones dérangeants d’Hiroshi Ishiguro.

Le bord des mondes

Quand ? Du 18 février au 17 mai, de midi à minuit

Où ? Palais de Tokyo à Paris

Petit tour d’horizon de l’exposition avec la présentation (pages suivantes) de cinq oeuvres :

-

Les monstres tubulaires de Theo Jansen

-

Les « chindōgu » de Kenji Kawakami

-

« Topographie des larmes », de Rose-Lynn Fisher

-

Les « attrape-nuages » de Carlos Espinosa

-

Les clones « géminoïdes » de Hiroshi Ishiguro

Les monstres tubulaires de Theo Jansen

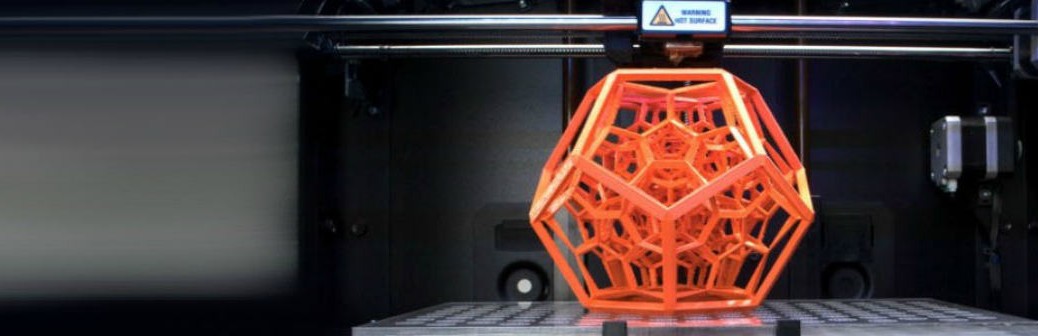

Le travail de Theo Jansen s’articule depuis près d’une vingtaine d’années autour du développement d’une espèce rare de monstres tubulaires de son cru, les « Strandbeasts » (ou créatures de plages), sculptures cinétiques imposantes contenant tout ou seulement quelques parties en mouvement. Le génial artiste néerlandais dit s’inspirer de la théorie de l’évolution génétique pour faire évoluer ses sculptures. En véritable Frankenstein de l’art cinétique, il s’est retrouvé à la tête d’une petite flottille de créatures mobiles quasi-autonomes.

« Le bord des mondes » présentera l’un des gigantesques – et quelque peu effrayants – myriapodes créés par Theo Jansen, monstre dont le squelette est composé de tubes d’isolation électrique, de tiges de bambou, de serre-câbles, et dont la voilure en Dacron (un textile artificiel de l’ordre des polyesters) lui permet de se mouvoir au gré du vent.

Theo Jansen, Animaris Umerus, 2010. Copyright : André Morin, 2015

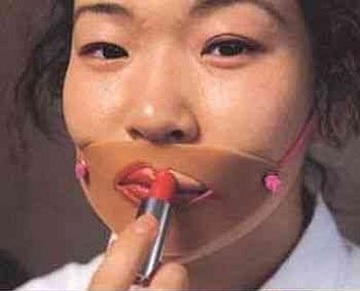

Les « chindōgu » de Kenji Kawakami

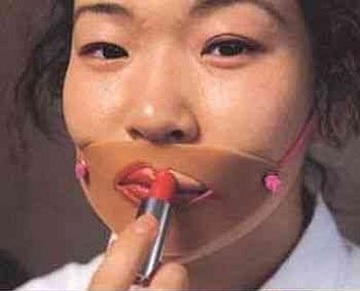

Depuis le début des années 1980, Kenji Kawakami est le pape de l’art japonais du « chindōgu », cette fâcheuse manie qu’ont certains inventeurs à créer des objets « utiles mais inutilisables », répondant efficacement mais de manière inappropriée ou ridicule aux menus problèmes de notre quotidien, manie que nous évoquions déjà ici.

Perçus comme « de véritables manifestes de résistance politique, économique et poétique », ses œuvres sont autant de petits bijoux dont la fonction est aussi évidente qu’elle insulte le sens pratique. De la grenouillère-serpillière au beurre en stick, « Le bord des mondes » offre une belle introduction au travail de Kenji Kawakami, avec une vingtaine de pièces exposées et une rétrospective photos couvrant une part non négligeable de son travail.

Copyright Kawakami / Jean-Christophe Leco

Copyrights Kenji Kawakami

Présentation de l’œuvre de Kawakami, au Palais de Tokyo. Copyright : André Morin, 2015

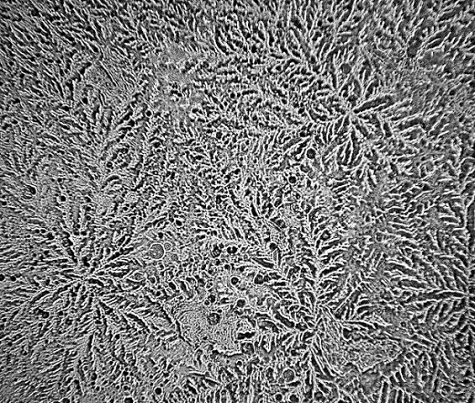

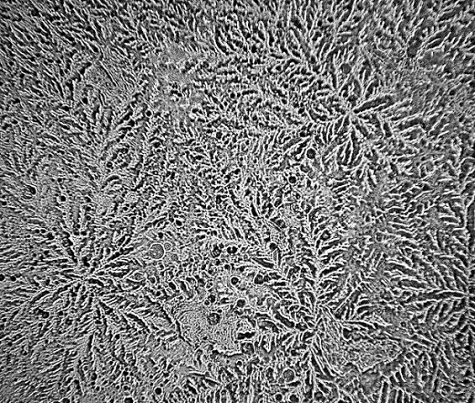

« Topographie des larmes », de Rose-Lynn Fisher

2008 a été une année difficile pour Rose-Lynn Fisher. La perte de quelques proches, ainsi qu’une certaine incertitude aux niveaux professionnel et personnel, ont fait basculer la balance lacrymale dans le rouge. Un jour, plutôt que d’essuyer ses larmes, la photographe américaine s’est mis en tête d’explorer les précieuses sécrétions à travers le prisme d’un microscope… pour y découvrir un univers inattendu, peuplé de protéines, de minéraux, d’hormones et d’enzymes. Elle renouvela alors l’expérience avec d’autres larmes, provenant d’autres cobayes ou induites de manière différente – sur le banc des accusés, se bousculent un oignon, une crise de fou rire, la douleur, ou encore l’exaspération.

Qualifiées de « vues aériennes de terrains émotionnels », et ressemblant de fait à s’y méprendre à des photographies aériennes de contrées imaginaires, la force des photos appartenant à la série « Topographie des larmes » est de dissocier ces larmes identiques en rendant visible quelque chose de fondamentalement intangible.

Rose-Lynn Fisher, The brevity of time (out of order) losing you, 2011

Rose-Lynn Fisher, Tears of change, 2013

Rose-Lynn Fisher, Tears of ending and beginning, 2013

Rose-Lynn Fisher, Onion tears, 2013

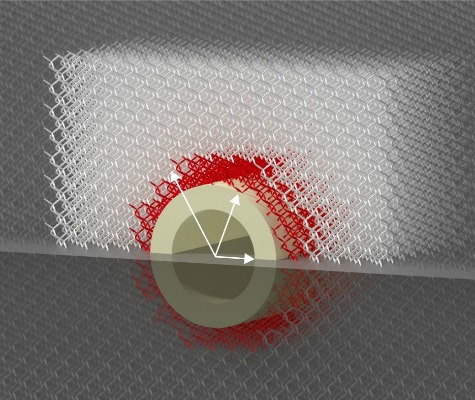

Les « attrape-nuages » de Carlos Espinosa

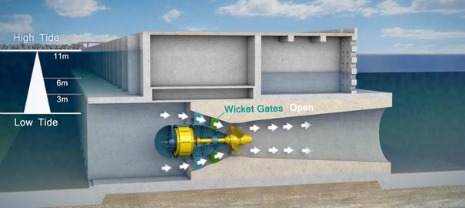

Physicien de formation et inventeur des « atrapanieblas » (« attrape-nuages » ou encore « piège à brume » en français), le Chilien Carlos Espinosa est également représenté au palais de Tokyo, avec l’un de ses fameux capteurs d’eau ayant fait florès un peu partout au Chili. Imaginés et conçus alors qu’une sécheresse sans précédent sévissait dans le pays, il y a près de cinquante ans, les atrapanieblas ont pour vocation de piéger l’eau vaporeuse en mouvement, afin de la fixer dans l’espace et pallier un éventuel manque.

Utopiste pragmatique, le désormais nonagénaire cherchait à « trouver des solutions durables de cohabitation de l’homme avec son environnement, quand l’humanité toute entière commençait déjà à se lancer dans la conquête spatiale ». Comme une évidence, le Chilien fit breveter son invention en 1963, pour en offrir dans la foulée l’usage à l’UNESCO. La classe.

Carlos Espinosa, Atrapanieblas Macrodiamante 781025, 2014. Copyright : André Morin, 2015

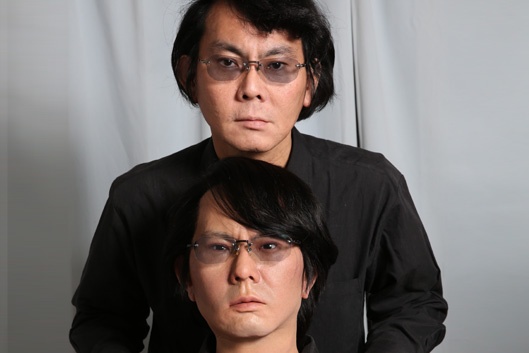

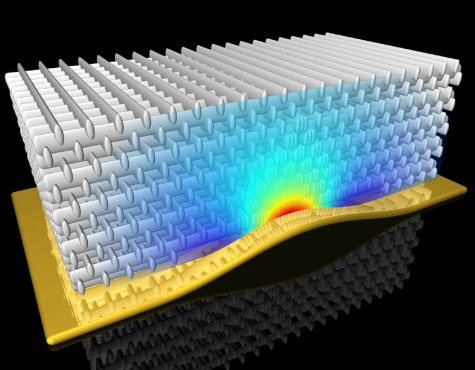

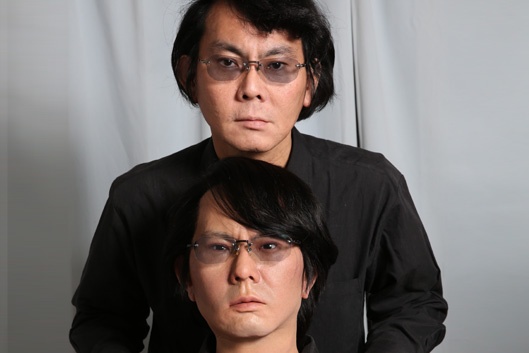

Les clones « géminoïdes » de Hiroshi Ishiguro

Enfin, dans l’une des salles de ce « bord des mondes » vous attendent une femme debout et un homme assis près d’elle, dans une atmosphère quelque peu dérangeante. Dérangeante car ces deux loustics ne sont pas faits de chair et de sang, mais de silicium et de polymère. Ces robots anthropomorphiques, répliques fidèles du professeur Hiroshi Ishiguro et d’une mannequin japonaise, sont les parfaits ambassadeurs parisiens du travail du célèbre chercheur en intelligence artificielle à l’université d’Osaka.

L’apparence des robots est primordiale pour le professeur japonais, une apparence humaine permettant au robot d’avoir une présence plus forte, plus ancrée dans le réel. Pourtant les créations d’Hiroshi Ishiguro ne sont pas seulement des poupées grandeur nature, mais bien des androïdes aux lèvres humides et aux yeux vifs, réagissant à leur environnement. La quête d’Ishiguro est paradoxale, puisqu’à travers ses « géminoïdes », c’est bien la nature de l’homme qu’il essaie de comprendre.

Copyright Hiroshi Ishiguro, 2014

Présentation de l’œuvre d’Ishiguro, au Palais de Tokyo. Copyright : André Morin, 2015

Par Rahman Moonzur