L’Europe attire énormément d’investisseurs internationaux, notamment pour le solaire et l’éolien. Cependant, une politique plus progressiste est nécessaire en vue de renforcer le mouvement, selon un réseau d’investisseurs tournés vers le développement durable.

Selon un registre volontaire de fonds d’investissement internationaux dans le développement durable, l’Europe est de loin la région la plus attrayante. En effet, plus de 90 projets mobilisant des capitaux d’institutions financières européennes, américaines, ou encore australiennes sont menés sur le Vieux Continent. L’Australie représente plus de 40 projets, alors que les « marchés développés » et les États-Unis représentent environ 30 projets chacun.

Des membres issus de différents réseaux tels Asia Investor Group on Climate Change et Investor Network on Climate Risk se sont inscrits sur le registre. Dévoilé le 18 septembre, ce registre est maintenant ouvert aux fonds d’investissement n’appartenant pas à ces réseaux d’investisseurs.

En Europe, le nombre d’inscrits dans le registre concerne en premier lieu l’éolien (27 inscrits) et le solaire (15 inscrits). Les fonds publics (10 inscrits) et privés (10 inscrits), qui investissent principalement dans les technologies à faible émission de CO2, sont également bien représentés.

L’efficacité énergétique, la transmission et la distribution d’énergie ainsi que les processus de production industriels comptent respectivement sept inscrits. La construction verte, les obligations vertes, les hydroénergies, les bioénergies, le secteur forestier et les marchés du carbone sont moins bien représentés dans le registre.

La majorité des projets en Europe reçoivent moins de 10 millions de dollars (7 millions d’euros) de la part des membres du réseau, dont font partie les fonds de pension américains et européens, comme PensionDanmark ou le California State Teachers’ Retirement System. Les fonds d’investissement religieux et de charité, tels que le fonds d’investissement de l’Église de Suède, et de l’Église d’Angleterre, représentent également des investisseurs clés.

Un second rapport publié en même temps que le registre donne des exemples concrets de contributions cruciales de la communauté d’investisseurs institutionnels dédiée au développement de l’économie à faible émission de carbone.

Ainsi, PensionDanmark attribue 3 milliards de dollars (2,3 milliards d’euros) aux projets d’infrastructures à faible émission de carbone et infrastructures de réseau, ce qui représente 9 % des actifs consacrés. Le groupe ING a pour sa part accru ses engagements en faveur d’énergies renouvelables dans son portefeuille de prêts de 6 % en 2006 à 39 % en 2013.

Stephanie Pfeifer, directrice générale de Investors Group on Climate considère cependant qu’il est trop tôt pour dire que les projets européens sont les plus attrayants pour la communauté d’investissement. « Nous n’en sommes qu’au début de la mise en place du registre », explique-t-elle.

« L’Europe a été une destination attrayante pour les investissements verts et le nombre d’inscrits reflète cette tendance », indique-t-elle. « Actuellement, l’Europe n’est plus attrayante en raison de l’incertitude politique qui règne et du faible prix du carbone », poursuit-elle.

Une politique plus progressiste

L’autosatisfaction n’est en effet pas de mise mettent en garde les 347 investisseurs, qui représentent ensemble une quantité d’actifs de 24 milles milliards de dollars (18,7 milles milliards d’euros).

Dans une déclaration publiée en amont du sommet de l’ONU sur le climat cette semaine, les membres des réseaux soulignent la nécessité d’avoir « une direction politique plus forte et des politiques plus ambitieuses afin que nous puissions investir plus… Nous demandons [plus spécifiquement] aux gouvernements de fournir une tarification fiable du carbone qui soit significative sur le plan économique. [Cette fixation des prix] contribuerait à réorienter les investissements en rapport avec l’ampleur du défi du changement climatique ? Nous leur demandons également de renforcer le soutien réglementaire pour l’efficacité énergétique ainsi que pour les énergies renouvelables ».

Les fonds de financement publics

Par ailleurs, l’Europe obtient des financements pour lutter contre le changement climatique de la part des banques multilatérales de développement (BMD), telles la Banque européenne d’investissement (BEI) et la Banque mondiale.

Ces institutions publiques financent des programmes d’adaptation au réchauffement climatique, y compris pour les infrastructures et les projets de développement des énergies renouvelables, principalement au sein des économies émergentes et en voie de développement.

Les pays non membres de l’UE en Europe et en Asie centrale (Albanie, Kosovo, Arménie, etc.) et les 13 nouveaux États membres (UE 13) ont reçu respectivement 22 % et 14 % des financements en provenance des BMD, selon un rapport commun sur le financement des BMD qui a été publié le 19 septembre.

Le montant des investissements est plus bas que ceux de 2012. À l’époque, les 13 nouveaux États membres de l’UE avaient décroché 11 % de la totalité des fonds alloués par les BMD, tandis que les pays tiers et ceux d’Asie centrale en avaient remporté 15 %.

À l’échelle mondiale, les fonds climatiques investis par les BMD ont chuté de plus de 11 % en 2013 pour atteindre un niveau de 23,8 milliards de dollars (18,5 milliards d’euros) cette année.

À l’instar des tendances en 2012, quelque 80 % des fonds sont alloués à la réduction des gaz à effet de serre. Les 20 % restant sont consacrés aux mesures d’adaptation et de précaution mises en place dans le cadre du réchauffement climatique.

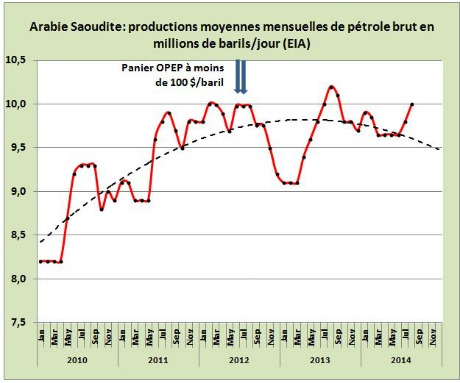

Richard Willis, porte-parole de la Banque européenne d’investissement, n’est que moyennement inquiet. « La faiblesse de l’économie et la nature conjoncturelle des investissements dans les énergies renouvelables expliquent en grande partie ce déclin. Dans ce dernier secteur, les investissements tendent à augmenter de nouveau avec l’avènement d’une nouvelle génération de technologies. Puis ils chuteront jusqu’à ce que de nouvelles technologies soient développées », a-t-il expliqué à EurActiv.

« La prise de conscience sur l’importance des financements climatiques a encouragé une bonne coopération et à un partage de l’expertise entre les BMD, les banques commerciales renouvelables, les entreprises privées, les gouvernements, etc.

Le défi qui se présente est de maintenir cette dynamique afin de continuer à attirer des investisseurs, parmi lesquels les obligations vertes, mais aussi d’apporter des solutions simples à l’échelle mondiale, par exemple sur l’évaluation des projets verts.

Donner confiance en ces projets, en leur efficacité à la fois environnementale et financière, notamment quand il s’agit de basculer d’un modèle basé sur les énergies fossiles vers un système fondé sur les énergies propres en Afrique ou ailleurs, représente un autre défi de taille ».

PROCHAINES ÉTAPES

- 23 septembre : sommet de l’ONU sur le climat

- 23-24 octobre : les dirigeants européens se mettront d’accord sur le paquet énergie-climat 2030 et sur les recommandations pour la conférence sur le climat de l’ONU en 2015 qui se tiendra à Paris

- Du 30 novembre au 11 décembre 2015 : la Conférence sur le climat 2015 se tiendra à Paris et les États essaieront de trouver un accord contraignant en vue de lutter contre le changement climatique

- 2020 : le nouvel accord sur le changement climatique entrerait en vigueur

- 2020 : date butoir pour respecter les objectifs sur la réduction de 20 % en émission de gaz à effet de serre, l’amélioration de l’efficacité énergétique, les parts de marché dédié aux énergies renouvelables.

EurActiv.com – Beatrice Denis – traduction de l’anglais par Pascal Hansens

Et aussi dans les

ressources documentaires :

.jpg)

.jpg)