Par Hubert Blatz

Par Hubert Blatz

Le culte de la santé n’a jamais été aussi poussé qu’aujourd’hui. Cela n’a pas échappé aux grands pontes de la technologie mobile qui se sont empressés de se nicher dans ce type de services. Résultat, on assiste à un développement d’applications en pagaille, avec dans ce sillon celui des objets connectés. Le marché est fleurissant, comme l’est celui des smartphones. Aujourd’hui, c’est au tour de deux des acteurs les plus emblématiques, Google et Apple, de surfer sur cet engouement en livrant leur application phare : le Google Fit et le l’HealthBook.

Jusqu’à maintenant, si vous utilisiez une ou plusieurs applications mobiles dans les domaines de la santé et du sport, vous ne pouviez observer les résultats transmis par les capteurs des objets connectés que sur l’application en question.

Google va changer la donne avec la plateforme Google Fit, une base de données permettant de centraliser les informations de ces applications en un seul point. C’est bête comme chou, mais en interconnectant ces applications, Google apporte à l’utilisateur une vision d’ensemble de ses performances et lui simplifie ainsi la vie.

Des marques renommées comme Adidas, Nike, Withings ou encore Asus devraient normalement faire partie des premiers partenaires.

Annoncée au même moment que le nouvel IOS 8, lors de la dernière conférence d’Apple le 2 juin, l’application HealthBook promet de chambarder notre quotidien. Ce « carnet de santé » numérique révélera à son utilisateur, en temps réel, toutes les données ayant trait à sa santé telles que son poids, ses heures de sommeil, sa tension, ses taux de glucose dans le sang et d’oxygène…

Encore une fois, les capteurs ont un rôle prépondérant dans cette collecte d’informations très personnelles. Dans un premier temps, l’application dialoguera avec des objets connectés d’autres fabricants, mais par la suite, il y a des chances pour qu’Apple s’appuie exclusivement sur les objets qu’elle compte développer.

Vous vous demandez sans doute ce que devient votre vie privée dans tout ça ? C’est bien normal, tant il est vrai qu’au travers de cette collecte d’informations « pour notre bien », les géants de l’hi-tech peuvent tout savoir de nous. La confidentialité sera-t-elle assurée ? Il semblerait que oui, toutefois, on peut légitimement penser que nos données seront commercialisées. Gageons que les marques tireront bien parti de nos données personnelles (mensurations, conditions physiques,…) pour nous proposer des solutions à nos maux.

Faire un bilan de santé tous les jours, grâce à son mobile, est une véritable innovation à n’en pas douter. Ces applications mobiles vont changer notre quotidien, bien qu’il faille sûrement un peu de temps avant que leur utilisation ne rentre tout à fait dans les moeurs. Google et Apple promettent d’offrir une toute nouvelle expérience, même si certains ont déjà pu s’échauffer via l’application Health Mate de la startup Withings et bien d’autres que l’on aurait pu citer. Quoi qu’il en soit, les Français seraient intéressés; selon une étude Almerys : 53% déclareraient être en faveur d’un carnet de santé en ligne. Il y a donc un public… Et une méfiance concernant la sécurité du stockage de ces informations.

Par Sébastien Tribot

Et aussi dans les

ressources documentaires :

De plus, compte tenu de la grande précision de positionnement des robots, de leur capacité à adopter des postures inaccessibles à l’homme et enfin de leur miniaturisation éventuelle, ceux-ci apparaissent comme étant les outils idéaux pour faire le lien entre l’image médicale et le patient sous le contrôle du chirurgien.

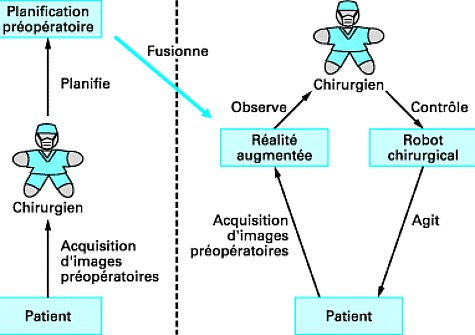

La figure 1 schématise comment la robotique médicale s’articule avec la réalité augmentée et la planification préopératoire. Il apparaît clairement que la robotique est une interface d’action du chirurgien sur le patient au même titre que la réalité augmentée est une interface de perception.

Mais c’est l’existence d’un contact entre la machine et l’homme qui donne une dimension particulière à cette technologie. Au-delà de l’existence d’une barrière psychologique pour le chirurgien et le patient, il s’agit de vaincre une autre barrière, technologique cette fois, qui vise à garantir la sécurité d’un système robotique, tant au niveau logiciel que matériel. Cette garantie s’obtient grâce à une conception adaptée de la mécanique du robot, évitant les mouvements aléatoires en cas de commande erronée ou d’alimentation électrique défaillante. Également, le logiciel du robot est validé à l’aide de techniques éprouvées de génie logiciel mais aussi par une validation systématique et à grande échelle des fonctionnalités du robot. Le contact ou la proximité d’un robot avec un patient impose une deuxième contrainte : la stérilisation partielle ou totale du robot. Ceci impose des choix spécifiques concernant la conception mécanique (possibilité d’extraire certains composants pour une stérilisation dans un autoclave) et la nature des matériaux utilisés.

En pratique, le terme de « robotique chirurgicale » est souvent utilisé pour désigner à la fois des robots qui assistent le geste du chirurgien et des robots qui effectuent un geste chirurgical. Dans la première catégorie, on exploite la précision, la force, la répétabilité du robot, alors que dans la seconde, on exploite plus souvent sa miniaturisation, sa précision et sa dextérité.

Parmi les robots qui assistent le geste du chirurgien, on peut citer les robots utilisés en neurochirurgie et qui sont destinés à porter les instruments chirurgicaux, un microscope (pour l’observation du champ opératoire) et un système de visée laser permettant de superposer les informations préopératoires (réalité augmentée). Également, la robotique peut permettre une certaine automatisation de la salle d’opération avec un objectif de gain de productivité et de temps d’exécution. Ainsi, il existe des manipulateurs robotisés, à l’extrémité desquels est placé un endoscope, qui permettent à un chirurgien de contrôler par la voix la position de cet endoscope dans une procédure de vidéochirurgie. Parmi les modèles de robots les plus récents, certains reposent sur le concept d’assistance semi-active au geste du chirurgien. Leur principe est simple : le robot est passif tant que l’outil chirurgical est à l’intérieur d’une zone déterminée lors de la planification préopératoire (pour éviter d’endommager des structures vitales) et, dans le cas contraire, le robot est actif en empêchant le mouvement de l’outil de pénétrer dans cette zone grâce à l’activation de moteurs (retour d’effort).

Figure 1 :

Depuis le début des années 1990, sont apparus des robots chirurgicaux conçus comme de véritables interfaces entre le chirurgien et le patient. Ceux-ci agissent directement au contact du patient et sont entièrement contrôlés par un chirurgien.

Jusqu’à présent des robots ont été destinés à deux types de chirurgie : la chirurgie orthopédique et la vidéochirurgie :

Si la robotique chirurgicale correspond naturellement à la prochaine génération d’instruments chirurgicaux, il existe plusieurs obstacles à son développement.

Tout d’abord, le coût des systèmes robotisés est très élevé et il est nécessaire de justifier quantitativement leur impact positif sur la santé des patients pour convaincre les organismes gestionnaires de la santé de les adopter.

Enfin, ils requièrent une mobilisation importante des chirurgiens et de leurs assistants pour se former à cette nouvelle conception de la chirurgie.

Par ailleurs, la généralisation de la téléchirurgie dont une expérience a été tentée avec succès entre Strasbourg (France) et New York (USA) est assez peu envisageable à grande échelle sauf pour des contextes militaires (chirurgie sur porte-avion ou sur champ de bataille) ou pour la formation des chirurgiens des pays en voie de développement.

Par Hervé Delingette

Et aussi dans les

ressources documentaires :

L’analyse de l’expression des gènes ou transcriptomique est l’application la plus courante des puces à ADN. Mais il ne faut pas négliger leur utilisation de plus en plus importante pour des applications en génomique telles que l’analyse du nombre de copies de gènes (CNV : Copy Number Variation) encore appelée « hybridation génomique comparative » (CGH : Comparative Genomic Hybridization) ou l’analyse des SNP (Single Nucleotide Polymorphism). Elles sont aussi employées dans les analyses épigénétiques qui permettent de mieux comprendre les régulations de l’expression des gènes (ChIP-chip, MeDIP-chip…), de même que pour réaliser de la capture de séquence en vue d’un séquençage ciblé de gènes d’intérêt.

Depuis quelques années, on assiste à un déploiement important des biopuces dans le cadre du diagnostic. L’intérêt de la technologie biopuce pour le diagnostic est incontestablement sa facilité d’utilisation, sa rapidité, son coût et surtout le fait qu’elle permette le multiplexage.

Ainsi dans de nombreux domaines tels que la sécurité alimentaire ou la santé, les biopuces ont investi le marché.

Greiner Bio One, considéré comme l’un des leaders sur ce marché du diagnostic, développe et produit des biopuces de haute qualité pour le diagnostic humain, la protection du consommateur et le contrôle qualité dans l‘industrie pharmaceutique :

D’autres sociétés, moins connues que Greiner Bio One, ont fait des biopuces diagnostic leur fonds de commerce. C’est le cas de la société DR. Chip Biotech Inc., basée à Taiwan, avec à son catalogue six biopuces pour le diagnostic dont voici quelques exemples :

Autre acteur de ce marché des puces pour le diagnostic, la société bioMérieux, qui commercialise la biopuce FoodExpert ID, capable de détecter 33 espèces de vertébrés différentes et d’identifier simultanément la présence de produits animaux dans des échantillons alimentaires à deux niveaux de taxonomie : au niveau de la classe (mammifère, oiseau ou poisson) et au niveau de l’espèce (bœuf, poulet, saumon…). FoodExpert-ID® fonctionne aussi bien sur l’alimentation crue que sur les produits transformés à haute température et pression, comme certains aliments pour les animaux.

Lire l’article dans son intégralité

Par Véronique Anton Leberre

Et aussi dans les

ressources documentaires :

Les applications potentielles des biosenseurs sont très larges, dès lors que la détection et la caractérisation rapides d’une odeur sont en jeu, dans des domaines aussi variés que :

Le développement des biosenseurs olfactifs est encore récent. Il est certain que les progrès dans le domaine de l’imagerie à l’échelle moléculaire (microscopie à champ proche) ainsi que le développement des micro- et nanotechniques de fabrication de capteurs et de la nanoélectronique pour mesurer de très faibles signaux électriques à partir de ces objets, vont augmenter les performances de ces systèmes.

Toutefois, la compréhension de la régulation de l’expression des récepteurs olfactifs, ainsi que la désorphanisation et la caractérisation d’un plus grand nombre de ces récepteurs restent des étapes clefs pour permettre le plein essor de ces biocapteurs olfactifs.

Les exemples sont nombreux dans tous les secteurs :

La désorphanisation

Désorphanisation des récepteurs olfactifs : l’immense majorité des récepteurs olfactifs n’a pas encore de ligand odorant connu. Il est très difficile de mener cette étude dans l’épithélium olfactif, car chacun des quelque 10 millions de neurones sensoriels présents exprime un type de récepteur olfactif parmi les quelques centaines de récepteurs olfactifs présents dans le génome. Il faut donc se tourner vers des systèmes d’expression fonctionnelle hétérologue, avec les difficultés déjà mentionnées, pour pouvoir procéder au criblage de centaines d’odorants de fonctions chimiques, longueurs de chaîne carbonée, branchements différents, sur toute une gamme de concentrations. Actuellement, on peut estimer à quelques dizaines le nombre de récepteurs olfactifs dont les ligands préférentiels sont identifiés, toutes espèces confondues.

Les analyses sur puces, ainsi que les micro- et nanobiosenseurs olfactifs ne requièrent que de très faibles quantités de nanosomes porteurs de récepteurs olfactifs préparés à partir de levures modifiées. Leur coût en terme d’éléments sensibles est donc minimal. Cette conception de capteurs offre donc de réelles possibilités pour l’élaboration d’un réseau de micro- ou nanocapteurs, qui pourrait mimer un nez biologique.

En outre, le test de RPS décrit ici peut tout à fait convenir au criblage à haut débit d’autres GPCR, d’intérêt pharmacologique en particulier, par les méthodes d’analyse automatique bien établies, car les récepteurs immobilisés peuvent être stimulés répétitivement sans manipulation spéciale, moyennant un temps de récupération de 30 min entre deux stimulations successives.

Par Jasmina Vidic et Edith Pajot-Augy

Et aussi dans les

ressources documentaires :

Il semblerait que les exosquelettes s’implantent dans notre quotidien. Le coup d’envoi de la coupe du monde 2014, le 12 juin dernier par un jeune Brésilien paralysé des membres inférieurs et équipé d’un exosquelette en est le signe le plus éminemment symbolique. En ce sens où il est révélateur des progrès de la science dans ce domaine : l’association de la robotique et de la neurosciences. La preuve en deux exemples.

Imaginé par la société Rewalk Robotics – fondée par l’ingénieur israélien Amit Goffer, paralysé à la suite d’un accident en 1997 – l’exosquelette ReWalk permet aux personnes atteintes à la moelle épinière de retrouver une certaine mobilité (se lever et marcher). Toutefois, l’appareil ne concerne que les paraplégiques atteints de lésions entre la 7ème vertèbre thoracique et la 5ème vertèbre lombaire. Il s’agit du premier dispositif du genre destiné aux particuliers pour les assister dans leur quotidien.

Son fonctionnement maintenant. L’appareil ceinture les jambes et le buste de l’utilisateur; à condition que sa taille soit comprise en 1,60 et 1,90 mètre et que son poids ne dépasse pas 100 kilogrammes. Un ordinateur de bord et une batterie contenus dans un sac à dos servent à actionner les moteurs placés au niveau des hanches et des genoux. L’utilisateur les contrôle à l’aide d’une commande située à son poignet et choisit de cette manière les actions qu’il souhaite effectuer. Et ça marche, les démonstrations sont éloquentes.

À ce titre, et après de nombreux tests, la Food and Drug Administration (FDA) a décidé d’approuver la vente sur le territoire américain de l’exosquelette ReWalk. Une excellente nouvelle, certes, mais dont le prix devrait refroidir quelque peu. Il en coûtera 70 000 dollars (plus de 50 000 euros) aux particuliers pour bénéficier d’un ReWalk.

Grâce à l’exosquelette ReWalk, l’alternative au fauteuil roulant n’est plus une chimère mais sera avant demain une réalité. Et c’est une espèce de révolution en soi parce que ReWalk offre l’espoir salvateur de retrouver de l’autonomie aux personnes handicapés. Pour celles qui, malgré le prix exorbitant, pourront s’acheter l’équipement, leur vie promet d’être bouleversée.

L’utilisation de l’exosquelette, outre le miracle de se lever et marcher à nouveau, s’accompagne d’autres bienfaits. Les patients ont témoigné d’une meilleure circulation du sang, d’une remusculation des membres… Bref d’une meilleure forme physique et également mentale. Le fait de regagner en autonomie, sans l’aide d’autrui, de communiquer à hauteur d’yeux procurerait un grand bien-être.

Cette fois-ci, l’exosquelette concerne les travailleurs et vient surtout en renforcement des capacités naturelles de l’homme. En effet, des chercheurs du MIT d’Arbeloff Laboratory ont conçu des prototypes afin de soulager les ouvriers lors de leurs tâches les plus difficiles.

L’exosquelette se présente en fait sous la forme de deux bras robotiques attachés au dos de l’utilisateur et couvrant une large surface. Selon le modèle – il en existe deux – le début des bras est situé au niveau des hanches ou des épaules. Le Supernumerary Robotic Limbs (SRL, son petit nom) ne pèse que 4,5 kilogrammes mais grâce au détecteur de mouvements dont il est pourvu, il peut venir en aide aux travailleurs, en suppléant ses gestes, ou en le soutenant lors du port de charges lourdes. Différents modèles comportementaux ont été créé dans ce but.

De par son faible encombrement, le SRL se révèle très pratique car il est censé offrir davantage de liberté de mouvement tout en permettant à celui qui le porte de garder les mains libres. Un système ingénieux qui a semble-t-il plu au constructeur aéronautique Boeing qui a financé en grande partie les recherches.

Par Sébastien Tribot

Et aussi dans les

ressources documentaires :

Pour remplacer des fonctions altérées chez les patients, les bioprothèses sont diverses et variées: implants dentaires, prothèses de hanche, de genoux, d’épaule, mais aussi valves cardiaques, substituts osseux… La recherche est riche, notamment pour créer des organes entiers, à l’instar du coeur ou du pancréas bio-artificiels. D’autres travaux s’intéressent même à la régénération des organes défectueux in-situ.

Pour remplacer des valves cardiaques, il existe essentiellement deux grandes familles de prothèses : les prothèses mécaniques et les valves biologiques. Les prothèses mécaniques ont une très longue durée de vie au prix d’un traitement anticoagulant à vie. A l’opposé, les bioprothèses ne demandent pas de traitements mais se détériorent avec le temps, imposant à certains patients une réintervention après une quinzaine d’années.

Les valves mécaniques (prothèse de St Jude) sont à base de carbone pyrolytique et de titane. Elles ont une durée de vie supérieure à celle du patient chez qui on l’implante mais nécessitent un traitement anticoagulant à vie. L’efficacité du traitement anticoagulant doit être contrôlé régulièrement. Le patient peut en effet faire des hémorragie s’il est trop anticoagulé ou au contraire contracter une embolie, quand il ne l’est pas assez.

Les bioprothèses valvulaires, sont élaborées avec des tissus de veau ou de cochon. Elles sont préférées chez les patients âgés et pour les patients qui ne peuvent pas suivre un traitement anticoagulant ou en contrôler son efficacité. A l’opposé, les patients qui sont déjà sous traitement anticoagulant en raison d’une autre pathologie recevront plus volontiers une prothèse mécanique plutôt qu’une bioprothèse.

Le premier coeur bio-artificiel de la société Carmat a été greffé en France début 2014. Le patient est décédé 74 jours après son opération des suites d’un court-circuit encore inexpliqué. « Pendant 74 jours, ce patient n’a montré aucune déficience cérébrale, et la vérification du cœur après le décès et l’autopsie l’ont confirmé : il n’y avait pas le moindre caillot, ni dans la prothèse, ni dans la circulation. En ce sens, l’essai est un succès. » explique le professeur Alain Carpentier, père du coeur artificiel au JDD. Les travaux vont donc continuer pour permettre à de futurs patients de profiter de ce coeur qui ne nécessite pas de lourds traitements anti-rejets de greffes.

Le premier pancréas bio-artificiel bénéficiera de premiers tests chez l’homme début 2016 à Montpellier et à Oxford (Royaume-Uni). De premiers résultats devraient ainsi être disponibles fin 2017. Ce pancréas bio-artificiel se présente sous la forme d’un disque ultra-fin en polymère, à peine plus grand qu’un CD. Il est destiné aux diabétiques insulino-dépendants. Implantée dans l’abdomen, cette poche renfermera des cellules de pancréas (obtenues par génie génétique ou à partir de cellules souches) permettant de sécréter l’insuline. Grâce à une membrane semi-perméable, les cellules se trouvent ainsi à l’abri des attaques du système immunitaire, tout en laissant passer l’insuline, mais aussi les sucres – afin que les cellules pancréatiques « sachent » quelle quantité d’insuline produire. Les cellules pancréatiques seront renouvelées par injection sous cutanée 1 à 2 fois par an et le disque devra être remplacé tous les 4 à 6 ans. Cela améliorera grandement le quotidien des diabétiques qui s’injectent de l’insuline plusieurs fois par jour ! Là encore, il n’y aura pas besoin de traitement anti-rejet.

Des travaux de recherche portent aussi sur l’injection de cellules souches au niveau du coeur. Elles permettent de régénérer des fibres musculaires et de revitaliser le coeur sans aller jusqu’à son remplacement par une bio-prothèse.

Les travaux portent notamment sur les cellules souches pluripotentes induites qui peuvent être répliquées indéfiniment en laboratoire etse différencier, dans la bonne matrice, en une multitude de tissus : cellules musculaires, nerveuses, pulmonaires… Dans le cas du pancréas bio-artificiel, « il a fallu trouver un matériau et une matrice de façon à avoir un environnement viable pour les cellules pluripotentes », explique Guy Daculsi, Directeur de Recherche Inserm de classe exceptionnelle (DRE) à l’Université de Nantes. »Dans cet environnement, les cellules croient être dans un pancréas et se différencient pour faire des cellules capables de sécréter l’insuline« , poursuit-il.

Ces cellules souches pluripotentes induites pourraient régénérer des parties d’organe une fois incorporées à la bonne matrice. « On va ainsi pouvoir réparer un morceau de coeur, un morceau de foie, de rein, même de poumon« , prévoit Guy Daculsi. Plusieurs unités de l’INSERM travaillent sur certains de ces organes. Ils pourraient être accessibles pour le grand public d’ici une dizaine d’années.

« Il y a eu l’époque de l’homme soigné, puis avec les deuxièmes générations de techniques et produits est arrivé l’homme réparé ; maintenant avec la troisième génération est arrivée l’ère de l’homme augmenté grâce aux nouvelles technologies qui augmentent le potentiel de cicatrisation, de régénération », conclut Guy Daculsi.

Par Matthieu Combe, journaliste scientifique

Et aussi dans les

ressources documentaires :

Les prothèses métalliques remplacent des fonctions mécaniques. Dans ce cas, les médecins utilisent principalement du titane. Face aux propriétés mécaniques insuffisantes du titane sur le long-terme pour de grandes prothèses, et face à son prix extrêmement élevé, les chercheurs se sont tournés vers des alliages de ce métal. L’alliage le plus couramment utilisé est le TiAl6V4, à base de titane, d’aluminium et de vanadium.

Pour favoriser l’ancrage osseux du métal de la prothèse et maintenir le plus longtemps possible un os vivant autour de l’implant, les chercheurs s’intéressent aux traitements de surface. S’ils ont commencé par des traitements de surface avec des biocéramiques en phosphates de calcium déposés par torche à plasma, la maîtrise du procédé a pris du temps. Au-delà de 1300°C, les phosphates de calcium se décomposent et perdent leur propriétés biologiques. « Aujourd’hui, ces procédés sont mieux maîtrisés mais ce ne sont pas les meilleures solutions pour l’avenir, car les dépôts peuvent avoir plusieurs micromètres d’épaisseurs et, en l’absence de liaisons chimiques entre le titane et le phosphate de calcium, il y a des risques de fissures et libération de débris« , explique Guy Daculsi, Directeur de Recherche Inserm de classe exceptionnelle (DRE) à l’Université de Nantes, l’un des pères de l’os artificiel et des nouveaux biomatériaux, récompensé du prix George Winter de la Société Européenne des Biomatériaux en 2014.

Pour éviter les couches épaisses, les spécialistes s’orientent plutôt vers des dépôts électrolytiques: ils déposent des phosphates de calcium par électrolyse à l’échelle nanométrique. Les ions ainsi déposés vont interagir avec les milieux biologiques et améliorer l’ancrage. Depuis quelques années, il existe aussi une troisième méthode permettant de créer des matériaux poreux métalliques. On parle de « métal trabéculaire« . Il s’agit de préparer l’implant en intégrant à la poudre de métal, un porogène ou une matrice poreuse. Lors du frittage, le porogène ou la matrice est calcinée, laissant en place la porosité. On obtient ainsi une mousse de titane ou de tantale. « On s’est aperçu que le traitement de surface microstructuré, avec des micro-porosités permettait d’améliorer l’hydrophilie de la surface des matériaux pour l’adhésion cellulaire, ou que le métal trabéculaire favorisait la colonisation cellulaire et la formation de tissu osseux dans les porosités « , nous livre Guy Daculsi.

Au lieu d’utiliser des prothèses métalliques pour remplacer des greffes osseuses, il est également possible d’utiliser des biomatériaux résorbables permettant de reconstituer les tissus osseux. La recherche est particulièrement riche dans ce domaine. Les chercheurs considèrent notamment des matériaux biodégradables associées à des cellules souches, qui se résorbent progressivement au fur et à mesure de la reconstruction des tissus.

Grâce à la multiplication en laboratoire de cellules souches prélevées au niveau de la moelle osseuse du patient, il est possible de régénérer n’importe quel tissu. Sur ce point, le projeteuropéenREBORNEa permis de réaliser les premiers essais cliniques concluants. Il a notamment mis au point une matrice (un support) permettant de promouvoir ou d’induire la différenciation des cellules souches. La clé du succès est le contrôle de cette matrice qui sert de support, d’échafaudage à la différenciation cellulaire, et à l’expression phénotypique.

« Dans le cadre du projet REBORNE, une matrice très particulière a été utilisée, à savoir une matrice biocéramique en phosphates de calcium nano, micro et macro-structurée, capable d’être rapidement colonisée par les cellules souches, de façon à ce qu’elles puissent exprimer leur phénotype et s’orienter pour faire du tissu osseux« , explique Guy Daculsi. Pour reconstituer un os vivant, il faut également régénérer la vascularisation afin qu’il puisse apporter les nutriments. « Avec des phosphates de calcium, on est proche de la phase minérale de l’os naturel, on a aussi des micro-structures, des micropores qui peuvent aller de la dizaine de nanomètres jusqu’au micron, qui vont permettre d’absorber des fluides biologiques, un peu comme un buvard, et des macro-pores, de l’ordre de 100 à 600 microns qui vont être colonisées par les cellules et le tissu osseux néo-formé », ajoute-t-il.« Il y a alors des niches avec des populations cellulaires qui vont produire des ostéoclastes pour résorber l’implant, des ostéoblastes pour former de l’os nouveau, mais aussi des cellules pour régénérer une vascularisation« , poursuit-il. « L’avantage de cette matrice est qu’elle libère des ions calcium et phosphate qui vont aider les cellules à reconstruire le tissu osseux, à le minéraliser : ils sont totalement absorbés pour en refaire un os naturel« , affirme-t-il. Au final, « d’un matériau totalement synthétique, avec les apports cellulaires et des fluides biologiques, on a un matériau qui se résorbe, qui est absorbé progressivement et va se transformer en os naturel« , résume-t-il.

Si cette solution est particulièrement intéressante, le projet REBORNE a montré que ce traitement peut coûter plus de 20 000 euros par patient. De plus, les centres habilités à manipuler les cellules souches sont extrêmement rares. « On ne pourra faire que 200 à 400 patients dans toute l’Europe, donc cela ne sera pas démocratisable« , déplore le chercheur de l’Inserm.

En parrallèle de ce projet, on peut noter le développement des cellules souches allogéniques. Dans ce cas, les cellules souches vont être extraites de la moelle osseuse d’un donneur, au lieu d’être extraites directement du patient, puis être multipliées. On peut imaginer ici le développement de banques de cellules souches allogéniques, d’ici quelques années. Celles-ci seront prêtes à être utilisées dans le même type de matrice que dans le cas précédent. « Avec la multiplication de cellules de donneurs universels, on va entrer dans une généralisation des biotechnologies, et cela sera une complète démocratisation de la technique pour des coûts beaucoup moins élevés« , prévoit Guy Daculsi.

En attendant cette généralisation,lamatrice développée dans le cadre du projet REBORNE peut déjà être directement utilisée au bloc opératoire de n’importe quel hôpital en faisant un simple prélèvement de moelle osseuse. Par centrifugation, les cellules blanches (dont une partie est constituée de cellules souches) sont ainsi extraites puis concentrées (technique MOCA Moelle Osseuse Concentrée Autologue). Des pionniers utilisent déjà cette technique à l’établissement français du Sang, au CHU de Tours et de Nantes, au CHU Henri Mondor et beaucoup d’autres centres hospitaliers en France, en Europe, mais aussi largement aux Etats-Unis. Dans ce cas, le prix de la procédure se situe autour de 2 000 euros et est donc 10 fois moins chère qu’avec des cellules souches prélevées sur le patient.

Cependant, « La qualité de la moelle et la quantité de cellules souches est très dépendante de l’état de santé du patient et de son âge. Chez un patient jeune, cela marche bien, mais chez un patient de 80 ans, le nombre de cellules souches est assez faible, et comme il n’y a pas de multiplication par culture cellulaire, le potentiel de réparation est moindre », prévient Guy Daculsi.La technique de concentré de moelle osseuse ne sera donc pas forcément très efficace. « En revanche, si on envoie les quelques cellules souches prélevées dans un centre de thérapie cellulaire, il va y avoir une multiplication d’une dizaine de cellules et en 3 semaines on va en avoir plusieurs millions, avec un potentiel de réparation plus important« , déclare-t-il . Mais cela reste très coûteux.

Là encore pour que cette technique fonctionne, il faut que la matrice soit résorbable, mais aussi soit nano, micro et macro structurée. Il faut savoir que sur les 70 à 75 substituts osseux de ce type développées dans le monde, seulement quelques uns ont démontré leur capacité et leur efficacité à être combinées aux cellules souches, ou avec les techniques de concentré de moelle osseuse. Elles sont commercialisées par les sociétés Xpand Biotechnology (Hollande) et BIOMATLANTE (France) partenaires du projet REBORNE.

Par Matthieu Combe, journaliste scientifique

Et aussi dans les

ressources documentaires :

Monsieur Hideki Goto de l’Automotive Software Engineering Division de Toyota Motor Corp. a déclaré lors d’un séminaire organisé par Nikkei Electronics, le 9 juillet 2014, que l’industrie automobile utilisera l’Ethernet comme standard de communication à l’intérieur des véhicules dès 2020.

Très impliqué dans le développement des technologies de LAN (Local Access Network) embarquées dans les véhicules chez Toyota Motor Corp, Monsieur Goto est également président du groupe de travail chargé de la standardisation des interfaces LAN dans les véhicules, le Next-Generation LAN Working Groupe de la JASPAR (Japan Automotive Software Platform and Architecture).

L’Ethernet embarqué est actuellement déjà utilisé pour les communications à l’intérieur des véhicules, notamment pour le réseau de caméras. Monsieur Goto a déclaré que le réseau Ethernet pourra être étendu à l’assistance à la conduite dès 2015 et que l’Ethernet de classe Gigabit (plus de 10 Gigabit par seconde) sera déployé dans les véhicules dès 2018.

Cette avancée sur les communications à l’intérieur des véhicules en utilisant un réseau local Ethernet basé sur le protocole IP (le protocole standard sur Internet) est une passerelle vers la voiture connectée à l’Internet des objets.

Source : bulletins-electroniques

Concept car sport FT-1

Le Big Data représente un nouveau paradigme, né d’une capacité croissante à enregistrer l’information et une disponibilité toujours plus grande de données. Le Big Data correspond aux bases de données toujours plus importantes et au développement d’outils permettant de les remplir, les sonder et d’en tirer des conclusions. Il prend de plus en plus d’importance, des projections indiquant que le PIB européen pourrait augmenter de 206 milliards d’euros dans les 10 prochaines années rien qu’avec lui. Son importance a été reconnue par la Commission 2030 qui en a fait l’un de ces 5 chantiers prioritaires ainsi que par les grands acteurs de l’économie française.

Israël n’est pas en reste, avec des universités à la pointe dans ce domaine, comme l’Université hébraïque de Jérusalem et le Technion, où l’Association France Technion a justement effectué sa dernière mission autour du thème « Making Sense of Big Data ».

La jeune star-tup israélienne DBS-H, fondée il y a un peu moins de 3 ans, travaille sur les bases de données et notamment l’intégration entre celles-ci. Initialement, elle était simple hébergeur et gestionnaire de base de données [10]. Désormais, elle propose également des outils pour mieux exploiter des bases de données Oracle. Elle a notamment mis au point des outils permettant d’analyser en temps réel des flux de données et d’autres permettant de transiter plus efficacement entre un stockage de données local et parcellaire à un stockage par cloud.

Son produit phare, Coreplic-8, est un logiciel qui complète une base de donnée Oracle en fournissant divers services permettant d’augmenter l’efficacité de celle-ci. Par exemple, le CR8 optimise la distribution et l’accès aux données par :

L’outil est conçu pour être peu cher, ciblé pour les petites et moyennes entreprises en croissance et surtout simple à mettre en place.

Présents cette année au MIXiii, forum d’innovation israélien, l’équipe de DBS-H a eu un succès certain, comme le montre cette histoire relatée sur leur blog : un visiteur italien, plus familier du biomédical, passait à coté de leur stand. Peu intéressé par cette histoire de base de données, le visiteur se laisse toutefois expliquer l’importance du Big Data par ces entrepreneurs dynamiques. Quelques minutes plus tard, impressionné par leur discours et convaincu de l’importance à venir du Big Data, il promet de les aider à trouver des financements ! Espérons qu’il y arrive !

Source : bulletins-electroniques

Il est arrivé à tout le monde de voir des nuages « bouillonner » dans le ciel. En général, les phénomènes physiques qui déterminent ces processus de mélange turbulent, essentiels pour la formation de nuages de vapeur d’eau, sont extrêmement difficiles à étudier pour les physiciens, car ils ont souvent lieu à une grande distance de la terre.

Une étude récente menée par le groupe Philofluid du Dimeas du Politecnico de Turin a réussi à surmonter cette difficulté, en reproduisant le comportement des nuages grâce à une simulation informatique. La recherche a permis de clarifier ainsi certains secrets des phénomènes de dynamique des fluides à petite échelle, liés aux processus de mélange turbulent se produisant dans la formation des nuages.

Le projet, coordonné par Daniela Tordella, professeur de mécanique des fluides au Politecnico, a impliqué des doctorants, en leur donnant l’opportunité d’utiliser des supercalculateurs du plus haut niveau: en effet, pour leur étude, ils ont eu accès à plus de 3.000.000 heures de temps de calcul (l’équivalent de 340 années de calcul sur une seule machine) sur le supercalculateur Curie, installé à Paris.

L’étude a également été signalée comme une « success-story » par Prace (Partnership for Advanced Computing in Europe), un réseau qui réunit les principaux centres de calcul intensif en Europe et qui vise à permettre aux chercheurs d’accéder aux systèmes informatiques les plus avancés.

« L’agriculture participe aux émissions de composés azotés, des COV [composés organiques volatils], du méthane et des pesticides, ainsi que des particules primaires », explique Carole Bedos, Chargée de Recherche à l’Inra spécialisée dans la volatilisation des pesticides. Une fois émis dans l’air, ces différents composés peuvent interagir entre eux et avec les composés déjà présents dans l’atmosphère. Ils vont alors générer des composés secondaires. Les NOX et COV constituent des précurseurs d’ozone ; l’ammoniac et les acides des précurseurs de particules fines.

Quantitativement, les flux des polluants peuvent paraître faibles. Mais, sur des surfaces étendues, les émissions deviennent significatives et diffuses. Selon différentes sources, l’agriculture et la forêt émettent ainsi 53 % du total des particules en suspension (20 % des PM10, 9 % des PM2,5 et 6 % des PM1), 89 % du protoxyde d’azote (N2O), 76 % du méthane, 10 % des oxydes d’azote (NOx), 50 % des COV biogènes et 97 % de l’ammoniac présents dans l’air (l’élevage contribuant à hauteur de 77 % des émissions). De plus, le secteur agricole utilise 91 % des pesticides.

En agriculture, les particules primaires sont émises par les cultures et l’élevage, mais il y a peu de données sur ces émissions dans le contexte agricole français. « Pour les cultures, la préparation du sol, la fertilisation, l’apport de produits phytosanitaires, les récoltes vont générer l’émission de particules primaires en fonction du type de sol et de la météo », note Carole Bedos. « Pour l’élevage, les émissions de particules peuvent avoir lieu au niveau des bâtiments, du stockage des effluents, de l’épandage d’effluents et en pâturage », ajoute-t-elle.

Chaque plante émet des types de COV différents. Il demeure néanmoins un manque de données concernant les émissions de COV par l’élevage, depuis les cultures et après apport de résidus organiques au champ pour bien comprendre l’intégralité des phénomènes.

En contact avec l’air, les équilibres physico-chimiques entre les différentes formes d’azote ammoniacal dans le sol engendrent une volatilisation d’ammoniac dans l’atmosphère. En parallèle, il y a des processus biologiques : essentiellement la nitrification (l’oxydation de l’ammonium vers la forme nitrate en passant par la forme nitrite) et la dénitrification (réduction de la forme nitrate vers la forme diazote inoffensive). « Au cours de ces étapes, il y a production d’oxyde nitrite NO et de protoxyde d’azote N2O », explique Sophie Génermont, Chargée de rechercher à l’Inra spécialisée dans les émissions d’ammoniac. « On reconnaît généralement la dénitrification comme étant la source majoritaire des émissions de N2O et la nitrification de NO ». NO et N2O sont des oxydes d’azote.

Les émissions d’ammoniac et d’oxydes d’azote sont des processus naturels qui ont été amplifiés par le développement de l’élevage industriel et l’utilisation des engrais industriels azotés. Les émissions dépendent toutefois du type de sol, de la météo, du type d’engrais apporté (minéral, organique) et des pratiques culturales : dose, apport du produit en profondeur ou en contact avec l’air, présence d’une culture capable d’absorber l’azote ou non.

L’ammoniac est un composé basique qui va interagir avec les composés acides présents dans l’atmosphère (par exemple, H2SO4 ou HNO3) pour former des aérosols secondaires de sulfate d’ammonium ((NH4)2SO4) ou nitrate d’ammonium (NH4NO3). Lors des pics de pollution, les mesures réalisées par le LSCE et l’INERIS montrent que les PM10 et PM2,5 sont composées essentiellement de ces particules inorganiques secondaires de nitrate d’ammonium et de sulfate d’ammonium. « L’industrie et les transports produisent des sulfates, des NOx, des acides qui au contact de l’ammoniac vont former des aérosols », résume Sophie Génermont. En parallèle de ces réactions, l’ammoniac peut aussi réagir avec des aérosols primaires, déjà présents dans l’atmosphère.

Les liens entre ammoniac et particules fines sont donc réels, mais demeurent difficiles à prévoir. « Ce sont des pics d’émission difficiles à prévoir car on n’est pas capable de renseigner de manière exacte la contribution des pratiques agricoles et des effets climatiques à la formation des particules », précise la chercheuse. Pour mieux prévoir ces pics, les chercheurs préconisent d’affiner la description spatio-temporelle des émissions d’ammoniac et de quantifier sa contribution à la formation d’aérosols secondaires.

Les dégâts de l’ammoniac ne s’arrêtent pas là. Il contribue également à l’acidification des sols, à la baisse de la biodiversité des écosystèmes, à l’eutrophisation des eaux continentales et à l’accroissement des émissions de protoxyde d’azote.

Les NOx et les COV sont des précurseurs d’ozone troposphérique. Les réactions liées à cette formation d’ozone sont complexes, car elles intègrent tout un cycle de réactions de formation/destruction d’ozone. Mais au final, la concentration en ozone dépend du ratio de concentrations NOx/COV. Les concentrations en NOx sont assez élevées en zone urbaine et la production d’ozone y est largement contrebalancée par sa destruction. En s’éloignant, les concentrations en NOx décroissent, et les taux de COV peuvent être importants. L’air passe progressivement d’un régime saturé en NOx vers un régime limité en NOx, avec toutefois une contribution locale des émissions de NOx par les sols. « Ce n’est pas en zone d’émissions de NOx que l’on va avoir le plus d’ozone, mais vers des zones plutôt rurales que l’on va avoir des pics de concentration en ozone essentiellement par jours de beau temps et de faible vent », résume Sophie Génermont.

Pour mieux modéliser la pollution, de nombreux défis demeurent, puisque les mécanismes qui entrent en jeu dépendent d’un certain nombre de facteurs. La complexité s’amplifie en plus lorsque l’on y ajoute le spectre des changements de pratiques, des changements d’usage des sols et du changement climatique !

Par Matthieu Combe, journaliste scientifique

Et aussi dans les

ressources documentaires :

« Une zone de culture, c’est à peu près 3 à 6 m2 de feuillage pour 1 m2 de sol, qui sont des capteur de polluants, de poussières, de tout ce qui peut être présent dans l’atmosphère extrêmement efficaces », rappelle Jean-François Castell,Maître de Conférence « Surveillance de la qualité de l’air, ozone et végétaux » à AgroParisTech.La pollution qui se dépose sur les plantes est diverse et varie dans l’espace et dans le temps. On y retrouve pêle-mêle : ozone, nitrates, sulfates, particules fines, pesticides, etc. L’entrée de ces polluants dans la plante va être contrôlée par les stomates, orifices présents à la surface des feuilles, suivant son état de santé et de développement.

Les cultures ne sont pas exposées aux mêmes pollutions d’une région à l’autre, et la nature des pollutions varie au cours des saisons. Au cours de leur vie, les végétaux sont donc exposés à des successions de combinaisons de polluants atmosphérique, dont les effets cumulés sont encore mal connus. Si les réponses des plantes varient d’une espèce à l’autre, elles varient aussi au sein d’une même espèce.

Les effets sur les rendements sont variés et dépendent des types de culture. « L’ozone est considéré comme le principal polluant qui peut avoir un impact sur les végétaux », note Jean-François Castell. L’ozone va jouer sur les mécanismes de la photosynthèse et entraîner des pertes de rendements ou des dégâts foliaires lorsque sa concentration est trop importante. Pour les variétés sensibles*, les pertes de rendement sont de l’ordre de 10 % dans nos régions, et peuvent dépasser 30 % en zone méditerranéenne. Elles atteignent régulièrement 15 % en région parisienne pour le blé. Pour l’ensemble de la zone européenne, les pertes de rendements du blé se chiffrent à environ 3 milliards d’euros selon une étude réalisée par ICP Vegetation.

L’ozone modifie les aspects qualité, mais les données sont encore insuffisantes pour établir des relations dose-impact satisfaisantes. « La qualité boulangère des blés français n’est pas forcément excellente par rapport au blé d’Europe centrale : n’est-ce pas un effet de la pollution atmosphérique ? », s’interroge Jean-François Castell. Les cherheurs notent aussi une légère augmentation de la teneur en protéines des grains/tubercules pour le blé et la pomme de terre, mais plutôt une diminution de la teneur protéique pour le colza.

Plus grave : les polluants peuvent aussi s’accumuler dans les tissus végétaux. C’est notamment le cas des métaux lourds, des HAP et des autres polluants organiques persistants. Lorsque des incinérateurs d’ordures ménagères, de centrales thermiques, des axes de transport routier ou de transport aérien sont situés à proximité des champs, l’impact peut être non négligeable. Une étude réalisée à Berlin** sur des salades cultivées près d’axes routiers a, par exemple, montré des teneurs en plomb croissantes en fonction de l’intensité du trafic. A Paris, des études similaires sont en cours afin d’étudier la teneur en polluants éventuels pour différentes cultures en ville. Les premiers résultats devraient être communiqués en fin d’année.

Les dépôts acides (H+, SO42–, NO3–) amplifient l’acidité des sols et diminuent leur qualité. Au contraire, les dépôts azotés accroissent le développement des plantes. Les sols de plus en plus acides vont alors perdre des éléments minéraux nécessaires à la croissance des plantes, parallèlement à des dépôts azotés favorables à leur croissance. Le déséquilibre est total. « Cela se traduit par une croissance accrue, mais dès qu’il y a un accident climatique ou une pression de maladie, il va y avoir des dégâts et des modifications de fonctionnement des plantes », analyse Jean-François Castell.

Au final, ces pollutions ont des conséquences économiques sensibles. La mise en place de stratégies d’adaptation pour limiter les impacts des polluants apparaît nécessaire. La solution de simplicité serait d’utiliser des traitements pour protéger les plantes de l’ozone ; ceux-ci existent. Mais il serait préférable de diminuer les émissions de polluants et de précurseurs d’ozone. Une stratégie complémentaire serait de déplacer les dates de semis par rapport aux pics de pollution et de préférer les variétés résistantes à l’ozone, propose le chercheur. « Pour s’adapter, l’agriculture devra peut-être choisir des cultures qui répondent mieux à des concentrations croissantes de polluants », envisage Jean-François Castell.

Par Matthieu Combe

* Espèces sensibles à l’ozone : blé, soja, cotonnier, melon, légumes à gousse (haricots, pois, fèves…), navet, oignon, laitue, tomate. Espèces modérément sensibles à l’ozone : betterave, colza, pomme de terre, tabac, riz, vigne, chou, maïs, luzerne. Espèces tolérantes à l’ozone : orge, prunier, fraisier, seigle, brocoli

Et aussi dans les

ressources documentaires :

Comment commence le processus de transformation de la lumière du soleil en électricité dans une cellule solaire organique? La réponse vient du groupe de chercheurs du Conseil national de recherches (CNR) qui a fait une vidéo en temps réel, sur une échelle sans précédent : millionièmes de milliardième de seconde. L’étude, menée par l’Institut de nanosciences du CNR à Modène (Nano-CNR) et par l’Institut de photonique et nanotechnologies (IFN-CNR) à Milan, prouve que les premiers instants de la photo-conversion sont régis par la nature quantique des électrons et noyaux impliqués dans les oscillations cohérentes dans des temps ultra-rapides. La recherche, publiée dans la revue « Science », est menée en collaboration avec le Politecnico de Milan, l’Université de Modène et Reggio Emilia et avec des collaborateurs allemands, français et espagnols.

Naissance du processus de transformation de la lumière du soleil en électricité dans une cellule solaire organique

Moins chères et plus polyvalentes que les panneaux solaires rigides en silicium, les cellules solaires organiques font partie des technologies clés pour la production durable et propre d’énergie renouvelable. « Elles contiennent des polymères qui absorbent la lumière en mettant en mouvement des électrons », explique Carlo Andrea Rozzi du Nano-CNR, « et des macromolécules formées par 60 atomes de carbone, les fullerènes, qui recueillent la charge électrique. Nous nous sommes proposés de comprendre comment se déclenche entre les deux molécules le transfert d’électrons qui donne lieu au courant ». « Un phénomène qui advient à une vitesse tellement rapide qu’il était jusqu’ici inaccessible expérimentalement », ajoute Giulio Cerullo du Politecnico de Milan et de l’IFN-CNR. « Désormais, nous sommes en mesure de l’observer et d’en capturer des images individuelles grâce à des flash de lumière laser ultrarapides, une technologie développée au Département de physique du Politecnico. »

Afin d’étudier ce qui se passe dans un temps de quelques dizaines de femtosecondes (millionième de milliardième de seconde) les chercheurs ont combiné les expériences de spectroscopie laser ultra-rapides, dirigées par Giulio Cerullo, avec une série de simulations informatiques, coordonnées par Carlo Andrea Rozzi. « Nous avons simulé la dynamique de transfert d’électrons entre polymère et fullerène en tenant compte de la nature quantique de la matière », explique Elisa Molinari, physicienne de l’Université de Modène et Reggio Emilia et directrice du centre Nano-CNR à Modène. « Les images que nous obtenons sont surprenantes. Les calculs et expériences montrent que la naissance de l’ensemble du processus de photoconversion se fait grâce à l’oscillation coordonnée des électrons et noyaux atomiques, un comportement que les physiciens appellent la cohérence quantique, sans laquelle il n’y aurait pas de transfert de charge ni de courant électrique. Nous estimons que ces résultats peuvent guider la construction de nouveaux matériaux artificiels capables de convertir la lumière solaire en énergie avec une efficacité maximale. »

Source : bulletins-electroniques

Afin de réduire les risques et les coûts engendrés par le changement climatique et pour atteindre les objectifs climatiques fixés par le Groupe Intergouvernemental d’Experts pour le Climat (GIEC), des technologies aujourd’hui controversées peuvent s’avérer nécessaires. La combinaison d’une production d’énergie à partir de combustibles fossiles et de biomasse avec la capture et le stockage du dioxyde de carbone émis (CCS) pourrait être une technologie clé pour respecter la limite d’un réchauffement maximal de deux degrés. C’est ce que montre l’étude la plus complète sur les stratégies technologiques possibles pour lutter contre le changement climatique, qui a été publiée dans un numéro spécial de la revue Climatic Change. Pour cette étude, les simulations de 18 modèles informatiques d’une équipe internationale de chercheurs ont été examinées au Stanford Energy Modeling Forum (projet EMF 27).

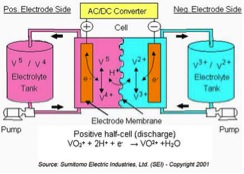

« Pour réduire les coûts du changement climatique, les technologies polyvalentes semblent être les plus intéressantes », explique l’auteur principal Elmar Kriegler, de l’Institut de recherche de Potsdam sur les effets du changement climatique (PIK, Brandebourg). La bioénergie tout comme le CCS peuvent contribuer à réduire les émissions liées à l’utilisation d’énergie non électrique, qui serait autrement difficile à décarboner. Dans l’industrie de l’acier, par exemple, la combustion du charbon de coke dans les hauts fourneaux pourrait être combinée avec le CCS ; dans le secteur des transports, les combustibles fossiles pourraient être remplacés par les biocarburants. « Les herbes et les arbres qui sont utilisés pour la production d’énergie à partir de biomasse, consomment du CO2 pour leur croissance. En combinaison avec le CCS, du CO2 peut donc être retiré de l’atmosphère pour compenser les émissions qui se produisent inévitablement dans certains secteurs et ne pourront être évitées qu’à long terme ou partiellement », explique M. Kriegler.

Un grand nombre de simulations effectuées dans le cadre de l’étude ne permettaient d’atteindre les réductions d’émissions nécessaires à l’objectif de deux degrés sans l’utilisation de la bioénergie en combinaison avec le CCS. Dans d’autres simulations, les coûts du changement climatique dans les scénarios sans CCS ont en moyenne plus que doublé. Cependant, l’énergie produite à partir de biomasse peut entrer en concurrence avec le secteur alimentaire du fait des surfaces agricoles nécessaires, tandis que le captage et le stockage souterrain du dioxyde de carbone provenant des centrales électriques à l’échelle industrielle n’est pas encore testé.

L’étude a été en mesure d’établir l’électrification accélérée de l’utilisation d’énergie par les consommateurs comme un facteur robuste de transformation – par exemple à travers plus de voitures électriques ou des fours électriques dans l’industrie de l’acier. En outre, une augmentation de l’efficacité énergétique pourrait être considérée comme une autre stratégie importante pour soutenir la politique climatique, en permettant de réduire de moitié le coût du changement climatique. Cependant, sans mesures fortes pour décarboner la production d’énergie, une amélioration de l’efficacité énergétique seule ne serait pas suffisante pour atteindre l’objectif des deux degrés. « Notre étude donne des raisons de croire que nos stratégies technologiques pour atteindre les objectifs de la politique climatique sont disponibles », explique John Weyant, directeur du Stanford Energy Modeling Forum. « Toutefois, ces stratégies ne peuvent être efficaces que si les politiques climatiques efficaces sont très bientôt mises en oeuvre. »

Source : bulletins-electroniques

Le district autonome des Khanthys-Mansis-Iougra, situé en Sibérie occidentale, est une des régions russes les plus riches en pétrole. La moitié du pétrole de Russie produit actuellement est extrait de cette région. Pour mesurer la place stratégique de cette région dans l’économie de la Fédération, il suffit de rappeler que selon des données de Rosstat, agence fédérale des statistiques, la deuxième région extractrice, le district autonome Yamal-Nenets, située dans la partie arctique du pays, pèse seulement 7% du total. Les méthodes actuelles d’extraction permettraient d’extraire 3,8 milliards de tonnes de pétrole en Iougra. Néanmoins, il existe de nombreuses autres réserves de pétrole encore non exploitées. Des techniques innovantes, notamment de récupération assistée du pétrole, permettraient d’exploiter jusqu’à 10 milliards de tonnes de pétrole dans cette région. Les enjeux scientifiques et technologiques sont donc très importants.

Pour répondre à ces défis, la région Iougra a fait appel à l’Académie des sciences (RAN), avec qui elle a signé un accord de coopération. Les scientifiques russes apporteront leur expertise pour réévaluer les réserves de pétrole et pour développer des nouvelles méthodes de récupération du pétrole. L’université de Sourgout, plus grande ville du district, collaborera notamment avec la RAN sur les aspects de modélisation informatique des réserves de pétrole et de gaz à l’aide de superordinateurs. Il est également question de créer un centre de recherche et de formation sur ce domaine, en collaboration avec des entreprises comme Gazprom et Surgutneftegaz.

Il est également prévu l’ouverture à 275 km au nord-ouest de Sourgout d’un centre de recherche et de développement tourné vers l’application de nouvelles solutions d’extraction. Il s’agira de la première structure de recherche de Russie travaillant sur les méthodes d’extraction des pétroles non-conventionnels. De plus, la RAN engagera des projets de recherches en sciences humaines et sociales ainsi que sur les aspects environnementaux, mobilisant des disciplines comme l’ethnologie ou l’archéologie et portant en autres sur les langues et le folklore des peuples autochtones.

Les dirigeants de la région Iougra ont bien conscience du défi industriel à relever, notamment face à la concurrence mondiale croissante des pétroles non-conventionnels. Ils ont également conscience de la dépendance de leur économie régionale. La RAN mènera ainsi des études prospectives et formulera des propositions de diversification de l’économie locale

Source : bulletins-electroniques

Intégrer un capteur de pression de quelques millimètres dans des Smartphones ou des box, voilà une idée intéressante. A l’origine, des scientifiques américains s’intéressant à la précision des prédictions des phénomènes météo quand on intègre dans les calculs des données de pression issues des Smartphones des citoyens. L’étude a été menée au département des sciences atmosphériques de l’Université de Washington. Les chercheurs ont combiné les données provenant de 350 Smartphones aux 110 mesures du réseau officiel local. En comparant les prédictions avec et sans les données des téléphones, il est apparu que la prédiction la plus proche de la réalité de l’évènement choisi pour le comparatif, l’orage du 30 juin 2013 qui s’est abattu a Washington, est celle incluant les informations récoltées en plus grâce aux téléphones « civils ».

Le nombre croissant de Smartphones en fonctionnement pourrait donc servir pour alimenter les modélisations météos et les rendre plus fiables. Toutefois, avant d’en arriver à l’exploitation de ces informations, il est important de considérer la précision de ces capteurs. Les chercheurs américains indiquent que même si celle-ci peut se révéler insuffisante ponctuellement, ces erreur sont très largement compensées par la quantité de données traitées. Idem, les mesures erronées seraient facilement filtrables, toujours à cause de la masse d’informations dont est extraite une valeur moyenne qui sert de référence. Les mesures seraient donc fiables. Ce gain de précision serait toutefois limité aux zone à haute densité de population, soit principalement les zones urbaines.

Un de nos confrères de Slate.fr, Nicolas Baldeck, suggère d’exploiter aussi les box internet. En effet, leur démocratisation fait que de nombreux foyers en sont équipés, ce qui pourrait être la base d’un maillage de l’ensemble du territoire. Mais à ce jour, des doutes subsistent quant à la sensibilité de tels capteurs de pression à la chaleur dégagée dans les boitiers des boxs, que le capteur soit positionné à l’intérieur ou à l’extérieur.

Au-delà de ces considérations techniques surgit la problématique économique. Météo-France monnaye ses données météorologiques et ne sera peut-être pas ravie de partager ces chiffres avec les opérateurs téléphonique et fournisseurs d’accès à internet.

Par Audrey Loubens

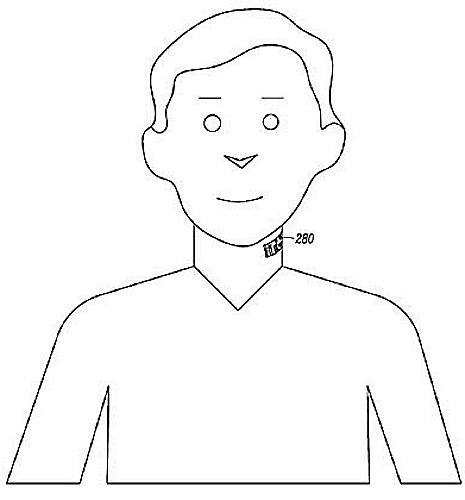

Ce tatouage d’un autre genre se place au niveau du cou, au plus proche des cordes vocales. Doté d’un circuit électronique, d’un microphone, d’un bloc d’alimentation et d’un mini-écran, son utilisation première sera de téléphoner. Exit le kit main libre standard, cette nouvelle génération de micro permettra de communiquer via Wifi, Bluetooth ou tout autre système de communication sans fil, ce choix n’étant pas encore défini. Le tatouage pourra être connecté à un Smartphone et pourquoi pas à des Google Glass. Motorola appartenant à Google, des liens entre ces produits sont très probables.

Quel est l’intérêt de ce tatouage connecté ? Tout d’abord, il s’agit d’un kit mains libres amélioré qui permet donc de téléphoner sans coller son téléphone à l’oreille. Mais surtout, il devrait permettre d’améliorer les communications. Positionné au plus près de la gorge de l’utilisateur, ce système diminue le rapport signal/bruit pour gagner en qualité sonore. Idéal pour les coups de téléphones dans les lieux bruyants comme les restaurants ou les bars. Plus proche d’un patch autocollant que d’un tatouage, ce système pourrait être alimenté en utilisant l’énergie solaire ou tout simplement être jetable.

Mais une deuxième fonction pourrait être envisagée, celle de la détection de mensonge ! Une application basée sur l’analyse du rythme cardiaque et des réactions épidermiques. Exactement comme les systèmes déjà existants. Cet usage n’est pas explicite dans le brevet déposé, mais est nettement suggéré puisqu’il y figure cette phrase: « Le tatouage pourrait inclure un détecteur de réaction cutanée. Il a été démontré qu’un utilisateur qui pourrait être nerveux ou qui raconte des mensonges montre des réactions cutanées différentes de lorsqu’il dit la vérité. »

Un tel système de communication pourrait toutefois avoir d’autres usages comme des applications médicales grâce à différents capteurs, pour les hommes mais aussi les animaux.

Alors, prêt à vous faire tatouer le cou ?

Par Audrey Loubens, journaliste scientifique

Un délai supplémentaire a été déjà été accordé, la date initialement prévue (février 2014) ayant été reportée au 1er août. Les entreprises n’ont donc plus qu’un mois pour se conformer à la nouvelle norme SEPA (Single Euro Payments Area).

Si la plupart des grands groupes ont déjà effectué cette migration, la majorité des TPE/PME tardent à franchir le cap. Pourtant, le passage à la norme SEPA implique de façon plus ou moins importante les différents services des sociétés (comptable, RH, commercial, informatique, juridique…).

Le SEPA s’applique aux virements et aux prélèvements nationaux et européens. Afin de mettre en place cette nouvelle norme, plusieurs actions auprès des différents partenaires sont indispensables.

Au-delà de l’obtention d’un nouvel identifiant bancaire (ICS), un code unique devra être attribué à chaque débiteur (RUM). Les mandats d’autorisation de prélèvements doivent être renouvelés sous la responsabilité du créancier.

Il est également nécessaire de s’assurer que l’ensemble des applications informatiques impactées par l’émission de prélèvements ou de virements soient compatibles avec la nouvelle norme SEPA. Des tests en interne et avec les banques sont à prévoir avant toute mise en place définitive.

La migration informatique des outils de gestion et des moyens de paiement qui doit être effectuée par les entreprises peut impliquer des investissements et des délais de mise en place parfois importants.

De plus, à défaut d’anticipation et de préparation avant le 1er août prochain, de nombreuses sociétés pourraient ne plus être en mesure d’effectuer de paiements, pas plus que d’en recevoir et mettre ainsi leur activité en danger.

Source : Baker Tilly France

Et aussi dans les ressources documentaires :

Jacques Michotte, expert en thermique industrielle, nous présente la formation Thermique industrielle : la combustion, qu’il anime chez Techniques de l’Ingénieur.

Pour débuter notre soixante-deuxième Revue du Web en douceur, jetons un œil à une installation épatante baptisée « For those who see », conçue par Daniel Schulze, un artiste allemand basé à Berlin. « For those who see » se propose de montrer la beauté de l’invisible à travers un réseau de sept par sept enceintes recouvertes d’un fin tapis de fumée, chacune des enceintes générant un petit anneau blanc à chaque impulsion qui leur est donnée – et donc à chaque fois qu’un son leur est jeté en pâture. Les vortex ont une durée de vie très limitée, de seulement quelques secondes, ce qui créé un élégant ballet éphémère d’anneaux de fumée.

Cette installation permet également de visualiser des signaux numériques, traduits par des anneaux uniques respectant une suite logique, notre perception visuelle connectant les vortex orphelins en un ensemble esthétiquement harmonieux.

Les robots imprimables – ceux que l’on peut assembler à partir de morceaux sortant d’une imprimante 3D – n’ont plus de secret pour Daniela Rus, sommité et chercheur en ingénierie électrique au prestigieux Massachusetts Institute of Technology (MIT). A la tête de son propre laboratoire depuis quelques années, elle s’est fendue d’une nouvelle petite trouvaille qu’elle a présentée lors de la Conférence Internationale sur la Robotique et l’Automatisation de cette année, organisée par l’Institut des ingénieurs électriciens et électroniciens (IEEE).

Le concept est simple : parvenir à mettre au point des composants robotiques imprimables en trois dimensions qui, lorsqu’ils sont exposés à certaines températures, se plient automatiquement en épousant des configurations tridimensionnelles pensées au préalable. Débutant avec une modélisation 3D de la forme que l’on souhaite obtenir, l’équipe de Daniela Rus utilise ensuite un logiciel de Conception Assistée par Ordinateur afin de décomposer le volume et en faire un origami, simplifié ou non. Il suffit alors d’imprimer en plastique ce modèle final, pour qu’il reproduise la forme initiale en se repliant sous l’effet de la chaleur. Que ce soit un humanoïde, une forme ovoïde ou encore le célèbre lapin de Stanford – un modèle de test utilisé dans le domaine de la synthèse d’image et développé en 1994 à l’université Stanford par Greg Turk et Marc Levoy, à partir du balayage laser 3D d’une figurine de lapin en céramique – la méthode semble marcher à merveille.

Le MIT veut même aller plus loin : le laboratoire de Daniela Rus travaille actuellement sur des extensomètres à fils résistants – permettant de traduire la déformation d’une pièce en variation de résistance électrique – qui laisseraient passer une quantité de courant variable en fonction de leur compression, ainsi que sur des bobines s’enroulant seules, parfaits actionneurs auto-pliants.

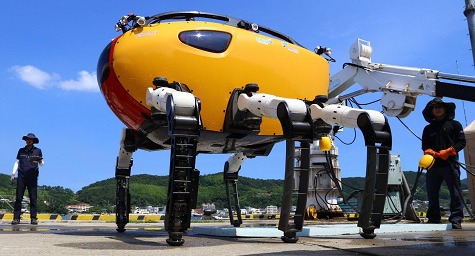

Le carnet rose de l’Institut Coréen des Sciences Océaniques a cessé d’être vierge. Nous pouvons désormais souhaiter la bienvenue à Crabster CR200, joli bébé de 635 kilos pour 2 mètres de haut, 2,42 mètres de long et 2,45 mètres de large. Derrière ces proportions éléphantesques se cache un monstre que n’aurait pas renié Jules Verne au moment de l’écriture de Vingt mille Lieues sous les mers.

Ses six pattes en aluminium recouvert de fibre de verre lui accordent une résistance et une posture qui devrait lui permettre de supporter des courants qu’aucun plongeur ne pourrait décemment affronter. Les deux pattes avants possèdent chacune une pince pouvant collecter des objets sur place, et lui assurant à la fois stabilité et une plus grande manœuvrabilité.

Un câble de 500 mètres de long permet aux opérateurs humains de contrôler ce crabe/homard robotique à distance, câble véhiculant également les informations collectées en profondeur par le robot coréen. Car il faut pas moins d’un pilote pour le diriger et assurer sa posture, un copilote pour les pinces, et plusieurs autres opérateurs pour superviser la collecte des informations. Et le moins qu’on puisse dire est qu’il est équipé pour : dix caméras HD mobiles dont une capable de filmer ce qu’il se passe à l’extérieur comme à l’intérieur du robot, à des fins d’inspection ; une caméra acoustique utilisant les ondes sonores pour générer des images en eaux troubles, et ce jusqu’à une distance de 15 mètres ; un sonar d’une portée de 150 mètres, capable de cartographier les fonds marins en trois dimensions ; un Doppler acoustique pour jauger la force et la direction des courants.

Présenté « nu » dans la vidéo, vous pouvez le voir avec sa carapace dans la photo qui suit :

Après la carte de visite la plus cool du monde, que nous vous présentions déjà ici (//www.techniques-ingenieur.fr/actualite/web-thematique_89430/revue-du-web-58-les-videos-etonnantes-de-la-semaine-article_199042/article_199042_1.html), Tetris n’en finit pas d’être revisité par toute une génération bercée par le thème aux forts accents russophones et par les cascades de pièces géométriques. Pour célébrer les trente ans du célèbre jeu culte, Mark Kreger a également tenu à marquer le coup à sa manière. Armé de 128 diodes électroluminescentes, de quatre boutons physiques et quelques autres pièces imprimées en 3D, d’un microcontrôleur Arduino Uno, de quatre piles AA et d’un peu de patience, le bricoleur luxembourgeois est parvenu à customiser un T-Shirt pour le rendre… jouable. Le T-Shirt, qui ne sera pas commercialisé, donnera peut-être quelques idées à d’autres bricoleurs du dimanche.

Pour conclure notre soixante-deuxième Revue du Web, rien de tel qu’une fausse bonne idée dont la réalisation donne un résultat un brin… angoissant. Développé par la société britannique RoboThespian, le SociBot-Mini est un robot social qui semble, de prime abord, cumuler de nombreux points forts : il est capable de gérer la reconnaissance vocale et faciale, il est doté d’un système de synchronisation labiale, il maîtrise la synthèse vocale dans près de vingt idiomes, mais il est également capable de mesurer la profondeur de champ et de pister plus d’une dizaine de personnes à la fois, grâce à une caméra de type Kinect.

Le hic, c’est d’avoir voulu faire en sorte qu’il épouse les traits d’un ou de plusieurs de nos proches – si leur visage a été scanné au préalable – tel un alter-ego angoissant de ces personnes qu’on aime tant. Comme souvent, plus on veut pousser loin le réalisme et le mimétisme, plus le raté est grand… Destiné, entre autres, aux secteurs de la recherche et de l’éducation, SociBot risque de faire peur à plus d’une de nos chères têtes blondes.

Jugez plutôt !

En bonus cette semaine, partons à la découverte du travail de Theo Jansen, génial artiste néerlandais réalisant de sublimes sculptures cinétiques – œuvres contenant tout ou seulement quelques parties en mouvement. Connu pour ses gigantesques et quelque peu effrayants myriapodes composés de légers tubes en plastique ainsi que d’une voilure leur permettant de se mouvoir au gré du vent, il s’inspire de la théorie de l’évolution génétique pour faire évoluer ses sculptures. En véritable Frankenstein de l’art cinétique, il se retrouve à la tête d’une petite flottille de créatures mobiles quasi-autonomes. Du plaisir pour les yeux !

Par Rahman Moonzur

Les web crawler seraient les ouvriers du roi Google. La seule fonction de ces robots est de parcourir le monde, de lien en lien, et de collecter des ressources que sont les pages, les images, les vidéos… Cette récolte permet ensuite à Google d’indexer les pages du web. Cette façon de travailler n’est pas nouvelle. C’est ainsi que les fourmis recherchent la nourriture ramenée à la fourmilière.

Un article paru dans les Proceedings of the national academy of science of the United States of America met en evidence cette similarité. Les fourmis partent explorer leur environnement de façon aléatoire. Dès que l’une d’entre elles découvre de la nourriture, elle rentre au bercail, laissant sur sa route des phéromones qui permettront à ses collègues de rallier la source. Ainsi, d’autres fourmis vont se diriger vers le lieu où est situé l’aliment, chaque passage renforçant la visibilité de l’itinéraire. En parallèle, le chemin est optimisé par les fourmis. De la même façon, les robots d’indexation se promènent sur la toile et « […] utilisent des centaines de signaux pour trouver la réponse la plus efficace et précise à toute requête, comme la colonie de fourmis s’organise rapidement pour trouver le chemin le plus efficace pour aller à une source de nourriture, une fois qu’elle a été découverte » décrypte Jurgen Kurths, co-auteur de l’étude, dans The Independant. Ce dernier n’hésite pas à qualifier le fonctionnement collectif des fourmis comme meilleur que celui des robots de Google. Le géant américain appréciera.

Par Audrey Loubens

L’objectif de BeConnections est d’encourager les contacts et les échanges commerciaux entre les entreprises du monde entier en les connectant entre elles de manière totalement gratuite.

Ainsi par exemple, si une entreprise espagnole a besoin de trouver un partenaire commercial ou un client au Bangladesh, elle n’est pas obligée de le faire en dépensant une grande quantité d’argent et de temps en appels téléphoniques et en voyages : Grâce à ce nouveau type de réseau social à destination des entreprises, et à travers des moteurs de recherche permettant de filtrer des résultats par région ou par secteur, chaque entreprise peut se connecter directement à celles qui l’intéressent le plus, économisant ainsi beaucoup de moyen. Cela peut être un avantage déterminant dans le cas des PME, qui ne bénéficient pas des mêmes moyens que les grandes compagnies, mais pourraient ainsi profiter des mêmes opportunités de développement.

L’entreprise a été créée il y a à peine un an, en 2013, mais la plateforme est officiellement en ligne depuis tout juste deux mois. Malgré cela, BeConnections compte déjà parmi ses clients enregistrés des entreprises de plus de 20 pays, tels que la Chine, l’Inde, les Etats-Unis, la Grande-Bretagne, l’Afrique du Sud, l’Arabie-Saoudite, …et la plateforme continue de grandir jour après jour. Le pays le plus actif du réseau à ce jour est l’Espagne, où est établi le siège social de l’entreprise, avec une majorité d’entreprises des secteurs Média et Publicité ainsi que des sociétés de conseil. Parmi les autres pays comptant le plus d’utilisateurs de BeConnections on peut citer les Etats-Unis, l’Amérique Latine ou le Moyen Orient.

La toute jeune entreprise, récemment présentée lors de la Foire Internationale d’Algérie, a également été sélectionnée parmi plus de 10.000 projets candidats pour participer au Summit 2014, la plus grande foire européenne de l’internet, célébrée chaque année à Dublin.

Biocéramique, polyuréthane, microcapsules, capteurs, LED et fibres optiques, autant de composés qui sont désormais intégrés à des textiles. L’objectif ? Fonctionnaliser le support. Les vêtements ne sont plus simplement inertes mais tendent de plus en plus à devenir actifs. Parmi les nouvelles fonctionnalités, certaines sont dédiées à notre bien-être et notre santé.

Les hauts développés par Smartex sont équipés de capteurs permettant d’enregistrer les rythmes cardiaque et respiratoire ainsi que d’un GPS. Portés par des patients, ces t-shirt facilitent le suivi des interventions chirurgicales. Les informations sont envoyées en temps réel par bluetooth au médecin sur sa boite mail ou son Smartphone.

Le groupe néerlandais a eu l’idée d’intégrer des LED bleues à l’intérieur d’une couverture. La lumière bleue permet de traiter la jaunisse des nourrissons en détruisant la bilirubine, responsable de la couleur jaune de la peau de bébé. La couverture permet d’envelopper le bébé qui peut dès lors être pris dans les bras par ses parents par exemple. Il est aussi exposé de façon plus uniforme à la lumière, ce qui améliore le traitement de la jaunisse tout en protégeant ses yeux du rayonnement. Autre avantage, le personnel soignant ne se retrouve plus exposé.

L’entreprise française a développé des pastilles thermosensibles qui changent de couleur en fonction de la température ou de l’exposition aux UV. MySenses a donc placé des capteurs sur des chapeaux d’enfant ou sous forme de bracelets. Idéal pour surveiller l’exposition aux UV des enfants ou des femmes enceintes par exemple.

Médaillé d’or au concours Lépine, Jacques Casper est à l’origine de la technologie Gold Reflect’Line. Il s’agit d’une membrane en polyuréthane céramique, un matériau qui favorise la récupération musculaire. L’intégration des microparticules de cette céramique en partie composée de roche volcanique à l’intérieur d’un textile est à la source d’émissions d’infra-rouge lointain. Un rayonnement connu pour améliorer la circulation sanguine, réduire les spasmes musculaires ou encore éliminer les toxines.

Les cosmétotextiles de Lytess possèdent des microcapsules remplies de principes actifs amaigrissants. Ceux-ci sont libérés de façon progressive pour un effet amincissant, drainant, raffermissant… Au choix.

Fini les cabines de bronzage ! Pour avoir un teint de vacancier il suffit désormais de porter ses vêtements équipés de microcapsules gorgées d’huiles naturelles facilitant le bronzage. Ces substances sont libérées grâce aux mouvements du porteur et seraient actives jusqu’à 30 lavages.

Ces exemples d’applications utiles ou futiles témoignent de l’essor des vêtements intelligents, et ce dans différents domaines. Le secteur a d’ailleurs été identifié comme confidentiel mais offrant des perspectives de croissance importante. A tel point que le pôle de compétitivité des textiles et matériaux souples Techtera a labellisé en 2012 le projet R&D Texactiv’ dont l’objectif est le « développement d’une nouvelle génération de textiles fonctionnalisés avec une action durable sur le bien-être, la beauté et la santé. » et d’ « […] ancrer l’industrie française » sur ce marché émergent.

Par Audrey Loubens

Tout commence avec la décision de Kentzaburo Ōe de boycotter le Festival de littérature japonaise d’Aix-en-Provence dont il est l’invité d’honneur, afin de dénoncer les essais nucléaires français.

Claude Simon, soutenant la reprise des essais décidée par Jacques Chirac, réagit de façon violente :

«Vous avez cru devoir, il y a peu, manifester assez grossièrement votre hostilité à mon pays, où vous aviez été invité, en flétrissant les essais nucléaires auxquels celui-ci procède sur un petit îlot du Pacifique à des milliers de kilomètres de chez vous et d’autres pays. De multiples voix d’experts ont cependant affirmé que ces essais sont d’une parfaite innocuité sur l’environnement, tant terrestre que maritime ou humain. Au surplus, à qui fera-t-on croire sans rire que la France médite une guerre d’agression.»

Pour justifier sa position, Claude Simon revient sur les exactions commises par les militaires japonais pendant la deuxième guerre mondiale. Selon lui, la réaction de Ōe illustre la lâcheté et l’hypocrisie de son pays :

«On a complaisamment répandu (cela frappe l’imagination de ceux qui en sont dépourvus) les photographies des ruines d’Hiroshima ainsi que des pitoyables victimes souffrant encore, des années après cette catastrophe, de brûlures et d’affections cancéreuses découlant de la radio-activité. On n’a pas, par contre, montré les photos des populations japonaises contraintes au suicide par vos militaires à l’approche de l’ennemi, non plus celles des survivantes de ces femmes et de ces jeunes filles enfermées dans vos bordels militaires et dont l’équilibre psychique est au moins aussi estropié à jamais que peuvent l’être des corps par des brûlures ou des cancers. J’ai même lu (mais détrompez-moi si cette information est inexacte) que des « médecins » japonais auraient procédé sur des prisonniers de guerre américains (l’équipage, en particulier, d’un bombardier) à des « expériences » d’une impensable horreur dont on n’a connu l’équivalent que dans les camps d’extermination de l’Allemagne nazie, cette Allemagne d’où aujourd’hui, dit-on, provient une grande partie des fonds de financement de Greenpeace.»

Couverture du livre de Kenzaburo Ōe, Dites-nous comment survivre à notre folie ?

L’écrivain japonais, très choqué par les propos de Claude Simon, déplore le patriotisme de son homologue français qui, selon lui, l’empêche d’avoir une véritable conscience écologique :