Des avancées et des faiblesses…

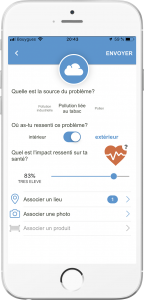

Afin de réduire l’exposition des populations aux produits chimiques à risque, la France s’est dotée d’une stratégie nationale sur les perturbateurs endocriniens (SNPE) en 2014. La dernière version de ce document, une SNPE2, qui définit le plan d’action pour la période 2019-2022, a été présentée aux membres du Groupe santé environnement, un groupe composé de professionnels de santé, d’associations et de chercheurs. Ce projet sera soumis à une consultation publique courant janvier 2019.

Parmi les mesures phares, la publication par l’Anses (Agence nationale de sécurité sanitaire de l’alimentation, de l’environnement et du travail) d’ici fin 2021 d’une liste de substances chimiques pouvant avoir des propriétés de perturbateur endocrinien (PE). L’agence, qui évalue actuellement cinq PE par an dans le cadre du SNPE1 devra expertiser 6 substances par an en 2019 et 2020, puis 9 par an à partir de 2021. Cette nouvelle version ajoute également la période pubertaire comme fenêtres de vulnérabilité aux PE. Le projet prévoit aussi une meilleure formation sur les PE des professionnels de santé et de la petite enfance (pédiatres, gynécologues, responsables de crèches, d’écoles) ainsi que des professions les plus exposées (professionnels de l’agroalimentaire, de la chimie, agriculteurs, vétérinaires, ingénieurs sécurité, architectes, urbanistes).

Néanmoins, certaines associations comme Génération Futures soulignent plusieurs faiblesses notamment dans le domaine crucial de l’alimentation (le manque de recommandations officielles incitant les femmes enceintes et les jeunes enfants à consommer des produits biologiques par exemple). Autre regret : la protection des populations vivant dans des zones à risques (riverains de zones cultivées) ne figure pas dans le projet de SNPE2.

Une dynamique nouvelle autour de la substitution

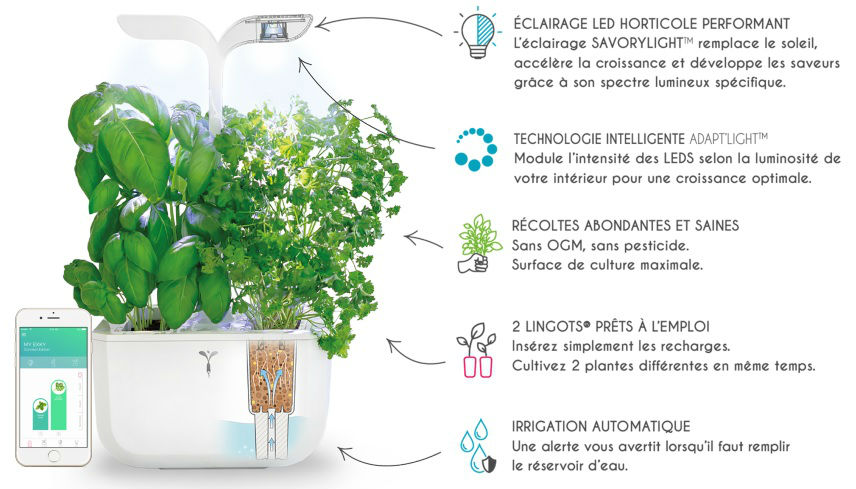

Au cœur de cette stratégie : la question de la substitution qui prévoit de remplacer les perturbateurs endocriniens par des alternatives non chimiques ou des produits chimiques alternatifs plus sûrs.

L’objectif est de recourir à des appels d’offres afin de financer des projets ambitieux pour explorer notamment la toxicité des substituants. Cette mesure, qui fait appel à des financements publics, suscite de vives critiques même si les ministres assurent que « la mobilisation des acteurs industriels est cruciale sur ce sujet ».

Le projet s’appuie sur une approche volontariste puisque qu’aucune obligation n’est imposée aux industriels. Ils seront simplement encouragés au retrait volontaire des produits contenant des substances PE ; une démarche décrite comme un “manque d’ambition” par Générations Futures.

Mais, surtout, pour l’association, la question de la substitution a été vidée de sa substance par rapport à la première version qui visait également la réduction de l’exposition à d’autres polluants chimiques. « Il n’est plus question de penser la substitution dans le cadre plus large du risque chimique, qui inclut d’autres pollutions (micro plastiques, nanoparticules, métaux lourds, etc.). » ce qui fait craindre à l’association que « la nouvelle stratégie abandonne l’objectif de développer une culture de la substitution généralisée des substances chimiques, en impliquant les acteurs de la recherche et les professionnels. »