Le BIM n’est pas une révolution, mais une évolution qui mobilise tous les acteurs de la filière BTP et impacte à la fois le fonctionnement interne des entreprises de construction et les relations entre les différents intervenants sur un même projet.

L’émergence du BIM est intimement liée aux nouvelles technologies. Les logiciels bien sûr, mais également les matériels permettant la capture et le transport des données. Cette caractéristique fait du BIM un concept et des méthodes en perpétuelle évolution.

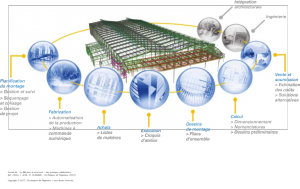

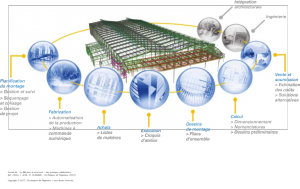

Le BIM concerne l’ensemble du cycle de vie d’un ouvrage. Il est, par conséquent, nécessaire de décrire l’usage du BIM et ce qu’il apporte tout au long des différentes phases d’un projet :

- la conception et le chiffrage ;

- les études d’exécution ;

- la fabrication et l’omniprésence du numérique utilisé historiquement pour l’automatisation de la production en construction métallique et en construction en béton préfabriqué ;

- la construction sur site et l’impact du BIM sur la relation étude/chantier. L’information doit circuler de façon bidirectionnelle. Le chantier accède aux données du modèle BIM et peut, entre autres, renseigner ce dernier sur l’état d’avancement du montage de la structure ou des phases de coulage du béton.

Le BIM s’adresse à tous les intervenants et à toutes les étapes.

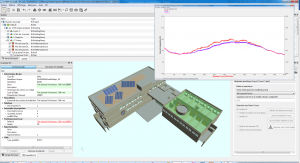

Le BIM change la façon de travailler des maîtres d’ouvrage en phase d’étude de faisabilité et de conception (délais de construction, critères financiers, performances énergétiques et environnementales, qualité des bâtiments) et des architectes (respect des normes en vigueur, gestion des modifications, visualisation de la maquette 3D, collaboration). Une fois la construction terminée, le modèle virtuel 3D est transmis au propriétaire de l’ouvrage avec toutes les informations nécessaires pour la gestion des installations, les travaux d’entretien et les modifications éventuelles. La maquette numérique est également utile en phase de déconstruction de l’ouvrage.

De la maîtrise d’ouvrage au constructeur, des commanditaires aux sous-traitants, un nombre important de sociétés peuvent collaborer et partager l’information autour de maquettes numériques. Il apparaît clairement qu’il n’y a pas qu’un seul BIM, mais différentes maquettes en fonction des phases du projet. La mise en place de méthodologies, l’utilisation de normes et de protocoles BIM internes aux sociétés sont indispensables pour une gestion optimale du projet.

BIM est un acronyme anglo-saxon qui signifie « Building Information Modeling ». Le M identifie dans certains cas « Model » ou « Management ».

En français, il est possible de le traduire en « modèle d’information du bâtiment » ou « modélisation de l’information du bâtiment », ou encore « gestion de l’information du bâtiment ».

Le terme de « maquette numérique » est également fréquemment utilisé en France.

Son origine

Le BIM ou la BIM est un concept relativement ancien. On attribue en effet la paternité du BIM à Charles M. Eastman, professeur au Collège d’Architecture et d’informatique de l’institut Georgia Tech. Ce dernier a travaillé sur le BIM fin 1970, début 1980. Charles Eastman est le co-auteur d’un ouvrage de référence publié en 2008 puis révisé en 2011, le BIM Handbook . Il a été un des pionniers dans le développement de logiciels de modélisation 3D paramétrique pour l’Architecture et l’ingénierie de la construction et a dirigé de nombreux projets de recherche depuis le milieu des années 1970.

Le développement du concept BIM va de pair avec l’apparition des logiciels de conception et/ou fabrication assistée par ordinateur CAO/CFAO 3D. Au début des années 1980, les premières solutions commerciales sont apparues.

Citons, comme exemple l’application ArchiCad (Éditeur : Graphisoft) pour la modélisation architecturale.

L’amélioration des performances des ordinateurs, la baisse de leurs coûts (PC) et l’usage d’interfaces graphiques interactives ont ensuite permis le développement de solutions dites 2D, puis 3D pour la filière construction.

Objectifs

La filière « Construction » au sens large n’est pas réputée pour son haut niveau de productivité. C’est une industrie qui fait (ou faisait) face à de gros problèmes de qualité. La maquette numérique est un des éléments de réponse à la non-qualité. La maitrise d’ouvrage a deux exigences : que les délais soient respectés et qu’il n’y ait pas de dépassement des budgets. Améliorer la qualité est très clairement l’objectif majeur du BIM.

C’est un énorme défi car le BIM est avant tout un changement d’attitude et un changement des habitudes

Maquette numérique

Le BIM est un processus de génération des données pour la conception et la construction d’un bâtiment et d’exploitation de ces informations sur le cycle complet de vie de l’ouvrage.

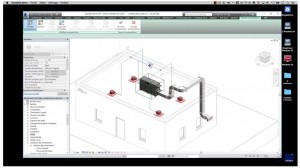

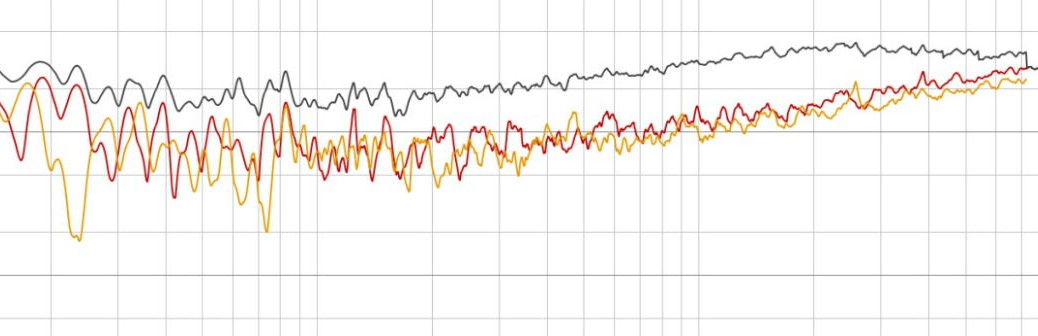

L’une des caractéristiques de l’approche BIM est l’échange autour de modèles virtuels de bâtiments créés numériquement. Ces modèles facilitent la conception, l’analyse et le contrôle en comparaison avec les procédures manuelles.

La forme la plus aboutie de cette démarche est le travail collaboratif autour de la maquette numérique qui peut être interne à une entreprise ou entre les différents intervenants dans la réalisation d’un projet.

Le BIM est un outil d’information puissant qui ne concerne pas uniquement le bâtiment mais également les infrastructures. Par conséquent, il existe différents formats de maquette numérique, depuis la représentation à l’échelle d’une ville facilitant la prise de décisions en termes d’aménagements urbains jusqu’à la modélisation d’un ouvrage complet incluant le détail des systèmes constructifs.

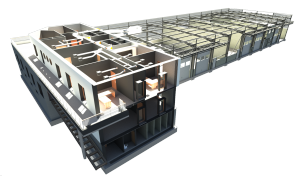

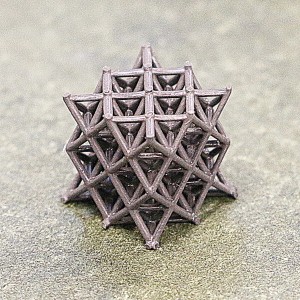

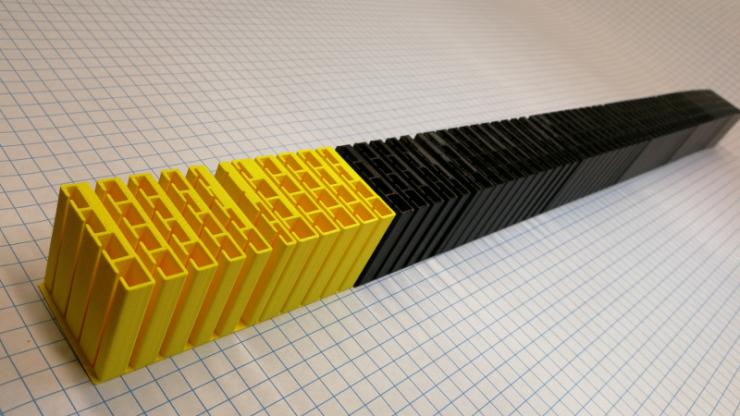

Dans le cadre du BIM pour la structure, un modèle virtuel 3D est composé de tous les objets et les assemblages d’objets utilisés dans le projet en cours.

Les objets BIM sont des composants uniques (poutre, voile, plaque, boulon…). Ils possèdent des paramètres pour la définition des caractéristiques géométriques (profil de l’élément, dimensions de la section, longueur…). La valeur de ces paramètres a une influence sur l’apparence physique des objets.

Ces composants peuvent également contenir, sous la forme d’attributs, les informations nécessaires pour les concevoir, les positionner, les spécifier et les analyser :

-

- matériau utilisé ;

- type de protection ;

- couleur d’apparence ;

- spécifications techniques du fabricant ;

- propriétés d’analyse ;

- classes d’exécution ;

- performance thermique ;

- durée de vie ;

- date de mise en fabrication et/ou de montage ;

- etc.

La maquette numérique ou BIM offre aux différents intervenants la possibilité de concevoir et de valider les choix à chaque stade d’avancement d’un projet.

Différents niveaux de développement pour la représentation des éléments de la maquette numérique (appelés « LOD » de l’anglais Level of Development) ont été adoptés au niveau international, depuis l’esquisse en phase de conception, jusqu’à la définition détaillée de l’ouvrage tel que construit.

La mise en pratique des outils et processus BIM ne fait que débuter. Les technologies vont évoluer et s’améliorer. Nous pensons en particulier aux technologies de scannérisation et de vectorisation des ouvrages. Les formats d’échanges s’améliorent également et de plus en plus d’applications seront certifiées IFC. Le risque existe néanmoins de voir s’imposer des formats natifs ou des plateformes collaboratives propriétaires. Cela nuirait grandement à la diversité des solutions et aux bienfaits de la concurrence. Des associations et initiatives gouvernementales agissent pour promouvoir des formats neutres et des pratiques dites OpenBIM. Nous pouvons citer et souligner les actions de Mediaconstruct (le chapitre français de buildingSMART International) et du PTNB.