Durée de vie et maintenance des routes

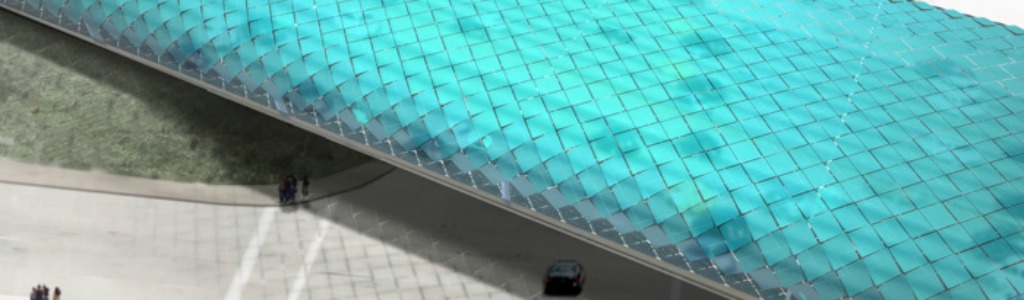

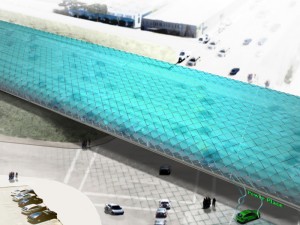

La toiture solaire protège la route des agressions météorologiques.

La route n’étant plus exposée au soleil, le bitume ne fond pas durant les périodes chaudes. Les agressions hydriques (érosion par ruissèlement) sont également éliminées. L’eau, absente, rend les périodes de gel moins dévastatrices. Les variations thermiques sont atténuées, réduisant ainsi les cycles de dilatation/contraction destructeurs. Et les très puissants Ultra-Violets sont stoppés.

La route n’étant plus exposée au soleil, le bitume ne fond pas durant les périodes chaudes. Les agressions hydriques (érosion par ruissèlement) sont également éliminées. L’eau, absente, rend les périodes de gel moins dévastatrices. Les variations thermiques sont atténuées, réduisant ainsi les cycles de dilatation/contraction destructeurs. Et les très puissants Ultra-Violets sont stoppés.

Selon les sites et les sources, le coût d’une autoroute 2 x 2 voies et d’une largeur roulable de 11 mètres coûte en France entre 5 et 25 millions d’euros du kilomètre, le haut de la fourchette concernant les milieux montagnards. Auquel s’ajoute des frais d’entretien annuels de 70.000 à 100.000 € par kilomètre. Pouvoir protéger une infrastructure aussi coûteuse a donc un intérêt majeur.

Il y a en France 7850 km d’autoroutes à péage, 1100 km d’autoroutes non concédées par l’état, 11 800 km de routes nationales, 383.000 km de routes départementales et 550.000 km de routes communales. En retenant une hypothèse de 85.000€/km, la maintenance des 8950 km d’autouroutes coûte 23 milliards d’€ en 30 ans. Dans l’hypothèse (bas de la fourchette) d’un coût d’investissement de 5 M€/km, elles pèsent 45 milliards d’€.

Le toit solaire peut s’étendre au-delà de la bande roulable, d’où une largeur retenue ici de 16 mètres. Ce qui, avec une longueur de 8950 km, correspond à une surface de 143 kilomètres-carrés. En retenant la même densité de puissance que la centrale solaire de Cestas (300 MW sur 2,6 km2, 115 W/m2), les autoroutes françaises, a elles seules, permettraient d’installer une puissance solaire PV d’un peu plus de 16 GW. Soit 2 fois et demi la puissance PV totale actuellement en place en France. Et on peut considérablement augmenter la mise en intégrant les routes nationales.

Sur la base de l’expérience belge susmentionnée, on peut retenir un coût d’environ 2,5€/W (tout compris) pour une centrale solaire en toiture d’autoroute, contre 0,8 €/W pour du PV classique au sol. Mais le surcoût d’1,7€/W peut être compensé par l’augmentation de la durée de vie de l’autoroute et la réduction de son coût de maintenance. 16 GW à 1,7€/W ce sont 27 milliards d’€. C’est 60% du coût d’investissement de l’autoroute. Autrement dit si la toiture solaire augmente d’un facteur 1,6 la durée de vie de l’autoroute, alors le coût de la structure porteuse est compensé. Et comme cette toiture diminue copieusement les frais de maintenance annuels l’équation économique devient encore plus favorable. Et c’est pas fini…

Qualité de l’air

La pollution de l’air en France, pays où le parc automobile est fortement dieselisé, coûte chaque année plus de 100 milliards d’euros. Deux fois plus que le tabac. Les autoroutes, dont le débit est très elevé, sont des sources majeures de pollution. Des routes de qualité, c’est-à-dire non dégradées par les agents météorologiques, ce que permet le serpent solaire, conduisent à une réduction de la consommation des véhicules de 7% selon une étude danoise. Grâce à une baisse de la résistance au roulement.

Le serpent solaire protège par ailleurs du vent, qui, lorqu’il est de face ou latéral, conduit également à augmenter de manière significative la consommation des véhicules. La résistance de l’air augmente avec le carré de la somme vitesse du véhicule + vitesse du vent. Un vent même de seulement 20 km/h s’opposant à un véhicule voulant maintenir sa vitesse à 110 km/h conduit à un très copieux surcoût énergétique.

L’effet d’îlot urbain est atténué grâce à notre ophidien photovoltaïque. Le fait de rouler à l’ombre conduit à une baisse des besoins en climatisation, et donc à une diminution de la consommation en carburants pétroliers. Et aussi à une diminution du risque de surchauffe du moteur. Si la France est principalement concernée durant la période estivale, une bonne partie de la population mondiale, de l’Egypte au Brésil en passant par l’Arabie Saoudite et l’Inde, vit dans des régions qui sont ensoleillées et chaudes toute l’année.

Un serpent solaire au niveau des 35 kilomètres du périphérique parisien aurait un intérêt pour la santé de l’ensemble des riverains : la pollution particulaire a un en effet des conséquences particulièrement graves lors d’un temps d’exposition long. Celui des automobilistes est bien plus court. Et ce sont ces derniers la source de la pollution. Pollueur, payeur. De nombreux constructeurs proposent par ailleurs aujourd’hui des véhicules dont l’air de l’habitacle est contrôlé. Comme par exemple la Tesla X avec son mode « ». Mais aussi la Renault Zoé 100% électrique.

Des systèmes de filtration de l’air du même type que ceux qui équipent le tunnel du Mont-Blanc dans les Alpes (Autoroutes et Tunnel du Mont Blanc, ATMB) pourraient d’ailleurs être installés dans le tube intestinal du serpent et fonctionner avec l’électricité photovoltaïque. 90% des particules sont éliminées avec ce système.

Le léviathan solaire rend en outre possible la séquestration du CO2. La concentration en CO2 est naturellement plus élevée dans un tunnel. Måns Tham propose d’aspirer cet air enrichi et de l’envoyer vers où sont cultivées des micro-algues. Le CO2 est la molécule-clé de la photosynthèse. C’est exactement ce qu’avait fait Greenfuel, une start-up du MIT, en utilisant l’air riche en CO2 sortant d’une centrale à charbon alimentant le campus. La structure porteuse du serpent solaire peut d’ailleurs être , matériaux qui constitue un puits de carbone.

« J’ai déjà fait des esquisses pour un serpent solaire au dessus du périphérique » a indique Måns Tham, joint par voie électronique, et interrogé sur la faisabilité de la mise en place d’un tel écosystème dans une grande ville française. Ce Suèdois particulièrement créatif a travaillé en 2010-2011 dans une agence d’architecture parisienne.

Qualité de l’eau

Le serpent solaire empêche l’eau de pluie de ruisseler sur les routes. « La pollution d’origine routière, liée aux émissions du moteur à l’échappement, à l’usure des véhicules, de la chaussée et des équipements de la route, constitue une pollution chronique qui affecte directement l’environnement de proximité via les eaux de ruissellement et les dépôts atmosphériques secs et humides » souligne une étude publiée dans la revue Vertigo. « Les milieux impactés sont les hydrosystèmes superficiels et/ou souterrains, l’atmosphère, les sols et les végétaux qu’ils supportent. » Là encore, les conséquences économiques sont lourdes.

Grâce au serpent solaire non seulement l’eau n’est plus polluée, mais en plus elle peut être collectée, stockée, et ainsi être utile pour les activités agricoles du voisinage. Avec en outre une contribution à la réduction des risques d’inondation.

Réduction de la pollution sonore et sécurité routière

Le serpent solaire a encore une autre qualité : il empêche la propagation des ondes acoustiques. La pollution sonore peut lourdement affecter la santé et la qualité de vie des riverains des routes. Avec des conséquences physiques et/ou psychologiques (stress, dépression, violence conjugale, fatigue, arrêts de travail) pour les hommes et les femmes qui les subissent. Le coût économique est lourd. Les nuisances sonores ont également un impact sur la biodiversité. Certaines espèces d’oiseaux y sont par exemple très sensibles.

Protégeant du soleil et de la chaleur, et ainsi de la fatigue au volant, la peau du serpent peut vous sauver la vie ! Il évite de plus les éblouissements ainsi que l’usage des essuie-glaces. Empêchant la pluie de tomber sur la route, il prévient les aquaplanings mortifères ainsi que l’accumulation de neige verglaçante. L’hélio-reptile peut ainsi éviter de nombreux morts et blessés chaque année. Un tué sur la route coûte 1,2 million d’euros, selon l’Observatoire National Interministériel de la Sécurité Routière (2007).

Un support à l’innovation

Le serpent solaire pourrait servir à des applications complémentaires. Comme par exemple la charge par pantographe des camions transportant des marchandises, ce qu’expérimente par exemple le géant allemand Siemens en Californie. Il pourrait aussi servir de support à des capteurs utiles pour la conduite 100% autonome.

Le serpent solaire pourrait servir à des applications complémentaires. Comme par exemple la charge par pantographe des camions transportant des marchandises, ce qu’expérimente par exemple le géant allemand Siemens en Californie. Il pourrait aussi servir de support à des capteurs utiles pour la conduite 100% autonome.

En continuité de la dynamique lancée par Emmanuel Macron, Ministre de l’économie, des bus électriques autonomes (sans chauffeur), équipés d’un pantographe (ce qui permet de réduire de façon massive la taille de la batterie), pourraient ainsi être guidés par le serpent solaire et traverser la France entière. Le low-cost est bien sûr apprécié des voyageurs, et rouler sous une aile solaire qui capte en direct l’énergie de notre étoile permet de vivre l’expérience Solar Impulse des aventuriers suisses Bertrand Piccard et André Borschberg.

Des superchargeurs de type Tesla pourraient également être installés au niveau des aires de repos, en symbiose avec le serpent photonique, afin d’offrir de l’électricité photovoltaïque gratuite (avec éventuellement un soutien de l’état) aux véhicules électriques pratiquant le covoiturage de type BlaBlaCar.

Avec le serpent solaire, plus besoin d’installer de lampadaires pour l’éclairage (il suffit d’installer les lampes directement sous la peau du serpent), ni de supports de panneaux de signalisation routière, ni même de pylones de lignes à haute tension (y compris ). Une économie appréciable pour RTE et ERDF.

Des haies placées de chaque côté du serpent solaire permettront de le rendre complètement invisible dans le paysage tout en améliorant encore davantage son bilan carbone.

La route n’étant plus exposée au soleil, le bitume ne fond pas durant les périodes chaudes. Les agressions hydriques (érosion par ruissèlement) sont également éliminées. L’eau, absente, rend les périodes de gel moins dévastatrices. Les variations thermiques sont atténuées, réduisant ainsi les cycles de dilatation/contraction destructeurs. Et les très puissants Ultra-Violets sont stoppés.

La route n’étant plus exposée au soleil, le bitume ne fond pas durant les périodes chaudes. Les agressions hydriques (érosion par ruissèlement) sont également éliminées. L’eau, absente, rend les périodes de gel moins dévastatrices. Les variations thermiques sont atténuées, réduisant ainsi les cycles de dilatation/contraction destructeurs. Et les très puissants Ultra-Violets sont stoppés.