Génèse

Les sources du conflit coréen remontent au début du XXème siècle. A l’époque, la Corée est colonisée par le Japon dont les méthodes provoquent des révoltes durement réprimées. La Seconde Guerre Mondiale va mettre fin à l’oppression japonaise. La conférence de Yalta en 1945 dessine le nouvel ordre mondial et prévoit l’indépendance de la Corée. Dans les faits, la péninsule sera sacrifiée sur l’autel de la Guerre Froide, divisée en deux le long du 38ème parallèle. La partie nord est dirigée d’une main de fer par Kim Il-sung, allié des Soviétiques, le sud étant soutenu par les Etats-Unis. La péninsule sera l’un des théâtres de guerre indirecte entre les deux superpuissances. Entre 1950 et 1953, le conflit fait 2 millions de victimes civils et militaires et marque profondément l’esprit des survivants. La fracture entre Coréens, devenus frères ennemis, ne fera alors que grandir. La guerre se conclut sur un armistice et non un traité de paix ce qui implique que les deux pays sont théoriquement toujours en guerre. Une zone démilitarisée est tracée autour du 38ème parallèle pour limiter le risque d’embrasement. Mais dans les faits, les deux armées se font face et cette bande de terre détient le titre peu enviable de plus grande densité d’armes et de militaires de la planète…

La chute de l’empire soviétique en 1989 va laisser Pyongyang seul face à ce qu’il appelle « l’impérialisme américain ». La disparition de l’URSS a impacté durement l’économie nord-coréenne qui s’est progressivement recroqueviller sur elle-même. L’autosuffisance et la menace étrangère vont ainsi devenir les thèmes principaux de la propagande du parti.

Le péril extérieur

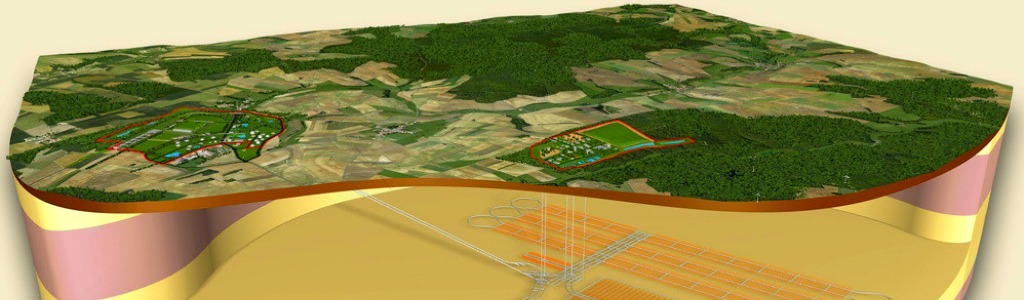

Le sentiment d’insécurité va être exacerbé par le régime afin d’asseoir son emprise et constituer une armée disproportionnée. Selon les experts, le pays aurait la quatrième plus grande armée du monde avec 1,19 million de soldats et officiers, mais également une réserve de 5,7 millions de miliciens, sur une population qui n’excèderait pas les 25 millions d’habitants. Très nombreuse, l’armée nord-coréenne est assise sur un stock d’armes impressionnant issu de la Guerre Froide. Pyongyang disposerait ainsi de pas moins de 6 000 blindés en tous genres, 21 000 pièces d’artillerie, plus de 500 avions de combat ou encore de 70 sous-marins ! Pour autant, ces matériels sont anciens (années 60) voire obsolètes. La capacité d’attaque de Pyongyang est donc relativement faible mais, Séoul, la capitale sud-coréenne est très proche de la frontière et reste donc vulnérable par l’artillerie lourde nord-coréenne souvent dissimulée sous terre, à l’abri de l’aviation américaine et sud-coréenne.

C’est dans ce contexte que Pyongyang a décidé de lancer à la fin des années 90 son programme nucléaire, seul à même selon Kim Jong-Il, fils de Kim Il-sung et père de l’actuel dirigeant Kim Jong-Un, de garantir l’indépendance du pays.

Objectif A

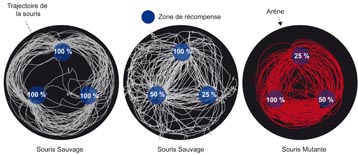

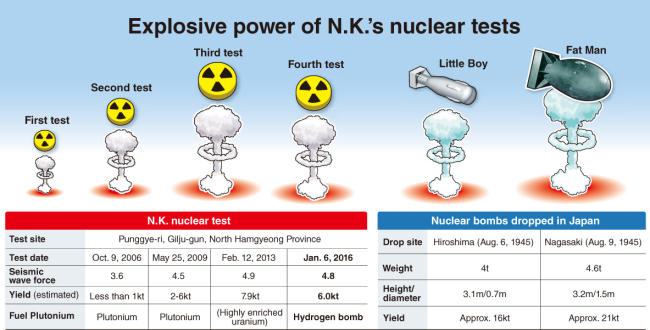

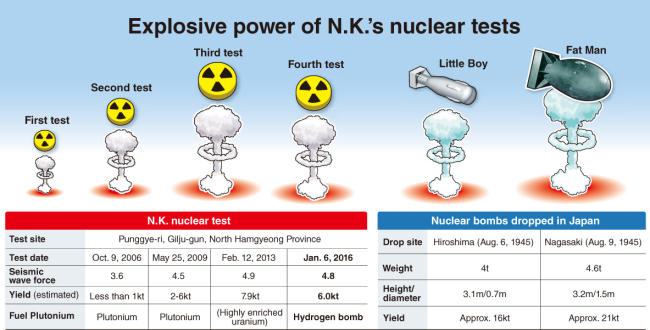

Le programme nucléaire nord-coréen est relativement récent. Débuté selon les observateurs en 1998, il répond au sentiment d’insécurité lié à la chute de l’Union soviétique. L’arme atomique, objet de dissuasion, devient la priorité du régime et un instrument de cohésion national. Au vu de la difficulté technique et technologique d’une telle entreprise, du peu de moyens du pays, et de l’avancée rapide de son programme nucléaire, des soupçons pèsent fortement sur le concours d’un réseau clandestin qui aiderait le régime. L’ingénieur Abdul Qadeer Khan, « père » de la bombe nucléaire pakistanaise, est l’un des suspects. Il faut dire que les progrès nord-coréens en physique nucléaire ont été anormalement rapides. Pyongyang a testé sa première bombe au plutonium en octobre 2006 créant une vague d’inquiétude dans la région. Des négociations sont engagées mais n’aboutissent pas. En mai 2009, la Corée du nord annonce l’essai réussi d’une deuxième bombe au plutonium, plus puissante. En février 2013, les scientifiques nord-coréens franchissent une nouvelle étape-clé en faisant exploser sur leur site de Punggye-ri une bombe alimentée en uranium enrichi, ce qui implique une possible maîtrise du procédé d’enrichissement. Enfin, le dernier en date, l’essai en janvier 2016 d’une bombe à hydrogène.

Des doutes

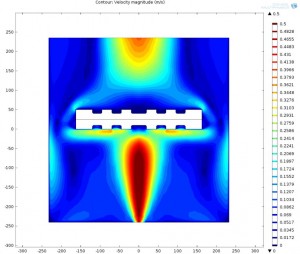

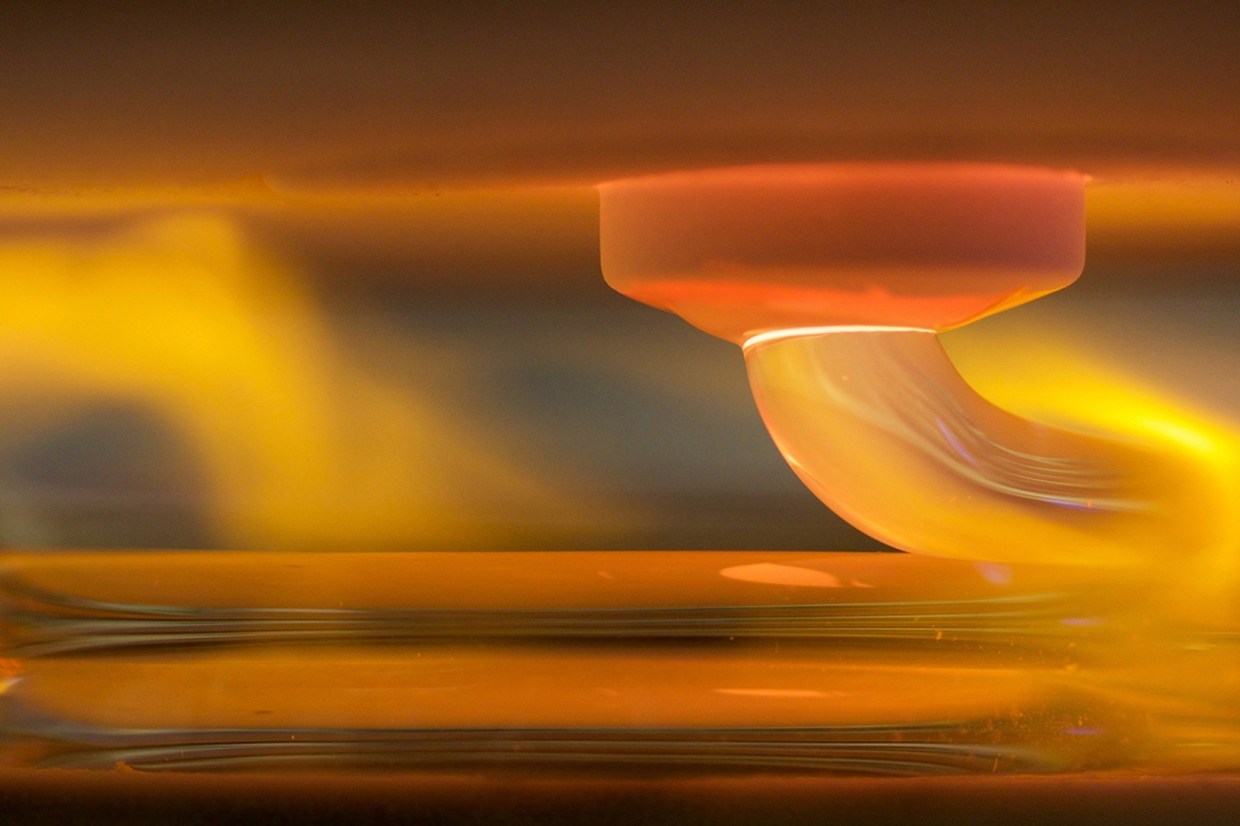

L’annonce de Pyongyang a surpris les observateurs internationaux. En premier lieu car la bombe à hydrogène représente un saut qualitatif majeur dans la menace que représente l’arsenal nucléaire nord-coréen. Contrairement à la bombe A (fission), la bombe thermonucléaire consiste en la fusion de deux noyaux légers (deutérium ou tritium), ce qui représente un défi technologique qui semblait jusqu’ici hors de portée du régime de Kim Jong-un. Ces engins sont généralement divisés en deux étages : le premier est celui d’une bombe A qui fait office de détonateur pour le second étage, constitué des combustibles de fusion. Une complexité qui fait douter certains experts en armement de la véracité de cette annonce. Les relevés sismologiques de l’agence américaine USGS font en effet apparaître des mesures de 5,1 sur l’échelle de Richter, soit sensiblement équivalent à ceux enregistrés en 2013 lors du 3ème essai de la bombe A. Or, une bombe à hydrogène est nettement plus puissante, le séisme enregistré aurait donc dû être plus important. Ce ne serait pas la première fois que Pyongyang use de la désinformation.

L’autre inconnue réside dans la capacité réelle des ingénieurs nord-coréens à miniaturiser la bombe présumée. Un pré-requis indispensable pour pouvoir l’installer sur les missiles balistiques Taepodong-2, d’une portée théorique de 4 500 km mais dont la maîtrise est encore imparfaite (2 tirs ratés sur 3). Par ailleurs, ces fusées restent encore très rustiques par rapport aux technologies anti-missiles développées par les Etats-Unis notamment. En revanche, la proximité de la Corée du sud et du Japon les rend potentiellement plus vulnérables.

Axe du mal

Face à la menace que représentait le développement d’un programme nucléaire clandestin, l’administration Clinton avait initié des négociations. L’élection de Georges W. Bush, et les attentats du 11 septembre 2001, ont radicalement changé la donne. La Corée du nord a été classée dans le fameux « Axe du mal », aux côtés de l’Irak et l’Iran, contre lequel Washington partit en guerre, au sens propre et figuré. La multiplication des essais nucléaires nord-coréens s’est traduite par le vote systématique de nouvelles sanctions au Conseil de sécurité des Nations-Unies, dont l’efficacité semble aujourd’hui bien maigre. Ces provocations ont durci un peu plus l’opinion publique du sud qui a porté au pouvoir en 2008 le parti conservateur, peu enclin à l’apaisement. Ainsi, les années 2010 se sont caractérisées par des provocations verbales des deux côtés, Pyongyang promettant « une mer de feu » à Séoul, qui s’en amuse en retour : « un chien qui aboie ne mord pas », se serait hasardé le ministère de la Défense sud-coréen. Cette tension a dépassé les simples mots en novembre 2010, lorsque le nord a bombardé l’île de Yeonpyeong, située dans une zone stratégique et très disputée. Elle est, depuis la fin des années 90, l’objet de nombreux accrochages entre les armées des deux pays, mais jusqu’ici, le conflit n’a jamais dégénéré. L’arrivée à la Maison Blanche de Barack Obama n’a guère changé la donne. Empêtré au Moyen-Orient, le président américain s’est concentré sur d’autres priorités laissant la situation coréenne pourrir un peu plus. De fait, les pays de la région poursuivent leur course aux armements.

Bombe à retardement

Si le scénario d’une confrontation directe et totale sur la péninsule coréenne est peu probable, l’attitude belliqueuse de la Corée du nord n’en reste pas moins problématique au regard de la situation régionale tendue. Historiquement premier allié du régime de Kim Jong-un, Pékin joue un jeu d’équilibriste. Le maintien de la menace nord-coréenne est utile car elle détourne en partie l’attention et les ressources de ses concurrents régionaux. Par ailleurs, Pékin craint l’effondrement du régime nord-coréen et des millions de réfugiés qu’il pourrait entraîner. Longtemps solidaire, la Chine a ainsi peu à peu pris ses distances avec le voisin coréen, jusqu’à voter des sanctions au Conseil de sécurité, elle qui n’hésite pas à opposer son veto lorsque ses intérêts sont menacés. L’attitude de la Chine est le deuxième facteur de tension régionale.

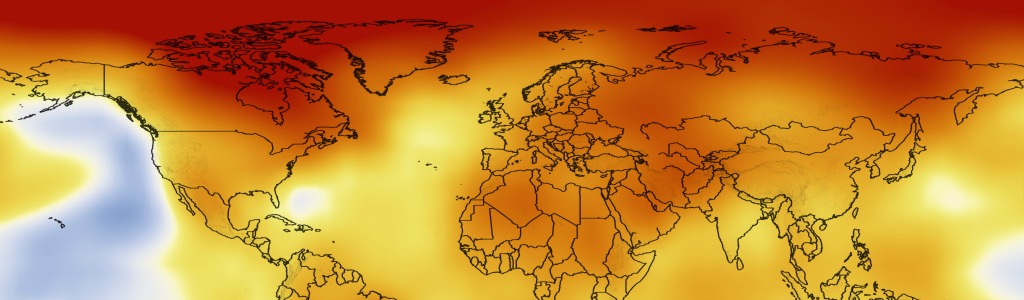

La montée en puissance de l’économie chinoise s’est accompagnée d’une politique étrangère visant à sécuriser ses approvisionnements en matières premières et les passages maritimes stratégiques (comme le détroit de Malacca). Cette stratégie s’est traduite notamment par le déploiement d’une grande flotte de guerre qui inquiète au plus haut point ses voisins et les Etats-Unis.

Mais le changement de paradigme majeur est sans aucun doute la remilitarisation du Japon qui, depuis la Seconde Guerre Mondiale, s’était interdit d’envoyer des troupes hors du sol nippon et avait délégué aux États-Unis la charge de protéger le pays. Une règle inscrite dans la Loi japonaise mais amendée par le Premier ministre Shinzo Abe, élu en 2012. Il s’agit là d’un tournant géopolitique majeur dans l’équilibre des forces. Les capacités technologiques de l’archipel devraient propulser son armée à la quatrième position des forces de la région. En 2015, le budget de la Défense japonais a atteint les 41,7 milliards de dollars, un record pour le pays et, le septième plus important au monde. Cette remilitarisation est justifiée par les Conservateurs japonais par la menace nord-coréenne et la politique marine active menée par Pékin. Le Japon entretient avec la Chine un contentieux territorial au sujet des îles Senkaku/Diaoyu en Mer de Chine orientale. Cette dernière inquiète ses voisins en raison de sa stratégie dite de « polders », en référence aux Pays-Bas, qui consiste à créer de toutes pièces des îles artificielles, en Mer de Chine méridionale, destinées à abriter des bases militaires.

En somme, le cas nord-coréen montre les limites du Traité de non-prolifération nucléaire, conclu en 1968, qui n’aura pas empêché plusieurs nations d’acquérir l’arme atomique (Israël, Inde, Pakistan et Corée du nord). Face à une Chine ambitieuse, on assiste au renforcement de l’alliance militaire tripartite issue de la Guerre Froide entre les Etats-Unis, la Corée du sud et le Japon. Une escalade militaire qui ne présage rien de bon.

Par Romain Chicheportiche