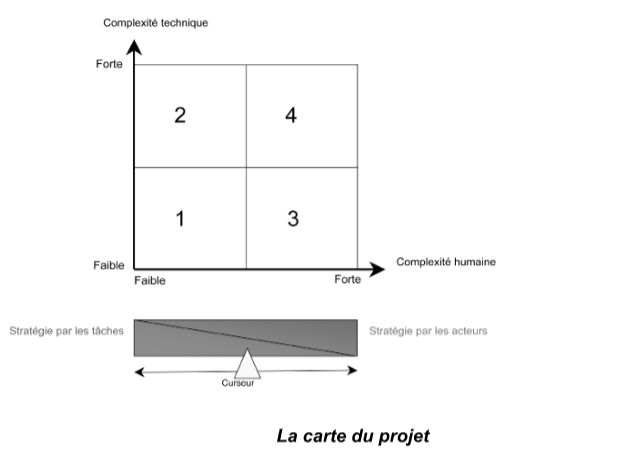

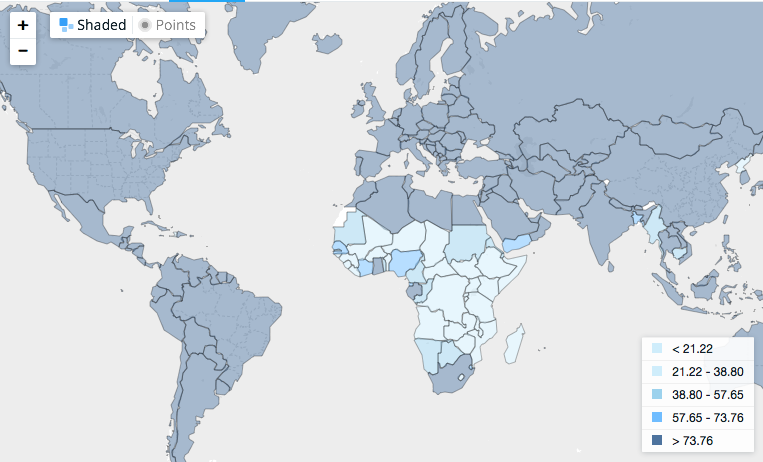

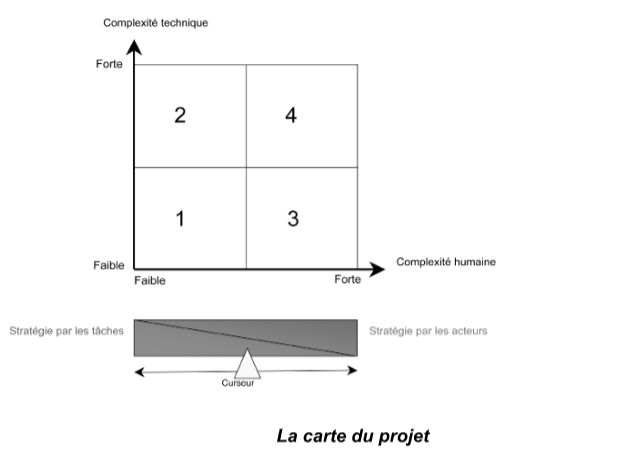

Caractériser le profil du projet

Le profil du projet se détermine à l’aide de la carte du projet. Cette carte est définie par deux axes : en ordonnée, l’axe de la complexité technique ; en abscisse, l’axe de la complexité humaine.

La carte du projet est divisée en quatre secteurs caractéristiques du profil des projets :

- Secteur 1 : Le projet est faiblement complexe techniquement et humainement. Projet sans difficulté particulière. C’est un projet de profil 1.

- Secteur 2 : Le projet est fortement complexe techniquement et peu humainement. C’est un projet un peu plus difficile à gérer qu’un projet de profil 1. C’est un projet de profil 2.

- Secteur 3 : Le projet est faiblement complexe techniquement mais l’est plutôt humainement. Ce type de projet demande plus de doigté de la part du chef de projet et une stratégie différente des deux premiers profils. C’est un projet de profil 3.

- Secteur 4 : Le projet est techniquement et humainement complexe. Ce type de projet est très difficile à mener. C’est un projet de profil 4.

Le profil des projets se situe sur une échelle de difficulté de 1 à 4. Cette échelle est plutôt du type exponentiel que linéaire.

Après avoir analysé la complexité technique et observé les acteurs au cours des deux premières étapes, le chef de projet synthétise ces informations sur cette carte. Celle-ci lui permet de caractériser le profil de son projet et de mesurer le degré de difficulté de son projet.

Conseil :

Faire baisser au maximum la difficulté de mise en œuvre de son projet. Pour ce faire, le chef de projet a tout avantage à découper son projet en plusieurs sous-projets de difficulté inférieure, si c’est possible bien entendu. À titre d’exemple, un projet avec un profil 4 est plus facile à mener en le découpant en un sous-projet « technique » de profil 2 et en un sous-projet « hommes » de profil 3.

Choisir la stratégie adaptée

Face aux caractéristiques du profil du projet, deux stratégies s’offrent au chef de projet :

- la stratégie par les tâches ;

- la stratégie par les acteurs.

La stratégie par les tâches se concentre essentiellement sur l’organisation précise des tâches. L’aspect humain est relégué au second plan. Seules la quantité et la qualité des personnes sont un sujet de préoccupation. L’enjeu principal est de définir dans le détail : chacune des tâches du projet, la personne qui la réalise et le temps qu’elle a pour l’exécuter.

La stratégie par les acteurs se focalise prioritairement sur les relations humaines. La façon de réaliser les tâches passe après. L’objectif principal se concentre sur les acteurs, qui font ou qui empêchent les tâches de se faire, afin d’en rallier le maximum à notre cause.

À la lecture de cette carte, le chef de projet en déduit la stratégie à adopter. Si le projet est de :

Profil 1 : L’utilisation de la stratégie par les tâches est totalement adaptée.

- Profil 2 : Là encore la stratégie par les tâches est juste.

- Profil 3 : Une approche différente des deux premiers profils est conseillée. La manœuvre employée est celle de la stratégie par les acteurs.

- Profil 4 : La stratégie par les acteurs est à adopter.

La stratégie par les tâches est principalement utilisée pour les projets qui ont un profil 1 ou 2. Pour les profils 3 ou 4, la stratégie par les acteurs est mieux appropriée.

Le fait d’avoir découpé un projet en plusieurs sous-projets permet de faire cohabiter les deux stratégies. L’objectif principal est de mettre en place un plan adapté et efficace.

Après avoir choisi la tactique adaptée au profil du projet, il est bon de la formaliser, dans un document. Le plan d’actions correspondant sert de fil rouge au chef de projet.

Conseils :

- Il est important de choisir la bonne stratégie en fonction de son projet.

- Appliquer une stratégie par les acteurs pour des projets de profil 1 ou 2 est une perte d’efficacité. Elle l’alourdit sans amener de contrepartie positive.

- Appliquer une stratégie par les tâches, sur des projets de profil 3 ou 4, est un risque majeur de déclenchement de conflits. La conséquence est de mettre une majorité d’acteurs dans le camp des « contres ». Le projet est alors dans une situation irréversible d’échec.

Valider la stratégie

Même si nous avons beaucoup parlé du chef de projet sur les actions précédentes, il n’est pas seul à travailler sur ces thèmes. Le commanditaire doit l’accompagner et le soutenir. À ce stade du projet, il est très important que le chef de projet et le commanditaire constituent déjà un binôme solide, il en va de la crédibilité du projet et donc de sa réussite.

Cette action permet de prendre du recul et de passer en revue chacune des tâches déjà étudiées. Le commanditaire et le chef de projet sont-ils en accord ? Y a-t-il des points à préciser ? Quelles sont les marges de manœuvre ? Cette stratégie est-elle cohérente avec la finalité du projet ? Le lien entre les méthodologies de conduite de projet et de management d’équipe projet est-il bien établi ? Les deux méthodologies sont-elles en phase ? Si certaines réponses à ces questions sont floues, il est bon de reprendre le travail et de clarifier les points nécessaires.

En validant la stratégie, le commanditaire et le chef de projet engagent individuellement et collectivement leur responsabilité. C’est un acte fort.

Conseils :

- Prendre le temps de faire cet exercice permet de créer du lien entre le chef de projet et le commanditaire.

- C’est l’occasion de mettre en œuvre, à l’échelle de deux personnes, certains concepts (développés un peu plus loin dans cet ouvrage) comme celui du développement d’une équipe performante par exemple.

- Les points essentiels de cette validation sont la finalité du projet et la stratégie à mettre en œuvre.

Mettre en œuvre la stratégie par les tâches

La phase de préparation, en amont des tâches de réalisation, est prépondérante.

Le chef de projet identifie l’ensemble des tâches de fabrication du produit objet du projet.

Pour se sécuriser, il analyse les risques inhérents à cette production et prend en compte un certain nombre d’actions préventives. Celles-ci correspondent au niveau d’assurance qu’il souhaite prendre. Plus le projet est innovant et plus il apporte un soin particulier à ce travail. Il intègre ces nouvelles tâches à la liste des tâches déjà définies pour la fabrication elle-même.

Le chef de projet détermine ensuite la durée et la charge de chacune des tâches. Il définit l’ordonnancement et les liens entre elles.

Il analyse les compétences nécessaires à l’accomplissement de ces tâches. Il recherche les individus qui possèdent les savoir-faire indispensables à la bonne réalisation de chaque composant du produit.

Parallèlement, il répertorie l’ensemble des ressources matérielles et financières nécessaires à l’accomplissement des tâches.

Le chef de projet individualise alors les objectifs en associant les réalisateurs, les moyens et les tâches élémentaires.

Une fois ce travail de préparation effectué, il lance la phase de fabrication. Pendant toute la durée de réalisation, son travail consiste à s’assurer qu’il n’y a pas de dérive entre ce qu’il a planifié et ce qui se passe réellement. En cas d’écart, le chef de projet réagit immédiatement pour revenir au plan de route prévu.

Comme nous pouvons le constater, le projet se gagne pendant la phase de préparation. Donc, plus la planification prévisionnelle est de qualité, les moyens humains, matériels et financiers à la hauteur des enjeux du projet et moins la phase de réalisation pose de problème. Le chef de projet, en utilisant la stratégie par les tâches pour des projets de profil 1 et 2, se donne un maximum de chance de réussite dans son entreprise.

Conseils :

- Mettre un maximum d’énergie du chef de projet sur la phase de préparation car c’est à ce moment-là que le projet se gagne.

- Ne pas lésiner sur les moyens humains, matériels et financiers.

- S’entourer des meilleurs experts métiers du produit à fabriquer.

- Ne pas hésiter à faire appel à un spécialiste de la planification si nécessaire.

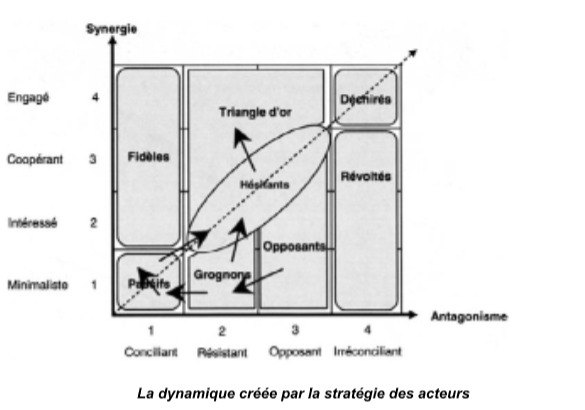

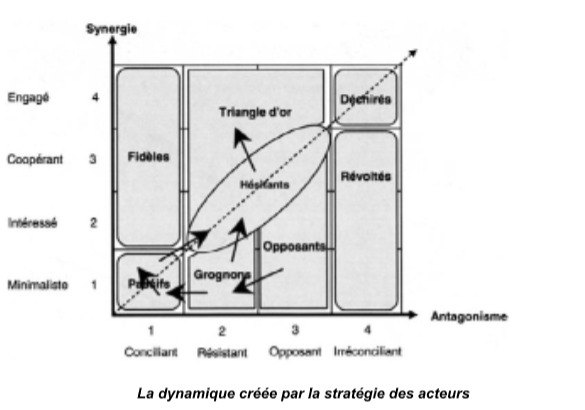

Mettre en œuvre la stratégie par les acteurs

Pour réussir cette stratégie, le chef de projet garde toujours en tête la finalité ultime du projet. Il se focalise en priorité sur les comportements des acteurs vis-à-vis du projet. Il dépense son énergie à rallier efficacement un maximum d’acteurs à la cause du projet. Le processus, pour réaliser les tâches, passe alors au second plan et les tâches, en elles-mêmes, viennent encore après.

Tout d’abord, le chef de projet identifie son premier noyau d’alliés. Il y fait entrer :

- Les triangles d’or car, même s’ils sont « pour » le projet, ils ne suivent pas aveuglément le chef de projet. Ils définissent souvent mieux que lui le meilleur chemin à emprunter pour arriver au but en évitant les chausse-trapes. Le chef de projet n’en prend pas ombrage car il donne priorité à la finalité du projet.

- Les hésitants potentiellement alliés. Ils sont les premiers acteurs à basculer dans le camp des alliés. Ils sont convaincus par les triangles d’or qui ont eu les mêmes doutes, à un moment donné, mais qui ont trouvé leurs propres arguments pour adhérer au projet. Ces arguments sont alors utilisés auprès des hésitants.

Nota bene : Les fidèles n’y entrent pas nécessairement car ils n’ont pas le recul nécessaire par rapport au projet pour voir les embûches potentielles.

Ce premier noyau formé, le chef de projet s’entretient individuellement avec chacun des membres. Il établit une synthèse des points positifs, des critiques et des conditions de ralliement. Il réunit le groupe à qui il présente cette synthèse ainsi qu’un projet remanié qui tient compte de celle-ci, tout en gardant la même finalité. Le projet n’est plus la solution du chef de projet mais devient la solution des membres du premier noyau d’alliés, cocréé à l’unanimité.

Le chef de projet accompagne alors ce premier noyau à s’engager sur ce nouveau chemin. Il donne suffisamment de visibilité à cette action et aux premiers résultats concrets obtenus par ces membres. Cela permet à l’ensemble des acteurs du projet d’en prendre conscience. L’objectif est de montrer que les premiers hésitants se sont ralliés au projet et ainsi encourager de nouveaux hésitants à venir rejoindre le groupe des alliés. Cette action a aussi pour but de faire passer les premiers passifs vers le camp des hésitants et ainsi créer une dynamique.

C’est le principe de la tache d’huile. De nouveaux résultats concrets, obtenus par les premiers alliés, encouragent de nouveaux acteurs à les rejoindre. L’objectif est de créer une dynamique collective suffisamment puissante pour que les passifs suivent le mouvement « naturellement ».

À partir du moment où les passifs se mettent à suivre les alliés, le projet est gagné. En effet, seuls les derniers opposants restent immobiles vis-à-vis du projet. À ce stade, ils n’ont plus d’autre choix que de se rallier ou de se démettre car leur énergie n’est plus suffisante pour contrecarrer le mouvement.

Conseils :

- Mettre l’énergie du chef de projet sur la création de la dynamique de groupe et de sa pérennité.

- Repérer individuellement les acteurs alliés qui alimentent cette dynamique collective.

- Voir les acteurs non pas comme une masse statique mais comme un groupe d’individus en mouvement que le chef de projet est capable d’orienter via les alliés.

- Appliquer la théorie de l’engagement. L’idée est de demander à des opposants au projet de s’engager par petites touches successives sur des actions concrètes sur lesquelles ils se sentent à l’aise. Ils finissent progressivement par adhérer au projet et devenir des alliés.

- La stratégie par les acteurs est tout sauf une stratégie de consensus mou (partiel). En effet, le premier noyau d’alliés coélabore le meilleur chemin à suivre en coresponsabilité, et donc en pleine unanimité consciente. C’est le gage d’une équipe performante qui tient dans le temps.

Points clés

- Quatre profils types caractérisent les projets en fonction de la complexité technique et de la complexité des relations humaines.

- Ces profils types donnent le degré de difficulté de réalisation du projet.

- Dans le cas d’un projet de grand degré de difficulté, essayer, si possible, de le scinder en plusieurs sous-projets. Le degré de difficulté de chacun d’eux est alors moindre.

- Caractériser le profil du projet permet de choisir la stratégie adaptée au projet.

- Les deux stratégies de base sont les suivantes : la stratégie par les tâches et la stratégie par les acteurs.

- Bien entendu, il est important de savoir positionner le curseur stratégique entre ces deux approches en intelligence de situation.

- La stratégie par les tâches privilégie la phase de préparation et plus particulièrement la planification détaillée des tâches et les ressources à mettre en œuvre pour les réaliser.

- Le processus et le contenu sont premiers dans le cas de la mise en œuvre de la stratégie par les tâches.

- La mise en œuvre de la stratégie par les acteurs se gagne en créant une dynamique collective, à partir d’un petit noyau d’individus choisis méticuleusement. Cette dynamique entraîne toutes les parties prenantes du projet. Le chef de projet laisse le premier noyau d’alliés codéfinir la meilleure route à suivre mais il garde en permanence le contrôle de la finalité ultime du projet.

- Le sens prime sur le processus dans le cas de la mise en œuvre de la stratégie par les acteurs.

Manager une équipe projet – 6e édition – 8 étapes et 12 livrables pour accompagner son équipe dans la réussite d’un projet

Auteur : Yves SOTIAUX

Éditeur : GERESO ÉDITION

Nombre de pages : 243

Date de parution : 12 octobre 2017