Epoustouflant: 2,99 cents le kWh ! C’est la meilleure des cinq offres que vient de recevoir l’opérateur DEWA (Dubai Electricity and Water Authority) de la part du groupe saoudien Abdul Latif Jameel associé à l’espagnol Fotowatio Renewable Ventures ainsi qu’au groupe Masdar (Abu Dhabi Future Energy Company). Ceci dans le cadre de la troisième phase de construction du parc solaire Mohammed bin Rashid Al Maktoum qui totalisera une puissance de 800 MW.

Annoncé par Saeed Mohammed AlTayer, le directeur de DEWA, ce record du monde en matière de compétitivité photovoltaïque permet de diviser presque d’un facteur deux le coût du solaire PV comparativement au deal de la seconde phase du projet réalisé il y a moins d’un an et demi.

La seconde offre la plus compétitive (3,69 cents) a été délivrée par JinkoSolar, géant chinois producteur de modules photovoltaïques polycristallins, tandis que la troisième (3,96 cents) émanait du saoudien ACWA Power en partenariat avec l’américain First Solar, l’un des leaders mondiaux du solaire à couches minces. Les deux dernières offres ont été proposées par deux géants français : Engie, ex-GDF-Suez (4,40 cents) et EDF (4,48 cents). Ce qui constitue « moins de la moitié du coût du très controversé projet de centrale nucléaire à Hinkley Point C » porté par EDF en Grande-Bretagne, constate non sans ironie le journaliste australien Giles Parkinson, fondateur du média de référence RenewEconomy.

A ce stade la DEWA étudie les offres sur le plan technique et commercial afin de sélectionner celle qui lui semble être la plus pertinente.

Un tsunami solaire des Emirats Arabes Unis au Mexique

La compétitivité redoutable du solaire observée aux Emirats Arabes Unis n’est pas un cas isolé. Au Mexique un contrat solaire PV (1000 MW) a été signé en avril 2016 à 3,60 cents par l’énergéticien italien ENEL Green Power. Auxquels il convient d’ajouter 0,50 cent selon Cédric Philibert, expert EnR de l’Agence Internationale de l’Energie, soit un total de 4,10 cents. Et le Français Engie a obtenu début mars 2016 un contrat à 4,85 cents au Pérou (40 MW). Aux USA les contrats s’établissent à présent autour de 3 cents explique le magazine en ligne spécialisé CleanTechnica, c’est-à-dire à 4,3 cents en intégrant la subvention fédérale du gouvernement américain (30%) dont bénéficie le solaire PV.

Le record de compétitivité à Dubaï (2,99 cents) s’explique en partie par un coût de la main d’œuvre modeste et par un ensoleillement optimal. Mais surtout par le fait que Masdar est liée au fond souverain d’Abu Dhabi (l’Abu Dhabi Investment Authority), ce qui permet d’obtenir des taux d’intérêts très bas, bien inférieurs à ceux que peuvent offrir les banques commerciales. Un projet solaire, c’est en effet essentiellement du capital (CAPEX). Contrairement aux centrales thermiques à flamme le coût du combustible est nul. Pour reprendre la formule de Jeremy Rifkin « le soleil n’envoie pas de facture ». Le niveau du taux d’intérêt impacte ainsi fortement le coût final du kWh.

Selon un expert du solaire PV appartenant à l’une des entreprises qui ont répondu à l’appel d’offre mais qui préfère rester anonyme:

« C’est en effet par le biais de Masdar, mais malgré tout ils devraient perdre quelques millions sur les 25 ans. Ils s’achètent une image pour les futures projet dans la zone. » Une affirmation difficile à vérifier. Ce qui est sûr c’est que l’offre la plus attractive, qui est ici critiquée, est 33% plus économique que l’offre la plus coûteuse. La compétition est rude.

En France le solaire PV est presque aussi bon marché que le nucléaire historique

Selon Richard Loyen, le président du syndicat des professionnels du solaire (ENERPLAN), le grand solaire PV au sol est à présent à 7 c€/kWh (8 cents) dans le sud de la France, un niveau proche de celui du coût du nucléaire historique déjà amorti (6 c€/kWh), et presque deux fois inférieur à celui du nouveau nucléaire (EPR). Ce coût deux fois plus élevé que celui observé à Dubaï est le fruit d’un ensoleillement moins généreux qu’en péninsule arabique, une main d’œuvre plus coûteuse et des taux d’intérêt bien plus élevés.

« Sur le marché de la fourniture d’électricité au réseau il y a aujourd’hui des appels d’offre dans le monde à 4, 5 ou 6 centimes d’euros. On est capable aujourd’hui de challenger le nucléaire, bien évidemment » et aussi les « nouvelles centrales à gaz et nouvelles centrales à charbon » a affirmé Richard Loyen sur BFM-TV le 1er mai 2016. « On est sur le trend de 100 GW par an qui seront atteints avant 2020 » a ajouté l’expert.

Face à cet effondrement vraiment massif et spectaculaire des coûts, même les solaro-sceptiques les plus endurcis sont aujourd’hui contraints d’admettre qu’ils ont eu tord. David Keith, professeur à Harvard, a par exemple déclaré récemment: « J’étais dans l’erreur concernant les limitations économiques de l’électricité solaire » (Greentech Media, 28 avril 2016). Cette évolution du monde de l’énergie a conduit les géants français ENGIE (sous la houlette d’Isabelle Kocher) et TOTAL (Patrick Pouyanné) à une réorientation stratégique profonde. Le solaire est bien entendu au cœur de cette révolution. Thierry Lepercq, cofondateur de Solairedirect, start-up rachetée par Engie en 2015, vient d’être promu Directeur Général Adjoint du géant français, en charge de la recherche & technologie et de l’innovation.

L’avenir des groupes qui, par idéologie ou faute de vision et de capacité d’anticipation, ont lourdement investi dans l’industrie du nouveau nucléaire est en revanche inquiétant, a fortiori quand de l’argent public est concerné : cette industrie ne sera désormais plus jamais compétitive avec celle du photovoltaïque. Tout tentative d’acharnement thérapeutique et de maintien sous respiration artificielle de cette filière du siècle dernier risque de conduire à un naufrage encore plus douloureux. AREVA a déjà commencé le plongeon infernal.

Le secteur du solaire PV n’est pas le seul à battre des records de compétitivité : un contrat éolien terrestre à 3 cents le kWh a été signé en janvier 2016 au Maroc. Abderrahim El Hafidi, Vice-Ministre de l’énergie et de l’environnement a estimé que ce contrat est « extraordinaire » et qu’il annonce une «vraie révolution ». Combiner solaire PV et éolien permet d’ailleurs de réduire les besoins en outils de flexibilité.

Prendre la bonne route

De son côté, Ségolène Royal, Ministre de l’écologie, a choisi de mettre en avant un projet de 1000 kilomètres de route solaire. La technologie Wattway retenue, développée par Bouygues-Colas, aura un coût qui sera très supérieur à 30 centimes le kWh selon Olivier Apper, conseiller énergie de l’Institut Français des Relations Internationales (IFRI). Il sera en réalité probablement supérieur à 100 centimes le kWh si l’on intègre l’inévitable écrasement du rendement et de la durée de vie des cellules photovoltaïques en milieu routier. Soit un coût d’ un ordre de grandeur supérieur à celui du grand PV au sol dans le sud de la France ! Dans une tribune intitulée « Route solaire : un magnifique coup de pub…A quel coût ? » Olivier Apper, non sans ironie, s’interroge : « la technologie peut presque tout, sauf inventer le moteur à eau. Peut-on dans ces conditions dépenser sans compter ? ». Président du Conseil Français de l’Énergie, une organisation membre du Conseil Mondial de l’Energie, cet expert souligne que « c’est le consommateur d’électricité qui paiera la note par le biais du mécanisme de la CSPE. Ce consommateur en est-il informé ?».

L’ingénieur Matthew Klippenstein y est allé aussi de son couplet dans une amusante tribune publiée le 26 avril 2016 dans le magazine de référence Greentech Media. Tout comme le journaliste Antoine de Ravignan dénonçant « un gouffre financier » dans une tribune intitulée « Routes solaires : une fausse bonne idée » et publiée dans le magazine Alternatives Economiques le 27 avril 2016. « Les éléphants blancs, ces gros projets inutiles et ruineux, ça trompe énormément (…) Avant de se lancer sur les routes électriques, il serait urgent de lever les obstacles mis en travers des énergies renouvelables qui roulent.». Clémentine Vaysse du journal marseillais indépendant MarsActu émet de son côté l’hypothèse que Ségolène Royal aurait été frappée d’un « coup de soleil ». Et la journaliste estime que « De scandale d’Etat à projet d’avenir, il n’y a visiblement qu’un pas. »

Avec ce projet Wattway porté par Ségolène Royal, « en France, on roule sur la tête » estime Oxygn, spécialiste du solaire PV cofondée par Marc Maionchi et Christophe Vanopbroeke. Basée à Marseille, cette PME a publié un excellent dossier de synthèse au sujet de la plus grande centrale PV d’Europe (300 MW) construite près de Bordeaux, dossier dans le cadre duquel sont révélés les très pervers bâtons dans les roues qui ont été placés volontairement par des fonctionnaires de l’état français : « un pays qui a l’art de cultiver les chausse-trappes pour les développeurs de centrales au sol (…) Tout est fait pour nous freiner dans notre atteinte de taille critique et d’optimisation du bilan financier. »

Aux Emirats Arabes Unis, en Inde, en Chine, en Afrique, en Amérique latine, aux USA, en Allemagne et en Italie, le futur est vraiment solaire. Au royaume de l’atome, on le cherche encore. Particulièrement lucide et bien informée l’avocate Corinne Lepage, fondatrice de CAP21 Le Rassemblement Citoyen, auteur du livre « L’état nucléaire » et ancienne Ministre de l’environnement, estime que « le nucléaire n’est plus à terme un atout pour la France, c’est un boulet ».

Olivier Daniélo

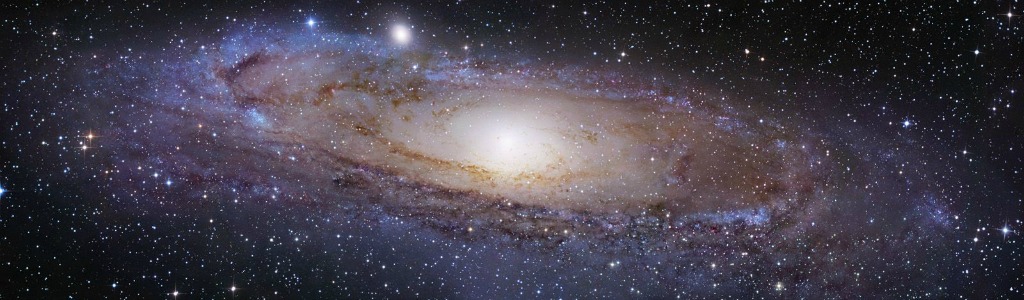

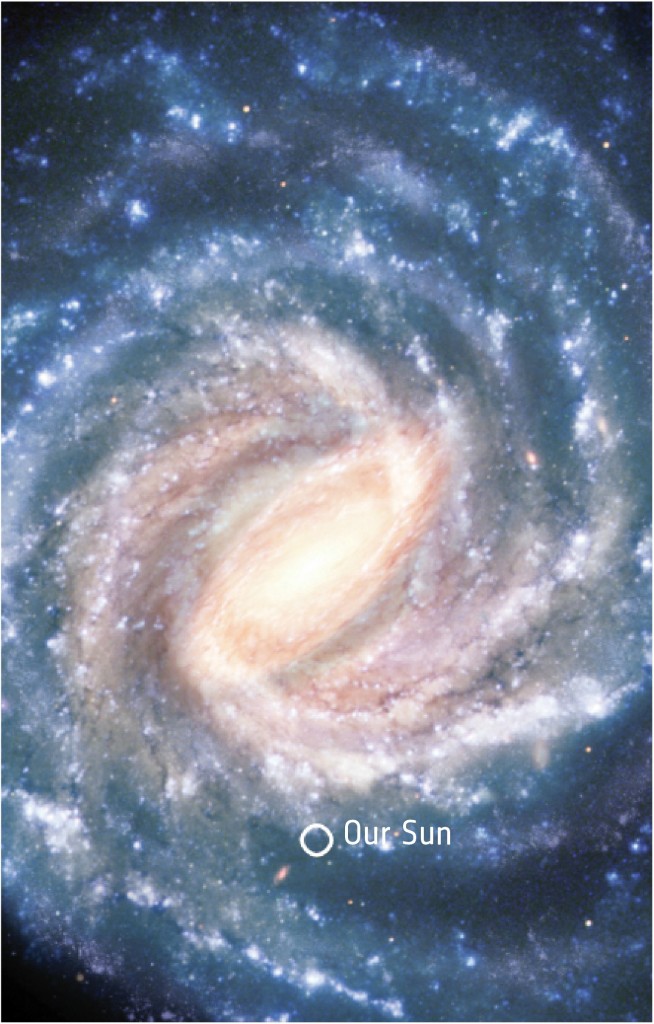

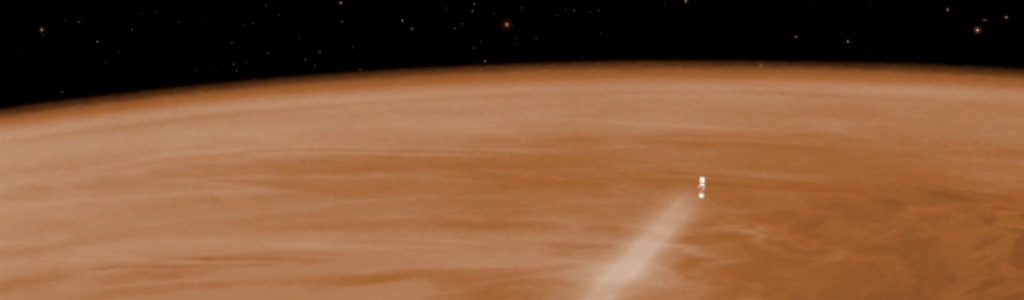

L’étoile 2MASS J23062928-0502285, maintenant rebaptisée TRAPPIST-1, est une étoile très froide (température de surface de l’ordre de 2500°C contre 6000°C pour notre Soleil) : 2000 fois moins brillante que le Soleil, elle est tout juste plus grande que Jupiter. De telles étoiles bien que couramment observées dans la Voie Lactée n’avaient jamais été vue en compagnie d’un système planétaire. Et pour Mickael Gillon, l’un des auteurs de l’étude, la découverte de planètes autour d’une naine est une aubaine car la faible luminosité de l’étoile permet de bien mesurer les effets du passage des planètes sur la lumière qui nous parvient. Avec les étoiles trop brillantes, cet effet est trop infime pour que nous puissions les étudier avec les technologies actuelles.

L’étoile 2MASS J23062928-0502285, maintenant rebaptisée TRAPPIST-1, est une étoile très froide (température de surface de l’ordre de 2500°C contre 6000°C pour notre Soleil) : 2000 fois moins brillante que le Soleil, elle est tout juste plus grande que Jupiter. De telles étoiles bien que couramment observées dans la Voie Lactée n’avaient jamais été vue en compagnie d’un système planétaire. Et pour Mickael Gillon, l’un des auteurs de l’étude, la découverte de planètes autour d’une naine est une aubaine car la faible luminosité de l’étoile permet de bien mesurer les effets du passage des planètes sur la lumière qui nous parvient. Avec les étoiles trop brillantes, cet effet est trop infime pour que nous puissions les étudier avec les technologies actuelles.