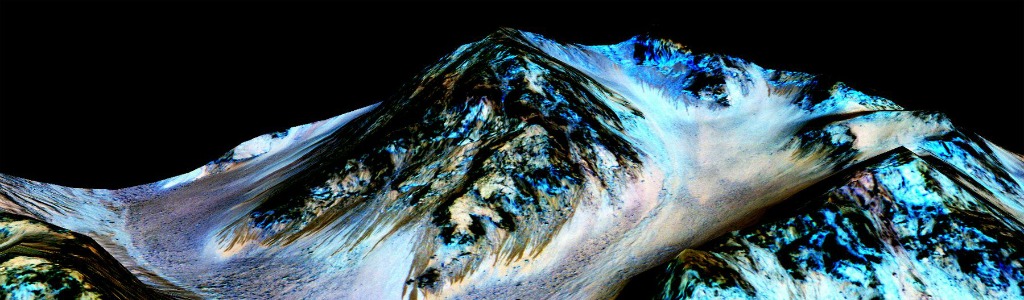

Ces longues stries sombres (voir photo ci-dessous) seraient la preuve de l’écoulement et de la descente d’eau sur les pentes de Mars.

« Ceci est terriblement excitant, confie James Green, directeur de la division des sciences planétaires de la NASA : Nous n’avons pas encore été en mesure de répondre à la question : « Est-ce que la vie peut exister au-delà de la Terre ? », mais la découverte d’eau est un élément fondamental pour pouvoir imaginer que oui, la vie peut exister ailleurs. Nous avons maintenant, je pense, de grandes possibilités, dans certains endroits que nous avons identifié sur Mars, d’approfondir de façon formidable nos connaissances. »

.jpg)

La volte-face de la NASA

Il s’agit d’un revirement complet de ton de la part de la NASA, dont les officiels concédaient régulièrement depuis des mois que le paysage triste et poussiéreux de Mars ne révèlerait très probablement pas quelconque trace de vie.

Mais cette semaine, John Grunsfeld, administrateur associé de la NASA, a évoqué l’envoi d’un vaisseau spatial dans les années 2020 vers l’une de ces régions, peut-être avec pour mission de détecter « sur site » toute trace de vie : « Je ne peux pas imaginer que ce ne sera pas une grande priorité de la communauté scientifique », a t-il commenté.

Il y a quelques milliards d’années, rivières, lacs et peut-être même océans étaient des habitués du paysage martien. Aujourd’hui pourtant, l’humidité y est modeste : quelques minuscules parcelles de terres humides, mais pas de flaque d’eau stagnante à la surface, par exemple.

Dans un article publié dans la revue Nature Geoscience, des scientifiques ont identifié des molécules gorgées d’eau : ce sont des sels (perchlorates) présents dans la trainée de l’orbite martienne. « Voilà une détection directe de l’eau sous la forme d’hydratation de sels », explique Alfred S McEwen, professeur de géologie planétaire à l’Université de l’Arizona, et investigateur principal des images provenant d’une caméra à haute résolution installée sur le Mars Reconnaissance Orbiter de la NASA : « Ce sel hydraté a été produit par une source d’eau, dans un passé récent, très récent. De l’ordre de quelques jours. »

Les scientifiques savent depuis longtemps que de grandes quantités d’eau restent – à l’état solide – dans les calottes polaires. Il y a eu quelques indices concernant la présence d’eau liquide mais rien d’assez convaincant jusque-là.

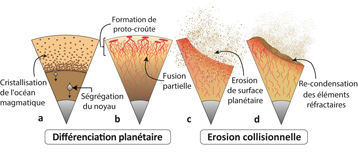

En 2011, le Dr McEwen et ses collègues ont découvert sur des photographies des stries sombres qui descendent le long des pentes des cratères, des canyons et des montagnes. Ces stries sont allongées pendant l’été, disparaissent quand les températures baissent et réapparaissent à la saison suivante.

Ces stries ont un nom : stries de pente linae, ou RSL. Des milliers d’entre elles ont à ce jour été repérées.

Les fameuses stries de pente Linae

Les scientifiques soupçonnaient depuis longtemps le rôle moteur de l’eau dans l’observation d’un tel phénomène. Mais comment le prouver ?

Lujendra Ojha, un étudiant de troisième cycle à l’Institut de technologie de Géorgie (Etats-Unis), se pencha vers un instrument dont dispose le vaisseau orbiteur qui récolte des données sur la planète rouge. Il s’agissait d’un spectromètre permettant d’analyser la couleur absorbée par les molécules pour mieux les identifier. Mais l’appareil, pas assez précis, ne permettait pas de certifier la présence d’eau dans les stries identifiées.

«Nous avons dû trouver de nouvelles techniques pour analyser la signature chimique des éléments que nous voulions analyser dans ces stries », résume Mr Ojha, l’auteur principal de l’article paru dans Nature Geoscience.

Les chercheurs ont ainsi réussi à identifier les signes révélateurs de la présence de sel hydraté à quatre endroits. De plus, ces signes ont disparu avec l’arrivée du froid, « ce qui nous permet d’affirmer de manière définitive aujourd’hui qu’il y a une sorte d’eau liquide sur Mars », conclue Mr Ojha.

En fait, les sels de perchlorate abaissent la température de congélation de l’eau, qui a donc tendance à rester plus longtemps liquide. Sur Mars, bien que la température moyenne soit de -70 °C, on atteint quand même, à l’équateur, en été, plus de 70 °C.

Cependant de nombreux mystères demeurent. A commencer par la provenance de cette eau. Les scientifiques ne le savent pas encore.

Le docteur McEwen résume les hypothèses : « l’eau ne peut provenir que de deux directions : le haut ou le bas. Le perchlorate pourrait agir comme une éponge, en absorbant l’humidité de l’air. Mais l’humidité mesurée en surface est très faible : à peine 10 microns de pluviométrie si toute l’humidité à la surface se transformait d’un seul coup en pluie ! »

Mais cette idée ne peut être exclue pour le moment, car la partie inférieure de l’atmosphère martienne pourrait se révéler plus humide que ce que l’on ne pense : « nos mesures de ces zones sont pour le moment très rudimentaires, concède ainsi le Dr McEwen. Il faut aussi envisager la présence d’aquifères souterrains, glacés durant l’hiver et fondant partiellement quand les températures se réchauffent, formant les RSL… ». Tout cela ne reste que conjecture à l’heure actuelle.

La problématiqeu de la stérilisation

L’eau liquide est considérée comme l’un des ingrédients essentiels à la vie, et sa présence soulève la question de savoir si Mars, qui paraît si sec et aride, pourrait posséder des niches d’habitabilité pour la vie microbienne.

Christopher P. McKay, astrobiologiste au Ames Research Center de la NASA, ne pense pas que les RSL sont l’endroit le plus prometteur pour faire des découvertes révolutionnaires : « l’eau liquide qu’on trouverait dans les RSL serait de toute façon tellement salée que la vie ne peut pas s’y développer. En termes d’habitabilité par contre, cela ne signifie rien. »

Sur terre, on connait l’étang Don Juan – dans l’arctique – qui reste liquide tout au long de l’année malgré des températures très inférieures à zéro. L’étendue accuse une salinité extrêmement forte due à la présence de chlorure de potassium. « Si vous allez dessus, ça ressemble à une belle piscine. Mais aucun organisme vivant ne s’y est jamais développé », précise le Dr McKay.

Même si les pentes lineae (RSL) sont pour certaines d’un grand intérêt pour les chercheurs, la NASA n’a pas l’intention de les investiguer de sitôt.

Ces espaces géographiques sont pour le moment considérés comme des régions spéciales que les explorateurs robotisés de la NASA n’ont pas l’autorisation d’approcher. En effet, les rovers n’étant pas totalement stérilisés, ils pourraient être vecteurs d’« autostoppeurs microbiens » terriens qui contamineraient Mars.

De toutes les sondes que la NASA a envoyées vers Mars, seules les deux sondes Viking en 1976 ont été « cuites » à des températures assez chaudes pour tuer les microbes de la Terre. Le prochain rover de la NASA qui partira vers Mars, et dont le lancement est prévu en 2020, ne sera pas propre lui non plus. Stériliser un engin spatial est très compliqué, car l’électronique embarquée supporte très mal la chaleur inhérente à un tel procédé. Cela pose également des problématiques insolvables en termes de design.

En choisissant le site d’atterrissage pour 2020, l’agence spatiale américaine s’est donc volontairement portée sur des endroits considérés comme non habitables en prenant soin d’éviter d’autres zones plus prometteuses, dont font partie les RSL.

Cette interdiction d’explorer va perdurer, alors que Curiosity est actuellement à moins de deux kilomètres du cratère Gale, où deux stries considérées comme prometteuses ont été identifiées.

Même si la NASA décidait d’y envoyer Curiosity pour voir de plus près ce qui se passe sans trop s’approcher, le trajet jusqu’au cratère durerait quelque chose comme… deux ans ! Pour le moment la possibilité d’un détour n’est pas exclue, la NASA se laissant le temps d’analyser plus en avant la situation.

Dans une interview suivant l’annonce de la NASA, le Dr Green – de la NASA – a déclaré que si les stries dans le cratère Gale s’avéraient être des RSL, l’agence spatiale envisagerait de se pencher plus précisément sur le risque de contamination réel posé par Curiosity. En effet, le rover martien est soumis aux ultra-violets depuis plusieurs années, et le risque réel de contaminer un habitat martien est aujourd’hui probablement infime : « Si nous pouvons aller en deçà de 20 mètres d’un RSL, nous pouvons utiliser le laser de Curiosity, et ainsi déterminer la nature de la roche en la vaporisant, grâce au spectromètre qui y est embarqué. Le mieux, évidemment, serait de pouvoir ramasser un fragment de RSL pour l’analyser, ça serait le top », conclut le Dr Green.

Traduit pas S.L

Source : New York times

Et aussi dans les

ressources documentaires :

.jpg)

.jpg)

.jpg)