Cette semaine dans la revue du Web :

- Rendre un essaim d’un millier de robots autonome : un jeu d’enfant ;

- Le robot origami qui se plie seul, avatar étonnant des « Transformers » ;

- Pépite : transmettre des données à l’aide de signaux de fumée ;

- Tout est possible à réaliser avec des Lego… même un afficheur sept segments ;

- Le gadget (inutile?) de la semaine : l’épouvantable épouvantail ;

- Et en bonus : le plaisir toujours jouissif de la destruction, à l’aide d’aimants.

Rendre un essaim d’un millier de robots autonome : un jeu d’enfant

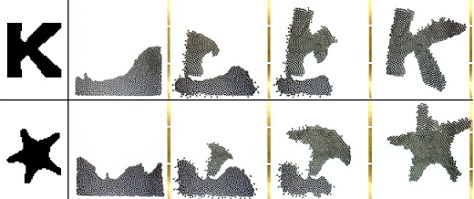

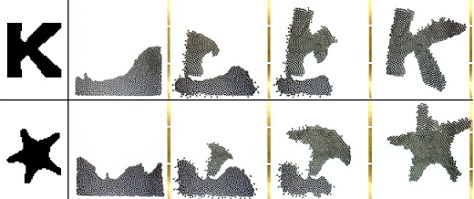

La prestigieuse université Harvard aurait-elle finalement succombé à la mode du flash-mob, alors que ce n’est plus qu’un lointain – mauvais – souvenir ? Rassurez-vous : l’institution américaine, qui peut se targuer d’être l’établissement d’enseignement supérieur le plus ancien et le plus riche des États-Unis, n’a pas cédé aux sirènes de la « mobilisation éclair », tout du moins pas de la manière dont on pourrait l’entendre. Pour débuter notre soixante-quatrième Revue du Web, voici « Kilobots », un essaim de 1024 petits robots simples et collaboratifs qui, à l’image des poissons se déplaçant en banc, ou des cellules d’un organisme qui s’assemblent en une structure sophistiquée et intelligente, sont capables de créer des formes complexes en suivant des règles de programmation basiques.

Chaque « Kilobot » est un monument de simplicité juché sur trois petites tiges qui font office de pattes : un petit moteur vibrant, un cavalier, une diode électroluminescente, une photodiode (en guise de capteur de lumière), un émetteur et un récepteur infrarouge, ainsi qu’un microcontrôleur pour la partie programmation et une pile bouton pour alimenter l’ensemble. Pour cette expérience inédite d’intelligence artificielle collective (tout du moins, à cette échelle), une équipe de chercheurs dirigée par le professeur Radhika Nagpal a développé un algorithme permettant aux robots de se déplacer afin de reproduire une forme prédéfinie, sans autre intervention humaine que le placement des quatre premiers robots « noyaux » pour ancrer la forme dans l’espace.

Placés de manière arbitraire, les robots de l’amas se mettent peu à peu en branle, en commençant par les extrémités et sans jamais s’éloigner de la masse. Pour pallier les situations difficiles ou les erreurs que les robots sont inévitablement amenés à commettre (« embouteillages », déplacements aberrants…), chaque Kilobot collabore afin de corriger les menus problèmes, transcendant ainsi les limites individuelles en une entité-groupe plus intelligente. Contrairement à l’effet de foule, l’union fait ici la force.

Le robot origami qui se plie seul, avatar étonnant des « Transformers » :

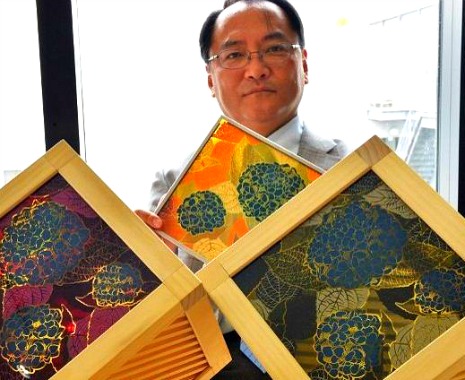

Comme ils ne chôment pas à Harvard, la nuée intelligente du millier de Kilobots n’est pas leur seul fait d’armes de l’été. Quittons le flash-mob robotique pour retrouver le monde créatif et autrement plus apaisant de l’origami. Un origami peut transformer une feuille de papier en formes tridimensionnelles complexes, alors que des techniques similaires de pliage peuvent produire à la fois des structures et des mécanismes pour le moins sophistiqués. Cette tradition japonaise de l’art du pliage du papier semble, au premier abord, ne rien partager avec le monde supposément froid et austère de la robotique. Pourtant, les chercheurs de l’institut Wyss pour la bio-ingénierie de l’université Harvard sont parvenus à créer une passerelle entre les deux univers.

Pour démontrer la possible application des techniques de l’origami à la fabrication de machines plus ou moins simples, l’équipe américaine a développé un robot rampant… qui se plie tout seul, et se transforme en un robot fonctionnel. Afin d’arriver à cette prouesse, les scientifiques ont développé un matériau composite à mémoire de forme qui se plie le long de charnières intégrées, se contractant comme un muscle une fois l’origami chauffé. Ce petit robot peut prendre forme en seulement quatre minutes, suivant une feuille de route bien précise – pliage des pattes extérieures, alignement du moteur, pliage du corps, redressement, pliage des pattes intérieures – avant de s’en aller en rampant, tout seul. Comme un grand. Quelque peu effrayant.

Pépite : transmettre des données à l’aide de signaux de fumée

Il est loin, le temps où les Indiens d’Amérique communiquaient à l’aide de signaux de fumée ? Niklas Isselburg et Jakob Kilian, deux étudiants de l’école Internationale de Design de Cologne, ont décidé de rendre hommage aux premiers occupants du continent nord-américain avec « Binairy Talk », un système ingénieux dépoussiérant cette forme de communication ancestrale. Ici, plus besoin de feu, ni de tissu pour le couvrir.

L’installation interactive est composée d’un module émetteur – un ordinateur, un haut-parleur, un générateur de sons et un autre de fumée– et d’un module récepteur – un réseau de lasers. Le message à transmettre est traduit par l’ordinateur en langage binaire, que le premier module va matérialiser en créant puis en propulsant une série de ronds de fumée vers le second module, qui va alors intercepter le « signal » dans son maillage laser. Pour décrypter les signaux, nos deux jeunes Allemands utilisent un module Arduino customisé permettant la traduction du message. L’installation, en plus de son côté hautement ludique, permet de rendre « physique » et de matérialiser les données, le plus souvent intangibles, créant ainsi une passerelle entre le monde digital et le monde analogique.

Tout est possible à réaliser avec des Lego… même un afficheur sept segments :

De vidéos en vidéos, nombreux sont les artistes, ingénieurs en herbe et bricoleurs du dimanche qui semblent crier, à l’unisson… que rien n’est impossible à créer à partir de Lego. Madeleine de Proust pour nombre de nos amis internautes, ils rivalisant souvent d’ingéniosité pour concevoir des choses aussi étonnantes et diverses qu’un clavier d’ordinateur, un variateur de vitesse mécanique, une imprimante 3D ou encore… une voiture. On peut se souvenir également de la merveilleuse horloge LCD conçue par le Suédois Hans Andersson.

Dans le même registre, un internaute a créé un afficheur sept segments – similaires à ceux présents dans les montres ou les calculatrices à affichage numérique – complètement mécanique et uniquement à partir de Lego. Fonctionnant sur le modèle d’une boite à musique, chaque segment est contrôlé de manière indépendante et ne peut prendre que deux valeurs (jaune ou noire, correspondant à « allumé » ou « éteint »). Bravo !

Le gadget (inutile?) de la semaine : l’épouvantable épouvantail

Mustafa Karasungur le répète à qui veut bien l’entendre : il en a marre. Marre de la météo peu clémente ? Marre de la politique conduite par le gouvernement ? Non, Mustafa Karasungur en a par-dessus la tête… des ours. Lassé par l’attitude inconvenante des ursidés de sa région, cet agriculteur turc de 46 ans a décidé d’employer les grands moyens afin de protéger ses récoltes et d’éloigner les grands mammifères de ses terres. Oui, mais comment faire ? Tout simplement… avec un épouvantail à ours spécialement conçu pour l’occasion !

Pour que l’épouvantail soit à la hauteur de son adversaire, l’agriculteur turc l’a équipé d’un pistolet à impulsion électrique, délivrant la bagatelle de 25 000 volts aux plus hardis des ours qui n’auraient pas déjà fui son bruit insupportable d’alarme de voiture, ou son aspect effrayant digne d’un film d’horreur à – très – petit budget. La journaliste ne semble, elle-non plus, pas rassurée devant notre gadget (inutile?) de la semaine. Ni devant tant de goût incertain.

Bonus : le plaisir jouissif de la destruction, à l’aide d’aimants

Pour conclure notre soixante-quatrième Revue du Web, pourquoi ne pas profiter de la puissance potentielle d’un aimant pour en faire une arme destructrice ? Ici, tout devient simple, on se trouve plongé dans le plaisir primaire et régressif de la destruction d’un verre à pied, de l’explosion de deux ou trois saucisses, de quelques néons, ou encore d’une banane. Les aimants permanents ne leur laissent aucune chance.

Pour rappel, un aimant permanent est souvent constitué d’un alliage de néodyme fer bore (structure cristalline tétragonale de formule Nd2Fe14B). L’alliage de néodyme fer bore est celui qui est le plus souvent utilisé pour les aimants en terres rares, car le néodyme augmente de manière significative les capacités électromagnétiques des aimants, mais est relativement fragile et trop malléable. On retrouve d’ailleurs de grandes quantités de néodyme dans les alternateurs des éoliennes à forte puissance.

Par Moonzur Rahman

.jpg)