Fukushima, nous dit-il en conclusion, « nous a offert l’opportunité de mener un vaste débat sur les défis auxquels sous sommes confrontés, au carrefour de multiples besoins humains : énergie décarbonée, sûreté, santé environnementale, sécurité des populations et préservation pour les générations futures. Ce sont là des questions qui définiront notre société humaine pour les siècles à venir. Nous ne devons donc pas rater l’opportunité d’en discuter en mettant sur la table tous les éléments dont on dispose. »

- Photo prise le 17 février 2015 : femme habitant un ensemble de logements provisoire couvert de neige à Aizuwakama, dans la préfecture de Fukushima. Ce complexe abrite des réfugiés nucléaires d’Okuma, une ville située à l’intérieur de la zone d’exclusion autour de la centrale nucléaire de Fukushima Daiichi de TEPCO (Tokyo Electric Power Co.) REUTERS/Toru Hanai

De multiples aspects de la crise continuent à affecter la santé de la population et la sécurité environnementale.

Au total, 178 000 réfugiés (dont 99 750 à Fukushima) ne savent toujours pas quand ils pourront rentrer chez eux. Chaque jour, 400 tonnes d’eau contaminée s’écoulent dans l’océan. Des pluies torrentielles balaient les matériaux radioactifs encore présents sur le site pour les déverser dans la mer. 814 782 tonnes d’eau contaminées sont stockées dans plus d’un millier de citernes et chaque mois, de nouvelles citernes sont mises en place. Les 7 000 travailleurs de la centrale accomplissent chaque jour des tâches dangereuses. Ces ouvriers qui prennent leur travail à cœur ont résolu jusqu’ici bon nombre de problèmes, mais certains problèmes continuent à mettre en difficulté les responsables et les équipes de nettoyage. Nul ne peut s’approcher des réacteurs 1, 2 et 3 en raison de l’intensité des radiations et il n’y a pas de solution scientifique à attendre pendant au moins 40 ans. Malheureusement, on ne peut pas exclure de nouvelles perturbations à venir : la probabilité d’un nouveau séisme important n’est pas nulle.

Depuis l’accident de Fukushima, nous avons eu la chance de recevoir rapidement des opinions et des recommandations de divers horizons. Physiciens nucléaires, médecins, militaires, sismologues, biologistes, océanographes, vulcanologues, journalistes, chefs spirituels, parlementaires, étudiants, organisations de citoyens et leaders d’opinion ont tous exprimé leur point de vue. La perspective horizontale qui a ainsi émergé a permis d’appréhender la situation d’une toute autre manière que si l’on s’en était tenu à une seule discipline, quel que soit le degré d’expertise du spécialiste. Les Japonais ont tiré profit de tous ces messages qui ont réussi à percer à travers la confusion régnant à l’époque dans les médias.

À l’occasion du 5è anniversaire de l’accident nucléaire de Fukushima, j’aimerais rappeler les premiers stades de l’événement et partager avec vous ma propre vision des choses et les recommandations tirées des leçons de ce douloureux événement.

Dans les deux premières semaines, les experts comme le public cherchaient des solutions techniques.

Est-ce que les cœurs avaient fondu ? Jusqu’à quelle distance fallait-il évacuer la population ? Comment maintenir les systèmes de refroidissement quand tant d’éléments ne fonctionnaient plus ? Les systèmes de ventilation marchaient-ils ? La situation était-elle pire qu’à Tchernobyl ? Les hélicoptères des Forces d’auto-défense pouvaient-elles arroser les piscines de combustible irradié des réacteurs 3 et 4 ?

Il est peut-être impossible de décrire précisément la panique qui s’est saisie alors des dirigeants et du public japonais. Les agences gouvernementales et l’opérateur chargé de la centrale, la Tokyo Electric Power Company, n’étaient pas préparés à une catastrophe nucléaire de cette ampleur. Le public les a accusés tous deux et eux se sont renvoyé la balle pour expliquer le manque de communication et les retards.

Confusion et panique n’étaient d’ailleurs pas limitées au Japon, mais ont aussi affecté le gouvernement américain. L’écart dans la manière dont les deux gouvernements ont évalué les dégâts des six réacteurs a été considérable, particulièrement en ce qui concerne le réacteur 4, qui se trouvait dans une situation unique, étant justement en arrêt pour maintenance. La confusion des messages sur la sûreté et les dégâts a encore accru la panique : le gouvernement japonais décidait que 20 km (12,5 miles) était la limite d’évacuation adéquate, tandis que le gouvernement américain fixait une limite de 80 km (50 miles) pour ses ressortissants. Le Royaume-Uni, la France, l’Allemagne et d’autres pays quant à eux recommandaient à leurs ressortissants de quitter Tokyo, qui se trouve à 200 km (125 miles) de la centrale.

Depuis le début, certains experts savaient que la crise dépassait largement les capacités techniques du moment mais que pour pouvoir avancer, il allait falloir plus d’information.

Très tôt au milieu de toute cette confusion, mon ami Hans-Peter Durr, depuis décédé, ancien directeur du département d’Astrophysique à l’Institut Max Planck en Allemagne, m’a appelé pour me suggérer d’informer le Premier ministre japonais que l’accident de Fukushima était bien pire que le gouvernement japonais ne l’avait laissé entendre. Quoique le Japon n’ait pas encore à l’époque admis la fusion des cœurs, Hans-Peter savait que Fukushima nous avait amenés à la limite de nos savoirs scientifiques. Il était d’avis que le Japon devait inviter une équipe d’évaluation indépendante formée des meilleurs physiciens nucléaires et ingénieurs structurels pour développer une solution. J’ai fait passer son message urgent au cabinet du Premier ministre et aux chefs de partis.

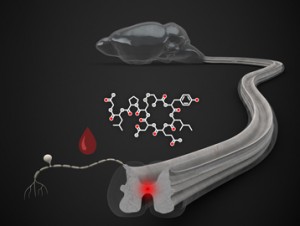

Quelle était l’ampleur du problème ? Un an après la crise et l’on n’avait toujours pas vraiment idée de l’importance de la situation. Une façon de commencer à réaliser ce qui se passait réellement était de savoir combien il y avait de barres de combustible irradié sur le site. TEPCO n’avait pas communiqué cette information et j’ai donc dû demander à l’Ambassadeur Mitsuhei Murata de se renseigner discrètement auprès de sources internes. Il nous a fait savoir que le total des assemblages de combustible irradié sur le site de Fukushima Daiichi se montait à 11 421, sans compter celles qui étaient contenues dans les cuves. J’ai ensuite demandé à Robert Alvarez, qui a été haut conseiller à la sécurité nationale et l’environnement au ministère de l’Énergie américain, d’expliquer l’impact potentiel de ces 11 421 assemblages.

Le 3 avril 2012, Bob a interprété ce chiffre pour nous. Les résultats étaient ahurissants : il y avait 85 fois plus de césium 137 entreposé à Fukushima que la quantité émise par l’accident de Tchernobyl.

Même si ce césium ne risquait pas nécessairement d’« exploser » comme une bombe atomique, une telle quantité de radioactivité avait un potentiel de destruction énorme. Les gens ont été choqués d’apprendre cela. L’article a rapidement été lu par plus d’un million de lecteurs et s’est propagé de manière virale sur la Toile. Il ne fait aucun doute que sans les avertissements des scientifiques internationaux sur le désastre potentiel représenté par le réacteur 4, le gouvernement japonais n’aurait pas fait une priorité de l’enlèvement des 1 535 barres [du réacteur 4], l’équivalent de 14 000 fois la radioactivité de la bombe d’Hiroshima.

Sans l’avis d’experts issus de domaines différents, des informations importantes seraient restées entre les mains du gouvernement et de l’opérateur nucléaire, plutôt que d’être communiquées au public.

Mais même compte tenu de ces informations, des pans entiers de la crise et de ses causes restent dans le noir si l’on s’en tient aux questions techniques. M. Kiyoshi Kurokawa, président de la commission d’enquête indépendante du Parlement japonais sur l’accident de Fukushima, présente une vision différente, mais très claire.

Le séisme et le tsunami du 11 mars 2011 sont des catastrophes naturelles dont l‘ampleur a choqué le monde entier. Quoiqu‘il ait été déclenché par ces cataclysmes, l‘accident de Fukushima Daiichi qui s‘en est suivi ne peut pas être considéré comme une catastrophe naturelle. Ce fut un désastre d’origine spécifiquement humaine ‒ qui aurait pu et aurait dû être prévu et empêché. De plus, ses effets auraient pu être atténués par une réponse plus efficace.

Comment un tel accident a-t-il pu se produire au Japon, une nation qui a une telle préoccupation de sa réputation d’excellence en ingénierie et en technologie? Cette Commission est d’avis que le peuple japonais ‒ et la communauté mondiale ‒ méritent une réponse complète, honnête et transparente à cette question. Ce qu‘il faut admettre, aussi douloureux soit-il, c‘est que nous avons à faire à un désastre « made in Japan ».

Les raisons fondamentales sont à chercher dans le souci des convenances qui fait partie intégrante de la culture japonaise : notre obéissance automatique, notre réticence à remettre en cause l‘autorité, notre attachement au « respect du programme », notre dépendance au groupe et notre insularité.

Personnellement, ce que je retiens de Fukushima, c’est que nous vivons entourés de nouvelles menaces et que ces menaces sont présentes depuis des dizaines d’années.

J’ai appris qu’un accident frappant une centrale nucléaire peut avoir des conséquences inimaginables sur la vie humaine durant des siècles. L’accident a causé des préjudices indicibles à ceux dont la vie a été bouleversée par la centrale. Si la situation s’était encore aggravée, quel aurait été l’impact de 24 000 années de dommage environnemental sur les générations futures ?

La situation aurait pu être acceptable si le public avait été conscient de ces risques et les avait acceptés quand la centrale a été construite. Malheureusement ce n’a pas été le cas au Japon. Même les responsables n’ont pas admis ces risques, que ce soit au moment de la construction ou au moment de l’accident. Et ils ne les admettent toujours pas, même maintenant.

Ce n’est que le mois dernier que TEPCO a admis, cinq ans plus tard, avoir mis deux mois à utiliser le terme de « fusion » sur le site de la centrale. Arnie Gundersen de Fairewinds et Mycle Schneider, auteur du Rapport sur l’état de l’industrie nucléaire, ont indiqué qu’à partir du moment où avaient eu lieu des rejets considérables de gaz de fission, il était évident que les cœurs étaient en train de fondre. Mais le déni de TEPCO a influencé la manière dont l’entreprise a géré la panique. Comme l’avait suggéré Helen Caldicott, il était évident que le gouvernement japonais aurait dû évacuer les femmes et les enfants plus tôt et les envoyer beaucoup plus loin. Helen a écrit pour notre blog cet article : Le sacrifice nucléaire de nos enfants : 14 recommandations pour aider le Japon contaminé par la radiation. En ignorant les avertissements de nombreux experts, TEPCO et les autorités gouvernementales ont refusé d’entendre l’appel à réagir.

Après cinq ans de réflexion, Fukushima m’a fait entrevoir de nouvelles inquiétudes à propos des centrales nucléaires.

L’accident de Fukushima m’a fait faire une découverte importante, à savoir que nous n’avions pas réalisé que les radiations causées par les bombes atomiques et celles de l’accident nucléaire sont très similaires en termes de risque pour la vie humaine. Nous avons longtemps admis les dangers d’attaques à l’arme nucléaire perpétrées par des États et aujourd’hui nous comprenons la menace que représentent pour les centrales nucléaires le danger de l’erreur humaine et les catastrophes naturelles, comme les séismes, les tsunamis et les volcans. Et si les centrales nucléaires devenaient une cible ? Je crains surtout la possibilité d’attaques terroristes contre des centrales nucléaires dans les pays instables, en particulier le Pakistan.

- Le Premier ministre Nawaz Sharif et le Président Xi Jinping se serrent la main : la Chine accepte de construire de nouvelles centrales nucléaires au Pakistan.

Il devient de plus en plus probable qu’un groupe terroriste décide de s’en prendre à une, voire plusieurs centrales nucléaires dans le monde. Ces centrales et nombre d’autres installations du même genre restent exposées à de multiples menaces et les gouvernements ont encore beaucoup de mal à partager les résultats de leur renseignement. Les États-Unis ne pourraient pas avertir le Japon, pourtant un proche allié, de certaines menaces, même s’ils le voulaient ! D’autres formes de menace nucléaire, par exemple un engin de la taille d’une petite valise qui exploserait à Times Square, continuent à donner des cauchemars aux experts et au Président. Étant donné le degré de probabilité de ces risques dans les années à venir, que nous vivions en démocratie ou sous un régime autoritaire, il est très surprenant de voir que le public n’a aucune information sur la question. Comme nous l’avons vu à Fukushima, une grande détresse provient de la réalisation soudaine qu’on nous a demandé de vivre avec des risques qu’on nous a cachés jusqu’au moment où il était trop tard.

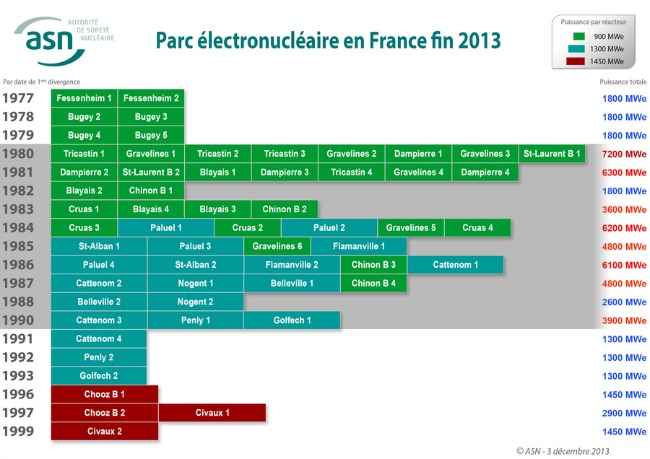

Les experts feront comme il se doit une grande partie du travail pour ce qui est de définir, étudier et recommander des solutions pour répondre à ces risques. Cette responsabilité augmente au fur et à mesure que de nouvelles centrales nucléaires sont construites et prévues, en particulier en Chine, en Inde, dans les Émirats arabes unis, au Vietnam et en Indonésie. Mais des échanges ouverts avec le public sont très utiles pour prévenir les attaques et les accidents et réagir de façon appropriée après coup. Les médias sociaux peuvent fournir un lien entre la société et les experts en divers domaines en cas d’accident ou d’attaque nucléaires. De fait, cela pourrait être un outil très intéressant pour compléter les efforts de ces autres organisations qui œuvrent à empêcher les catastrophes nucléaires. N’importe quelle autorité a du mal à accepter de perdre le contrôle de l’information, mais Fukushima et d’autres crises comme celle du virus Ebola ont bien montré les limites des canaux de communication venue d’en haut.

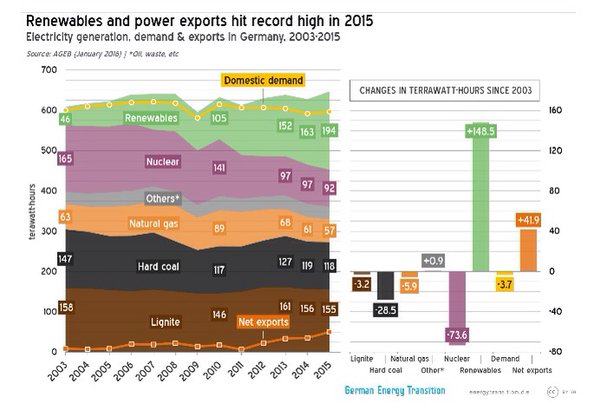

Les hommes politiques doivent faire face à bien des défis et intérêts contradictoires dans la mission qu’ils ont reçue de faire avancer la société. L’énergie nucléaire peut ainsi sembler une solution adaptée aux défis du changement climatique. Mais aucune évaluation ne peut être considérée comme correcte ou honnête si les risques de la solution envisagée ne sont pas présentés ouvertement à toutes les parties prenantes, y compris au public. Fukushima nous a offert l’opportunité de mener un vaste débat sur les défis auxquels sous sommes confrontés, au carrefour de multiples besoins humains : énergie décarbonée, sûreté, santé environnementale, sécurité des populations et préservation pour les générations futures. Ce sont là des questions qui définiront notre société humaine pour les siècles à venir. Nous ne devons donc pas rater l’opportunité d’en discuter en mettant sur la table tous les éléments dont on dispose.

Le mot de la fin : Sir Brian Flowers, éminent physicien nucléaire britannique, a fait remarquer que si des centrales nucléaires avaient été construites et déployées en Europe avant la Seconde guerre mondiale, de vastes zones d’Europe seraient inhabitables de nos jours car ces centrales auraient été la cible des méthodes de guerre et de sabotage classiques.

Par Akio Matsumura (Traduction française : Odile Girard)

Article paru sous le titre original « Our Lessons from Fukushima: New Concerns for the Future » le 6 mars 2016 sur le site Finding the missing link.

Source : fukushima-blog