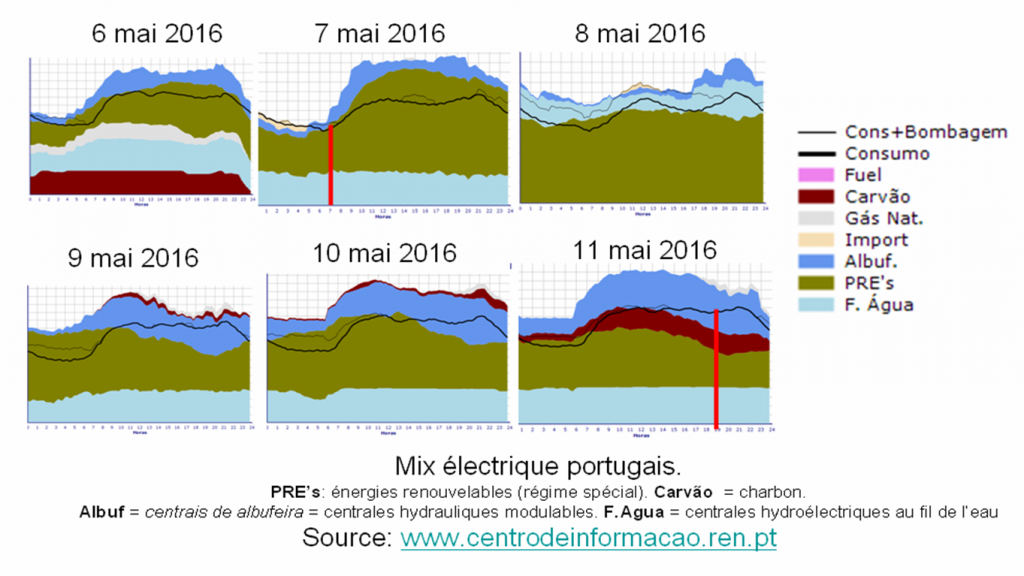

The Guardian et The Independant, 20Minutes.fr, Klimaretter ou MondoPortugues, ont fait écho de cette nouvelle : le Portugal n’aurait eu aucun recours aux énergies fossiles durant 4 jours.

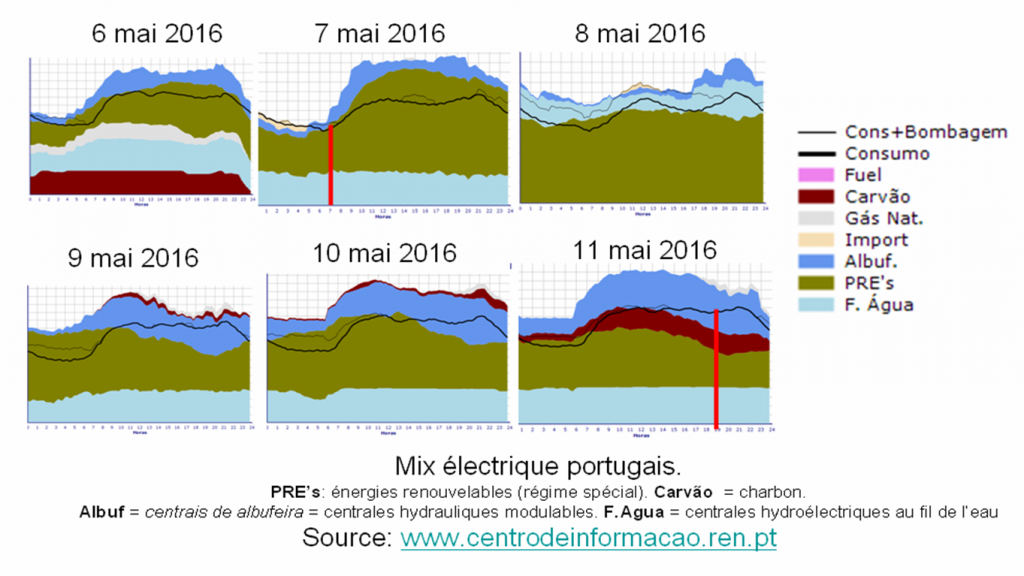

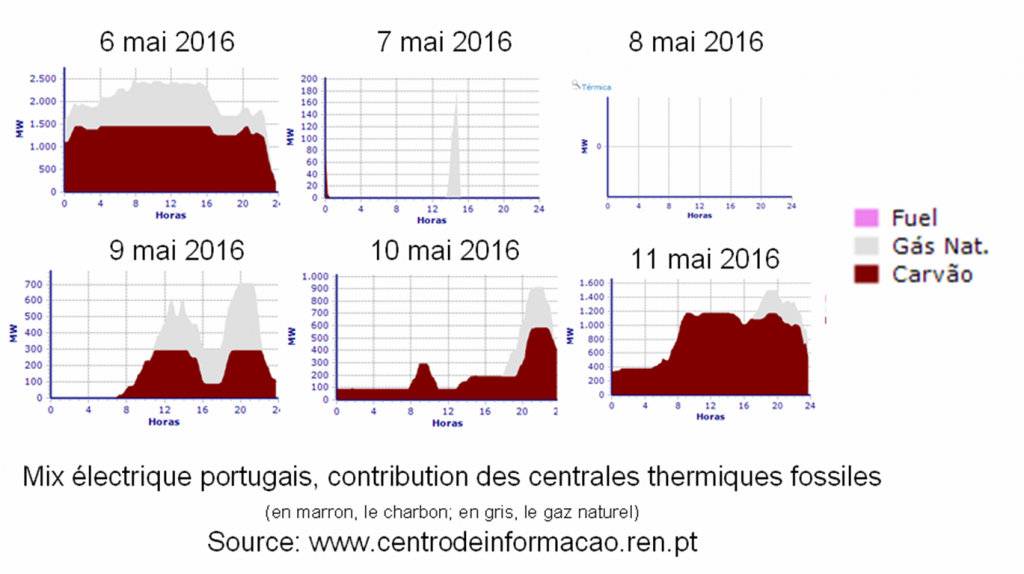

Or des centrales thermiques portugaises ont bien fonctionné pendant cette période. Les MWh thermiques correspondants ont été dissimulés dans l’électricité exportée, notamment vers la France, via les liaisons électriques établies par l’hexagone avec la péninsule ibérique à travers la chaîne pyrénéenne.

Selon le centre d’information de REN (« Redes Energéticas Nacionais », Réseaux Energétiques Nationaux), dont fait écho le site Lifegate.com, 632,7 GWh ont été consommé par le Portugal durant les 4 jours en question. Et 153,7 GWh ont été exportés, soit 19,5% de l’électricité totale produite (solde exportateur net).

On mesure ici l’importance des interconnexions électriques entre régions et pays, outil de flexibilité particulièrement utile pour parvenir à de hauts niveaux de renouvelables. Une situation que l’on retrouve aussi au Danemark qui est électriquement relié à la Scandinavie et à l’Allemagne.

97%, et non pas 100%

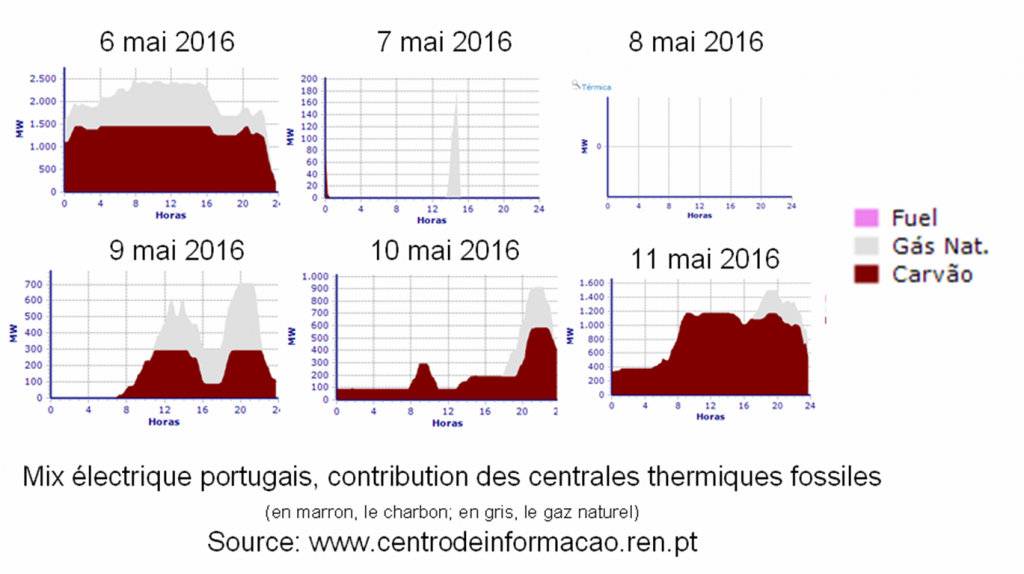

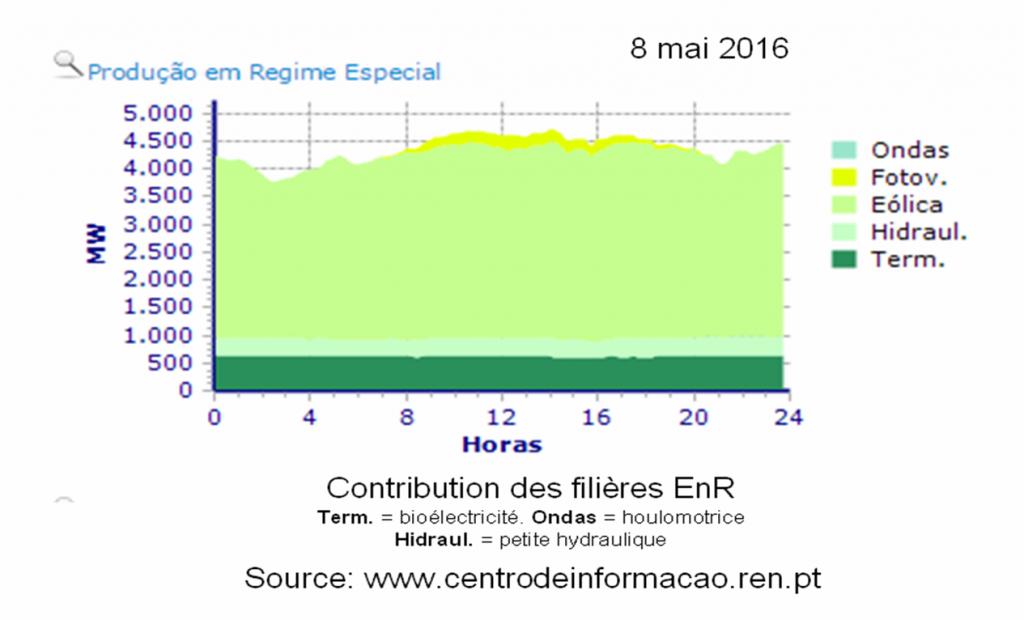

Le 7 mai la production thermique a été quasi-nulle. Le 8 mai complètement nulle. Donc oui, pendant une journée entière le Portugal a fonctionné sans brûler aucun combustible fossile, et uniquement avec les EnR. Mais pas 4 jours. Le 9 mai la production thermique a été de 5,6 GWh (3,4%). Idem le 10 mai avec 5,6 GWh (3,0%). Et le 11 mai, 22,2 GWh (12,4%).

Globalement la part thermique du 7 au 10 mai (4 jours) a été de 1,6%. Et de 3,8% du 7 au 11 mai (5 jours). Si l’on prend la période de 107 heures retenue par REN (de 6:45 du matin le 7 mai à 17:45 le 11 mai), alors on obtient une valeur d’environ 3%.

Autrement dit 97% de l’électricité portugaise a été d’origine renouvelable durant cette période. Et 3% d’origine fossile, à base de charbon et de gaz naturel. C’est remarquable. Mais ce n’est pas 100%. Considérer que l’intégralité des électrons sortant des centrales thermiques fossiles ont été expulsés vers l’étranger est un peu grossier.

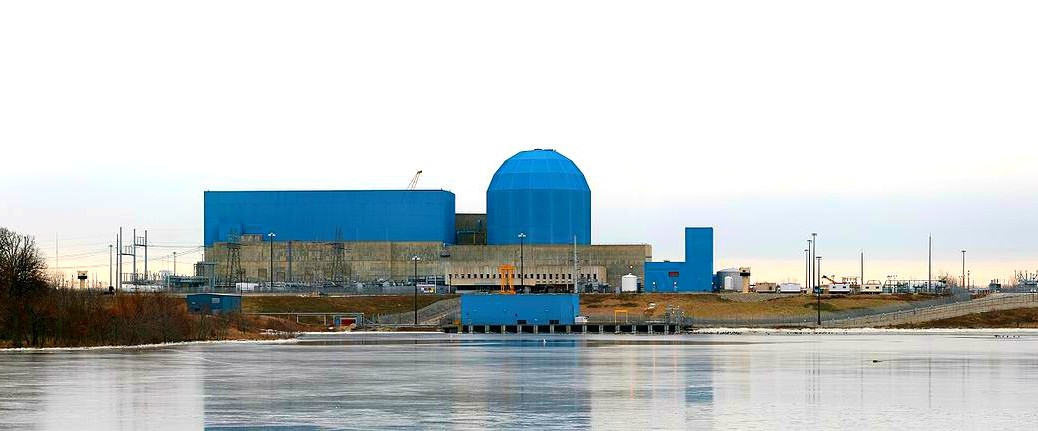

Les centrales thermiques sont utiles pour parvenir à de très hauts niveaux d’EnR. Bien sûr les centrales thermiques seront dans le futur remplacées par tout un panel d’outil de flexibilité disponibles dès aujourd’hui, dont les solutions de stockage à base de batteries. Mais en attendant, en transition, elles sont vitales. Les groupes énergétiques leaders dans le secteur des centrales à gaz ont donc une carte majeure à jouer dans la révolution énergétique en cours. Le gaz, par ailleurs beaucoup moins émetteur en CO2 que le charbon et que le fioul, est le meilleur allié des EnR.

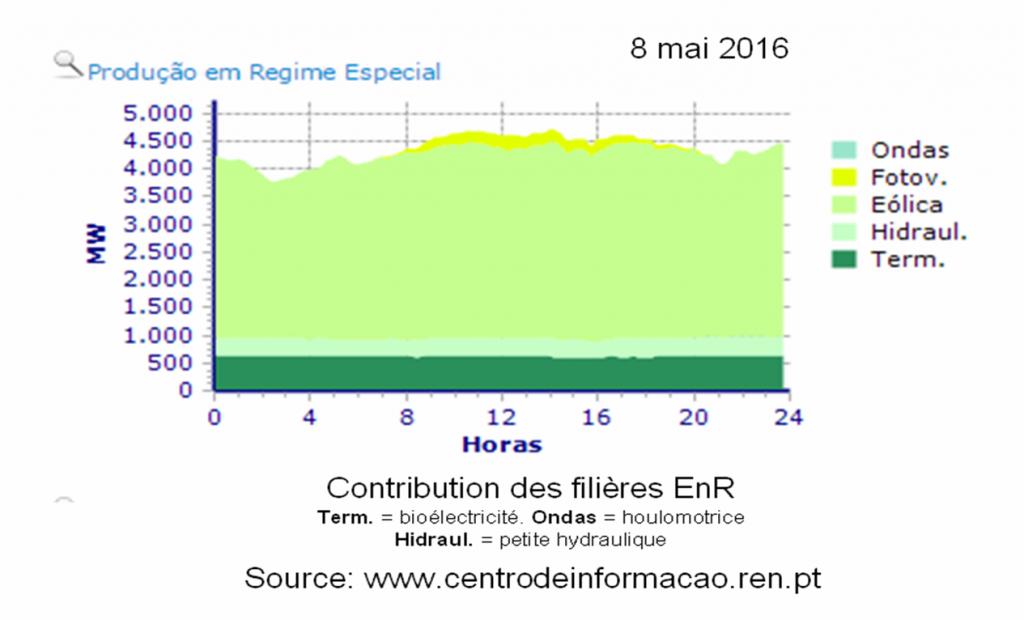

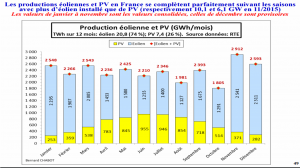

Quelle a été la contribution de chaque filière EnR durant ces 4 jours historiques ? 45% d’éolien, 45% d’hydro, les 10% restants partagés entre la bioélectricité et le solaire selon le REN. Le Portugal démontre ainsi concrètement qu’il est possible d’atteindre presque 50% d’EnR fluctuantes (solaro-éolien) sans poser de problèmes de contrôle de la fréquence et de la tension électrique. C’est-à-dire de stabilité du réseau électrique. Les centrales hydroélectriques et bioélectriques portugaises permettent d’offrir un socle de puissance permettant de réaliser cette performance.

Les EnR ont répondu à 95,5% de la demande électrique portugaise au cours de l’ensemble du mois d’avril 2016 (30 jours). En 2005 seulement 16% de l’électricité de ce pays du littoral atlantique était renouvelable, un niveau aussi modeste que celui observé aujourd’hui en France. Le seuil des 50% a été franchit dès 2010 selon le site allemand Energie transition, The German Energiewende. Soit seulement 5 ans après. La transition énergétique, quand on a vraiment la volonté de la réaliser, peut ainsi être très rapide. La STEP (Station de Transfert d’Energie par Pompage) d’Alqueva II, équipées par le français Alstom, a été inaugurée en 2013. En 2014, le Portugal a atteint 63% d’EnR.

Début 2016 le pays du Fado comptait une puissance installée de 6024 MW d’hydraulique (dont 5360 MW de grands barrages), 5033 MW d’éolien, 566 MW de centrale bioélectriques, 474 MW de solaire PV, et 29 MW de centrales géothermiques. De nouveaux records seront vraisemblablement battus cette année.

Vers 50% de solaro-éolien en France ?

La densité de population au Portugal (114 habitants au kilomètre-carré) est identique à celle de la France (112). En France l’hydroélectricité peut répondre à 15% de la demande électrique nationale, et la bioélectricité 10%. En ajoutant 25% d’électricité à base de gaz naturel il est possible d’intégrer 50% d’éolien et de solaire.

En ajoutant le marélien, une énergie marine à haute prévisibilité et à potentiel important en France, ainsi que de l’électro-méthane (obtenu par électrolyse puis méthanation) alors la part du gaz fossile peut être fortement réduite. Le gaz naturel est l’énergie fossile la moins sale. Un mix électrique composé par exemple de 90% d’EnR et de 10% de gaz naturel peut être considéré comme très propre. D’ici que les 75% d’EnR soient atteints l’efficacité et le coût de la technologie power-to-gas aura probablement baissé et son efficacité augmenté. Une perspective 100% EnR est ainsi tout à fait rationnelle.

Une étude réalisée par la R&D d’EDF, entreprise qui a pourtant des intérêts directs dans le business nucléaire, conclue d’ailleurs que parvenir à 40% d’EnR variables est tout à fait possible dans l’Union Européenne. En ajoutant l’hydroélectricité, la bioélectricité et les autres EnR (géothermie et énergies marines) les ¾ de l’électricité européenne peuvent être d’origine renouvelable. Un bon socle de centrales à gaz garantira une stabilité du réseau : les centrales nucléaires, qui sont beaucoup moins flexibles, ne sont pas indispensables.

Des études publiées par des scientifiques indépendants dans des revues scientifiques à comité de lecture estiment que l’on peut aller bien au-delà des 40% d’EnR variables. Un rapport gouvernemental de prospective piloté par l’ADEME, publication décriée dans le milieu pro-nucléaire, parvient à la conclusion qu’il est possible d’intégrer 80% de solaro-éolien en France (63 % d’éolien terrestre et en mer, 17 % de solaire). Des travaux menés dans de nombreux pays du monde, des USA à la Chine parviennent à de résultats comparables : de très hauts niveaux d’EnR sont possibles.

Des chercheurs de Stanford University estiment que la France peut répondre à 100% de ses besoins énergétiques (y compris transport et chaleur) uniquement avec le trio Wind Water Sun. Autrement dit sans aucune combustion, pas même celle de la biomasse (source d’émissions polluantes, dont notamment le carbone-suie).

Ceci sans aucun effort, c’est-à-dire sans intégrer le volet « sobriété » des études de l’association française négaWatt. Une Solar « Electron Economy », formule visionnaire du physicien suisse Ulf Bossel, est en effet intrinsèquement efficiente. Un véhicule électrique est par exemple 3 à 4 fois plus efficace qu’une voiture thermique équivalente.

Vers une révolution solaire mondiale ?

Au premier quadrimestre de 2016 pas moins de 64% des nouvelles puissances installées aux USA ont été photovoltaïques. Et 33% éoliennes. Le charbon et le gaz n’ont pesé qu’1%. Et le nucléaire 0%.

Selon les dernières statistiques mondiales de BP sur l’énergie (rapport qui vient de paraître) la production électrique solaire PV pèse à présent un dixième de celle du nucléaire (253 TWh versus 2577 TWh).

Alors que la production d’électricité nucléaire n’a augmenté que de 34 TWh, celle des énergies renouvelables a augmenté de 252 TWh, sept fois plus. A ce rythme, le solaire, à lui seul, dépassera le nucléaire vers 2025 au niveau mondial, malgré tous les réacteurs nucléaires en construction à ce jour et le redémarrage d’une partie des réacteurs japonais. Dans moins de 10 ans.

Le nucléaire mondial ne produit pas plus d’électricité en 2015 qu’il y a quinze ans (2.582 TWh en l’an 2000). Ceci alors que l’hydraulique en produit 48% de plus (2.662 TWh en 2000) et les autres énergies renouvelables sept fois plus (229 TWh en 2000).

Le solaire, devenu très compétitif et dont la ressource, gratuite, est illimitée, attire naturellement les géants mondiaux de l’énergie. Dont les français Total et Engie (ex-GDF Suez) qui ont entamé un changement stratégique profond.

Engie a phagocyté Solairedirect en 2015, tout en préservant son esprit de start-up. Et ce Gargantua multiplie les acquisitions dans le domaine du digital, secteur clé dans la perspective d’un futur à hauts niveaux d’EnR.

Dès 2011 Total a pris 60 % du capital de SunPower, pour 1,38 milliard de dollars. En mai 2016 il a mis un milliard d’euros pour acheter le champion tricolore de fabrication de batteries, Saft.

De son côté EDF, plombé par ses actifs nucléaires, est en train de vivre le syndrome de Kodak.

Olivier Daniélo