Alors que les récifs coralliens couvrent moins de 0,2% de la superficie des océans, ils réunissent près de 30% de la biodiversité marine connue. Leur santé est donc cruciale pour la diversité des espèces qu’ils abritent mais aussi pour l’humanité. Alors qu’une grande partie des récifs tend à disparaître ces dernières années, étudier cet écosystème fragile et menacé devient une priorité.

Alors que les récifs coralliens couvrent moins de 0,2% de la superficie des océans, ils réunissent près de 30% de la biodiversité marine connue. Leur santé est donc cruciale pour la diversité des espèces qu’ils abritent mais aussi pour l’humanité. Alors qu’une grande partie des récifs tend à disparaître ces dernières années, étudier cet écosystème fragile et menacé devient une priorité.

D’est en ouest et du sud au nord, Tara parcourra l’océan Pacifique pour découvrir la diversité des récifs coralliens et mieux appréhender leurs capacités d’adaptation aux changements climatiques.Du canal de Panama à l’archipel du Japon (2016-2017), puis de la Nouvelle Zélande jusqu’en Chine (2017-2018), la goélette croisera 11 fuseaux horaires à travers l’océan le plus vaste de la planète, joignant notamment les terres insulaires et les récifs les plus isolés de la planète.

Une approche inédite de la biodiversité des récifs

Le caractère unique de cette expédition consiste tout d’abord en son approche « transversale » d’une zone géographique très étendue, en l’occurrence le Pacifique, où se concentre plus de 40 % des récifs coralliens de la planète. Une telle approche n’avait encore jamais été réalisée jusqu’à présent à cette échelle.

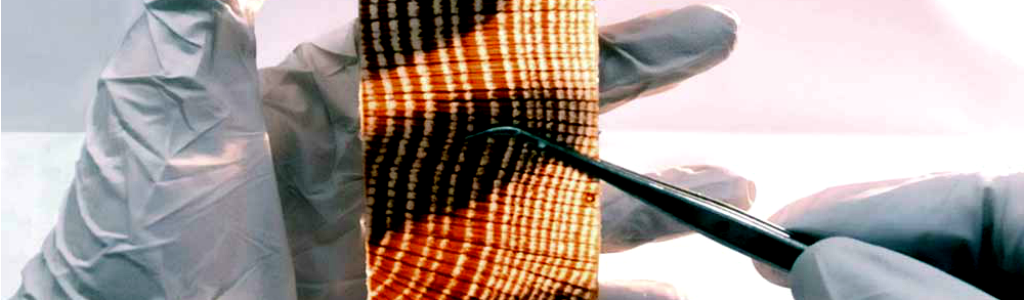

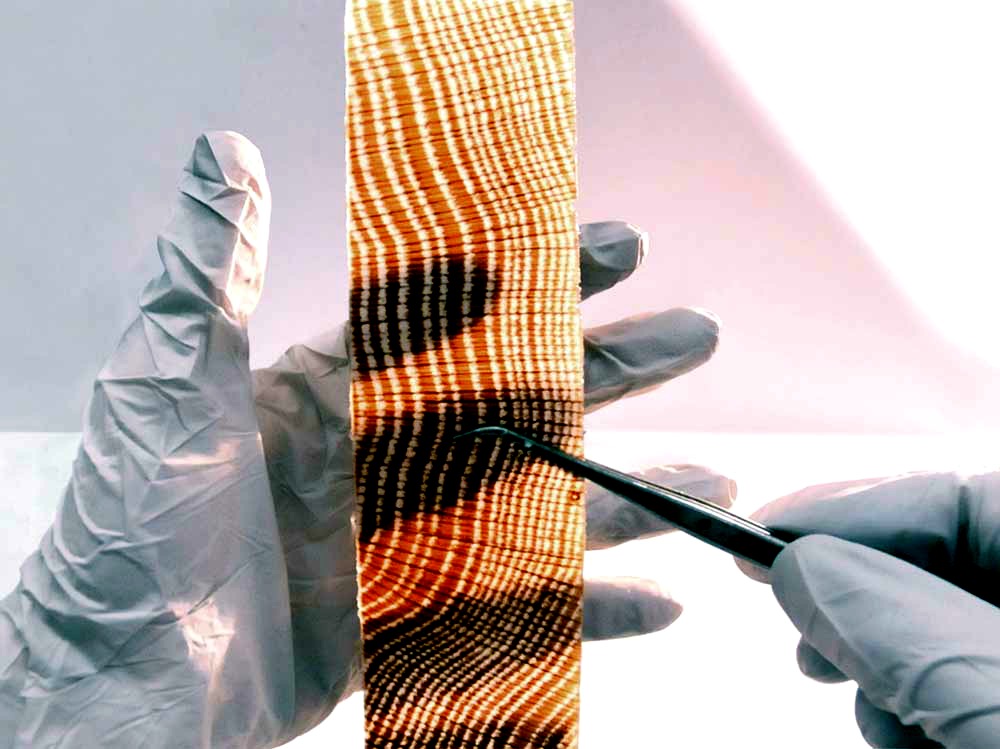

Selon Serge Planes, chercheur CNRS et directeur scientifique de l’expédition, « Tara Pacific tentera de dévoiler la biodiversité d’un récif, à la fois génomique, génétique, virale ou bactérienne, pour la comparer à celle de la masse d’eau qui l’entoure. Le but est de se faire une idée réelle de la diversité globale d’une colonie corallienne. » Elle permettra également d’apporter de nouvelles connaissances sur le rôle encore inconnu joué par les paramètres biologiques, chimiques ou physiques dans la vie des colonies coralliennes et la capacité de ces dernières à s’adapter aux changements environnementaux.

L’expédition Tara Pacific traversera un très large gradient de biodiversité qui atteindra son maximum au « Triangle de corail » en Asie du Sud-Est. Au cours de l’expédition, quarante archipels seront étudiés de façon identique pour appréhender les variations de la biodiversité à travers trois espèces récifales : deux coraux et un petit invertébré de la famille des hydraires.

Par une approche comparative et interdisciplinaire, les scientifiques tenteront de remonter dans le passé récent des colonies coralliennes, d’observer l’évolution contemporaine des récifs et d’en envisager le futur, notamment à travers des modélisations.

Outre l’état de santé du récif et sa biodiversité à différents niveaux, l’équipe scientifique s’intéressera aux capacités de résistance, d’adaptation et de résilience de ces écosystèmes. Un dernier axe d’étude portera sur les éventuelles applications de la biologie corallienne pour la recherche médicale.

Sensibiliser et partager les enjeux environnementaux

« Si la communauté scientifique a besoin de ces nouvelles données, les acteurs locaux et internationaux aussi. Tara contribuera à mieux comprendre les enjeux qui touchent ces berceaux de biodiversité que sont les récifs et qui importent tant pour l’avenir des populations notamment dans les petites îles » indique Etienne Bourgois, président de la Fondation Tara Expéditions.

La Fondation Tara Expéditions profitera de cette expédition pour interpeler les acteurs politiques et le monde économique, sensibiliser la société aux enjeux écologiques les plus urgents ainsi qu’aux problématiques rencontrées par les populations qui dépendent de la bonne santé de l’océan. De nombreuses escales dans le Pacifique et en Asie permettront de partager avec le plus grand nombre, petits et grands, ces enjeux environnementaux.

Etapes majeures – Panama, Malpelo (Colombie), Ile de Pâques, Papeete (Polynésie Française), Iles Cook, Samoa, Wallis et Futuna, Iles Marshall, Micronésie, Mariannes, Japon, Taïwan, Fidji, Nouvelle Zélande, Nouvelle Calédonie, Papouasie Nouvelle Guinée, Philippines, Chine, Hong Kong, Corée du Sud, …

Partenaires majeurs de l’expédition – agnès b., Fondation Prince Albert II de Monaco, Serge Ferrari, Fondation Véolia, BillerudKorsnäs, Lorient Agglomération, Région Bretagne – CNRS, Paris Sciences et Lettres, Centre scientifique de Monaco (CSM), CEA, EMBL, Fonds Français pour l’Environnement, Unesco-Commission Océanographique intergouvernementale

Source : cnrs