Nous vivons aujourd’hui dans une économie linéaire : nous prélevons des matières premières dans notre environnement, nous les transformons et les assemblons. Les produits ainsi fabriqués sont ensuite vendus, consommés puis jetés lorsqu’ils sont hors d’usage. Ces processus sont à la fois extrêmement consommateurs en énergie et producteurs de déchets.

L’économie linéaire est donc un système non durable. Depuis quelques décennies la montée en puissance du recyclage est un exemple de tentative d’”arrondir” la linéarité de l’économie.

Le but étant d’arriver à créer un cercle – vertueux – où l’extraction des matières premières et l’énergie consommée pour produire des biens ont un impact nul sur l’environnement.

L’économie n’est alors plus linéaire mais circulaire

L’Ademe définit l’économie circulaire comme “un système économique d’échange et de production qui, à tous les stades du cycle de vie des produits (biens et services), vise à augmenter l’efficacité de l’utilisation des ressources et à diminuer l’impact sur l’environnement tout en développant le bien être des individus”. Pour faire simple, l’économie circulaire est un modèle qui s’intègre dans les modèles économiques existants en y ajoutant les contraintes liées aux exigences de soutenabilité.

Quels sont les ressorts de l’économie circulaire ?

Trois piliers en portent les principes :

- l’offre des acteurs économiques ;

- les demandes des consommateurs ;

- le recyclage.

Faire évoluer l’offre des acteurs économiques

L’offre des acteurs économiques concerne l’approvisionnement en ressources, l’écoconception, l’écologie industrielle et territoriale, ainsi que l’économie de fonctionnalité.

Au sein de l’économie circulaire, l’approvisionnement devient durable. Ainsi, les modes d’exploitation des ressources sont raisonnés :

- prise en compte de la finitude des ressources ;

- amélioration de l’exploitation des ressources (en limitant les rebuts d’exploitation par exemple) ;

- prise en compte des impacts environnementaux liés à l’exploitation des ressources ; dans le modèle linéaire, les industriels veulent avoir accès à toutes les ressources potentielles ; dans une économie circulaire, l’accès aux ressources dépend du prix écologique à payer ;

- prise en compte des externalités sociales de l’exploitation des ressources, principalement des impacts sociaux au niveau local.

Autrement dit, l’économie circulaire est avant tout un changement de paradigme assez simple à comprendre. En prenant en compte toutes les externalités liées à une activité industrielle, on contraint celle-ci pour la faire entrer dans un cadre pérenne. Et cela peut rapporter de l’argent, où en faire perdre moins, c’est selon. A titre d’exemple, la pollution de l’air coûte chaque année près de 3000 milliards d’euros dans le monde.

Deuxième volet d’action sur l’offre des acteurs économiques : l’écoconception. L’écoconception, en prônant une approche préventive des problèmes d’environnement, et ce dès la conception des produits, s’avère avoir des effets bénéfiques sur les profits des entreprises. En termes de cycle de vie des produits, l’écoconception est plutôt focalisée sur l’amont, alors que l’économie circulaire demande d’accorder une plus grande importance à l’aval, c’est-à-dire au devenir réel du produit, à son usage, à sa fin de vie, et à son insertion dans différents types de boucles de nature industrielle ou naturelle. Parmi toutes les composantes de l’économie circulaire, l’écoconception est l’usage qui s’est le plus banalisé dans les pratiques industrielles.

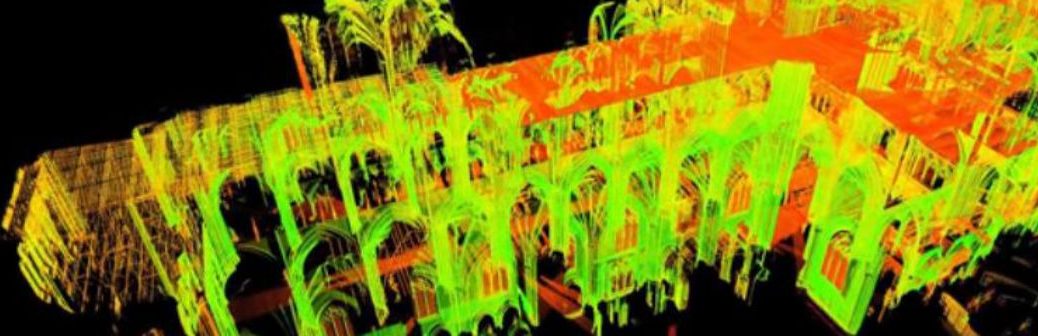

Pilier de l’économie circulaire, l’écologie industrielle et territoriale porte bien son nom : elle vise à optimiser les ressources – énergies, eau, matières, déchets mais aussi équipements et expertises – en se basant sur une approche systémique biomimétique.

Dernier composant de l’offre construite par les acteurs économiques, l’économie de fonctionnalité : elle se définit comme un système privilégiant l’usage plutôt que la vente d’un produit.

Elle vise à développer des solutions intégrées de biens et services dans une perspective de développement durable. Ainsi, l’échange économique ne repose plus sur le transfert de propriété de biens, qui restent la propriété du producteur tout au long de son cycle de vie, mais sur le consentement des usagers à payer une valeur d’usage.

Les demandes des consommateurs

Les consommateurs en font la demande depuis des années : ils veulent des produits qui durent plus longtemps. Aujourd’hui ce souhait est entendu par les industriels. Réemploi, réutilisation, vente, occasion, don, et plus généralement allongement de la durée de vie… les moyens de proposer aujourd’hui des produits qui “durent plus longtemps” sont très nombreux. Il s’agit là aussi d’un changement de pratique drastique pour les industriels dont l’usage des méthodes d’obsolescence programmée est aujourd’hui jugé intolérable par l’opinion publique.

Seconde tendance, la consommation responsable. Conscients de leurs rôles, les consommateurs assument aujourd’hui la responsabilité personnelle de choisir ou non d’acheter un produit, pas seulement en fonction de sa qualité mais également selon ses conditions de production et de son impact environnemental global (à tous les niveaux de son cycle de vie).

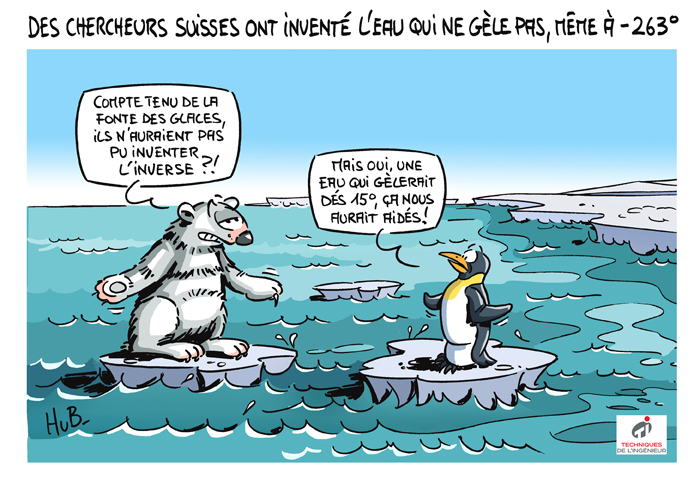

Le recyclage, pierre angulaire de l’économie circulaire

Le recyclage vise à utiliser les matières premières issues de déchets. Si certains matériaux – verre, papier, cartons, acier, aluminium, certains plastiques – sont aujourd’hui facilement recyclables, d’autres – papiers, cartons souillés, certains plastique, polystyrène… – posent plus de problèmes. Des problèmes techniques, ou économiques.

Intégrer le recyclage dans un système d’économie circulaire est à la fois nécessaire et compliqué, car il faut développer un modèle économique viable sur cette partie du process.

Ainsi, les ingrédients de l’économie circulaire, bien que complexes à mettre en place de façon synergique, permettent de construire des modèles économiques durables.

Reste à savoir si le poids des consommateurs, la mise en place de la RSE et l’urgence écologique permettront au modèle circulaire de remplacer l’économie linéaire.