« Comment une telle imposture-peut-elle avoir lieu ? » poursuit sur son blog Philippe Hansen. Ce professeur de sciences physiques au Lycée International de Valbonne à la technopole Sophia-Antipolis est co-auteur avec d’autres membres du réseau « sauvons le climat » dont fait partie l’ingénieur le plus médiatisé de France, Jean-Marc Jancovici, d’ un papier où est proposé de mettre en service 7000 GW de réacteurs nucléaires dans le monde entre 2060 et 2100. En août 2015 la puissance électrique installée du parc électro-nucléaire mondial s’élevait à 378 GW.

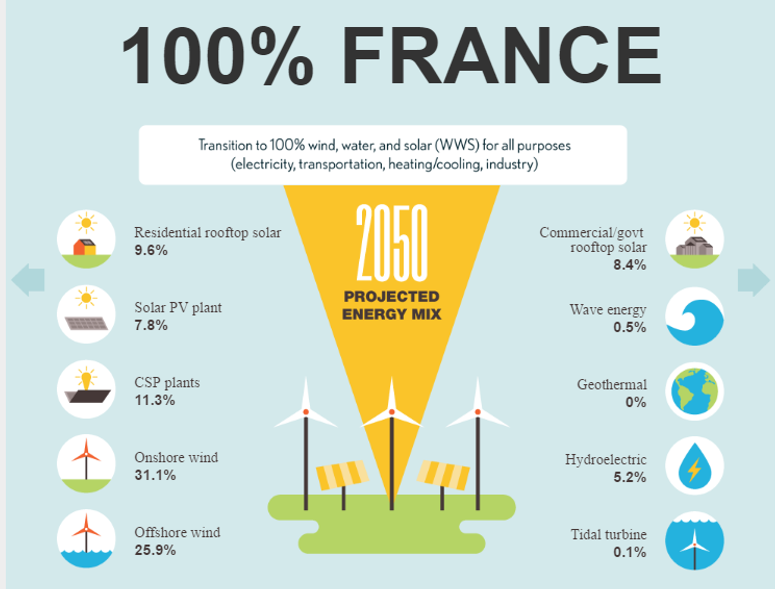

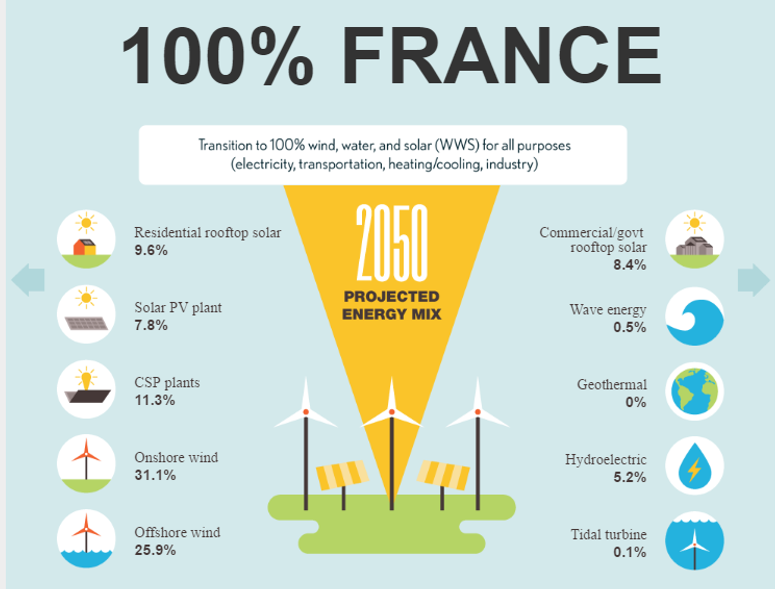

Contrairement aux scénarios proposés par l’ADEME qui ne portent que sur le remplacement du mix électrique actuel très largement dominé par le nucléaire par des mix à haute teneur en électro-EnR, le scénario WWS-France de Stanford porte sur le mix énergétique global, y compris transports et chauffage.

Une énergie 100% renouvelables en France, est-ce possible ?

Grâce à l’efficacité intrinsèque de l’approche WWS intégralement basée sur les électro-EnR la demande énergétique de la France estimée par les chercheurs californiens est de 1384 TWh (158 GW x 8760 heures) à horizon 2050.

Contacté par les Techniques de l’ingénieur suite à l’article de Philippe Hansen, Mark Jacobson a souligné que pour la France « les 158 GW en 2050 d’électricité WWS constituent une réduction de 40,9% des 267 GW du scénario BAU (Business as usual) ». Le scientifique ajoute : « ceci en premier lieu grâce à un meilleur ratio énergie:travail de l’électricité comparativement à la combustion (23,1%), en second lieu par l’élimination de l’énergie dépensée dans l’extraction minière et le raffinage des combustibles fossiles et de l’uranium (9,1%) et enfin par les gains d’efficacité au niveau des usages finaux comparativement au BAU (8,7%). » Autrement dit, à niveau de confort égal (et même supérieur compte-tenu de la préservation de l’air, de l’eau, des sols et de la biodiversité) l’approche WWS est presque deux fois plus efficiente que celle BAU.

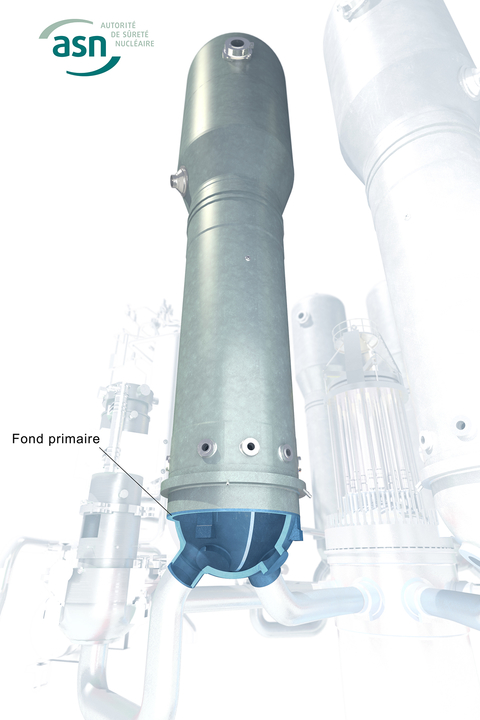

Contrairement au solaire et à l’éolien, la filière nucléaire repose sur une ressource finie et très limitée, l’Uranium 235. Dans une perspective de durabilité le peak uranium est tout aussi problématique que le peak oil. Au niveau des coûts les filières reposant sur l’Uranium 238 seront encore moins viables que les filières nucléaires actuelles. Or le solaire et l’éolien sont dès à présent bien meilleurs marché que le nouveau nucléaire EPR qui repose sur l’Uranium 235.

L’équipe dirigée par Mark Jacobson a passé en revue les 50 états des USA et 139 pays dans le monde. Un scoop: la France fait partie du monde ! Dans le cas de l’hexagone les 1384 TWh d’électricité requis (contre environ 500 TWh aujourd’hui) sont répartis entre 57% d’éolien, 37% de solaire et 5% d’hydroélectricité.

Plus précisément 31,12% d’éolien terrestre, 25,94% d’éolien marin, 9,57% de solaire PV en toitures résidentielles, 8,40% de solaire PV au niveau des toitures des collectivités ou des commerces, 7,78% de solaire PV au sol et 11,29% de thermosolaire (CSP) avec stockage thermique. S’ajoutent 5,25% d’hydroélectricité ainsi que d’autres filières plus marginales: 0,49% d’houlomoteur, 0,02% de géothermie et 0,14% de marémoteur.

Ces données sont disponibles sur le site de l’université Stanford (cliquer sur xlsx spreadsheet) :

Les ressources renouvelables disponibles en France sont-elles compatibles avec l’ambitieux scénario WWS-France ? Dans le rapport de l’ADEME (2015) sur le 100% EnR sont estimés, sur la base d’hypothèse extrêmement conservatrices, les potentiels des différentes filières. Celui de l’éolien terrestre est évalué à 374,2 TWh et celui de l’éolien offshore à 269,5 TWh (190.4 TWh d’offshore classique et 79,1 TWh de farshore flottant, une technologie émergente). En retenant des hypothèses un peu moins rigides les 429 TWh d’éolien terrestre et les 359 TWh d’éolien offshore du scénario WWS-France sont tout à fait atteignables. Par exemple en doublant le potentiel de l’éolien farshore.

Dans le cas d’une faible acceptabilité sociale de l’éolien (les enseignants et les journalistes ont un rôle clé à jouer sur le plan pédagogique pour expliquer les enjeux) il est tout à fait possible de muscler davantage le volet solaire en France et de passer par exemple à 50% de solaire + 40% d’éolien + 5% d’hydroélectricité + 5% de marélien (une nouvelle filière prônée par François Lempérière de l’association Hydrocoop).

Le potentiel purement théorique du solaire en France est supérieur à 70.000 TWh

L’ADEME estime à 403,1 TWh le potentiel du solaire PV en toiture. C’est largement assez pour répondre aux 239,6 TWh requis dans le scénario WWS-France (123,4 TWh au niveau résidentiel + 116,2 TWh au niveau des autres toitures).

Le potentiel du solaire au sol (62,5 TWh) retenu dans l’étude ADEME est presque 7 fois inférieur à celui du solaire PV en toiture, ce qui constitue à l’évidence une aberration. Sont ignorés le solaire flottant (Lire : La PME Ciel et Terre construit la plus grande centrale solaire flottante du monde au Japon. Pas en France) ainsi que l’approche du solar sharing consistant à coupler production agricole et énergétique (Lire: L’île d’Ukushima accueille le plus grand projet Solar Sharing du monde).

D’un point de vue purement théorique si l’on couvrait intégralement la France métropolitaine (551.500 km2) avec une centrale solaire PV semblable à celle installée à Cestas par le groupe Neoen (puissance installée de 300MW, production de 350 GWh/an, surface totale de 2,6 km2), ce ne sont pas moins de 74.240 TWh par an qu’il serait possible de produire en métropole. La région de Bordeaux jouit d’une ressource solaire au km2 proche de la moyenne française.

La valeur retenue par l’ADEME (62,5 TWh) est donc équivalente à 0,08% de ce potentiel purement théorique. Le scénario WWS-France estime nos besoins énergétiques totaux à seulement 1384 TWh pour 2050, ce qui est équivalent à seulement 1,8% du potentiel. Plus de la moitié de la surface française est aujourd’hui utilisée (SAU, Surface Agricole Utile) pour capter l’énergie solaire nécessaire à la croissance des plantes alimentaires (photosynthèse). Serait-il vraiment aberrant que 1% de cette surface serve à produire de l’énergie parfaitement durable et qu’ainsi la France devienne énergicultrice ?

Environ 2,5% de la surface nationale suffira pour que la France devienne totalement renouvelable

« Nous avons calculé que la surface nécessaire pour le scénario WWS-France est de 0,36% (footprint) pour le solaire PV et CSP » souligne Mark Jacobson. « Pour l’éolien la surface requise (spacing) est de 1,9 à 3% mais cette surface pourra être utilisée parallèlement pour d’autres usages comme l’élevage, les cultures végétales ». L’espace est en effet libre entre les mâts des éoliennes. Le scientifique californien insiste : « ces chiffres sont valables pour la totalité des usages énergétiques et avec la demande énergétique de 2050 ».

Deux facteurs peuvent expliquer la timidité de l’ADEME et sa difficulté à être aussi ouverte que Stanford University. Tout d’abord la France est le royaume de l’atome et la pression contre les électro-EnR est considérable compte-tenu des enjeux financiers pour EDF qui a misé presque exclusivement sur la fission. Le solaire PV, dont la production est maximale en milieu de journée, agit comme un poignard perforant le business-model nucléaire d’EDF. Comme l’a souligné le réseau TEPOS l’étude de l’ADEME a failli terminer cachée dans un tiroir du ministère de l’écologie dirigé par Ségolène Royal, car ses conclusions dérangeaient.

Dans le documentaire « Les voleurs de feu, qui a peur de l’énergie solaire ? » qui sera diffusé le lundi 24 octobre sur France 3 et qui est disponible dès à présent via le site de l’association Hespul, la journaliste et réalisatrice bretonne Brigitte Chevet explique sur la base de l’analyse de nombreuses personnalités dont celle de l’ingénieur catalan André Joffre (bureau d’études Tecsol à Perpignan) ainsi que celle de l’avocate Corine Lepage, comment EDF a tout fait pour empêcher l’émergence du solaire en France.

Un second facteur est aussi impliqué : celui de l’idéologie de la décroissance qui s’est développée au sein du milieu écologiste en réaction à la mise en place du parc électro-nucléaire hexagonal. Ce parc construit sans concertation avec la population nationale a conduit à l’émergence d’une méfiance généralisée vis-à-vis des sciences & technologies ainsi que de la « fée électricité ». Les dégâts du tout nucléaire vont bien au-delà du seul domaine de l’énergie.

La communication écologiste, en réaction à ce déni de démocratie, a alors été principalement construite dans une perspective de sobriété et d’économies d’énergie. Mais pour le psychothérapeute Bertrand Piccard, père de l’avion Solar Impulse qui est bardé de produits high-techs et qui a fait le tour du monde sans brûler une seule goutte de carburant, cette stratégie des écologistes n’est pas la bonne. Il préconise au contraire de « montrer que le développement durable peut être sexy » et qu’« il ne signifie pas retourner en arrière » ou se priver.

Le solaire contre la décroissance

Dans une tribune publiée le 13 octobre dans Les Echos Xavier Fontanet, président du groupe Essilor (58.000 employés) propose comme axe stratégique « le solaire contre la décroissance ». Pour ce membre du conseil d’administration des groupes L’Oreal et Schneider electric « l’impact (de l’émergence du solaire PV ndlr) est plus profond, il est d’ordre philosophique : la sauvegarde de la planète ne passe plus nécessairement par des stratégies de décroissance. Derrière cette bonne nouvelle, une réalité simple qu’on avait oubliée : la plus grosse centrale nucléaire de l’univers travaille chaque seconde pour notre bonne vieille Terre c’est… le Soleil ! »

Un climat d’affrontement particulièrement stérilisant a émergé en France, avec beaucoup de haine de part et d’autre, faisant perdre beaucoup de temps. Les articles du blog Energie-Crise.fr en sont l’illustration. Les uns dénoncent un projet de « retour à la bougie », et symétriquement les autres dénoncent un programme de transformation de la France en Tchernobyl ou Fukushima.

S’opposent par exemple les promoteurs du scénario « négaWatt » contre ceux du scénario « négaTEP » porté par l’association sauvons le climat (TEP pour tonne équivalent pétrole). Pour les seconds faire reculer le nucléaire conduirait mécaniquement à faire monter les énergies fossiles : les promoteurs des électro-EnR en France sont alors traités de criminels climatiques. Cet affrontement négaWatt (sous-entendu Watt nucléaire) versus négaTEP s’inscrit dans une dynamique de néga-tivité, et même d’auto-destruction nationale, une forme de suicide français. En France le scénario « posiWatt » n’existe toujours pas et il est par conséquent difficile de positiver.

Un seul point de convergence est apparu entre anti-atomes et pro-atomes: développer la biomasse pour les applications thermiques. Les pro-atomes l’utilisent pour s’offrir un parapluie pro-renouvelable tout en protégeant le nucléaire. De leur côté les scénarios négaWatt, même s’ils évoluent peu à peu, misent beaucoup sur cette énergie renouvelable reposant sur la photosynthèse. Or c’est précisément la filière que le scientifique Mark Jacobson rejette car son bilan dans les études environnementales et multicritères n’est pas bon.

Les filières biomasse sont en effet basées sur la combustion (avec comme corrélat l’émission de particules et autres composés polluants) et diffèrent en réalité assez peu des filières fossiles: charbon pétrole et gaz naturel constituent de la biomasse fossilisée. De plus le rendement de la photosynthèse est très médiocre : son développement conduirait à un gaspillage surfacique peu souhaitable dans un contexte de démographie mondiale croissante. La filière microalgale, au rendement un peu moins médiocre, devra de son côté affronter la problématique du peak phosphorus et prouver que son équation économique peut devenir solide.

Frédéric Livet, Polytechnicien et Docteur en Physique confiait ceci en 2009, à une époque où le solaire PV était très coûteux, ce qui n’est plus le cas aujourd’hui: « J’espère que mon scepticisme à l’égard des renouvelables et en particulier à l’égard du solaire ne gênera pas un rapprochement que je pense nécessaire entre écoles de pensées (école de pensée de Stanford University versus celle du lobby atomique en France, ndlr) Ce scepticisme n’est d’ailleurs pas partagé par tous les amis de SLC. ». Ce Directeur de recherche CNRS et membre de Sauvons Le Climat ajoutait: « La position non-scientifique et religieusement critique à l’égard du progrès technique (qu’on me pardonne mes facilités polémiques!) de beaucoup de nos amis écologistes a beaucoup contribué à ce que je me décide à intervenir, en particulier par l’intermédiaire de « sauvons le climat » dans les débats sur le problème des GES. Après la canicule de 2003, il m’a paru urgent de contribuer à l’information sur les énergies décarbonées. »

Il est vrai que l’image donnée à l’écologie par une partie de celles et ceux qui se présentent comme les propriétaires du label « écologiste » est potentiellement nuisibles à l’image des EnR qu’ils prétendent promouvoir. Quand Cécile Duflot, après avoir pulvérisé le groupe écolo à l’Assemblée Nationale, parle de solaire cela peut donner l’envie à certains ingénieurs de balancer volontairement des déchets radioactifs dans la nature ou de rouler dans un gros 4×4 carburant au charbon liquéfié. N’est-il pas grand temps d’effectuer un nettoyage paradigmatique en France et de construire le débat énergétique sur des bases saines, c’est-à-dire scientifiquement rationnelles ? Puissent les réflexions de l’équipe de Stanford University y contribuer.

Dès 1869 le professeur français Augustin Mouchot écrivait : « Si dans nos climats l’industrie peut se passer de l’emploi direct de la chaleur solaire, il arrivera nécessairement un jour où, faute de combustible, elle sera bien forcée de revenir au travail des agents naturels. Que les dépôts de houille et de pétrole lui fournissent longtemps encore leur énorme puissance calorifique, nous n’en doutons pas. Mais ces dépôts s’épuiseront sans aucun doute : le bois qui, lui, cependant, se renouvelle n’est-il pas devenu plus rare qu’autrefois ? Pourquoi n’en serait-il pas de même un jour d’une provision de combustible où l’on puise si largement sans jamais combler les vides qui s’y forment ?[…] On ne peut s’empêcher de conclure qu’il est prudent et sage de ne pas s’endormir à cet égard sur une sécurité trompeuse ».

Un siècle plus tard Nicholas Georgescu-Roegen, devenu plus tard le pape des idéologues de la décroissance, tenait ces intéressants propos : « Si l’énergie utilisable a quelque valeur pour l’humanité, c’est dans la mesure où elle est aussi accessible. L’énergie solaire et ses sous-produits nous sont accessibles pratiquement sans effort ». Comme le souligne Elon Musk, a quoi sert-il de s’embêter à construire des centrales nucléaires sur Terre alors que nous en avons une énorme dans le ciel: le Soleil ? Nicholas Georgescu-Roegen ajoutait dans son livre The entropy law and the economic process publié en 1971 :« Nous devrions nous concentrer sur l’amélioration des utilisations directes de l’énergie solaire, la seule source propre et essentiellement illimitée (…) Bien sot serait celui qui proposerait de renoncer totalement au confort industriel de l’évolution exosomatique. L’humanité ne retournera pas dans les cavernes »

Le blog energie-crise.fr de Philippe Hansen avait initialement comme adresse energie-gouv.fr. Suite à la demande d’une importante organisation française le gouvernement a exigé le retrait du .gouv compte-tenu du fait que cela pouvait induire en erreur les lecteurs. Le délire, manifestement, n’est pas du côté des chercheurs de Stanford.

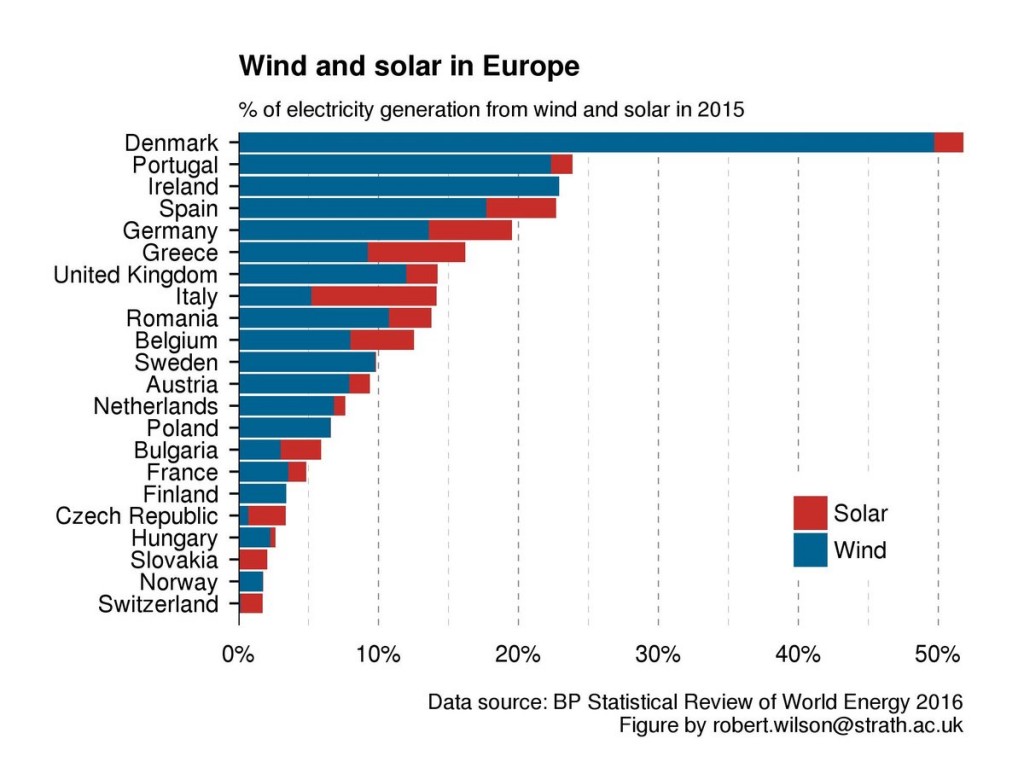

Le Portugal (pays étrangement oublié par le PDG d’EDF) répond à présent aux deux-tiers de sa demande électrique avec les énergies renouvelables, principalement de l’éolien. Ayant pourtant la même densité démographique, le pays du roi soleil serait-il incapable de faire aussi bien que celui du Fado ?

A la question posée par nos confrères de l’Usine Nouvelle, « L’Ademe a révélé un scénario d’une France 100 % renouvelable en 2050. Y croyez-vous ? », l’ingénieur des Mines Isabelle Kocher devenue CEO du géant français de l’énergie ENGIE a répondu :« Oui, j’y crois, à condition de mettre en place un écosystème qui le permette. Il ne faut pas que les renouvelables créent une volatilité insupportable sur les prix et des problèmes d’intermittence. Cela demande de développer des solutions de stockage. Si le stockage suit des courbes d’évolution technologique et de réduction des coûts aussi rapides que celle du photovoltaïque, il sera prochainement compétitif à toutes les échelles. En ajoutant des outils de gaz renouvelable, le scénario 100 % renouvelable est peut-être crédible à l’horizon 2050. »

Du délire ? « Souviens-toi quand nous avons commencé les gens nous riaient au nez et disaient que nous étions fous d’essayer, mais cela nous convenait tout à fait » chante Vienna Teng, artiste sino-américaine associée aux World Energy Innovation Forum qu’organise chaque année Elon Musk dans l’usine Tesla de Fremont en Californie. Elon Musk est déjà passé du rêve à la réalité : SpaceX lance à présent des fusées recyclables, une révolution. Il est bien parti pour la conquête de la planète Mars. Et la Tesla X, un SUV 100% électrique doté d’une autonomie de 500 km, passe de 0 à 100 km/h en 3 secondes. Le tout avec des électrons générés par SolarCity.

L’art occitan du trobar

Aliénor d’Aquitaine avait contribué à ce que les troubadours puissent exprimer leur poésie en recourant à la langue d’oc. Dans la même lignée n’est-il pas temps de laisser aux Girondins la possibilité de déployer leurs énergies citoyennes et leurs impulsions solaires ?

L’esprit de pionnier, qui est au cœur du message porté par Bertrand Piccard, et la créativité ne peuvent s’épanouir que dans un climat propice à l’innovation et acceptant l’échec. Isabelle Kocher a décidé de récompenser la « Best Failed idea ». Echouer (comme Shaï Agassi avec BetterPlace, associé au français Renault) c’est mûrir, et cela conduit à augmenter la probabilité de faire mieux la prochaine fois si l’on tire les leçons de cet échec.

Isabelle Kocher résume son projet par cette formule : « transformer une baleine (l’ancien système énergétique centralisé ndlr) en banc de poissons rapide, agile et cohérent ».Comment ? « par une révolution des esprits » répond cette dirigeante visionnaire. L’esprit de pionnier si cher à Bertrand Piccard.

« Les idées de vérité, de rationalité et de responsabilité intellectuelle sont à la base, conformément à ce que nous avons admis, des deux éthiques professionnelles, l’ancienne et la nouvelle » analysait le philosophe des sciences Karl Popper « Mais l’ancienne éthique était fondée sur l’idée du savoir personnel et certain, et par conséquent sur l’idée d’autorité ; tandis que la nouvelle éthique est fondée sur l’idée d’un savoir objectif et incertain. » Le droit d’échouer…

Un membre de Sauvons Le Climat ex-directeur de centrale nucléaire a déclaré aux Techniques de l’ingénieur: « mon maître en matière d’économie est Marcel Boiteux qui a été traîné dans la boue par Télérama ». Marcel Boiteux est l’ancien directeur d’EDF. L’ancienne éthique fabrique des « experts », des hommes considérés comme parfaits, infaillibles, qui n’ont pas le droit à l’erreur. Mais comme tous les êtres humains, ils en commettent. Ce qui, en contexte nucléaire, peut avoir des conséquences très graves. Non seulement pour eux-mêmes mais pour des millions de personnes. Cependant, sous la pression du système qui leur a délivré leur statut de super-expert, ils ne peuvent reconnaître de telles erreurs. Quand émerge une innovation qu’ils n’ont pas vu venir et qui remet en cause leurs dogmes, ils entrent dans une attitude de déni et même parfois dans un violent mépris.

« L’ancienne éthique que je décris nous interdit de faillir. Une faute est absolument inenvisageable. C’est pourquoi ces fautes ne peuvent être avouées » souligne Karl Popper, auteur notamment du livre « La société ouverte et ses ennemis ». « Je n’ai pas besoin de souligner à quel point cette ancienne éthique professionnelle est intolérante. Elle a toujours été intellectuellement malhonnête : elle a mené à la dissimulation de fautes en raison de l’autorité ».

Aucun domaine n’est épargné, ni celui de la médecine, ni celui de l’énergie. Des super-experts sont alors hyper-médiatisés par le système qui les a engendré, imposant une pensée monolithique et incapable de s’adapter au monde qui change. Sauf dans quelques cas, en nombre par ailleurs croissant. Alain Grandjean, économiste collègue de l’ingénieur Jean-Marc Jancovici, a par exemple prononcé cette phrase remarquable lors d’un débat avec une personne coincée dans ses certitudes anti-solaires: « l’histoire humaine est faite de ruptures qu’on n’a pas vu venir, non? ».

Encore mieux, Alain Grandjean est à l’origine de l’étude sur le solaire PV + stockage de la Fondation Nicolas Hulot (2015) dont il a confié la réalisation à l’ingénieur des Mines Nicolas Ott, étude qui est une synthèse du meilleur de la littérature scientifique mondiale sur le sujet et qui casse des dogmes et idées reçues malheureusement encore très présentes dans le débat énergétique en France. Nicolas Ott, avec l’appui d’une bonne dizaine de spécialistes du solaire, montre par exemple que même en prenant les hypothèses les plus conservatrices l’EROI (paramètre clé du développement vraiment durable) du solaire PV est à présent de 8:1. Et que le stockage batterie intraday ne l’impacte que très marginalement, de l’ordre de -10%.

Autre exemple, David Dornbusch, polytechnicien ex-super-expert du nucléaire (AREVA & CEA), est devenu un remarquable pédagogue des EnR et a fondé l’association Cleantuesday dont le rayonnement est à présent international.

Elon Musk, Shaï Agassi, Bertrand Piccard et Mark Jacobson, la tête dans les étoiles et les pieds bien sur Terre, sont des troubadours des temps modernes. Autrement dit, et au sens étymologique de ce mot occitan et excitant, des trouveurs.

L’innovation est le fruit des délires alimentés par des racines rationnelles.

Olivier Daniélo

Cet article a fait l’objet d’un droit de réponse à lire ICI

Mais pour mettre réellement en pratique ce système, encore faudrait-il que “100% des véhicules roulant sur l’autoroute soient autonomes”, indique Alain Bonnafous, chercheur au Laboratoire d’économie des transports, au Huffington Post. Avant que les voitures sans conducteur deviennent la norme et se généralisent, il nous faudra très probablement attendre plusieurs décennies, puisque celles-ci ne sont encore qu’en développement.

Mais pour mettre réellement en pratique ce système, encore faudrait-il que “100% des véhicules roulant sur l’autoroute soient autonomes”, indique Alain Bonnafous, chercheur au Laboratoire d’économie des transports, au Huffington Post. Avant que les voitures sans conducteur deviennent la norme et se généralisent, il nous faudra très probablement attendre plusieurs décennies, puisque celles-ci ne sont encore qu’en développement. BMW, Daimler et Volkswagen n’ont pas perdu de temps, et ont racheté récemment le service allemand de cartographie HERE, afin de faire communiquer les voitures entre elles, au sujet des bouchons, des accidents, des risques routiers (brouillard, voies glissantes), ou encore des limitations de vitesse temporaires – et d’afficher des annonces sur les tableaux de bord des conducteurs. Comme l’explique ZDNet, “ce sont des centaines de milliers de véhicules des 3 constructeurs allemands qui alimenteront en données le système – et des millions d’ici 2018”.

BMW, Daimler et Volkswagen n’ont pas perdu de temps, et ont racheté récemment le service allemand de cartographie HERE, afin de faire communiquer les voitures entre elles, au sujet des bouchons, des accidents, des risques routiers (brouillard, voies glissantes), ou encore des limitations de vitesse temporaires – et d’afficher des annonces sur les tableaux de bord des conducteurs. Comme l’explique ZDNet, “ce sont des centaines de milliers de véhicules des 3 constructeurs allemands qui alimenteront en données le système – et des millions d’ici 2018”.