Les Smacs (Social, Mobility, Analytics, Cloud, Security) synthétisent les principales évolutions technologiques du numérique à l’heure actuelle. Réseaux sociaux, internet des objets, applications multi device, impression 3D, virtualisation, traitement des données massives, sécurisation des données, etc. La transformation numérique des entreprises, ainsi que celle de l’ensemble des individus du fait des nouveaux usages, ont un impact sur l’ensemble des métiers, que ce soit ceux des systèmes d’information ou ceux de l’ensemble des autres fonctions.

Les évolutions rapides de l’informatique ont amené à la création de métiers, qui restent néanmoins des métiers de niche. Ainsi, les problèmes liés au stockage de données de plus en plus massives dans le cloud, en garantissant de bonnes pratiques environnementales et en matière de sécurité, disponibilité et fiabilité des données, ont conduit au recrutement de responsables de data centers. C’est aussi le besoin de maîtrise de la fiabilité et de la disponibilité des applications qui a incité les très grandes entreprises à se doter de gestionnaires de contrats informatiques, chargés des relations avec les sous-traitants.

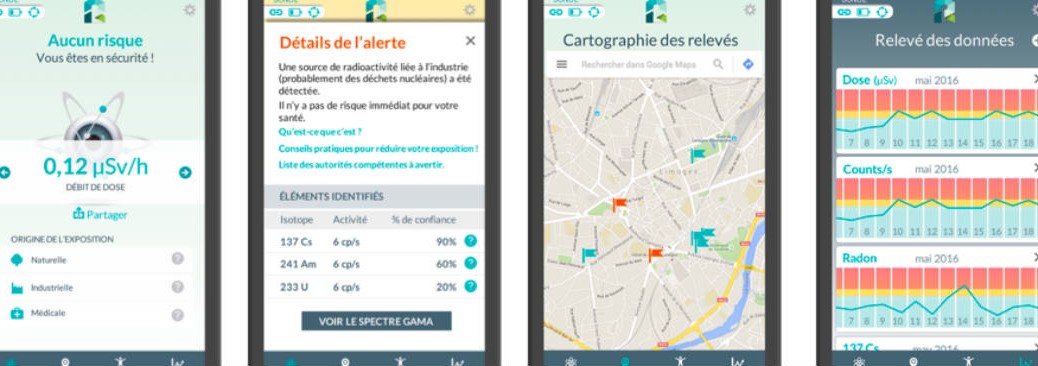

Les problématiques de sécurité sont devenues une source de création ou de transformation des emplois. Poussées par les contraintes réglementaires, mais aussi par les problèmes d’intrusion ou de pertes de données, les entreprises tentent de maîtriser certains risques en se dotant de responsables de sécurité des systèmes d’information, d’ingénieurs sécurité informatique (cybersécurité), voire d’experts en cryptologie. Le nombre d’offres d’emploi diffusées par l’Apec pour les postes en cybersécurité – principalement ingénieur sécurité et RSSI – ont quadruplé entre 2014 et 2016. La sécurité fait également partie des compétences que doivent posséder les ingénieurs et chefs de projets maîtrise d’œuvre, les ingénieurs systèmes et réseaux, les responsables et architectes infrastructures.

Les métiers traditionnels de l’informatique sont bouleversés en permanence par les nouvelles technologies venues de l’internet. Les technologies web se sont étendues à une grande partie de l’informatique d’entreprise ; les développements pour les applications mobiles doivent être envisagés, nécessitant la prise en compte de problématiques d’urbanisme et d’architecture fonctionnelle et technique croissantes avec la taille des systèmes d’information.

Les fonctions informatiques sont également impactées par la nécessité pour les entreprises de traiter et valoriser de multiples données internes et externes de plus en plus massives et éventuellement non structurées. Les métiers de la data, comme celui de data scientist, de data architect ou de data manager se développement, dans les services mais également dans l’industrie. Cette évolution a également des impacts sur des métiers à la frontière avec le marketing ou la stratégie d’entreprise comme les data officers.

Au-delà des métiers informatiques, beaucoup d’autres activités sont impactées par le numérique ; le bâtiment du futur ou l’industrie du futur en sont des symboles. L’industrie du futur, appelée aussi industrie 4.0, se caractérise avant tout par une intégration massive d’outils numériques sur toutes les dimensions de la chaîne industrielle : conception, fabrication, logistique, maintenance, vente. Les exemples concrets sont nombreux. La simulation numérique d’une usine permet ainsi de tester facilement de nouveaux procédés. L’impression 3D (appelée plus souvent fabrication additive) d’objets ou de pièces ouvre de nouvelles perspectives en matière de personnalisation de la production. L’utilisation de capteurs connectés (Internet des objets) sur des machines permet de récupérer des données massives (big data) qui faciliteront les opérations de maintenance (maintenance prédictive). Des logiciels spécialisés facilitent le partage d’informations sur l’ensemble du cycle de vie d’un produit (PLM : product lifecycle management), etc. Côté bâtiment du futur, le BIM (building information modeling) peut être utilisé de la conception à la destruction, en passant par la construction et la maintenance. Il constitue un outil numérique de centralisation de l’information, de co-conception, de collaboration, de pilotage de la réalisation d’un projet de construction.

De même, la digitalisation et l’usage des réseaux sociaux a fait se développer ou se transformer un grand nombre de métiers du marketing. Ces métiers d’analyse de la relation client ou des données marketing utilisent de nouveaux outils afin de produire des recommandations opérationnelles créatrices de valeur pour l’entreprise en prenant en compte la multiplication des canaux de vente et de communication avec les clients.

C’est également le cas de métiers de la fonction ressources humaines. Le responsable recrutement diffuse des offres d’emploi sur Internet, emploie des logiciels de présélection de candidatures, utilise les réseaux sociaux pour chasser les candidats ou pour se renseigner sur eux, gère ses recrutements grâce à des applications informatiques. Le responsable formation innove dans les sessions qu’il propose aux salarié·e·s : Mooc, blended learning, elearning, etc.

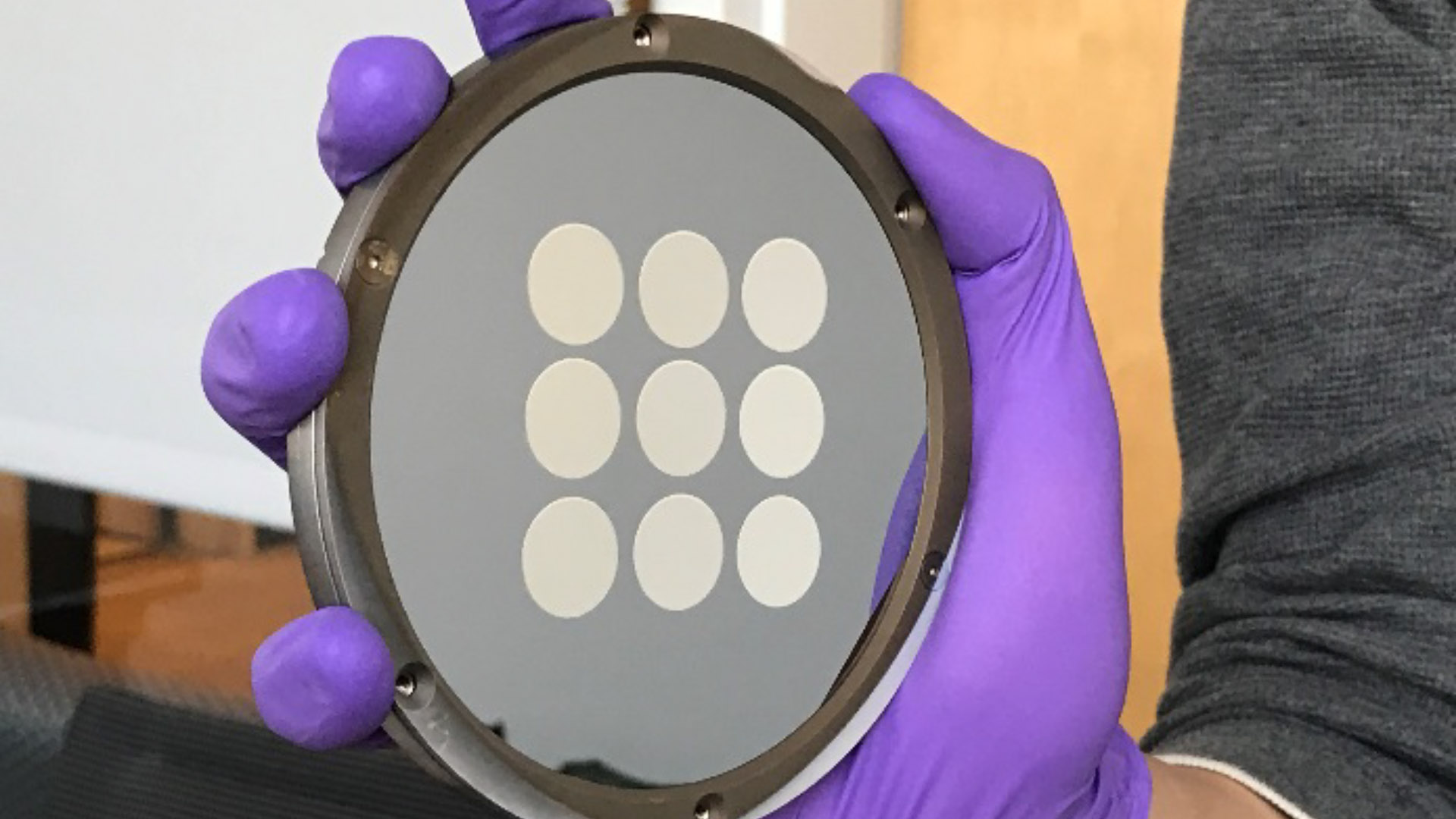

L’ensemble des métiers de l’industrie utilise les objets connectés pour la plupart des métiers de la maintenance, de la production ou de la logistique. Ainsi, les métiers de la logistique sont transformés par l’Internet des objets qui permet, grâce à une technologie embarquée, de suivre les containers en temps réel et de planifier de manière de plus en plus précise les livraisons. Dans l’industrie, la fabrication additive ou impression 3D contribue au développement de métiers informatiques tels que celui d’ingénieur développement de logiciels de conception 3D, mais opère également des transformations dans des métiers classiques comme celui d’ingénieur conception, impliquant de concevoir différemment des produits ou des pièces.

Dans la chimie du végétal, on voit apparaître de nouvelles compétences à la croisée de l’informatique et de la biologie. On assiste ainsi à l’émergence des bioinformaticiens, qui créent les logiciels et bases de données pour traiter les informations issues du vivant.

Dans le secteur sanitaire, l’utilisation de mannequins intelligents et les techniques de e-learning ont amené les responsables pédagogiques à repenser les formations en soins infirmiers. Le médecin DIM (département d’information médicale) optimise les outils informatiques permettant d’effectuer le codage des actes et exploite des données pour suivre l’activité opérationnelle et économique de l’établissement.

Aujourd’hui, ces facteurs d’évolution peuvent s’interpénétrer ; ainsi les contraintes réglementaires sont porteuses d’innovations et certains estiment que « les innovations naissent aujourd’hui davantage de contraintes ou d’évolutions réglementaires que d’une réelle liberté d’innovation comme dans le passé ». La transformation numérique est porteuse d’innovation non seulement dans la sphère technologique, mais également dans l’organisation des relations entre les acteurs. La transition énergétique s’appuie sur l’innovation technologique et est portée par les règlementations issues du Grenelle de l’environnement.

Source : Apec