« Nous ne sommes pas ici que pour découvrir l’énergie, mais pour connaître l’énergie dans un objectif précis: réaliser de meilleures politiques et prendre de meilleures décisions d’investissement (…) Nous devons apprendre rapidement de nos erreurs, nous n’avons pas le temps d’attendre 5 ou 10 ans » expliquait Rembrandt Koppelaar en mai 2015 (Vidéo) à l’occasion de la Global Energy Systems Conference.

L’expert pointe durant cette conférence l’erreur majeure qui a été commise dans le passé avec les agrocarburants (initialement appelés de manière trompeuse « biocarburants« ), et le temps perdu ensuite pour corriger la trajectoire. Al Gore a regretté, après coup, avoir fait la promotion de l’éthanol de maïs.

Parfois des Femmes ou Hommes politiques, tel(le)s des alouettes attirées par un miroir philosophal, s’emballent pour une nouvelle technologie qui, bien qu’a priori sexy et PR-compatible, constitue en réalité une aberration énergétique et/ou environnementale, les deux étant liés. Dès qu’émerge la prise de conscience à propos de l’impasse, il convient d’avoir l’humilité de reconnaître l’erreur, et de ne surtout pas foncer encore plus vite vers l’ornière. Réfléchir avant de (ré)agir.

Koppelaar est un spécialiste de l’analyse des systèmes énergétiques. Ex-Chairman de l’antenne hollandaise de l’ASPO (2005-2010), l’association pour l’étude du pic pétrolier (peak oil), et architecte de The Oil Drum (2010-2013), ce chercheur a publié en 2013 dans la revue Global Environmental Change une analyse particulièrement importante pour l’avenir de l’Humanité sur le pic de phosphore (peak phosphorus), un élément constitutif de l’ADN et du squelette osseux.

Egalement professeur au prestigieux l’Imperial College London, Koppelaar vient de mettre les points sur les i en ce qui concerne l’EROI (Energy Return on energy invest), autrement dit le NER (Net Energy Ratio, ratio énergétique net), du solaire photovoltaïque. Ceci en publiant le 29 novembre 2016 un papier (« Solar-PV energy payback and net energy: Meta-assessment of study quality, reproducibility, and results harmonization« ) dans la revue spécialisée « Renewable and Sustainable Energy Reviews ».

Obsolète, vous avez dit obsolète ?

Dans une chronique intitulée « Faire de l’écologie avec des données obsolètes« , Xavier De La Porte, journaliste à France-Culture, fait écho de cette méta-étude de Koppelaar qui analyse 29 autres études:

« (…) Les chercheurs de l’Imperial College de Londres ont fait un constat assez stupéfiant : ces études utilisent des données en moyenne vieilles de 7 ans, se réfèrent à des technologies qui ont été largement améliorées depuis. Résultat, elles sous-estiment largement les performances de l’énergie solaire. Car, selon les chercheurs, ce qui s’est passé entre 2009 et aujourd’hui, c’est que les performances de l’énergie solaire ont doublé (…) Mais ce sont ces résultats qui servent aux décideurs politiques à définir leur politique énergétique pour les décennies à venir. Ce cas particulier illustre une question fondamentale : l’importance des données en matière environnementale. L’écologie est affaire de mentalité, elle est aussi affaire de chiffres et de calcul (…) ».

Cette chronique est également disponible sur le site Rue89 (Nouvel-Obs) sous le titre:

« Data : l’énergie solaire est aussi performante que le pétrole ou le gaz«

La méthodologie de l’étude de Koppelaar « consiste d’abord à les rendre comparables en les harmonisant, et pour cela commence à recalculer l’EROI qui découle, pour chacune d’elles, des données qu’elles ont employées » explique Cédric Philibert, expert EnR au sein de l’Agence Internationale de l’Energie et notamment auteur principal du rapport de référence « Solar Energy Perspectives » (2011).

« L’harmonisation consiste à recalculer à nouveau l’EROI qui découle des données de chaque étude en les complétant par des données moyennes quand il en manque, en adoptant des valeurs uniques pour l’ensoleillement, la durée de vie » ainsi que d’autres paramètres. Philibert ajoute que « dans une deuxième phase Koppelaar note que les études sont basées sur des données de deux à dix-huit ans d’âge et ordonne les valeurs d’EROI fournies en fonction de l’âge des données, en trois groupes. Il montre alors que les études basées sur des données acquises depuis 2009 ont des EROI de 13 à 15 pour poly- et mono- silicium, respectivement, contre des chiffres en gros de moitié inferieurs pour les études basées sur des données plus anciennes, obsolètes. »

L’EROI actuel du solaire PV est très probablement supérieur à 14:1

Une étude publiée le 6 décembre 2016 dans Nature Communications souligne la très forte corrélation entre l’évolution du CAPEX (coût d’investissement) et celle du temps de retour énergétique (EPBT) du solaire PV.

« Ces euros correspondent à de l’énergie » soulignait dès 2015 l’ingénieur des Mines Nicolas Ott dans le rapport de la Fondation Nicolas Hulot sur le solaire + stockage batterie (page 35) ajoutant que « sur la période 2009-2011, Hall et Prieto ont évalué le coût d’investissement à environ 5,5 M€/MW et le coût d’exploitation et de maintenance à 1,7 M€ sur 25 ans. Ces euros correspondent à de l’investissement énergétique. Au vu de l’analyse précédente sur l’investissement et des données des experts sur la partie exploitation et maintenance, 1MW de photovoltaïque coûte aujourd’hui de l’ordre d’1M€ et la maintenance sur 25 ans coûte plutôt de 20 à 30 k€/MW/an soit sur 25 ans entre 0,5 et 0,75 M€. En gardant le périmètre et les données de Hall et Prieto, si on prend le coût énergétique actuel lié à la construction d’une installation photovoltaïque et celui lié à son fonctionnement, (sans prendre en compte les économies potentielles sur les autres facteurs de coûts), l’EROI passe de 2,41 à environ 7-8″.

Philibert explique de son côté que « c’est après 2009 que les réductions de coût les plus rapides sont intervenues, reflétant en particulier la réduction de consommation d’énergie dans la fabrication du silicium de qualité photovoltaique et la baisse des quantités employées par unité de puissance, et que l’efficacité n’a cessé de croître également depuis 2009, entraînant une baisse des surfaces nécessaires et donc aussi de l’emploi d’autres matériaux; autrement dit, les valeurs de 13 et 15 (du papier de Koppelaar ndlr) sont plutôt conservatrices et lorsqu’on étudiera l’EROI de modules produits aujourd’hui on trouvera vraisemblablement des valeurs supérieures.«

Une seule étude (Ferroni et Hopkirks 2016) donne un EROI inférieur à un pour le solaire PV. La date de la publication (2016) donne l’illusion de la modernité: les données de l’étude datent de 1998 selon Koppelaar. « C’est le record du monde de l’obsolescence – le vrai sujet de l’étude de Koopelaar » souligne Philibert.

Jacques Treiner, conseiller scientifique de « The Shift Project » et responsable en région parisienne de l’association très pro-nucléaire « Sauvons Le Climat » a publié le 7 mai 2016 sur son blog (hébergé par Médiapart) un article intitulé « Taux de retour énergétique ». Il se réfère à l’étude du biologiste Charles Hall et de l’ingénieur Pedro Prieto reposant sur des données datant de…2004 (table 3 page 14). Or entre 2004 et 2016, les technologies photovoltaïques ont fortement évolué. Jacques Treiner a déclaré avoir eu connaissance du rapport de la Fondation Nicolas Hulot sur le solaire publié fin 2015. Pourtant il écrit en 2016 à propos du solaire PV: « Un retour de 2 pour 1, seulement ?! Eh oui. »

Le miracle de la multiplication des pains solaires

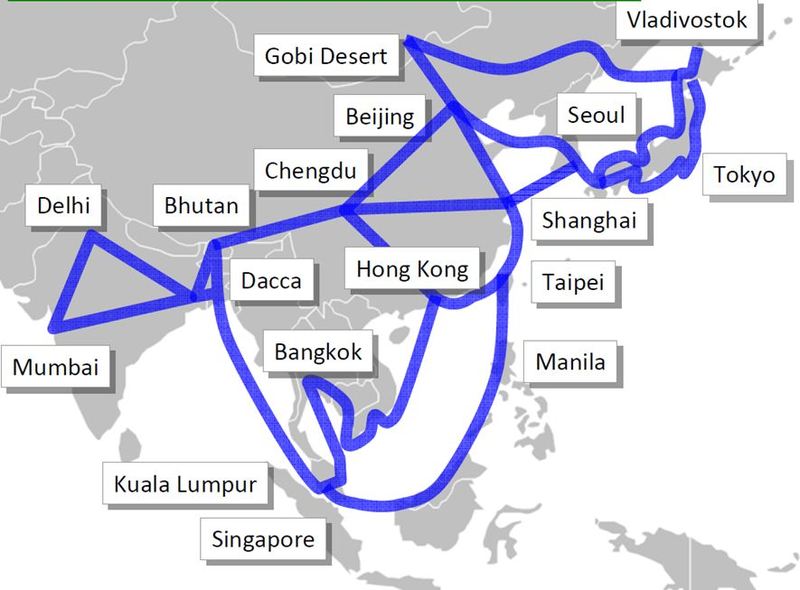

Bien entendu les valeurs de l’EROI varient en fontion de l’insolation, différente entre Marseille et la Normandie (Carte). Koppelaar a retenu une valeur de 1700 kWh/m2/an mais souligne que 85% de l’humanité vit dans des régions très ensoleillées, ce que montre le rapport « The Future of Solar » du MIT (Fig 1.1 page 5).

« En Amérique latine, en Afrique, dans le sud des USA, dans la plus grande partie de l’Asie et en Océanie le ratio énergétique de 14 est en réalité une valeur basse » a déclaré l’expert à Medium.com. Avec une insolation de 850 kWh/m2/an (nord de la Finlande) l’EROI du solaire PV peut être estimé à environ 7:1. A l »inverse dans certaines régions du monde l’insolation dépasse les 2500 kWh/m2/an.

Contacté par Techniques-ingénieur.fr Koppelaar a annoncé qu’une nouvelle étude est en cours: « nous préparons à présent un papier sur l’énergie nette de l’électricité globalement, incluant la transmission au niveau des réseaux électriques, et aussi la gestion (balance), ceci pour 4 scénarios existants à horizon 2050. Une étape de plus vers un « energy calculator » disponible directement sur internet. »

Le stockage a un impact marginal sur l’EROI du solaro-éolien

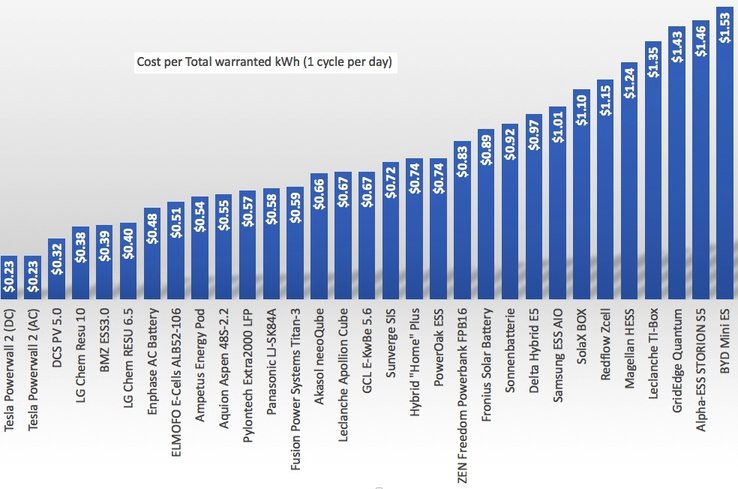

C’est chaud pour ceux qui ont peur des EnR: Ott a montré dès 2015 (page 51 du rapport de la FNH), avec un réel talent pédagogique, que la prise en compte du stockage batterie n’impacte que très marginalement l’EROI du solaire PV:

« 350-400 kWh pour 1 kWh de stockage, cela fait beaucoup. Mais ce « 1 kWh » de stockage va être utilisé plusieurs fois, et plus précisément 4000 fois. Donc, l’énergie de fabrication par cycle tombe à environ 0,1 kWh pour 1 kWh stocké et moitié moins avec un doublement du nombre de cycles. Par ailleurs, le passage des coûts de fabrication de 400- 500 $/kWh, pour un coût énergétique de 350-400 kWh/kWh de stockage, à 100 $/kWh, correspond à une baisse équivalente de la consommation énergétique par kWh de stockage. Au premier ordre, 100 $/kWh pour 8000 cycles correspond à 0,01kWh/kWh de stockage. Même doublé en considérant des coûts énergétiques indirects, ce surcoût énergétique pour une installation photovoltaïque couplée à du stockage ne ferait que diminuer la fourchette de EROI du photovoltaïque de 5-10 à 4,5-9 ».

Ou de 15 à 13,5. Le solaire en bouteille a bel et bien rendez-vous avec le pétrole en barril. Les travaux de Koppelaar viendront enrichir cette réflexion et confirmer ce qu’Ott a déjà révèlé en filigrane.

En 2013 la Royal Society a publié un rapport (cité par Medium.com) estimant que l’EROI du pétrole s’est effondré et qu’il entre dans un domaine fortement glissant. En 2017, 4 ans après, il est vraisemblablement de l’ordre de 10:1. Il est de plus en plus difficile, et donc coûteux, d’extraire le pétrole, il faut aller le chercher sur des sites off-shore, parfois jusqu’à la région Arctique. Autrement dit la compétitivité (énergétique et économique) du solaire en bouteille ne va faire que croître dans les années à venir.

La revue scientifique Nature, reprenant le magazine Scientific American (2013) a publié un document synoptique à propos des EROI des différentes filières énergétiques. On y découvre (âmes sensibles s’abstenir) que l’EROI du nucléaire est de 5:1, soit égal à celui du pétrole des schistes bitumineux mais il est vrai trois fois meilleur que le très absurde éthanol de maïs. Contre 20:1 pour l’éolien et plus de 40:1 pour l’hydroélectricité. La valeur retenue dans ce document pour le solaire PV est à présent obsolète.

Un mix Wind Water Sun (WWS) tel que prôné par le professeur Mark Jacobson de Stanford University a un EROI égal à la moyenne pondérée des trois EROI respectifs (20:1, 40:1 et 14:1), moyenne qu’il convient de légèrement corriger pour tenir compte du stockage + réseau. Il n’est donc pas étonnant, avec d’aussi bons EROI, que le kWh WWS soit bon marché.

Olivier Danielo

Article édité le 16-12-2016 à propos du rapport de la Royal Society sur l’EROI du pétrole