Dans le cadre des JNI 2019, Techniques de l’Ingénieur a réalisé des interviews avec plusieurs des participants au Colloque National organisé au CNAM par l’IESF. Voici la troisième et dernière interview avec Emmanuelle Galichet, maître de conférences en Sciences et technologies nucléaires au CNAM et également responsable du diplôme d’ingénieur en génie nucléaire.

Qu’est-ce que l’innovation dans le secteur du nucléaire ?

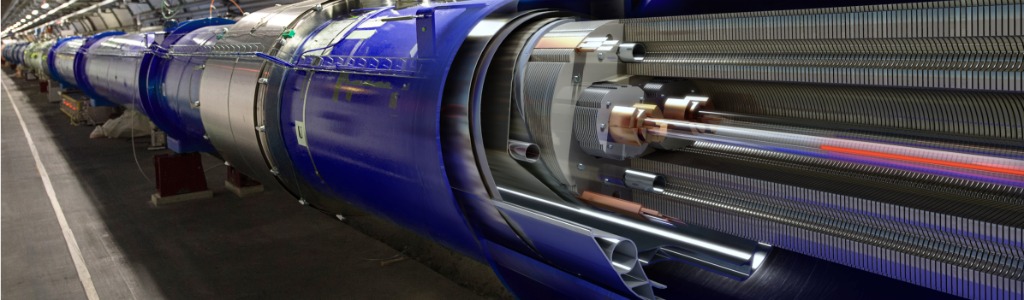

Pour moi l’innovation a toujours fait partie du secteur nucléaire car c’est une filière de haute technologie, qui possède un très gros relationnel avec la recherche fondamentale. L’innovation c’est apporter de nouvelles idées technologiques à l’industrie nucléaire. C’est toujours difficile de parler d’innovation dans le nucléaire car pour beaucoup le secteur n’innove pas. Les process et les systèmes doivent être qualifiés par une autorité de sûreté extrêmement forte.

Pour autant, l’innovation est l’idée de base et fait partie intégrante de la filière nucléaire. Quand le CEA (Commissariat à l’énergie atomique et aux énergies alternatives) a été créé, c’était une manière d’innover, d’avoir un vrai partenaire qui développe des technologies innovantes. C’est une des filières industrielles en France qui a la chance de s’appuyer sur un partenaire public pour lequel l’innovation technologique et le transfert vers l’industrie sont des missions fondatrices. EDF, Orano et Framatome sont d’autres leaders du secteur qui possèdent de grands services de R&D. Ces 4 entreprises dépensent 700 M€ annuellement pour la R&D nucléaire et travaillent en commun dans le cadre de la PFN(Plateforme France Nucléaire).

Les nouveaux réacteurs fonctionnent à partir de technologies assez anciennes. Par exemple le process physique de la fission est ancien, mais le secteur a quand même réussi à développer toute une ingénierie technique autour, qui est toujours plus innovante. Notamment quand on parle de l’EPR (réacteur de 3ème génération), c’est un produit innovant par rapport aux réacteurs qui existent en France, que sont les réacteurs à eau pressurisés. Ils ont réussi à innover à pleins d’endroits alors même que le process de base n’a pas changé.

L’innovation a été permise grâce au retour d’expérience d’accidents comme TMI ou Tchernobyl. Aujourd’hui, l’EPR qui se construit à Flamanville intègre l’ensemble du retour d’expérience et c’est de l’innovation. Pour donner un exemple concret, l’EPR a un récupérateur du corium qui n’avait jamais été construit dans les réacteurs actuels.

Nous sommes dans un schéma d’innovation assez traditionnel avec une recherche, un développement, une démonstration et un déploiement industriel. Malgré cela, depuis quelques années, des initiatives d’open innovation voient le jour sur l’ensemble du territoire. La transformation numérique de l’industrie permet des nouveaux modes de collaboration et augmente l’efficacité dans pleins de domaines.

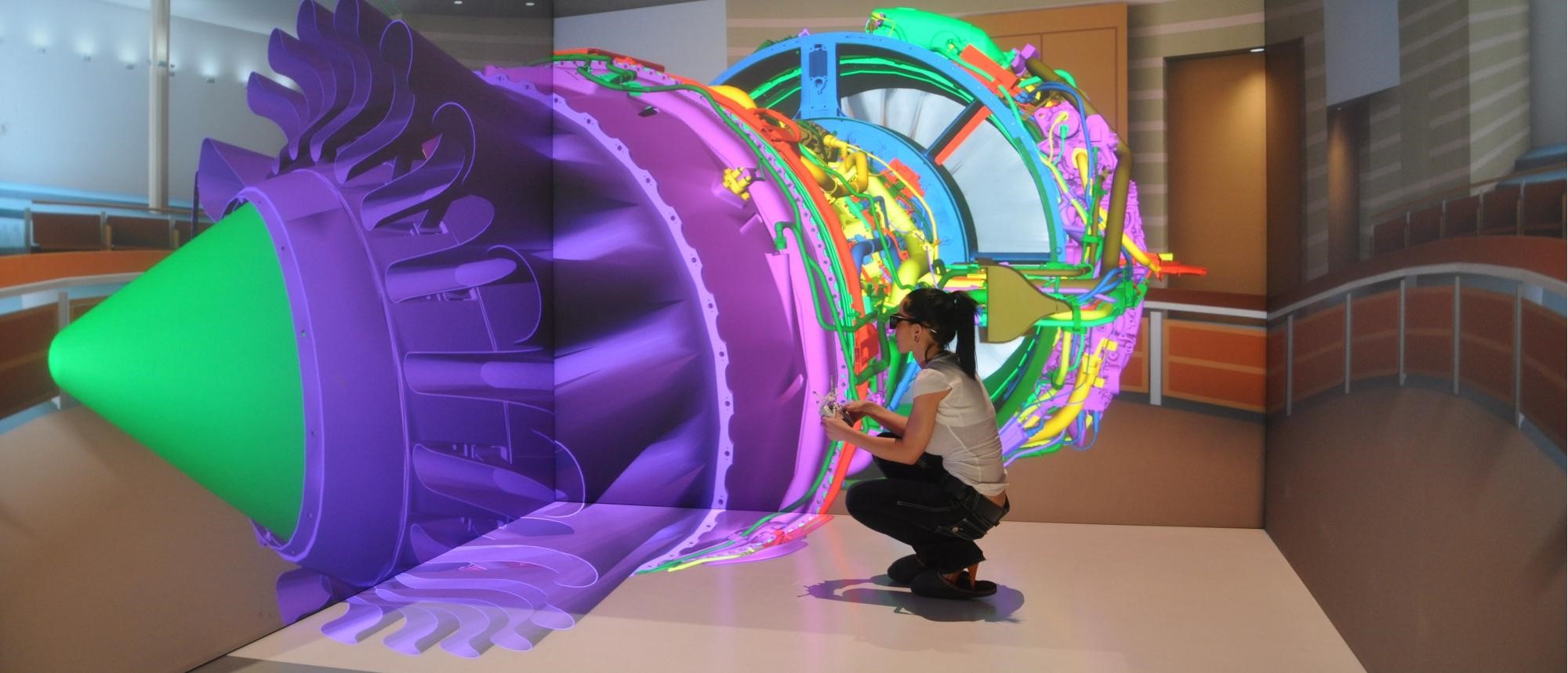

Par exemple, Orano, EDF et le CEA développent des plateformes d’innovation permettant à leurs sous-traitants de laisser des idées, de travailler avec eux. Les maquettes numériques, la réalité virtuelle, le BIM vont permettre un gain important d’efficacité et de sûreté.

Les nouveaux modes d’innovation organisationnelle sont aussi essayés dans le secteur nucléaire. La filière veut travailler ensemble (la PFN regroupe les 4 donneurs d’ordre), et s’organise dans ce sens. Un exemple concret : EDF essaie de travailler en mode entreprise étendue, en organisant depuis cette année des rencontres industries/universités. C’est une initiative que je trouve très innovante, où des chercheurs d’EDF présentent leurs verrous technologiques aux chercheurs universitaires pour les lever.

Enfin, il y a un gros secteur du nucléaire qui est en train de s’ouvrir, c’est le démantèlement et l’assainissement des installations nucléaires. C’est un secteur qui débute et il y aura un besoin d’innovations assez rapidement de manière à diminuer les coûts et à augmenter l’efficacité des chantiers d’assainissement. C’est un des domaines du secteur où l’innovation va être importante. Il y a également le nucléaire du futur où l’on va pouvoir utiliser l’innovation. Nous parlons à une échelle de 50 voire 100 ans. Ce n’est pas une innovation qui va permettre un gain de productivité ou de parts de marché immédiatement .

Comment instruire l’innovation aux élèves ?

Il y a deux points lorsque l’on fait de la formation dans le secteur nucléaire. Il y a les process technologiques et scientifiques. Prenons l’exemple de la fission, c’est de la physique pure. De ce côté-là, nous ne pouvons pas innover énormément puisque ce sont des sciences, et il existe des concepts de base qu’il va falloir inculquer de manière claire. Là où nous pouvons innover, nous en tant que formateurs, c’est sur « comment leur inculquer ? ».

Aujourd’hui nous sommes face à des élèves qui n’ont pas les mêmes attentes que par le passé. Nous devons utiliser l’arrivée des nouvelles technologies de manière importante pour amener les élèves vers la compétence et la connaissance dont ils ont besoin. Nous allons utiliser notamment Internet, la réalité virtuelle, les codes de simulation. Par exemple je monte actuellement au CNAM un Learning Lab où il sera possible d’utiliser toutes les technologies numériques pour former nos futurs salariés du nucléaire à l’ensemble des postes de travail, des process, des gestes qu’ils doivent savoir pour intégrer cette industrie. Cela peut être simplement la connaissance d’une installation nucléaire en allant la visiter de manière virtuelle. Cela peut être des serious game pour les entraîner à identifier les différentes parties d’un système, d’une installation. Vous pouvez utiliser ces jeux pour entraîner vos apprenants aux bons gestes, aux bons comportements lorsqu’ils sont dans des zones où il y a des rayonnements ionisants.

Tout cela fait partie des nouvelles manières d’enseigner par les mises en situation. Nous utilisons aussi énormément de chantiers écoles grâce à l’INSTN, avec qui nous sommes en collaboration. Le principe repose sur un scénario à dérouler comme s’ils étaient dans une vraie installation. Les travaux pratiques, les mises en situation, les chantier-école font partie de l’innovation dans l’enseignement.

Au-delà du gain de compétences est-ce que cela permet également de développer leur créativité ?

En tant que responsable de formation j’essaye d’essaimer ce sentiment de liberté et de créativité, qui est la base de l’innovation, dans l’ensemble des cours, qu’ils soient théoriques ou expérimentaux. Je demande aux intervenants de les amener à ce questionnement perpétuel qui permet d’avoir de nouvelles idées par de nouvelles questions. Nous faisons souvent des classes inversées (une nouvelle innovation pédagogique), qui sont des moments où vous pouvez laisser les élèves poser l’ensemble de leurs questions parce qu’ils vont aller découvrir par eux même. Cela peut être un cours, un scénario d’étude, des travaux pratiques, toutes ces méthodes peuvent être jouées en classes inversées.

Si vous les laissez découvrir les choses par eux même avant de leur donner la leçon, ils vont pouvoir se questionner seul ou en groupe ce qui permet l’innovation par la diversité de pensée. Il est possible que les questions soit naïves ou peu opportunes mais elles permettent aux élèves d’avancer dans leur cheminement intellectuel. Que ce soit de la physique, des mathématiques ou du management vous pouvez très rapidement faire de la classe inversée. Ce que j’ai fait en plus dans ma formation d’ingénieur, c’est d’inclure un cours de management et de la gestion de l’innovation. Ils vont apprendre ce qu’est l’innovation, comment on l’organise au niveau d’une entreprise, voir comment cela fonctionne dans d’autres industries. Cela leur permet d’avoir de nouvelles idées, de leur montrer que des choses peuvent être faites. Il faut que nos élèves soient préparés au nucléaire du futur.

Est-ce que la diversité peut aider à l’innovation ?

Oui, par exemple, sur les réacteurs du futur il existe un groupement qui s’appelle Génération 4 qui est un groupement international. Nous faisons de l’innovation participative pour réfléchir à des réacteurs du futur avec des innovations de rupture, avec des concepts de filières totalement différentes de ce qui est aujourd’hui en place à travers le monde.

Si nous parlons d’une diversité homme/femme, il est clair que le secteur nucléaire a beaucoup à faire, comme toutes les sciences. Mais le secteur fait beaucoup. Il y a eu une réelle prise de conscience du manque de femme à tous les niveaux dans le secteur nucléaire. L’ensemble des politiques RH est très en faveur des femmes. C’est nouveau et ça ne marche pas trop mal. Elles sont les bienvenues. Notamment, EDF a fait le prix FEM’ ENERGIA par exemple. C’est une initiative d’EDF et de WIN (Women in nuclear) qui est une association de femmes dans le nucléaire. Oui, il y a des actions, des initiatives, des prix importants pour mettre en avant les femmes.

Après la diversité va plus loin. Cela peut-être la diversité dans les parcours, et c’est très important aussi, autant que la diversité homme/femme. Le nucléaire a aussi des progrès à faire sur ce domaine. Aujourd’hui, nous pensons que la diversité des parcours de formation, des écoles et des parcours de vie sont des leviers à l’innovation et sont déterminants pour la productivité et l’efficacité de la filière. Pour donner un exemple, j’ai ouvert ma formation en 2012 et la formation par l’apprentissage n’était pas du tout reconnue dans le secteur nucléaire. Aujourd’hui, le secteur nucléaire est un des secteurs qui emploie le plus d’apprentis en France. La filière a beaucoup changé sur la diversité des parcours.

Maintenant, j’ai une vingtaine d’ingénieurs par an qui en sortent, formés par l’apprentissage et ils sont tous embauchés avant le diplôme, avec les mêmes salaires qu’une école d’ingénieur en formation initiale. Cela veut dire que les entreprises reconnaissent les parcours de formation différents et les intègrent dans leurs équipes. Et ça c’est sûr que ça va aider à l’innovation.

Pour le secteur nucléaire il existe d’énormes challenges dans lesquels la filière nucléaire à un vrai rôle à jouer : la transition énergétique et le mix énergétique du futur, le grand carénage et le développement international. La filière nucléaire est obligée d’innover, et finalement d’avoir des femmes et des hommes, des parcours de formation différents, des visions différentes car cela permet d’aller plus loin.