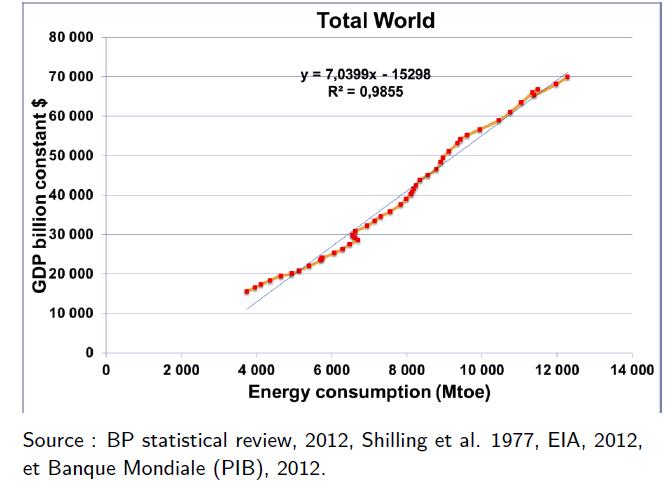

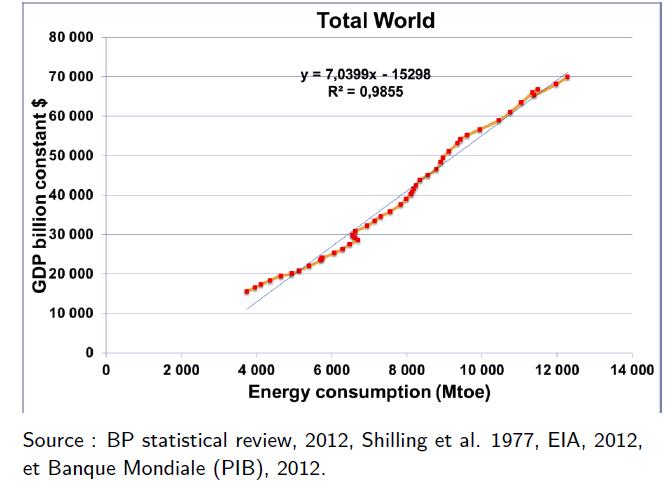

Cette importance est manifeste si l’on rapporte l’évolution du PIB mondial depuis les années 1960 à la consommation d’énergie primaire, exprimée non pas en dollars, mais en quantité physique : en million de tonnes-équivalent pétrole (Mtep). On voit que le PIB, en réalité, peut être vu comme un proxy de la consommation d’énergie [1], et que la pente moyenne a été d’environ 7000 $/tep.

Le formidable développement humain que les fossiles ont permis est dû à ce qu’ils décuplent les facultés de transformation de la matière. Un humain peut développer en une journée environ 0,5 kWh de travail, alors que la combustion d’un litre d’essence libère environ 10 kWh, et cela pour 1,5 € ! Il convient donc de mesurer, pour les sources d’énergie alternative aux fossiles, ce qu’elles sont capables de délivrer pour le développement des sociétés.

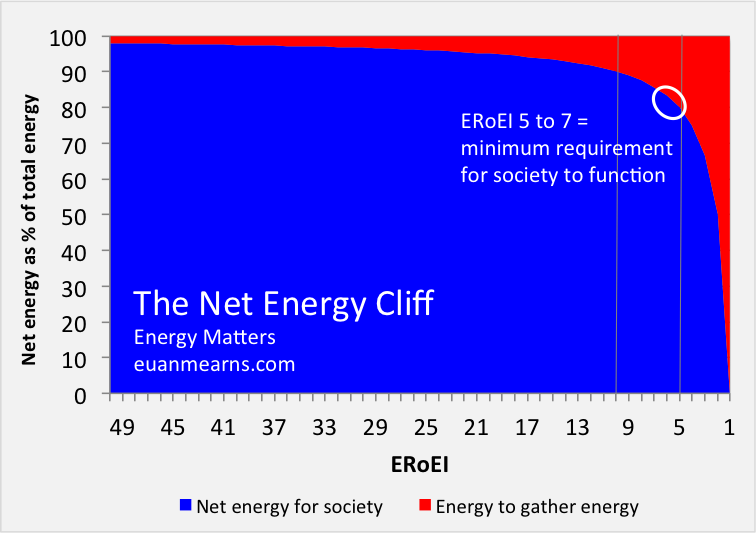

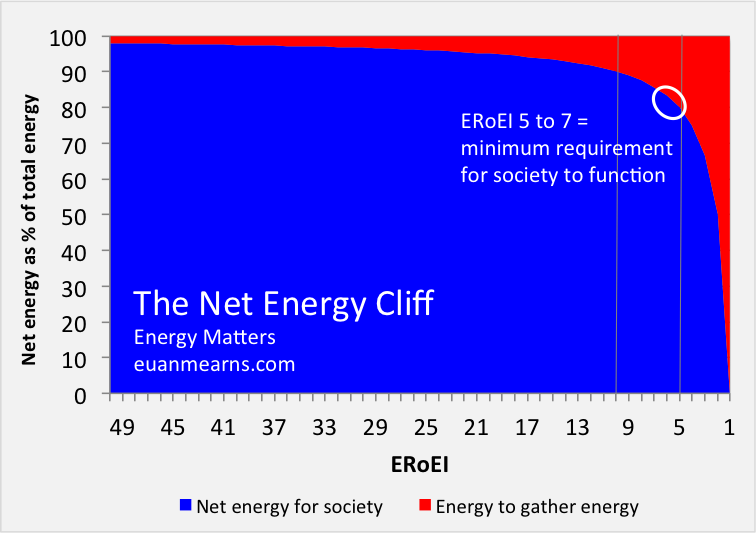

Le concept d’EROI (Energy return on [energy] invested), ou taux de retour énergétique, permet de quantifier les choses. Comme il faut de l’énergie pour en produire, ce qui est mis à disposition pour la société doit tenir compte de ce que le secteur énergétique lui-même consomme pour son propre fonctionnement. Désignons par Eout l’énergie produite, par Ein l’énergie investie pour cette production, l’EROI est défini par EROI = Eout/Ein. Il est intéressant d’introduire également, suivant Euan Mearns, l’énergie nette relative, (Eout-Ein)/Eout = 1- 1/EROI, et de la tracer en fonction de EROI. Voici ce qu’on obtient :

Pour une valeur donnée de l’EROI, la partie rouge représente l’autoconsommation du secteur énergétique, et la partie bleue ce qui est reversé aux autres secteurs d’activité. On voit que tant que l’EROI est élevé, sa diminution éventuelle ne change pas vraiment le bilan, mais qu’en dessous d’environ 10, le fonctionnement normal de nos sociétés n’est plus assuré, car de moins en moins d’énergie, en pourcentage, est disponible pour la satisfaction de nos besoins. Précisons que les sociétés développées fonctionnent avec un EROI moyen supérieur à 20 [2].

Une question délicate et controversée, pour l’évaluation de l’EROI, concerne le périmètre à prendre en compte pour calculer l’énergie investie. Prenons l’exemple du pétrole. Ne prendre que l’énergie nécessaire à son extraction n’est pas satisfaisant, car le pétrole n’est intéressant que dans la mesure où il est une promesse d’essence. Pour que cette promesse se réalise, il faut transporter ce pétrole, le raffiner, transporter l’essence, le diesel ou le fioul obtenus jusqu’au réseau de distribution, lequel doit exister. Il convient également de tenir compte des salaires des personnels travaillant dans le domaine, car ces salaires ont une contrepartie énergétique consommée par les salariés. Toutes ces étapes sont consommatrices d’énergie, et à chaque étape correspond une valeur de l’EROI. Tous ces coûts énergétiques pris en compte, ce qui reste peut enfin servir à différents besoins (mobilité, chauffage, industrie, agriculture, culture et loisirs). Cette problématique vaut évidemment quelle que soit la source d’énergie considérée.

Dans une étude remarquable publiée en 2013, Charles Hall et Pedro Prieto ont analysé les performances du photovoltaïque espagnol correspondant aux trois années de production 2009-2010-2011. L’intérêt de cette étude tient à son exhaustivité et à ce qu’il s’agit de données réelles (Pedro Prieto est un ingénieur qui a passé trente ans de sa vie à installer toute sorte de systèmes photovoltaïques). En effet, s’agissant de l’énergie produite Eout, toutes sortes d’effets viennent la réduire : les poussières, le mismatch de modules, les pertes angulaires, les effets de température, les pertes inverteurs, celles du circuit basse tension et de tension intermédiaire, les pertes d’évacuation du courant et de la dégradation temporelle des modules. Concernant l’énergie investie Ein, la fabrication des panneaux et leur installation ne représente qu’environ un tiers de la dépense énergétique, les deux autres tiers étant dus à des aspects souvent négligés mais bien réels : coûts énergétiques associés accès, fondations, canalisations, lignes d’évacuation, fonctionnement et maintenance, lavage et nettoyage, auto-consommation, surveillance et sécurité, transport du matériel et du personnel, vol et vandalisme, matériel défectueux, restructuration du réseau électrique, lissage d’une production par nature variable, obsolescence prématurée, administration, travail direct et indirect, taxes, marketting… Hall et Prieto évaluent ainsi l’EROI du PV espagnol à 8,3 :1 lorsqu’ils restreignent au minimum le périmètre de l’énergie investie et négligent la plupart des pertes, et cette valeur tombe à 2,5 :1 lorsque tous les coûts énergétiques du secteur sont pris en compte !

C’est à cette étude que j’ai fait allusion dans une note postée sur mon blog de Mediapart, et c’est ce qui m’a valu les critiques d’Olivier Daniélo. Il me reproche de me fonder sur une étude dont les données sont obsolètes, dans un domaine où les progrès technologiques sont extrêmement rapides, au point qu’à l’échelle de 10 ans le bilan énergétique est à revoir totalement. Avant de voir ce qu’il en est exactement, remarquons tout de même qu’il est difficile d’analyser les données sur trois ans de parcs construits aujourd’hui, voire demain – causalité oblige – et que la durée de vie d’un parc est estimée à environ 25 ans. De ce point de vue, l’analyse de Hall et Prieto est toujours d’actualité aujourd’hui pour le parc espagnol. Les industriels se sont jetés tête baissée dans le photovoltaïque dans les années 2000 – assurés de faire des bénéfices grâce aux tarifs d’achat avantageux garantis – savaient-ils qu’ils installaient une source dont l’EROI était si bas ?

Olivier Daniélo se fonde sur une étude très intéressante de Rembrandt Koppelaar, de l’Imperial College London, dont le but est de « reproduire et d’harmoniser 29 études, et d’examiner l’influence de l’âge des données, du périmètre du système et des configurations technologiques » sur l’évaluation des performances du photovoltaïque. Trois conclusions saillantes de cette étude de 2016 : i) l’EROI « harmonisé » est de 8,6 :1 et 9,2 :1 pour les panneaux mono- et poly-cristallins, ii) les valeurs obtenues en utilisant les données postérieures à 2008 sont doubles de celles utilisant les données antérieures et iii) en tenant compte d’améliorations technologiques récentes, les valeurs passent à 9,7 :1 et 11,4 :1 respectivement, bien au dessus de la valeur de Hall et Prieto.

En quoi consiste cette « harmonisation » effectuée par Koppelaar ? Parmi les hypothèses qu’il utilise, citons : i) la production d’électricité a été recalculée en prenant comme donnée d’ensoleillement la valeur de 1700 kWh/m2/an, ii) l’énergie correspondant aux salaires et aux coûts d’investissement obtenue au moyen d’une conversion de l’intensité énergétique des économies a été ôtée des études qui l’ont prise en compte et iii) l’énergie investie dans les batteries, les services auxiliaires, la restructuration du réseau a été ôtée des études qui l’ont incorporée.

La première hypothèse est valable pour l’Espagne, mais elle surestime d’un facteur presque 2 l’ensoleillement en Allemagne, qui a installé environ 40 GW de PV, ou en Suisse. Passons sur ce point, qui n’est pas le plus important. La seconde hypothèse n’est pas justifiée. De quoi s’agit-il ? Dans le coût énergétique des panneaux, par exemple, est comptée la consommation énergétique des travailleurs qui les fabriquent (c’est implicite dans le salaire qu’ils reçoivent) : de quoi assurer leur métabolisme, celui de leur famille, leur transport, l’éducation de leurs enfants etc. Pourquoi ne pas tenir compte de celle des travailleurs qui opèrent et maintiennent les installations ? Une façon approchée de calculer ce coût est de partir de la consommation totale moyenne d’énergie par salarié, puis de tenir compte du nombre de salariés du secteur. Hall et Prieto obtiennent ainsi 5% de Eout. Ce n’est pas négligeable. Il n’y pas plus de raison de ne pas tenir compte, dans l’énergie … investie, des coûts d’investissement ! La troisième hypothèse n’est valable que si la part du PV ne représente qu’une petite partie du mix électrique, mais elle ne l’est plus si l’on envisage un déploiement important de cette source d’énergie (par exemple, les scénarios 100 % renouvelables). Un réseau adapté pour une production centralisée ne l’est plus pour une multitude de producteurs décentralisés : les coûts énergétiques d’adaptation du réseau doivent être pris en compte. De plus, les réseaux électriques fonctionnent avec de la puissance garantie, pas avec de la puissance variable ou intermittente. Le pilotage de la demande peut prendre en charge une partie des fluctuations, mais certainement pas la totalité en cas de déploiement massif. Il faut donc disposer de puissance de back-up ou de stockage, dédiés au lissage de la production PV. Aujourd’hui, en Allemagne, ce back-up est assuré par les fossiles – charbon et lignite – mais si l’on prétend sortir des fossiles, le problème est entier.

Un rapport récent de la FNH envisage le stockage par batterie (page 51 du rapport). Mais les auteurs du rapport font une erreur grossière.

Ils commencent par remarquer que, d’après les experts, il faut de l’ordre de 350-400 kWh d’énergie pour « fabriquer » 1 kWh de batterie, ce qui, a priori, parait prohibitif. Mais, poursuivent-ils, ce kWh va être utilisé 4000 fois (nombre de cycles), voire le double (progrès). Le cout énergétique passera donc rapidement à 0,01 kWh pour 1 kWh stocké. Cela aura donc un effet négligeable sur l’EROI du PV.

L’erreur consiste à ne raisonner qu’en relatif (coût énergétique par kWh de stockage) sans évaluer le besoin total de stockage, en valeur absolue. Prenons le cas allemand. Nos voisins ont installé environ 40 GW de PV. Aujourd’hui, le back-up est fourni par les fossiles – charbon et lignite. Mais s’il s’agissait de batteries (pour sortir des fossiles), il faudrait pouvoir assurer une large fraction de cette puissance pendant une dizaine d’heures où le soleil est faible ou absent. Disons 20 GW pendant 10 heures, soit 200 GWh. Or l’énergie mondiale totale stockée dans les batteries est d’environ de 500 GWh !

Et je n’ai pas pris ici en compte les besoins de stockage associés à l’éolien. Dans ce cas, le besoin cumulé de stockage peut correspondre à un excédent ou un déficit de plusieurs jours, et une étude récente [3] indique, pour la France, un besoin de l’ordre de 10 TWh, pour un mix électrique renouvelable optimal (PV + éolien) correspondant à une réduction à 50 % de la part du nucléaire. Dix TWh, c’est 20 fois la capacité mondiale des batteries – pour un seul pays. On voit bien que cette technologie ne constituera jamais une solution pour du stockage massif.

Il est temps de conclure. Il ne fait aucun doute que la filière PV fait des progrès technologiques rapides, qu’elle continuera d’en faire, qui se traduiront par une augmentation de l’EROI de la filière. Je pense que c’est une très bonne chose, et que cette évolution est attendue car le photovoltaïque est loin d’être une technologie mature : d’importants progrès peuvent être encore accomplis.

Mais, d’une part, cela n’invalide en rien le besoin de caractériser les performances énergétiques d’installations faites dans un passé récent – car elles sont installées pour 25 ans. Fallait-il, d’ailleurs, en installer tant ? N’aurait-il pas mieux valu mettre l’accent sur la recherche et, en attendant de meilleures performance, développer le PV là où l’absence de réseau favorise l’auto-consommation ? La CSPE coûte aujourd’hui 7 milliards d’euros par an aux consommateurs français, elle augmente de 10 % par an, alors que les laboratoires, y compris ceux qui travaillent dans le solaire, se battent pour des budgets se chiffrant en millions d’euros.

Et, d’autre part, il est naïf – ou puéril, comme on veut – de gonfler les chiffres en restreignant le périmètre du calcul de l’énergie investie dans le secteur. Il convient de garder à l’esprit ce que l’EROI cherche à caractériser : la part du secteur énergétique – de tout le secteur énergétique – parmi l’ensemble des activités productrices de biens et de services. La discussion est parfois polluée, hélas, par des considérations idéologiques : toute analyse qui peut être perçue comme une critique du PV – ou de l’éolien – est immédiatement soupçonnée d’être une forme déguisée de promotion du nucléaire, même s’il ne s’agit que de faire un état des lieux. Pour ma part, cet état des lieux me conduit à penser qu’il est dangereux de décider de se passer du nucléaire, car c’est la seule source d’énergie peu chère capable de délivrer de grandes quantités d’énergie pilotable[4]. L’exemple allemand le confirme à contrario. La première économie européenne a dépensé plus de 300 milliards d’euros pour installer ces 15 dernières années environ 80 GW de PV et d’éolien, ne délivrant que 20 % de son électricité, à un prix du kWh double du prix français pour les particuliers, et en diminuant très peu ses émissions de gaz à effet de serre : le kWh produit en Allemagne émet 7 fois plus de CO2 que le kWh produit en France. Et c’est la nation qu’on donne en exemple de bonne conduite pour le climat ! Comprenne qui pourra.

Pour ma part, je pense qu’il est important de développer l’approche EROI auprès de tous ceux qui s’intéressent à l’énergie et à la substitution de sources décarbonées d’énergie aux sources fossiles. L’article de Koppelaar montre qu’il est urgent de définir des protocoles précis et unifiés du calcul de l’EROI, faute de quoi toutes les manipulations sont possibles et difficiles à démêler. C’est en ce sens que fut organisée au mois de mars dernier une session de l’Ecole des Houches, dont toutes les contributions sont accessibles – powerpoints et vidéos – sur le site Science-and-energy.org. D’autres initiatives similaires seront prises dans les prochains mois.

Par Jacques Treiner, Physicien, chercheur associé au LIED, Université Paris-Diderot

Dans les tribunes, les auteurs expriment un point de vue propre, qui n’est pas nécessairement celui de la rédaction.

[1] La pente de la courbe représente le « contenu énergétique du PIB » et augmente si l’ « efficacité énergétique » s’améliore. Ce genre d’évolution se voit si l’on fait une analyse détaillée pays par pays, mais on constate aussi que si l’on agrège mondialement les données, cette efficacité énergétique moyenne n’a pas changé en 50 ans.

[2] Cf., par exemple, la contribution de Jessica Lambert à l’Ecole des Houches du mois de mars 2016 : science-and-energy.org

[3] Intermittence des énergies renouvelables et mix électrique, D. Grand, C ; Lebrun et R. Vidil, Techniques de l’Ingénieur, 10/7/2015.

[4] Je précise ici que je n’ai jamais travaillé, ni de près ni de loin, dans le nucléaire français – ce qui ne m’empêche pas d’avoir beaucoup de respect pour les gens qui ont fait fonctionner un secteur essentiel pour le confort et le bien-être de tous, avec un sens du service public remarquable.