-

Google récupère vos données de localisation même si le service est désactivé per l’utilisateur

Même si votre téléphone ne contient pas de carte SIM, même s’il est éteint, et même si vous avez désactivé ce service, les téléphones sous Androïd envoient les données de localisation de votre téléphone à Google, dès que celui-ci est connecté à nouveau. Lire

Source: Quartz

-

Les 40 meilleurs objets high-tech de l’année selon The Guardian

Le quotidien publie sa liste au père Noël: robots, consoles, appareils photos, téléphones, enceintes… tout y est. Lire

Source: The Guardian

-

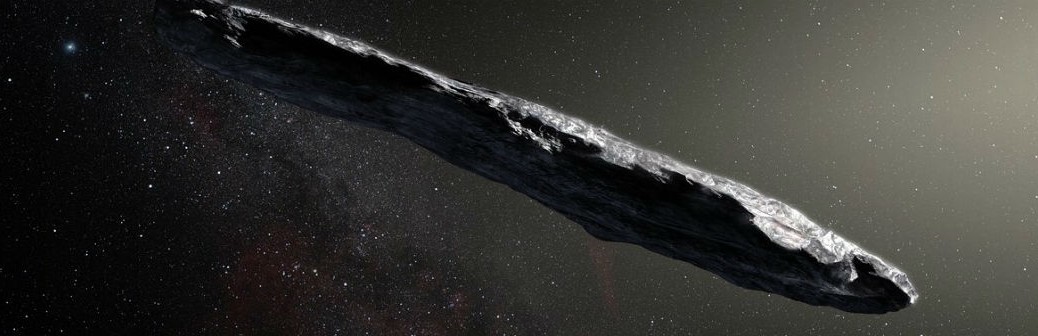

A-t-on le droit d’exploiter la lune ?

La question commence à se poser sérieusement: vu que la lune n’appartient à personne, comment imaginer exploiter ses ressources naturelles ? Lire

Source: NYT

-

Le Bitcoin passe la barre des 10 000 dollars

La valorisation de la monnaie cryptée virtuelle atteint des sommets, ce qui n’est pas sans poser quelques problèmes réels. Lire

Source: Tech Crunch

-

La ville de Chicago porte plainte contre Uber

Après les révélation confirmant qu’Uber a tout fait pour dissimuler une faille de sécurité massive dans la protection des données de ses utilisateurs, la ville de Chicago a décidé de porter l’affaire en justice. D’autres villes pourraient lui emboîter le pas. Lire

Source: Washington Post